Topik ini menjelaskan cara menyiapkan deployment multi-region untuk Apigee Hybrid di Microsoft® Azure Kubernetes Service (AKS).

Topologi untuk deployment multi-region mencakup hal berikut:

- Aktif-Aktif: Jika Anda memiliki aplikasi yang di-deploy di beberapa lokasi geografis dan Anda memerlukan respons API latensi rendah untuk deployment Anda. Anda memiliki opsi untuk men-deploy hybrid di beberapa lokasi geografis yang terdekat dengan klien Anda. Misalnya: Pantai Barat AS, Pantai Timur AS, Eropa, Asia Pasifik.

- Aktif-Pasif: Jika Anda memiliki region utama dan region failover atau pemulihan dari bencana.

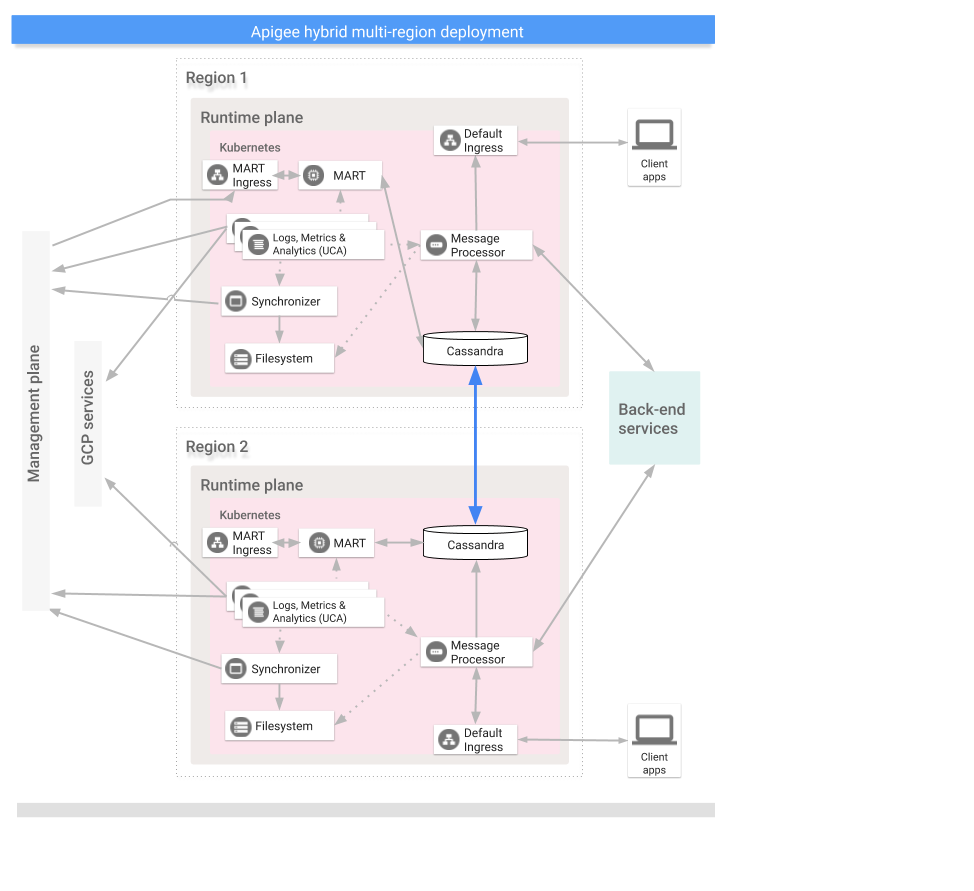

Region dalam deployment hybrid multi-region berkomunikasi melalui Cassandra, seperti yang ditunjukkan gambar berikut:

Prasyarat

Sebelum mengonfigurasi hybrid untuk beberapa region, Anda harus menyelesaikan prasyarat berikut:

- Ikuti panduan penginstalan hybrid untuk mengetahui prasyarat seperti konfigurasi GCP dan organisasi sebelum melanjutkan ke langkah-langkah penyiapan cluster.

Untuk mengetahui informasi mendetail, lihat dokumentasi Kubernetes.

Buat jaringan virtual di setiap region

Buat jaringan virtual untuk deployment multi-region. Misalnya, perintah contoh berikut membuat jaringan di region AS Tengah dan AS Timur.

Jalankan perintah ini untuk membuat jaringan virtual di region US Timur, dengan

nama my-hybrid-rg-vnet:

az network vnet create \ --name my-hybrid-rg-vnet \ --location eastus \ --resource-group my-hybrid-rg \ --address-prefixes 120.38.1.0/24 \ --subnet-name my-hybrid-rg-vnet-subnet \ --subnet-prefix 120.38.1.0/26

Jalankan perintah ini untuk membuat jaringan virtual di region US Tengah, dengan

nama my-hybrid-rg-vnet-ext01:

az network vnet create \ --name my-hybrid-rg-vnet-ext01 \ --location centralus \ --resource-group my-hybrid-rg \ --address-prefixes 192.138.0.0/24 \ --subnet-name my-hybrid-rg-vnet-ext01-subnet \ --subnet-prefix 192.138.0.0/26

Membuat peering jaringan

Buat peering jaringan antara jaringan virtual.

Mendapatkan ID jaringan virtual

Peering dibuat antara ID jaringan virtual. Dapatkan ID setiap jaringan virtual dengan perintah az network vnet show dan simpan ID dalam variabel.

Dapatkan ID jaringan virtual pertama, yang bernama my-hybrid-rg-vnet:

vNet1Id=$(az network vnet show \ --resource-group my-hybrid-rg \ --name my-hybrid-rg-vnet \ --query id --out tsv)

Dapatkan ID jaringan virtual kedua, yang bernama my-hybrid-rg-vnet-ext01:

vNet2Id=$(az network vnet show \ --resource-group my-hybrid-rg \ --name my-hybrid-rg-vnet-ext01 \ --query id \ --out tsv)

Buat peering dari jaringan virtual pertama ke jaringan virtual kedua

Dengan ID jaringan virtual, Anda dapat membuat peering dari jaringan virtual pertama (my-hybrid-rg-vnet) ke jaringan virtual kedua (my-hybrid-rg-vnet-ext01),

seperti yang ditunjukkan pada contoh berikut:

az network vnet peering create \ --name my-hybrid-rg-vnet1-peering \ # The name of the virtual network peering. --resource-group my-hybrid-rg \ --vnet-name my-hybrid-rg-vnet \ # The virtual network name. --remote-vnet $vNet2Id \ # Resource ID of the remote virtual network. --allow-vnet-access

Dalam output perintah, perhatikan bahwa peeringState adalah Initiated.

Peering tetap dalam status Dimulai hingga Anda membuat peering dari jaringan virtual

kedua kembali ke jaringan pertama.

{

...

"peeringState": "Initiated",

...

}

Buat peering dari jaringan virtual kedua ke jaringan virtual pertama

Contoh perintah:

az network vnet peering create \ --name my-hybrid-rg-vnet2-peering \ # The name of the virtual network peering. --resource-group my-hybrid-rg \ --vnet-name my-hybrid-rg-vnet-ext01 \ # The virtual network name. --remote-vnet $vNet1Id \ # Resource ID of the remote virtual network. --allow-vnet-access

Dalam output perintah, perhatikan bahwa peeringState adalah Connected. Azure

juga mengubah

status peering dari peering jaringan virtual pertama ke kedua menjadi Connected.

{

...

"peeringState": "Connected",

...

}

Anda juga dapat mengonfirmasi bahwa status peering untuk my-hybrid-rg-vnet1-peering ke

my-hybrid-rg-vnet2-peering:

peering berubah menjadi Terhubung dengan perintah berikut:

az network vnet peering show \ --name my-hybrid-rg-vnet1-peering \ --resource-group my-hybrid-rg \ --vnet-name my-hybrid-rg-vnet \ --query peeringState

Output yang diharapkan:

Connected

Membuat cluster multi-regional

Siapkan cluster Kubernetes di beberapa region dengan blok CIDR yang berbeda. Lihat juga panduan memulai AKS. Gunakan nama jaringan virtual dan lokasi yang Anda buat sebelumnya.

Buka port Cassandra 7000 dan 7001 antara cluster Kubernetes di semua region (7000 dapat digunakan sebagai opsi cadangan selama pemecahan masalah)

Mengonfigurasi host awal multi-region

Bagian ini menjelaskan cara memperluas cluster Cassandra yang ada ke region baru. Penyiapan ini memungkinkan region baru mem-bootstrap cluster dan bergabung dengan pusat data yang ada. Tanpa konfigurasi ini, cluster Kubernetes multiregion tidak akan saling mengetahui.

- Tetapkan konteks kubectl ke cluster asli sebelum mengambil nama seed:

kubectl config use-context original-cluster-name

Jalankan perintah

kubectlberikut untuk mengidentifikasi alamat host awal untuk Cassandra di region saat ini.Alamat host awal memungkinkan instance regional baru menemukan cluster asli pada startup pertama untuk mempelajari topologi cluster. Alamat host awal ditetapkan sebagai titik kontak di cluster.

kubectl get pods -o wide -n apigee | grep apigee-cassandra apigee-cassandra-0 1/1 Running 0 4d17h 120.38.1.9 aks-agentpool-21207753-vmss000000

- Tentukan IP mana yang ditampilkan dari perintah sebelumnya yang akan menjadi host

awal multi-region. Dalam contoh ini, saat hanya satu cluster cassandra node yang berjalan, host seed

adalah

120.38.1.9. - Di pusat data 2, salin file penggantian ke file baru yang namanya menyertakan nama

cluster. Misalnya,

overrides_your_cluster_name.yaml. - Di pusat data 2, konfigurasi

cassandra.multiRegionSeedHostdancassandra.datacenterdioverrides_your_cluster_name.yaml, denganmultiRegionSeedHostadalah salah satu IP yang ditampilkan oleh perintah sebelumnya:cassandra: multiRegionSeedHost: seed_host_IP datacenter: data_center_name rack: rack_name

Contoh:

cassandra: multiRegionSeedHost: 120.38.1.9 datacenter: "centralus" rack: "ra-1"

- Di pusat data/region baru, sebelum menginstal hybrid, tetapkan sertifikat TLS dan

kredensial yang sama di

overrides_your_cluster_name.yamlseperti yang Anda tetapkan di region pertama.

Menyiapkan wilayah baru

Setelah mengonfigurasi host awal, Anda dapat menyiapkan region baru.

Untuk menyiapkan wilayah baru:

- Salin sertifikat Anda dari cluster yang ada ke cluster baru. Root CA baru digunakan oleh Cassandra dan komponen hybrid lainnya untuk mTLS. Oleh karena itu, penting untuk memiliki sertifikat yang konsisten di seluruh cluster.

- Tetapkan konteks ke namespace asli:

kubectl config use-context original-cluster-name

- Ekspor konfigurasi namespace saat ini ke file:

$ kubectl get namespace

-o yaml > apigee-namespace.yaml - Ekspor rahasia

apigee-cake file:kubectl -n cert-manager get secret apigee-ca -o yaml > apigee-ca.yaml

- Tetapkan konteks ke nama cluster region baru:

kubectl config use-context new-cluster-name

- Impor konfigurasi namespace ke cluster baru.

Pastikan untuk memperbarui "namespace" dalam file jika Anda menggunakan namespace yang berbeda

di region baru:

kubectl apply -f apigee-namespace.yaml

Impor secret ke cluster baru:

kubectl -n cert-manager apply -f apigee-ca.yaml

- Tetapkan konteks ke namespace asli:

- Instal hybrid di region baru. Pastikan file

overrides_your_cluster_name.yamlmencakup sertifikat TLS yang sama yang dikonfigurasi di region pertama, seperti yang dijelaskan di bagian sebelumnya.Jalankan dua perintah berikut untuk menginstal hybrid di region baru:

apigeectl init -f overrides_your_cluster_name.yaml

apigeectl apply -f overrides_your_cluster_name.yaml

Luaskan semua keyspace Apigee.

Langkah-langkah berikut memperluas data Cassandra ke pusat data baru:

- Buka shell di pod Cassandra:

kubectl run -i --tty --restart=Never --rm --image google/apigee-hybrid-cassandra-client:1.0.0 cqlsh

- Hubungkan ke server Cassandra:

cqlsh apigee-cassandra-0.apigee-cassandra.apigee.svc.cluster.local -u ddl_user --ssl Password: Connected to apigeecluster at apigee-cassandra-0.apigee-cassandra.apigee.svc.cluster.local:9042. [cqlsh 5.0.1 | Cassandra 3.11.3 | CQL spec 3.4.4 | Native protocol v4] Use HELP for help.

- Dapatkan keyspace yang tersedia:

SELECT * from system_schema.keyspaces ; keyspace_name | durable_writes | replication ----------------------------+----------------+-------------------------------------------------------------------------------------------------------- system_auth | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system_schema | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} cache_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} kms_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} kvm_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} system_distributed | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} perses | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} quota_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} system_traces | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} (10 rows) - Perbarui/perluas keyspace Apigee:

ALTER KEYSPACE cache_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE kms_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE kvm_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE perses WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE quota_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3}; - Validasi perluasan keyspace:

SELECT * from system_schema.keyspaces ; keyspace_name | durable_writes | replication ----------------------------+----------------+-------------------------------------------------------------------------------------------------------- system_auth | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system_schema | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} cache_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} kms_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} kvm_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} system_distributed | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} perses | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} quota_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} system_traces | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} (10 rows) ddl@cqlsh>

- Buka shell di pod Cassandra:

- Jalankan

nodetool rebuildsecara berurutan di semua node di pusat data baru. Proses ini mungkin memerlukan waktu beberapa menit hingga beberapa jam, bergantung pada ukuran data.kubectl exec apigee-cassandra-0 -n apigee -- nodetool rebuild -- dc-1

- Verifikasi proses pembangunan ulang dari log. Selain itu, verifikasi ukuran data

menggunakan perintah

nodetool status:kubectl logs apigee-cassandra-0 -f -n apigee

Contoh berikut menunjukkan contoh entri log:

INFO 01:42:24 rebuild from dc: dc-1, (All keyspaces), (All tokens) INFO 01:42:24 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Executing streaming plan for Rebuild INFO 01:42:24 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.1.45 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.1.45 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.4.36 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 1 files(0.432KiB), sending 0 files(0.000KiB) INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.1.45 is complete INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.4.36 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.5.22 INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 1 files(0.693KiB), sending 0 files(0.000KiB) INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.4.36 is complete INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.5.22 INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 3 files(0.720KiB), sending 0 files(0.000KiB) INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.5.22 is complete INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] All sessions completed

- Perbarui host awal. Hapus

multiRegionSeedHost: 10.0.0.11darioverrides-DC_name.yamldan terapkan kembali.apigeectl apply -f overrides-DC_name.yaml