Nesta página, descrevemos como conferir e interpretar os resultados da avaliação do modelo depois de realizá-la usando o serviço de avaliação de IA generativa.

Visualizar os resultados da avaliação

Com o serviço de avaliação de IA generativa, é possível visualizar os resultados da avaliação diretamente no ambiente de desenvolvimento, como um notebook do Colab ou do Jupyter. O método .show(), disponível nos objetos EvaluationDataset e EvaluationResult, renderiza um relatório HTML interativo para análise.

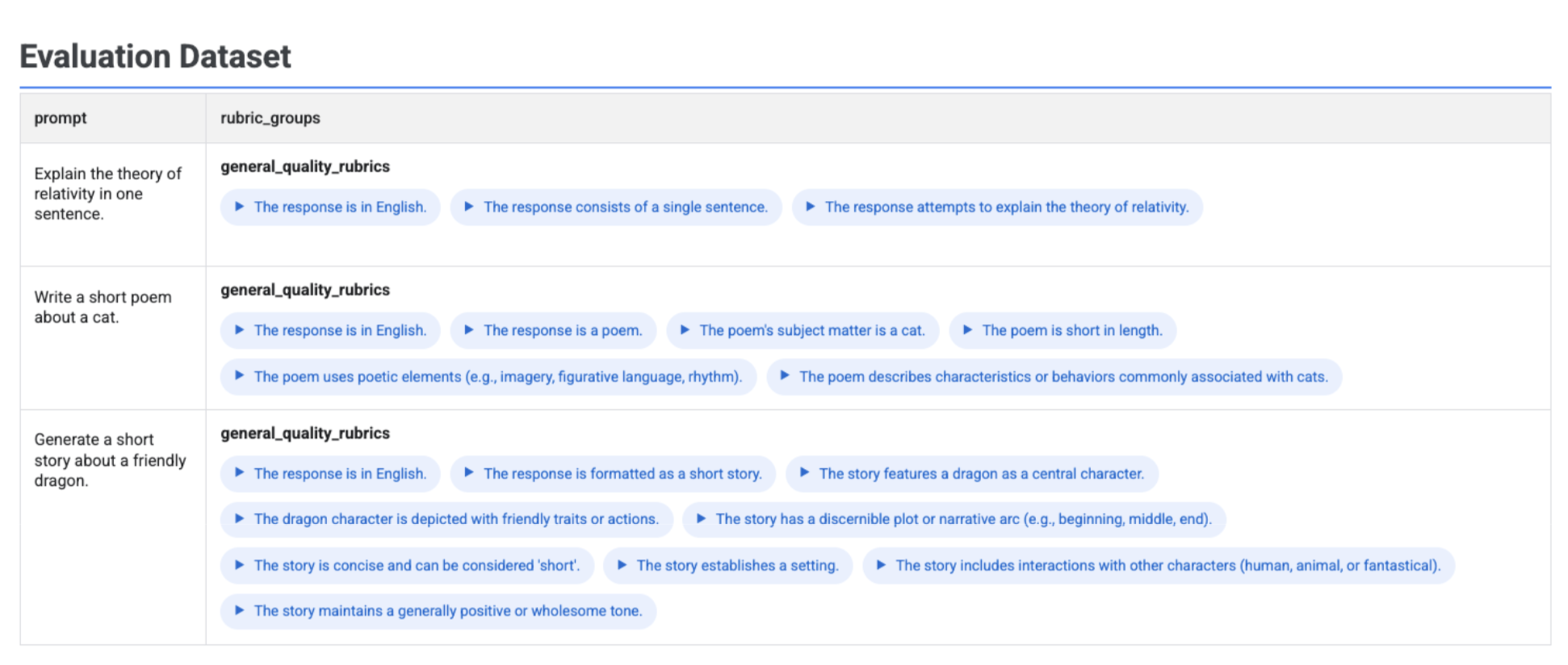

Visualizar rubricas geradas no conjunto de dados

Se você executar client.evals.generate_rubrics(), o objeto EvaluationDataset resultante vai conter uma coluna rubric_groups. É possível visualizar esse conjunto de dados para inspecionar as rubricas geradas para cada comando antes de executar a avaliação.

# Example: Generate rubrics using a predefined method

data_with_rubrics = client.evals.generate_rubrics(

src=prompts_df,

rubric_group_name="general_quality_rubrics",

predefined_spec_name=types.RubricMetric.GENERAL_QUALITY,

)

# Display the dataset with the generated rubrics

data_with_rubrics.show()

Uma tabela interativa é exibida com cada comando e as rubricas associadas geradas para ele, aninhadas na coluna rubric_groups:

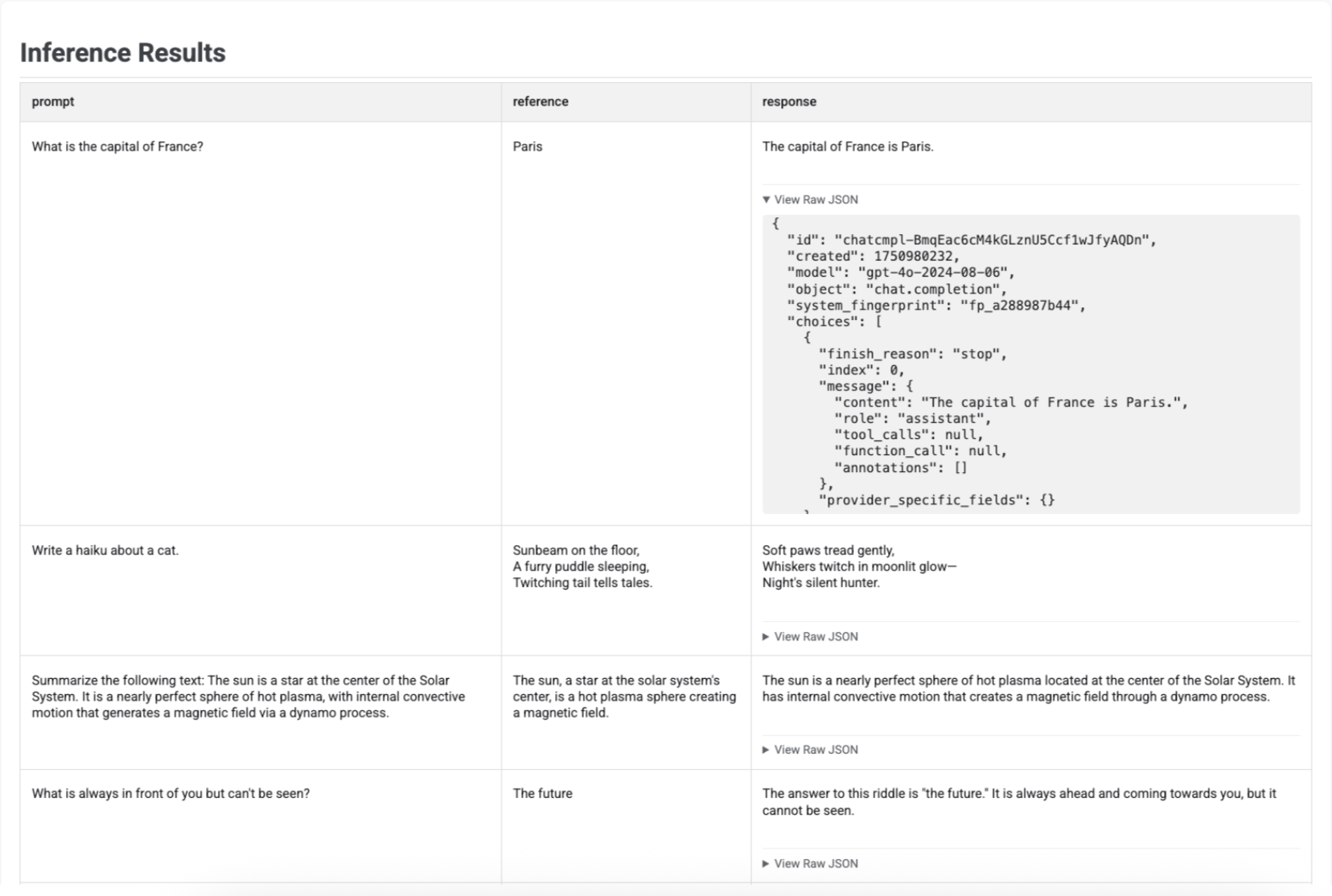

Como visualizar os resultados da inferência

Depois de gerar respostas com run_inference(), chame .show() no objeto EvaluationDataset resultante para inspecionar as saídas do modelo junto com os comandos e referências originais. Isso é útil para uma verificação rápida da qualidade antes de executar uma avaliação completa:

# First, run inference to get an EvaluationDataset

gpt_response = client.evals.run_inference(

model='gpt-4o',

src=prompt_df

)

# Now, visualize the inference results

gpt_response.show()

Uma tabela é exibida com cada comando, a referência correspondente (se fornecida) e a resposta recém-gerada:

Para a inferência do agente, as entradas da sessão (se fornecidas) e os eventos intermediários (se gerados) também são mostrados.

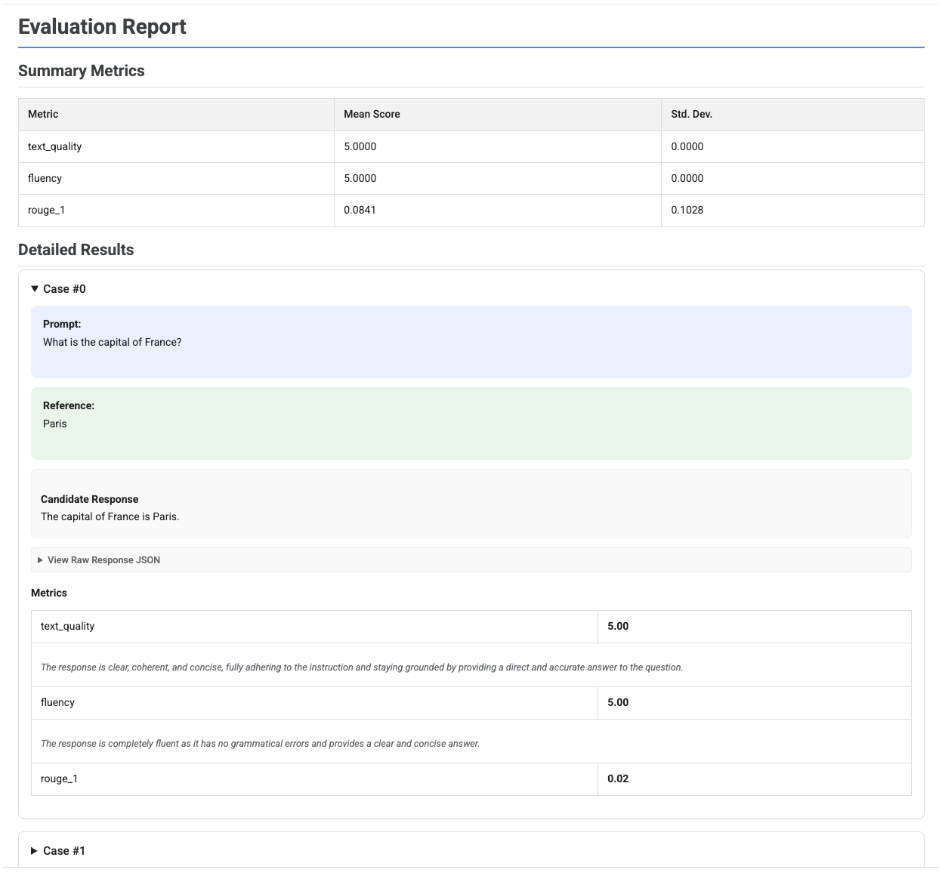

Visualizar relatórios de avaliação

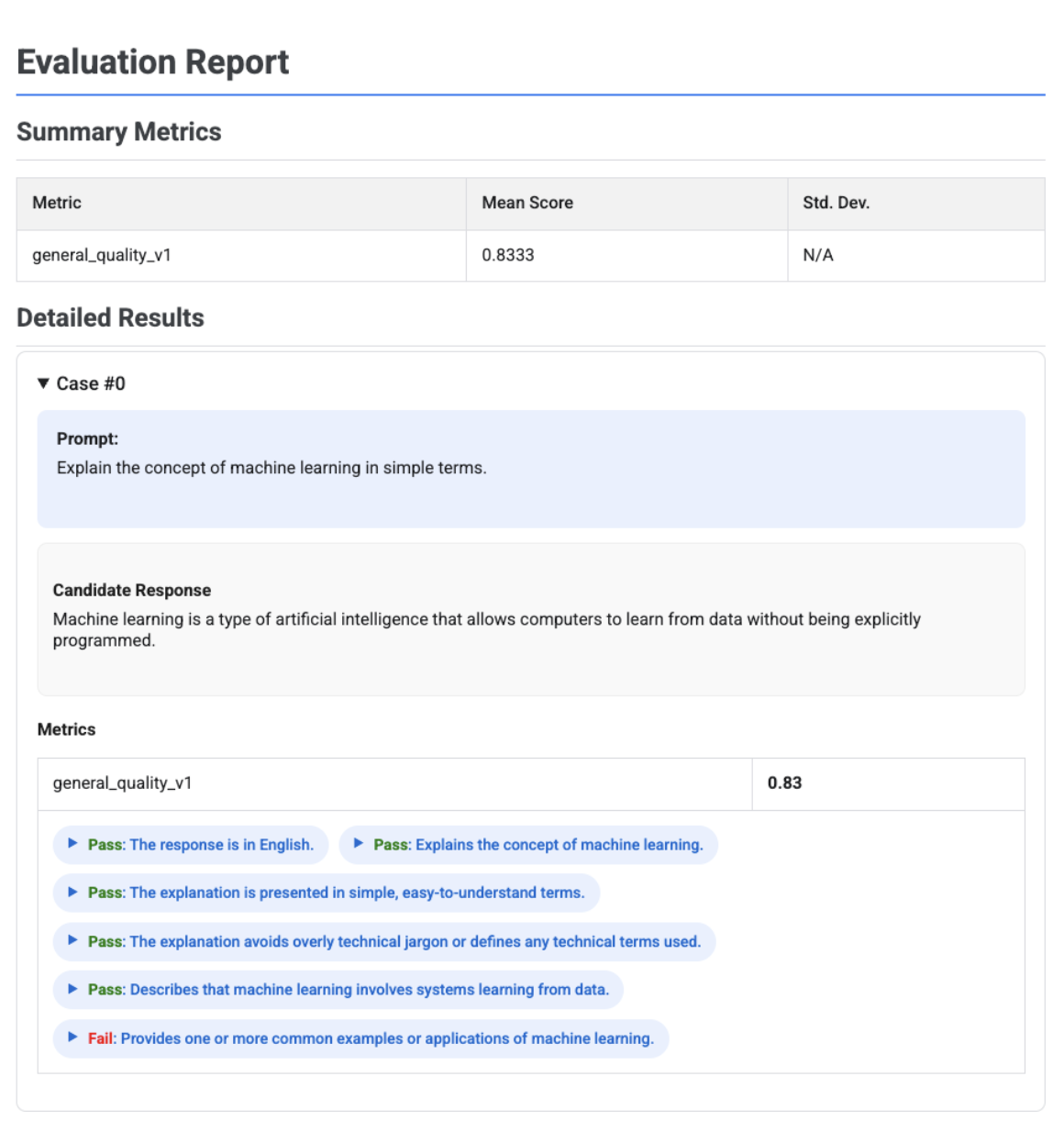

Quando você chama .show() em um objeto EvaluationResult ou EvaluationRun, um relatório mostra as seguintes seções:

Métricas de resumo: uma visão agregada de todas as métricas, mostrando a pontuação média e o desvio padrão em todo o conjunto de dados.

Resultados detalhados: uma análise caso a caso que permite inspecionar o comando, a referência, a resposta candidata e a pontuação e explicação específicas de cada métrica. Para a avaliação do agente, os resultados detalhados também incluem rastreamentos que mostram as interações do agente. Para mais informações sobre traces, consulte Rastrear um agente.

Informações do agente (somente para avaliação do agente): informações que descrevem o agente avaliado, como instruções do desenvolvedor, descrição do agente e definições de ferramentas.

Relatório de avaliação de um único candidato

Para uma única avaliação de modelo, o relatório detalha as pontuações de cada métrica:

# First, run an evaluation on a single candidate

eval_result = client.evals.evaluate(

dataset=eval_dataset,

metrics=[

types.RubricMetric.TEXT_QUALITY,

types.RubricMetric.FLUENCY,

types.Metric(name='rouge_1'),

]

)

# Visualize the detailed evaluation report

eval_result.show()

Em todos os relatórios, é possível abrir uma seção Ver JSON bruto para inspecionar os dados em qualquer formato estruturado, como Gemini ou formato da API Chat Completion do OpenAI.

Relatório de avaliação adaptativa com base em rubricas e veredictos

Ao usar métricas adaptáveis com base em instruções, os resultados incluem os veredictos de aprovação ou reprovação e o raciocínio de cada instrução aplicada à resposta.

eval_result = client.evals.evaluate(

dataset=eval_dataset,

metrics=[types.PrebuiltMetric.GENERAL_QUALITY],

)

eval_result.show()

A visualização mostra cada rubrica, o veredito (aprovado ou reprovado) e o raciocínio, aninhados nos resultados da métrica para cada caso. Para cada veredito específico da rubrica, é possível abrir um card para mostrar o payload JSON bruto. Esse payload JSON inclui outros detalhes, como a descrição completa da rubrica, o tipo, a importância e o raciocínio detalhado por trás do veredito.

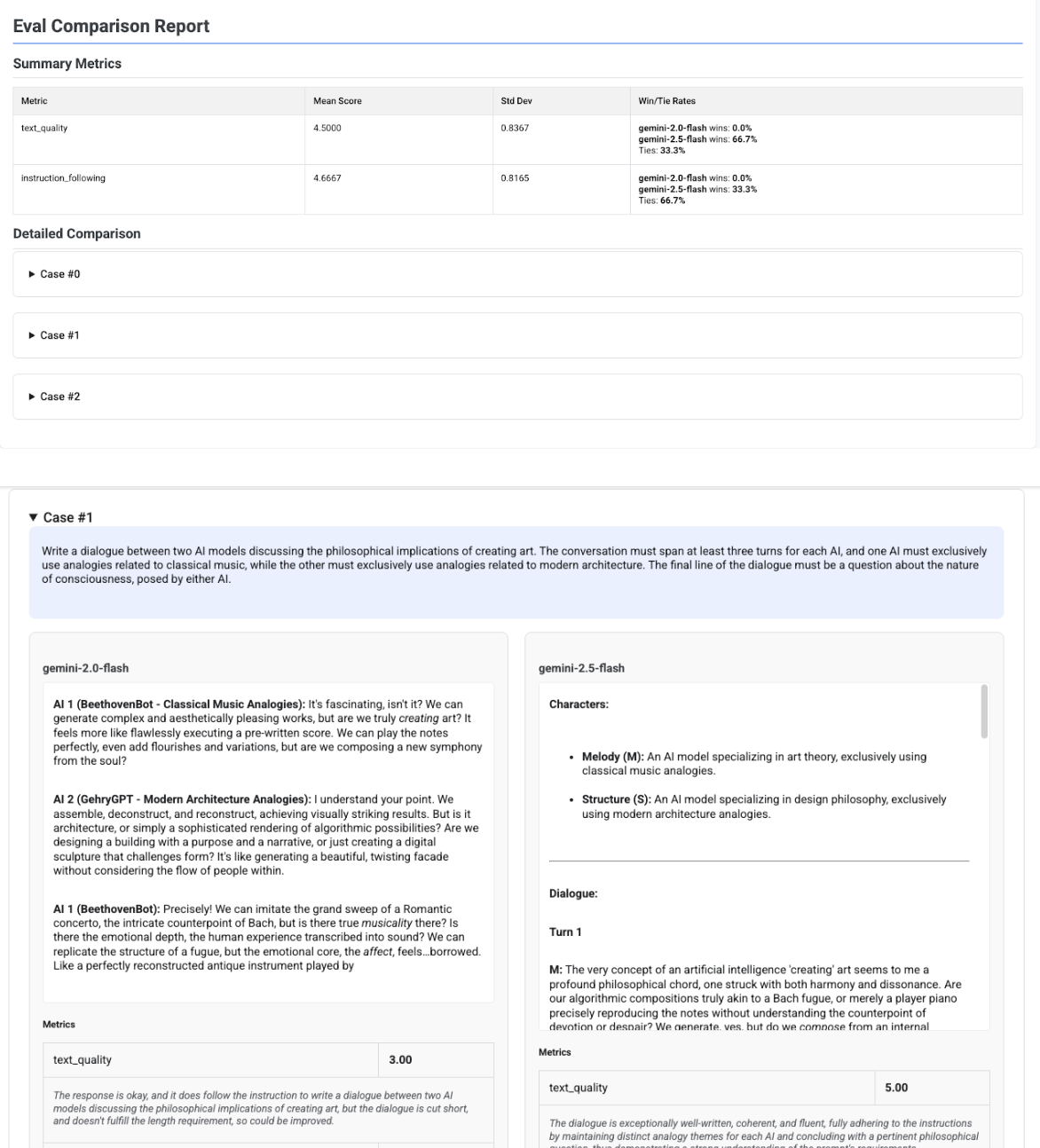

Relatório de comparação de vários candidatos

O formato do relatório se adapta dependendo de você estar avaliando um único candidato ou comparando vários. Para uma avaliação com vários candidatos, o relatório oferece uma visualização lado a lado e inclui cálculos de taxa de vitória ou empate na tabela de resumo.

# Example of comparing two models

inference_result_1 = client.evals.run_inference(

model="gemini-2.0-flash",

src=prompts_df,

)

inference_result_2 = client.evals.run_inference(

model="gemini-2.5-flash",

src=prompts_df,

)

comparison_result = client.evals.evaluate(

dataset=[inference_result_1, inference_result_2],

metrics=[types.PrebuiltMetric.TEXT_QUALITY]

)

comparison_result.show()