교차 클라우드 운영으로 데이터 로드

BigQuery 관리자 또는 분석가는 Amazon Simple Storage Service(Amazon S3) 버킷 또는 Azure Blob Storage에서 BigQuery 테이블로 데이터를 로드할 수 있습니다. 전송된 데이터를Google Cloud 리전에 있는 데이터와 조인하거나 BigQuery ML과 같은 BigQuery 기능을 활용할 수 있습니다. 특정 외부 소스의 구체화된 뷰 복제본을 만들어 BigQuery에서 해당 데이터를 사용할 수도 있습니다.

다음 방법으로 데이터를 BigQuery로 전송할 수 있습니다.

LOAD DATA문을 사용하여 Amazon S3 및 Azure Blob Storage의 파일에서 BigQuery 테이블로 데이터를 전송합니다.결과를 BigQuery 테이블로 전송하기 전에

CREATE TABLE AS SELECT문을 사용하여 Amazon S3 또는 Blob Storage의 파일에서 데이터를 필터링합니다. 대상 테이블에 데이터를 추가하려면INSERT INTO SELECT문을 사용합니다. 데이터 조작은 Amazon S3 또는 Blob Storage의 데이터를 참조하는 외부 테이블에 적용됩니다.BigQuery에서 데이터를 로컬로 사용할 수 있도록 외부 Amazon S3, Apache Iceberg 또는 Salesforce Data Cloud 데이터의 구체화된 뷰 복제본을 BigQuery 데이터 세트에 만듭니다.

할당량 및 한도

할당량 및 한도에 대한 자세한 내용은 쿼리 작업 할당량 및 한도를 참조하세요.

시작하기 전에

다른 클라우드에서 데이터를 로드하거나 필터링하는 데 필요한 읽기 액세스 권한을 Google Cloud 에 제공하려면 관리자에게 연결을 만들어 공유해 달라고 요청하세요. 연결을 만드는 방법은 Amazon S3에 연결 또는 Blob Storage에 연결을 참고하세요.

필요한 역할

교차 클라우드 전송을 사용하여 데이터를 로드하는 데 필요한 권한을 얻으려면 관리자에게 데이터 세트에 대한 BigQuery 데이터 편집자(roles/bigquery.dataEditor) IAM 역할을 부여해 달라고 요청하세요.

역할 부여에 대한 자세한 내용은 프로젝트, 폴더, 조직에 대한 액세스 관리를 참조하세요.

이 사전 정의된 역할에는 교차 클라우드 전송을 사용하여 데이터를 로드하는 데 필요한 권한이 포함되어 있습니다. 필요한 정확한 권한을 보려면 필수 권한 섹션을 펼치세요.

필수 권한

교차 클라우드 전송을 사용하여 데이터를 로드하려면 다음 권한이 필요합니다.

-

bigquery.tables.create -

bigquery.tables.get -

bigquery.tables.updateData -

bigquery.tables.update -

bigquery.jobs.create -

bigquery.connections.use

커스텀 역할이나 다른 사전 정의된 역할을 사용하여 이 권한을 부여받을 수도 있습니다.

BigQuery의 IAM 역할에 대한 자세한 내용은 BigQuery IAM 역할 및 권한을 참고하세요.

가격 책정

LOAD 문을 사용하여 클라우드 간에 전송된 바이트 수에 대한 요금이 청구됩니다. 가격 책정 정보는 BigQuery Omni 가격 책정의 Omni 교차 Cloud Data Transfer 섹션을 참조하세요.

CREATE TABLE AS SELECT 문 또는 INSERT INTO SELECT 문을 사용하여 클라우드 간에 전송된 바이트 수와 컴퓨팅 용량에 대한 요금이 청구됩니다.

LOAD 및 CREATE TABLE AS SELECT 문 모두 BigQuery Omni 리전의 슬롯에서 Amazon S3 및 Blob Storage 파일을 스캔하여 로드해야 합니다. 자세한 내용은 BigQuery Omni 가격 책정을 참조하세요.

외부 데이터 소스의 구체화된 뷰 복제본의 경우 비용에 구체화된 뷰 가격 책정도 포함될 수 있습니다.

로드 및 필터 옵션 권장사항

- 크기가 5MB 미만인 여러 개의 파일을 로드하지 마세요. 대신 파일에 대한 외부 테이블을 만들어 쿼리 결과를 Amazon S3 또는 Blob Storage로 내보내 더 큰 테이블을 만듭니다. 이 방법을 사용하면 데이터 전송 시간이 향상됩니다. 최대 쿼리 결과 한도에 대한 자세한 내용은 BigQuery Omni 최대 쿼리 결과 크기를 참조하세요.

- 소스 데이터가 gzip으로 압축된 파일에 있는 경우 외부 테이블을 만드는 동안

external_table_options.compression옵션을GZIP으로 설정합니다.

데이터 로드

LOAD DATA [INTO|OVERWRITE] 문을 사용하여 BigQuery에 데이터를 로드할 수 있습니다.

제한사항

- 연결 및 대상 데이터 세트는 동일한 프로젝트에 속해야 합니다. 프로젝트 간 데이터 로드는 지원되지 않습니다.

LOAD DATA는 Amazon Simple Storage Service(Amazon S3) 또는 Azure Blob Storage에서 같은 위치에 배치된 BigQuery 리전으로 데이터를 전송할 때만 지원됩니다. 자세한 내용은 위치를 참조하세요.US리전에서US멀티 리전으로 데이터를 전송할 수 있습니다.EU리전에서EU멀티 리전으로 전송할 수도 있습니다.

예

예시 1

다음 예시에서는 스키마 자동 감지를 사용해 sample.parquet라는 Parquet 파일을 Amazon S3 버킷에서 test_parquet 테이블로 로드합니다.

LOAD DATA INTO mydataset.testparquet FROM FILES ( uris = ['s3://test-bucket/sample.parquet'], format = 'PARQUET' ) WITH CONNECTION `aws-us-east-1.test-connection`

예시 2

다음 예시에서는 Blob Storage에서 시간별로 파티션을 나눈 사전 정의된 열이 있는 test_csv 테이블로 sampled* 프리픽스가 있는 CSV 파일을 로드합니다.

LOAD DATA INTO mydataset.test_csv (Number INT64, Name STRING, Time DATE) PARTITION BY Time FROM FILES ( format = 'CSV', uris = ['azure://test.blob.core.windows.net/container/sampled*'], skip_leading_rows=1 ) WITH CONNECTION `azure-eastus2.test-connection`

예시 3

다음 예시에서는 스키마 자동 감지를 사용해 기존 테이블 test_parquet를 sample.parquet라는 파일의 데이터로 덮어씁니다.

LOAD DATA OVERWRITE mydataset.testparquet FROM FILES ( uris = ['s3://test-bucket/sample.parquet'], format = 'PARQUET' ) WITH CONNECTION `aws-us-east-1.test-connection`

데이터 필터링

CREATE TABLE AS SELECT 문과 INSERT INTO SELECT 문을 사용하여 데이터를 BigQuery로 전송하기 전에 필터링할 수 있습니다.

제한사항

SELECT쿼리 결과가 논리 바이트로 60GiB를 초과하면 쿼리가 실패합니다. 테이블이 생성되지 않으며 데이터가 전송되지 않습니다. 스캔되는 데이터의 크기를 줄이는 방법은 쿼리에서 처리되는 데이터 줄이기를 참조하세요.임시 테이블은 지원되지 않습니다.

WKB(Well-Known Binary) 지리정보 데이터 형식 전송은 지원되지 않습니다.

INSERT INTO SELECT문은 클러스터링된 테이블로의 데이터 전송을 지원하지 않습니다.INSERT INTO SELECT문에서 대상 테이블이SELECT쿼리의 소스 테이블과 동일한 경우INSERT INTO SELECT문은 대상 테이블의 행을 수정하지 않습니다. BigQuery에서 여러 리전의 데이터를 읽을 수 없으므로 대상 테이블이 수정되지 않습니다.CREATE TABLE AS SELECT및INSERT INTO SELECT는 Amazon S3 또는 Blob Storage에서 같은 위치에 배치된 BigQuery 리전으로 데이터를 전송할 때만 지원됩니다. 자세한 내용은 위치를 참조하세요.US리전에서US멀티 리전으로 데이터를 전송할 수 있습니다.EU리전에서EU멀티 리전으로 전송할 수도 있습니다.

예

예시 1

Amazon S3의 데이터를 참조하는 myawsdataset.orders라는 BigLake 테이블이 있다고 가정해 보겠습니다.

해당 테이블의 데이터를 US 멀티 리전의 BigQuery 테이블 myotherdataset.shipments로 전송하려고 합니다.

먼저 myawsdataset.orders 테이블에 대한 정보를 표시합니다.

bq show myawsdataset.orders;

출력은 다음과 비슷합니다.

Last modified Schema Type Total URIs Expiration

----------------- -------------------------- ---------- ------------ -----------

31 Oct 17:40:28 |- l_orderkey: integer EXTERNAL 1

|- l_partkey: integer

|- l_suppkey: integer

|- l_linenumber: integer

|- l_returnflag: string

|- l_linestatus: string

|- l_commitdate: date

다음으로 myotherdataset.shipments 테이블에 대한 정보를 표시합니다.

bq show myotherdataset.shipments

출력은 다음과 비슷합니다. 출력을 간소화하기 위해 일부 열을 생략합니다.

Last modified Schema Total Rows Total Bytes Expiration Time Partitioning Clustered Fields Total Logical

----------------- --------------------------- ------------ ------------- ------------ ------------------- ------------------ ---------------

31 Oct 17:34:31 |- l_orderkey: integer 3086653 210767042 210767042

|- l_partkey: integer

|- l_suppkey: integer

|- l_commitdate: date

|- l_shipdate: date

|- l_receiptdate: date

|- l_shipinstruct: string

|- l_shipmode: string

이제 CREATE TABLE AS SELECT 문을 사용하여 미국 멀티 리전의 myotherdataset.orders 테이블에 데이터를 선택적으로 로드할 수 있습니다.

CREATE OR REPLACE TABLE myotherdataset.orders PARTITION BY DATE_TRUNC(l_commitdate, YEAR) AS SELECT * FROM myawsdataset.orders WHERE EXTRACT(YEAR FROM l_commitdate) = 1992;

그런 다음 새로 만든 테이블로 조인 작업을 수행할 수 있습니다.

SELECT orders.l_orderkey, orders.l_orderkey, orders.l_suppkey, orders.l_commitdate, orders.l_returnflag, shipments.l_shipmode, shipments.l_shipinstruct FROM myotherdataset.shipments JOIN `myotherdataset.orders` as orders ON orders.l_orderkey = shipments.l_orderkey AND orders.l_partkey = shipments.l_partkey AND orders.l_suppkey = shipments.l_suppkey WHERE orders.l_returnflag = 'R'; -- 'R' means refunded.

새 데이터를 사용할 수 있게 되면 INSERT INTO SELECT 문을 사용하여 1993년 데이터를 대상 테이블에 추가합니다.

INSERT INTO myotherdataset.orders SELECT * FROM myawsdataset.orders WHERE EXTRACT(YEAR FROM l_commitdate) = 1993;

예시 2

다음 예시에서는 수집 시간으로 파티션을 나눈 테이블에 데이터를 삽입합니다.

CREATE TABLE mydataset.orders(id String, numeric_id INT64) PARTITION BY _PARTITIONDATE;

파티션을 나눈 테이블을 만든 후 수집 시간으로 파티션을 나눈 테이블에 데이터를 삽입할 수 있습니다.

INSERT INTO mydataset.orders( _PARTITIONTIME, id, numeric_id) SELECT TIMESTAMP("2023-01-01"), id, numeric_id, FROM mydataset.ordersof23 WHERE numeric_id > 4000000;

구체화된 뷰 복제본

구체화된 뷰 복제본은 BigQuery에서 데이터를 로컬로 사용할 수 있도록 외부 Amazon Simple Storage Service (Amazon S3), Apache Iceberg 또는 Salesforce Data Cloud 데이터를 BigQuery 데이터 세트에 복제합니다. 이렇게 하면 데이터 이그레스 비용을 방지하고 쿼리 성능을 개선할 수 있습니다. BigQuery를 사용하면 Amazon Simple Storage Service(Amazon S3), Apache Iceberg 또는 Salesforce Data Cloud 데이터를 통해 BigLake 메타데이터 캐시 지원 테이블에서 구체화된 뷰를 만들 수 있습니다.

구체화된 뷰 복제본을 사용하면 데이터 이그레스 비용을 방지하고 쿼리 성능을 향상시키는 동시에 쿼리에서 Amazon S3, Iceberg 또는 Data Cloud 구체화된 뷰 데이터를 사용할 수 있습니다. 구체화된 뷰 복제본은 지원되는 BigQuery 리전의 데이터 세트에 Amazon S3, Iceberg 또는 Data Cloud 데이터를 복제하여 작동하므로 데이터를 BigQuery에서 로컬로 사용할 수 있습니다.

시작하기 전에

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator role

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator role

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

- 이 섹션의 작업을 수행하는 데 필요한 Identity and Access Management (IAM) 권한이 있는지 확인합니다.

-

bigquery.tables.create -

bigquery.tables.get -

bigquery.tables.getData -

bigquery.tables.replicateData -

bigquery.jobs.create - Amazon S3를 지원하는 리전에 데이터 세트를 만듭니다.

- 이전 단계에서 만든 데이터 세트에 소스 테이블을 만듭니다. 소스 테이블은 다음 테이블 유형 중 하나일 수 있습니다.

- 메타데이터 캐싱이 사용 설정되어 있고 Iceberg 파일 형식을 사용하지 않는 Amazon S3 BigLake 테이블

- Apache Iceberg 외부 테이블

- Data Cloud 테이블

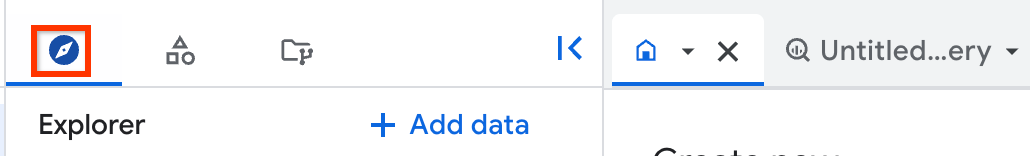

Google Cloud 콘솔에서 BigQuery 페이지로 이동합니다.

왼쪽 창에서 탐색기를 클릭합니다.

왼쪽 창이 표시되지 않으면 왼쪽 창 펼치기를 클릭하여 창을 엽니다.

탐색기 창에서 구체화된 뷰 복제본을 만들려는 프로젝트 및 데이터 세트로 이동한 다음 작업 > 테이블 만들기를 클릭합니다.

테이블 만들기 대화상자의 소스 섹션에서 다음을 수행합니다.

- 다음 항목으로 테이블 만들기에서 기존 테이블/뷰를 선택합니다.

- 프로젝트에 소스 테이블 또는 뷰가 있는 프로젝트를 입력합니다.

- 데이터 세트에 소스 테이블 또는 뷰가 있는 데이터 세트를 입력합니다.

- 보기에 복제할 소스 테이블 또는 뷰를 입력합니다. 뷰를 선택하는 경우 승인된 뷰여야 합니다. 그렇지 않은 경우 뷰를 생성하는 데 사용되는 모든 테이블이 뷰의 데이터 세트에 있어야 합니다.

(선택사항) 로컬 구체화된 뷰 최대 비활성의 경우 로컬 구체화된 뷰의

max_staleness값을 입력합니다.테이블 만들기 대화상자의 대상 섹션에서 다음을 수행합니다.

- 프로젝트에 구체화된 뷰 복제본을 만들 프로젝트를 입력합니다.

- 데이터 세트에 구체화된 뷰 복제본을 만들 데이터 세트를 입력합니다.

- 복제본 구체화된 뷰 이름에 복제본 이름을 입력합니다.

(선택사항) 구체화된 뷰 복제본의 태그 및 고급 옵션을 지정합니다. 로컬 구체화된 뷰 데이터 세트의 데이터 세트를 지정하지 않으면 소스 데이터와 동일한 프로젝트 및 리전에서 자동으로 생성되고 이름이

bq_auto_generated_local_mv_dataset로 지정됩니다. 로컬 구체화된 뷰 이름의 이름을 지정하지 않으면 소스 데이터와 동일한 프로젝트 및 리전에서 자동으로 생성되고 프리픽스bq_auto_generated_local_mv_가 지정됩니다.테이블 만들기를 클릭합니다.

- 만든 데이터 세트의 기본 테이블에 대해 구체화된 뷰를 만듭니다. Amazon S3 리전에 있는 다른 데이터 세트에도 구체화된 뷰를 만들 수 있습니다.

- 구체화된 뷰를 만든 쿼리에 사용된 소스 테이블이 포함된 데이터 세트에서 구체화된 뷰를 승인합니다.

- 소스 테이블에 수동 메타데이터 캐시 새로고침을 구성한 경우

BQ.REFRESH_EXTERNAL_METADATA_CACHE시스템 프러시저를 실행하여 메타데이터 캐시를 새로고침합니다. BQ.REFRESH_MATERIALIZED_VIEW시스템 프로시저를 실행하여 구체화된 뷰를 새로고침합니다.CREATE MATERIALIZED VIEW AS REPLICA OF문을 사용하여 구체화된 뷰 복제본을 만듭니다.CREATE MATERIALIZED VIEW PROJECT_ID.BQ_DATASET.REPLICA_NAME OPTIONS(replication_interval_seconds=REPLICATION_INTERVAL) AS REPLICA OF PROJECT_ID.S3_DATASET.MATERIALIZED_VIEW_NAME;

다음을 바꿉니다.

PROJECT_ID: 구체화된 뷰 복제본을 만들 프로젝트의 이름입니다(예:myproject).BQ_DATASET: 구체화된 뷰 복제본을 만들 BigQuery 데이터 세트의 이름입니다(예:bq_dataset). 데이터 세트는 소스 구체화된 뷰의 리전에 매핑되는 BigQuery 리전에 있어야 합니다.REPLICA_NAME: 만들려는 구체화된 뷰 복제본의 이름입니다(예:my_mv_replica).REPLICATION_INTERVAL: 소스 구체화된 뷰의 데이터를 복제본에 복제하는 빈도(초)를 지정합니다. 60~3,600(포함) 사이의 값이어야 합니다. 기본값은 300(5분)입니다.S3_DATASET: 소스 구체화된 뷰가 포함된 데이터 세트의 이름입니다(예:s3_dataset).MATERIALIZED_VIEW_NAME: 복제할 구체화된 뷰의 이름입니다(예:my_mv).

다음 예시에서는

bq_dataset에mv_replica라는 구체화된 뷰 복제본을 만듭니다.CREATE MATERIALIZED VIEW `myproject.bq_dataset.mv_replica` OPTIONS( replication_interval_seconds=600 ) AS REPLICA OF `myproject.s3_dataset.my_s3_mv`

- 구체화된 뷰 복제본의 최신 상태를 보려면 구체화된 뷰 복제본의 세부정보 창에서 최종 수정 시간 필드를 확인합니다.

- 소스 구체화된 뷰의 최신 상태를 보려면 구체화된 뷰의 세부정보 창에서 최종 수정 시간 필드를 확인합니다.

- 소스 Amazon S3, Iceberg 또는 Data Cloud 테이블 메타데이터 캐시의 최신 상태를 보려면 구체화된 뷰의 세부정보 창에서 최대 비활성 필드를 확인합니다.

northamerica-northeast1northamerica-northeast2us-central1us-east1us-east4us-east5us-south1us-west1us-west2us-west3us-west4northamerica-northeast1northamerica-northeast2us-central1us-east1us-east4us-east5us-south1us-west1us-west2us-west3us-west4europe-central2europe-north1europe-southwest1europe-west1europe-west2europe-west3europe-west4europe-west6europe-west8europe-west9europe-west10asia-east1asia-east2asia-northeast1asia-northeast2asia-northeast3asia-south1asia-south2asia-southeast1australia-southeast1australia-southeast2- 행 수준 보안 또는 열 수준 보안을 사용하는 테이블을 기반으로 하는 구체화된 뷰에는 구체화된 뷰 복제본을 만들 수 없습니다.

- 소스 구체화된 뷰 또는 구체화된 뷰 복제본에는 고객 관리 암호화 키(CMEK)를 사용할 수 없습니다.

- 메타데이터 캐싱을 사용하는 테이블을 기반으로 하는 구체화된 뷰에만 구체화된 뷰 복제본을 만들 수 있습니다.

- 지정된 소스 구체화된 뷰에 대해 구체화된 뷰 복제본 하나만 만들 수 있습니다.

- 승인된 구체화된 뷰의 구체화된 뷰 복제본만 만들 수 있습니다.

- BigQuery ML 알아보기

- BigQuery Omni 알아보기

- 쿼리 실행 방법 알아보기

- BigQuery Omni의 VPC 서비스 제어 설정 방법 알아보기

- Amazon S3에서 BigQuery로 및 Blob Storage에서 BigQuery로의 반복 로드 작업을 예약하고 관리하는 방법 알아보기

필요한 역할

이 섹션의 작업을 수행하는 데 필요한 권한을 얻으려면 관리자에게 BigQuery 관리자 (roles/bigquery.admin) IAM 역할을 부여해 달라고 요청하세요.

역할 부여에 대한 자세한 내용은 프로젝트, 폴더, 조직에 대한 액세스 관리를 참조하세요.

이 사전 정의된 역할에는 이 섹션의 작업을 수행하는 데 필요한 권한이 포함되어 있습니다. 필요한 정확한 권한을 보려면 필수 권한 섹션을 펼치세요.

필수 권한

이 섹션의 작업을 수행하려면 다음 권한이 필요합니다.

커스텀 역할이나 다른 사전 정의된 역할을 사용하여 이 권한을 부여받을 수도 있습니다.

BigQuery IAM에 대한 자세한 내용은 BigQuery IAM 역할 및 권한을 참고하세요.

구체화된 뷰 복제본을 위한 데이터 세트 준비

구체화된 뷰 복제본을 만들기 전에 다음 태스크를 완료해야 합니다.

구체화된 뷰 복제본 만들기

다음 옵션 중 하나를 선택합니다.

콘솔

(지정되지 않은 경우) 새 로컬 구체화된 뷰가 생성되고 소스 데이터 세트에서 승인됩니다. 그러면 대상 데이터 세트에 구체화된 뷰 복제본이 생성됩니다.

SQL

구체화된 뷰 복제본을 만들면 복제 프로세스에서 변경사항에 대한 소스 구체화된 뷰를 폴링하여 데이터를 구체화된 뷰 복제본에 복제하므로 replication_interval_seconds 또는 max_staleness 옵션에 지정된 간격으로 데이터가 새로고침됩니다. 첫 번째 백필이 완료되기 전에 복제본을 쿼리하면 backfill in progress 오류가 발생합니다. 첫 번째 복제가 완료된 후에 구체화된 뷰 복제본의 데이터를 쿼리할 수 있습니다.

데이터 최신 상태

구체화된 뷰 복제본이 생성되면 복제 프로세스는 변경사항에 대한 소스 구체화된 뷰를 폴링하고 데이터를 구체화된 뷰 복제본에 복제합니다. CREATE MATERIALIZED VIEW AS REPLICA OF 문의 replication_interval_seconds 옵션에 지정된 간격으로 데이터가 복제됩니다.

복제 간격 외에도 구체화된 뷰 복제본 데이터의 최신 상태는 소스 구체화된 뷰를 새로 고치는 빈도와 구체화된 뷰에서 사용하는 Amazon S3, Iceberg 또는 Data Cloud 테이블의 메타데이터 캐시를 새로 고치는 빈도에 따라 영향을 받습니다.

Google Cloud 콘솔을 사용하여 구체화된 뷰 복제본 및 해당 리소스의 데이터 최신 상태를 확인할 수 있습니다.

지원되는 구체화된 뷰 복제본 리전

구체화된 뷰 복제본을 만들 때 다음 표의 위치 매핑을 사용합니다.

| 소스 구체화된 뷰의 위치 | 구체화된 뷰 복제본의 위치 |

|---|---|

aws-us-east-1 |

US 멀티 리전 또는 다음 리전 중 하나: |

aws-us-west-2 |

US 멀티 리전 또는 다음 리전 중 하나: |

aws-eu-west-1 |

EU 멀티 리전 또는 다음 리전 중 하나: |

aws-ap-northeast-2 |

다음 리전 중 하나: |

aws-ap-southeast-2 |

다음 리전 중 하나: |

구체화된 뷰 복제본의 제한사항

구체화된 뷰 복제본 가격 책정

구체화된 뷰 복제본을 사용하면 컴퓨팅, 아웃바운드 데이터 전송, 스토리지 비용이 발생합니다.