Usar o plug-in do JupyterLab no BigQuery

Para solicitar feedback ou suporte para esse recurso, envie um e-mail para bigquery-ide-plugin@google.com.

Este documento mostra como instalar e usar a API O plug-in do JupyterLab faz o seguinte:

- Explorar seus dados do BigQuery.

- Usar a API DataFrames do BigQuery.

- Implantar um notebook do DataFrames do BigQuery no Cloud Composer.

O plug-in do JupyterLab do BigQuery inclui todos os da função Plug-in Dataproc JupyterLab, como criar um modelo de ambiente de execução sem servidor do Dataproc, iniciar e gerenciar notebooks, desenvolver com o Apache Spark, implantar seu código, e gerenciar seus recursos.

Instalar o plug-in do JupyterLab do BigQuery

Para instalar e usar o plug-in BigQuery JupyterLab, siga estas etapas:

No seu terminal local, verifique se você tem o Python 3.8 ou mais recente. instalados em seu sistema:

python3 --versionNo seu terminal local, Inicialize a CLI gcloud:

gcloud initInstale o Pipenv, uma ferramenta de ambiente virtual do Python:

pip3 install pipenvCrie um novo ambiente virtual:

pipenv shellInstale o JupyterLab no novo ambiente virtual:

pipenv install jupyterlabInstale o plug-in do JupyterLab do BigQuery:

pipenv install bigquery-jupyter-pluginSe a versão instalada do JupyterLab for anterior que a versão 4.0.0, ative a extensão do plug-in:

jupyter server extension enable bigquery_jupyter_pluginInicie o JupyterLab:

jupyter labO JupyterLab é aberto no navegador.

Atualizar as configurações de projeto e região

Por padrão, sua sessão é executada no projeto e na região que você definiu quando

executou gcloud init. Para mudar as configurações de projeto e região do

faça o seguinte:

- No menu do JupyterLab, clique em Configurações > Configurações do Google BigQuery.

É necessário reiniciar o plug-in para que as mudanças entrem em vigor.

Explorar dados

Para trabalhar com os dados do BigQuery no JupyterLab, faça o seguinte:

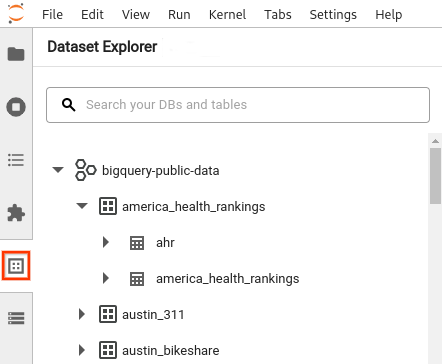

- Na barra lateral do JupyterLab, abra o painel Explorador de conjunto de dados: clique no

ícone dos conjuntos de dados.

ícone dos conjuntos de dados. Para expandir um projeto, no painel Dataset Explorer, clique em seta de expansão ao lado do nome do projeto.

O painel Explorador de conjunto de dados mostra todos os conjuntos de dados em um projeto que ficam na região do BigQuery que você configurou a sessão. É possível interagir com um projeto e um conjunto de dados de várias maneiras:

- Para exibir informações sobre um conjunto de dados, clique no nome dele.

- Para exibir todas as tabelas em um conjunto de dados, clique no seta de expansão ao lado de conjunto de dados.

- Para visualizar informações sobre uma tabela, clique no nome dela.

- Para alterar o projeto ou a região do BigQuery, atualize suas configurações.

Executar notebooks

Para consultar os dados do BigQuery no JupyterLab, faça o seguinte:

- Para abrir a página de acesso rápido, clique em Arquivo > Nova tela de início.

- Na seção Notebooks do BigQuery, clique em DataFrames do BigQuery cartão de crédito. Um novo notebook é aberto, mostrando como começar a usar o DataFrames do BigQuery.

Os notebooks do DataFrames do BigQuery oferecem suporte ao desenvolvimento em Python em um ambiente kernel do Python. As operações do DataFrames do BigQuery são executadas remotamente o BigQuery, mas o restante do código é executado localmente máquina local. Quando uma operação é executada no BigQuery, um job de consulta O ID e o link para o job aparecem abaixo da célula de código.

- Para abrir o job no console do Google Cloud , clique em Abrir job.

Implantar um notebook do DataFrames do BigQuery

É possível implantar um notebook do DataFrames do BigQuery no Cloud Composer usando um modelo de ambiente de execução sem servidor do Dataproc. Use o do ambiente de execução versão 2.1 ou posterior.

- No notebook do JupyterLab, clique em calendar_monthProgramador de jobs.

- Em Nome do job, insira um nome exclusivo.

- Em Ambiente, insira o nome do Cloud Composer. ambiente em que você quer implantar o job.

- Se o notebook estiver parametrizado, adicione parâmetros.

- Digite o nome do Modelo de ambiente de execução sem servidor:

- Para processar falhas de execução do notebook, insira um número inteiro em Contagem de tentativas. e um valor (em minutos) para Atraso na repetição.

Selecione quais notificações de execução serão enviadas e insira os destinatários.

As notificações são enviadas usando a configuração SMTP do Airflow.

Selecione uma programação para o notebook.

Clique em Criar.

Quando você programa seu notebook, ele aparece na lista de jobs programados no ambiente selecionado do Cloud Composer.

A seguir

- Conheça o guia de início rápido do BigQuery DataFrames.

- Saiba mais sobre a política de API BigQuery DataFrames Python.

- Use o JupyterLab para sessões de notebook e lote sem servidor com o Dataproc.