Analyser les problèmes de qualité des données

Ce document explique comment utiliser BigQuery et Dataplex Universal Catalog pour vous assurer que les données répondent à vos attentes en termes de qualité. La qualité automatique des données de Dataplex Universal Catalog vous permet de définir et d'évaluer la qualité des données de vos tables BigQuery. Vous pouvez automatiser l'analyse des données, les valider par rapport à des règles définies et enregistrer des alertes si vos données ne répondent pas aux exigences de qualité.

Pour en savoir plus sur la qualité automatique des données, consultez la présentation de la qualité automatique des données.

Avant de commencer

-

Enable the Dataplex API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Facultatif : si vous souhaitez que Dataplex Universal Catalog génère des recommandations pour les règles de qualité des données en fonction des résultats d'une analyse de profilage des données, créez et exécutez l'analyse de profilage des données.

Rôles requis

Cette section décrit les rôles et autorisations IAM nécessaires pour utiliser les analyses de la qualité des données Dataplex Universal Catalog.

Rôles et autorisations des utilisateurs

Pour obtenir les autorisations nécessaires pour exécuter et gérer les analyses de la qualité des données, demandez à votre administrateur de vous accorder les rôles IAM suivants :

-

Exécuter une analyse de la qualité des données sur une table BigQuery :

-

Utilisateur de job BigQuery (

roles/bigquery.jobUser) sur le projet pour exécuter des jobs d'analyse -

Lecteur de données BigQuery (

roles/bigquery.dataViewer) sur la table BigQuery à analyser

-

Utilisateur de job BigQuery (

-

Publiez les résultats de l'analyse de la qualité des données dans Dataplex Universal Catalog :

-

Éditeur de données BigQuery (

roles/bigquery.dataEditor) sur la table analysée -

Éditeur de catalogue Dataplex (

roles/dataplex.catalogEditor) sur le groupe d'entrées@bigqueryau même emplacement que le tableau

-

Éditeur de données BigQuery (

-

Effectuez des tâches spécifiques sur les ressources

DataScan:-

Administrateur Dataplex DataScan (

roles/dataplex.dataScanAdmin) sur le projet pour un accès complet -

Créateur Dataplex DataScan (

roles/dataplex.dataScanCreator) sur le projet pour créer des analyses -

Éditeur Dataplex DataScan (

roles/dataplex.dataScanEditor) sur le projet pour l'accès en écriture -

Lecteur Dataplex DataScan (

roles/dataplex.dataScanViewer) sur le projet pour lire les métadonnées d'analyse -

Lecteur de données Dataplex DataScan (

roles/dataplex.dataScanDataViewer) sur le projet pour lire les données d'analyse, y compris les règles et les résultats

-

Administrateur Dataplex DataScan (

Pour en savoir plus sur l'attribution de rôles, consultez Gérer l'accès aux projets, aux dossiers et aux organisations.

Ces rôles prédéfinis contiennent les autorisations requises pour exécuter et gérer les analyses de la qualité des données. Pour connaître les autorisations exactes requises, développez la section Autorisations requises :

Autorisations requises

Les autorisations suivantes sont requises pour exécuter et gérer les analyses de la qualité des données :

-

Exécuter une analyse de la qualité des données sur une table BigQuery :

-

bigquery.jobs.createsur le projet pour exécuter des tâches d'analyse -

bigquery.tables.getsur la table BigQuery à analyser -

bigquery.tables.getDatasur la table BigQuery à analyser

-

-

Publiez les résultats de l'analyse de la qualité des données dans Dataplex Universal Catalog :

-

bigquery.tables.updatesur la table analysée -

dataplex.entryGroups.useDataQualityScorecardAspectsur le groupe d'entrées@bigqueryau même emplacement que la table

-

-

Créez un

DataScan:dataplex.datascans.createsur le projet -

Supprimer un

DataScan:dataplex.datascans.deletesur le projet -

Affichez les métadonnées

DataScan:dataplex.datascans.getsur le projet. -

Afficher les détails du

DataScan, y compris les règles et les résultats :dataplex.datascans.getDatasur le projet -

Lister les

DataScan:dataplex.datascans.listsur le projet -

Exécuter un

DataScan:dataplex.datascans.runsur le projet -

Mettre à jour un

DataScan:dataplex.datascans.updatesur le projet -

Obtenir ou définir une stratégie IAM sur un

DataScan:dataplex.datascans.getIamPolicysur le projetdataplex.datascans.setIamPolicysur le projet

Vous pouvez également obtenir ces autorisations avec des rôles personnalisés ou d'autres rôles prédéfinis.

Si vous devez accéder à des colonnes protégées par des règles d'accès BigQuery au niveau des colonnes, vous devez également disposer des autorisations correspondantes.

Rôles et autorisations du compte de service Dataplex Universal Catalog

Si vous n'avez créé aucune analyse de la qualité des données ni aucune analyse de profilage des données, ou si vous ne disposez d'aucun lac Dataplex Universal Catalog dans ce projet, créez un identifiant de service en exécutant la commande suivante : gcloud beta services identity create --service=dataplex.googleapis.com.

Cette commande renvoie un identifiant de service Dataplex Universal Catalog s'il existe.

Pour vous assurer que le compte de service Dataplex Universal Catalog du projet contenant l'analyse de la qualité des données dispose des autorisations nécessaires pour lire les données provenant de différentes sources et exporter les résultats, demandez à votre administrateur d'accorder les rôles IAM suivants au compte de service Dataplex Universal Catalog du projet contenant l'analyse de la qualité des données :

-

Lire les données des table BigQuery :

Lecteur de données BigQuery (

roles/bigquery.dataViewer) sur les tables BigQuery à analyser et toutes les autres tables référencées dans les règles -

Exporter les résultats de l'analyse vers une table BigQuery :

Éditeur de données BigQuery (

roles/bigquery.dataEditor) sur l'ensemble de données et la table de résultats -

Analysez les données BigQuery organisées dans un lac Dataplex Universal Catalog :

-

Lecteur de métadonnées Dataplex (

roles/dataplex.metadataReader) sur les ressources Dataplex -

Lecteur Dataplex (

roles/dataplex.viewer) sur les ressources Dataplex

-

Lecteur de métadonnées Dataplex (

-

Analyser une table externe BigQuery à partir de Cloud Storage :

Lecteur des objets Storage (

roles/storage.objectViewer) sur le bucket Cloud Storage

Pour en savoir plus sur l'attribution de rôles, consultez Gérer l'accès aux projets, aux dossiers et aux organisations.

Ces rôles prédéfinis contiennent les autorisations requises pour lire les données de différentes sources et exporter les résultats. Pour connaître les autorisations exactes requises, développez la section Autorisations requises :

Autorisations requises

Vous devez disposer des autorisations suivantes pour lire les données de différentes sources et exporter les résultats :

-

Lire les données d'une table BigQuery :

-

bigquery.tables.getsur les tables BigQuery -

bigquery.tables.getDatasur les tables BigQuery

-

-

Exportez les résultats de l'analyse vers une table BigQuery :

-

bigquery.datasets.getsur l'ensemble de données et la table de résultats -

bigquery.tables.createsur l'ensemble de données et la table de résultats -

bigquery.tables.getsur l'ensemble de données et la table de résultats -

bigquery.tables.getDatasur l'ensemble de données et la table de résultats -

bigquery.tables.updatesur l'ensemble de données et la table de résultats -

bigquery.tables.updateDatasur l'ensemble de données et la table de résultats

-

-

Analysez les données BigQuery organisées dans un lac Dataplex Universal Catalog :

-

dataplex.lakes.listsur les ressources Dataplex -

dataplex.lakes.getsur les ressources Dataplex -

dataplex.zones.listsur les ressources Dataplex -

dataplex.zones.getsur les ressources Dataplex -

dataplex.entities.listsur les ressources Dataplex -

dataplex.entities.getsur les ressources Dataplex -

dataplex.operations.getsur les ressources Dataplex

-

-

Analyser une table externe BigQuery à partir de Cloud Storage :

-

storage.buckets.getsur le bucket Cloud Storage -

storage.objects.getsur le bucket Cloud Storage

-

Votre administrateur peut également attribuer au compte de service Dataplex Universal Catalog du projet contenant l'analyse de la qualité des données ces autorisations avec des rôles personnalisés ou d'autres rôles prédéfinis.

Si vous devez accéder à des colonnes protégées par des règles d'accès BigQuery au niveau des colonnes, attribuez les autorisations correspondantes au compte de service Dataplex Universal Catalog.

Si des règles d'accès BigQuery au niveau des lignes sont activées pour une table, vous ne pouvez analyser que les lignes visibles par le compte de service Dataplex Universal Catalog. Notez que les droits d'accès de chaque utilisateur ne sont pas évalués pour les règles au niveau des lignes.

Créer une analyse de qualité des données

Console

Dans la console Google Cloud , sur la page Curation des métadonnées de BigQuery, accédez à l'onglet Qualité et profilage des données.

Cliquez sur Créer une analyse de la qualité des données.

Dans la fenêtre Définir l'analyse, renseignez les champs suivants :

Facultatif : Saisissez un nom à afficher.

Saisissez un ID. Consultez les conventions d'attribution de noms pour les ressources.

Facultatif : Saisissez une description.

Dans le champ Table, cliquez sur Parcourir. Choisissez la table à analyser, puis cliquez sur Sélectionner. Seules les tables BigQuery standards sont acceptées.

Pour les tables des ensembles de données multirégionaux, choisissez une région dans laquelle créer l'analyse de données.

Pour parcourir les tables organisées dans les lacs Dataplex Universal Catalog, cliquez sur Parcourir les lacs Dataplex.

Dans le champ Champ d'application, sélectionnez Incrémentiel ou Intégralité des données.

- Si vous choisissez Incrémentiel : dans le champ Colonne de code temporel, sélectionnez une colonne de type

DATEouTIMESTAMPdans votre table BigQuery qui augmente à mesure que de nouveaux enregistrements sont ajoutés et qui permet d'identifier de nouveaux enregistrements. Il peut s'agir d'une colonne qui partitionne la table.

- Si vous choisissez Incrémentiel : dans le champ Colonne de code temporel, sélectionnez une colonne de type

Pour filtrer vos données, cochez la case Filtrer les lignes. Fournissez un filtre de ligne constitué d'une expression SQL valide pouvant être utilisée dans une clause

WHEREen syntaxe GoogleSQL. Exemple :col1 >= 0. Le filtre peut être une combinaison de plusieurs conditions de colonne. Par exemple,col1 >= 0 AND col2 < 10.Pour échantillonner vos données, sélectionnez un pourcentage d'échantillonnage dans la liste Taille d'échantillonnage. Choisissez un pourcentage compris entre 0,0 et 100,0 %, avec un maximum de trois chiffres après la virgule. Pour les ensembles de données plus volumineux, choisissez un pourcentage d'échantillonnage plus faible. Par exemple, pour une table de 1 Po, si vous saisissez une valeur comprise entre 0,1 et 1 %, l'analyse de la qualité des données échantillonne entre 1 et 10 To de données. Pour les analyses de données incrémentielles, l'analyse de la qualité des données applique l'échantillonnage au dernier incrément.

Pour publier les résultats de l'analyse de la qualité des données en tant que métadonnées Dataplex Universal Catalog, cochez la case Publier les résultats dans Dataplex Catalog.

Vous pouvez consulter les derniers résultats de l'analyse dans l'onglet Qualité des données des pages BigQuery et Dataplex Universal Catalog pour la table source. Pour permettre aux utilisateurs d'accéder aux résultats d'analyse publiés, consultez la section Accorder l'accès aux résultats d'analyse de la qualité des données de ce document.

Dans la section Planification, choisissez l'une des options suivantes :

Répétition : exécutez l'analyse de la qualité des données selon une planification horaire, quotidienne, hebdomadaire, mensuelle ou personnalisée. Spécifiez la fréquence et l'heure d'exécution de l'analyse. Si vous choisissez "Personnalisée", utilisez le format cron pour spécifier la planification.

À la demande : exécutez l'analyse de la qualité des données à la demande.

Ponctuelle : exécutez l'analyse de la qualité des données une seule fois, puis supprimez-la après la période de durée de vie.

Durée de vie : la durée de vie est l'intervalle de temps entre l'exécution et la suppression de l'analyse. Une analyse de la qualité des données sans durée de vie spécifiée est automatiquement supprimée 24 heures après son exécution. La durée de vie peut être comprise entre 0 seconde (suppression immédiate) et 365 jours.

Cliquez sur Continuer.

Dans la fenêtre Règles sur la qualité des données, définissez les règles à configurer pour cette analyse de la qualité des données.

Cliquez sur Ajouter des règles, puis sélectionnez l'une des options suivantes.

Recommandations basées sur les profils : créez des règles à partir des recommandations basées sur une analyse de profilage des données existante.

Sélectionner des colonnes : sélectionnez les colonnes pour lesquelles vous souhaitez obtenir des règles recommandées.

Sélectionner un projet d'analyse : si l'analyse de profilage des données se trouve dans un projet différent de celui dans lequel vous créez l'analyse de la qualité des données, sélectionnez le projet à partir duquel extraire les analyses de profilage.

Sélectionner des résultats de profil : sélectionnez un ou plusieurs résultats de profil, puis cliquez sur OK. Une liste de règles suggérées s'affiche. Vous pouvez l'utiliser comme point de départ.

Cochez les cases correspondant aux règles que vous souhaitez ajouter, puis cliquez sur Sélectionner. Une fois sélectionnées, les règles sont ajoutées à votre liste de règles actuelle. Vous pouvez ensuite modifier les règles.

Types de règles intégrés : créez des règles à partir de règles prédéfinies. Consultez la liste des règles prédéfinies.

Sélectionner des colonnes : sélectionnez les colonnes pour lesquelles vous souhaitez sélectionner des règles.

Choisir les types de règles : sélectionnez les types de règles que vous souhaitez choisir, puis cliquez sur OK. Les types de règles qui s'affichent dépendent des colonnes que vous avez sélectionnées.

Cochez les cases correspondant aux règles que vous souhaitez ajouter, puis cliquez sur Sélectionner. Une fois sélectionnées, les règles sont ajoutées à votre liste de règles actuelle. Vous pouvez ensuite modifier les règles.

Règle de vérification des lignes SQL : créez une règle SQL personnalisée à appliquer à chaque ligne.

Dans Dimension, choisissez une dimension.

Dans Seuil de réussite, choisissez le pourcentage d'enregistrements qui doivent réussir le contrôle.

Dans Nom de la colonne, sélectionnez une colonne.

Dans le champ Fournissez une expression SQL, saisissez une expression SQL qui renvoie la valeur booléenne

true(succès) oufalse(échec). Pour en savoir plus, consultez Types de règles SQL personnalisées compatibles et les exemples de la section Définir des règles de qualité des données.Cliquez sur Ajouter.

Règle de vérification des agrégations SQL : créez une règle de condition de table SQL personnalisée.

Dans Dimension, choisissez une dimension.

Dans Nom de la colonne, sélectionnez une colonne.

Dans le champ Fournissez une expression SQL, saisissez une expression SQL qui renvoie la valeur booléenne

true(succès) oufalse(échec). Pour en savoir plus, consultez Types de règles SQL personnalisées compatibles et les exemples de la section Définir des règles de qualité des données.Cliquez sur Ajouter.

Règle d'assertion SQL : créez une règle d'assertion SQL personnalisée pour vérifier si les données sont dans un état non valide.

Dans Dimension, choisissez une dimension.

Facultatif : dans Nom de la colonne, sélectionnez une colonne.

Dans le champ Fournissez une instruction SQL, saisissez une instruction SQL qui renvoie les lignes correspondant à l'état non valide. Si des lignes sont renvoyées, cette règle échoue. Omettez le point-virgule de fin de l'instruction SQL. Pour en savoir plus, consultez Types de règles SQL personnalisées compatibles et les exemples de la section Définir des règles de qualité des données.

Cliquez sur Ajouter.

Facultatif : Pour toute règle de qualité des données, vous pouvez attribuer un nom personnalisé à utiliser pour la surveillance et les alertes, ainsi qu'une description. Pour ce faire, modifiez une règle et spécifiez les informations suivantes :

- Nom de la règle : saisissez un nom de règle personnalisé de 63 caractères maximum. Le nom de la règle peut inclure des lettres (a-z, A-Z), des chiffres (0-9) et des traits d'union (-). Il doit commencer par une lettre et se terminer par un chiffre ou une lettre.

- Description : saisissez une description de la règle de 1 024 caractères maximum.

Répétez les étapes précédentes pour ajouter d'autres règles à l'analyse de la qualité des données. Lorsque vous avez terminé, cliquez sur Continuer.

Facultatif : Exportez les résultats de l'analyse vers une table BigQuery standard. Dans la section Exporter les résultats d'analyse dans une table BigQuery, procédez comme suit :

Dans le champ Sélectionnez un ensemble de données BigQuery, cliquez sur Parcourir. Sélectionnez un ensemble de données BigQuery dans lequel stocker les résultats de l'analyse de la qualité des données.

Dans le champ Table BigQuery, spécifiez la table dans laquelle stocker les résultats de l'analyse de la qualité des données. Si vous utilisez une table existante, assurez-vous qu'elle est compatible avec le schéma de la table d'exportation. Si la table spécifiée n'existe pas, Dataplex Universal Catalog la crée pour vous.

Facultatif : Ajoutez des étiquettes. Les étiquettes sont des paires clé/valeur qui vous permettent de regrouper des objets associés ou de les combiner à d'autres Google Cloud ressources.

Facultatif : Configurez des rapports de notification par e-mail pour informer les utilisateurs de l'état et des résultats d'un job d'analyse de la qualité des données. Dans la section Rapport de notification, cliquez sur Ajouter un ID d'adresse e-mail et saisissez jusqu'à cinq adresses e-mail. Sélectionnez ensuite les scénarios pour lesquels vous souhaitez envoyer des rapports :

- Niveau de qualité (<=) : envoie un rapport lorsqu'un job réussit avec un niveau de qualité des données inférieur au niveau cible spécifié. Saisissez un score de qualité cible compris entre 0 et 100.

- Échecs de jobs : envoie un rapport en cas d'échec du job lui-même, quels que soient les résultats de la qualité des données.

- Achèvement de jobs (réussite ou échec) : envoie un rapport à la fin du job, quels que soient les résultats de la qualité des données.

Cliquez sur Créer.

Une fois l'analyse créée, vous pouvez l'exécuter à tout moment en cliquant sur Exécuter maintenant.

gcloud

Pour créer une analyse de la qualité des données, utilisez la commande gcloud dataplex datascans create data-quality.

Si les données source sont organisées dans un lac Dataplex Universal Catalog, incluez l'indicateur --data-source-entity :

gcloud dataplex datascans create data-quality DATASCAN \

--location=LOCATION \

--data-quality-spec-file=DATA_QUALITY_SPEC_FILE \

--data-source-entity=DATA_SOURCE_ENTITY

Si les données source ne sont pas organisées dans un lac Dataplex Universal Catalog, incluez l'indicateur --data-source-resource :

gcloud dataplex datascans create data-quality DATASCAN \

--location=LOCATION \

--data-quality-spec-file=DATA_QUALITY_SPEC_FILE \

--data-source-resource=DATA_SOURCE_RESOURCE

Remplacez les variables suivantes :

DATASCAN: nom de l'analyse de la qualité des données.LOCATION: région Google Cloud dans laquelle créer l'analyse de la qualité des données.DATA_QUALITY_SPEC_FILE: chemin d'accès au fichier JSON ou YAML contenant les spécifications de l'analyse de la qualité des données. Il peut s'agir d'un fichier local ou d'un chemin d'accès Cloud Storage avec le préfixegs://. Utilisez ce fichier pour spécifier les règles de qualité des données pour l'analyse. Vous pouvez également spécifier des informations supplémentaires dans ce fichier, telles que des filtres, un pourcentage d'échantillonnage et des actions post-analyse (par exemple, l'exportation vers BigQuery ou l'envoi de rapports de notification par e-mail). Consultez la documentation sur la représentation JSON et l'exemple de représentation YAML.DATA_SOURCE_ENTITY: entité Dataplex Universal Catalog contenant les données pour l'analyse de la qualité des données. Exemple :projects/test-project/locations/test-location/lakes/test-lake/zones/test-zone/entities/test-entity.DATA_SOURCE_RESOURCE: nom de la ressource contenant les données pour l'analyse de la qualité des données. Exemple ://bigquery.googleapis.com/projects/test-project/datasets/test-dataset/tables/test-table.

C#

C#

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Go

Go

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Java

Java

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Node.js

Node.js

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Python

Python

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Ruby

Ruby

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

REST

Pour créer une analyse de la qualité des données, utilisez la méthode dataScans.create.

La requête suivante crée une analyse ponctuelle de la qualité des données :

POST https://dataplex.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/dataScans?data_scan_id=DATASCAN_ID { "data": { "resource": "//bigquery.googleapis.com/projects/PROJECT_ID/datasets/DATASET_ID/tables/TABLE_ID" }, "type": "DATA_QUALITY", "executionSpec": { "trigger": { "oneTime": { "ttl_after_scan_completion": "120s" } } }, "dataQualitySpec": { "rules": [ { "nonNullExpectation": {}, "column": "COLUMN_NAME", "dimension": "DIMENSION", "threshold": 1 } ] } }

Remplacez les éléments suivants :

PROJECT_ID: ID de votre projetLOCATION: région dans laquelle créer l'analyse de la qualité des données.DATASCAN_ID: ID de l'analyse de la qualité des données.DATASET_ID: ID de l'ensemble de données BigQuery.TABLE_ID: ID de la table BigQuery.COLUMN_NAME: nom de la colonne pour la règle.DIMENSION: dimension de la règle, par exempleVALIDITY.

Si vous souhaitez créer des règles pour l'analyse de la qualité des données à l'aide de recommandations de règles basées sur les résultats d'une analyse de profilage des données, obtenez les recommandations en appelant la méthode dataScans.jobs.generateDataQualityRules sur l'analyse de profilage des données.

Exécuter une analyse de la qualité des données

Console

Dans la console Google Cloud , sur la page Curation des métadonnées de BigQuery, accédez à l'onglet Qualité et profilage des données.

Cliquez sur l'analyse de la qualité des données à exécuter.

Cliquez sur Exécuter maintenant.

gcloud

Pour exécuter une analyse de la qualité des données, utilisez la commande gcloud dataplex datascans run :

gcloud dataplex datascans run DATASCAN \ --location=LOCATION \

Remplacez les variables suivantes :

LOCATION: région Google Cloud dans laquelle l'analyse de la qualité des données a été créée.DATASCAN: nom de l'analyse de la qualité des données.

C#

C#

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Go

Go

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Java

Java

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Python

Python

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Ruby

Ruby

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

REST

Pour exécuter une analyse de la qualité des données, utilisez la méthode dataScans.run :

Afficher les résultats d'analyse de qualité des données

Console

Dans la console Google Cloud , sur la page Curation des métadonnées de BigQuery, accédez à l'onglet Qualité et profilage des données.

Cliquez sur le nom d'une analyse de la qualité des données.

La section Présentation affiche des informations sur les jobs les plus récents, y compris la date d'exécution de l'analyse, le nombre d'enregistrements analysés dans chaque job, si tous les contrôles de qualité des données ont réussi, et s'il y a eu des échecs, le nombre de contrôles de qualité des données qui ont échoué.

La section Configuration de l'analyse de la qualité des données affiche des informations sur l'analyse.

Pour afficher des informations détaillées sur un job, comme les scores de qualité des données qui indiquent le pourcentage de règles réussies, les règles qui ont échoué et les journaux de job, cliquez sur l'onglet Historique des jobs. Cliquez ensuite sur un ID de job.

gcloud

Pour afficher les résultats d'un job d'analyse de la qualité des données, utilisez la commande gcloud dataplex datascans jobs describe :

gcloud dataplex datascans jobs describe JOB \ --location=LOCATION \ --datascan=DATASCAN \ --view=FULL

Remplacez les variables suivantes :

JOB: ID du job d'analyse de la qualité des données.LOCATION: région Google Cloud dans laquelle l'analyse de la qualité des données a été créée.DATASCAN: nom de l'analyse de la qualité des données à laquelle appartient le job.--view=FULL: pour afficher le résultat du job d'analyse, spécifiezFULL.

C#

C#

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Go

Go

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Java

Java

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Python

Python

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Ruby

Ruby

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

REST

Pour afficher les résultats d'une analyse de la qualité des données, utilisez la méthode dataScans.get.

Afficher les résultats publiés

Si les résultats de l'analyse de la qualité des données sont publiés en tant que métadonnées Dataplex Universal Catalog, vous pouvez consulter les derniers résultats de l'analyse sur les pages BigQuery et Dataplex Universal Catalog de la consoleGoogle Cloud , dans l'onglet Qualité des données de la table source.

Dans la console Google Cloud , accédez à la page BigQuery.

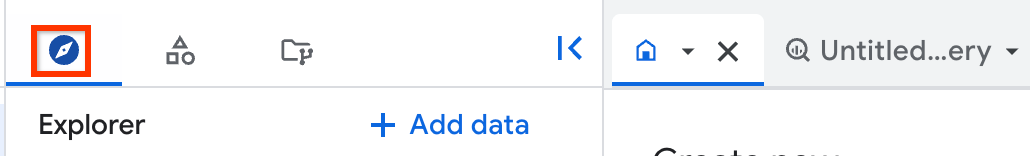

Dans le volet de gauche, cliquez sur Explorateur :

Si le volet de gauche n'apparaît pas, cliquez sur Développer le volet de gauche pour l'ouvrir.

Dans le volet Explorateur, cliquez sur Ensembles de données, puis sur votre ensemble de données.

Cliquez sur Présentation > Tables, puis sélectionnez la table dont vous souhaitez consulter les résultats de l'analyse de la qualité des données.

Cliquez sur l'onglet Qualité des données.

Les derniers résultats publiés s'affichent.

Afficher l'historique des résultats d'analyse

Dataplex Universal Catalog enregistre l'historique des analyses de la qualité des données des 300 derniers jobs ou de l'année écoulée, selon la première échéance.

Console

Dans la console Google Cloud , sur la page Curation des métadonnées de BigQuery, accédez à l'onglet Qualité et profilage des données.

Cliquez sur le nom d'une analyse de la qualité des données.

Cliquez sur l'onglet Historique des jobs.

L'onglet Historique des jobs fournit des informations sur les jobs passés, comme le nombre d'enregistrements analysés dans chaque job, l'état du job, l'heure à laquelle le job a été exécuté, et la réussite ou l'échec de chaque règle.

Pour afficher des informations détaillées sur un job, cliquez sur l'un des jobs de la colonne Job ID.

gcloud

Pour afficher l'historique des jobs d'analyse de qualité des données, utilisez la commande gcloud dataplex datascans jobs list :

gcloud dataplex datascans jobs list \ --location=LOCATION \ --datascan=DATASCAN \

Remplacez les variables suivantes :

LOCATION: région Google Cloud dans laquelle l'analyse de la qualité des données a été créée.DATASCAN: nom de l'analyse de la qualité des données pour laquelle afficher les jobs historiques.

C#

C#

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Go

Go

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Java

Java

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Python

Python

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Ruby

Ruby

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

REST

Pour afficher l'historique des jobs d'analyse de la qualité des données, utilisez la méthode dataScans.jobs.list.

Accorder l'accès aux résultats d'analyse de la qualité des données

Pour permettre aux utilisateurs de votre organisation d'afficher les résultats d'analyse, procédez comme suit :

Dans la console Google Cloud , sur la page Curation des métadonnées de BigQuery, accédez à l'onglet Qualité et profilage des données.

Cliquez sur l'analyse de la qualité des données dont vous souhaitez partager les résultats.

Cliquez sur l'onglet Autorisations.

Procédez comme suit :

- Pour accorder l'accès à un compte principal, cliquez sur Accorder l'accès. Accordez le rôle Lecteur de données Dataplex DataScan au compte principal associé.

- Pour supprimer l'accès d'un compte principal, sélectionnez le compte principal pour lequel vous souhaitez supprimer le rôle Lecteur de données Dataplex DataScan. Cliquez sur > Supprimer l'accès, puis confirmez lorsque vous y êtes invité.

Résoudre un échec de qualité des données

Vous pouvez définir des alertes en cas d'échec de la qualité des données à l'aide des journaux dans Cloud Logging. Pour en savoir plus, y compris sur les exemples de requêtes, consultez Définir des alertes dans Cloud Logging.

Pour chaque job avec des règles au niveau des lignes qui échouent, Dataplex Universal Catalog fournit une requête permettant d'obtenir les enregistrements ayant échoué. Exécutez cette requête pour afficher les enregistrements qui ne correspondaient pas à votre règle.

Console

Dans la console Google Cloud , sur la page Curation des métadonnées de BigQuery, accédez à l'onglet Qualité et profilage des données.

Cliquez sur le nom de l'analyse de la qualité des données dont vous souhaitez résoudre les enregistrements ayant échoué.

Cliquez sur l'onglet Historique des jobs.

Cliquez sur l'ID du job qui a identifié des échecs de qualité des données.

Dans la fenêtre des résultats du job qui s'ouvre, dans la section Règles, recherchez la colonne Requête d'obtention des enregistrements ayant échoué. Cliquez sur Copier la requête dans le presse-papiers pour la règle ayant échoué.

Exécutez la requête dans BigQuery pour afficher les enregistrements qui ont entraîné l'échec du job.

gcloud

Non compatible

REST

Pour obtenir le job qui a identifié les échecs de qualité des données, utilisez la méthode

dataScans.get.Dans l'objet de réponse, le champ

failingRowsQueryaffiche la requête.Exécutez la requête dans BigQuery pour afficher les enregistrements qui ont entraîné l'échec du job.

Dataplex Universal Catalog exécute également la requête de débogage, à condition qu'elle ait été incluse lors de la création de la règle. Les résultats de la requête de débogage sont inclus dans la sortie de chaque règle. Cette fonctionnalité est disponible en version bêta.

Console

Non compatible

gcloud

Non compatible

REST

Pour obtenir le job qui a identifié les échecs de qualité des données, utilisez la méthode dataScans.get.

Dans l'objet de réponse, le champ debugQueriesResultSets affiche les résultats des requêtes de débogage.

Gérer les analyses de qualité des données pour une table spécifique

Les étapes décrites dans ce document expliquent comment gérer les analyses de qualité des données dans votre projet à l'aide de la page Curation des métadonnées > Profilage et qualité des données de BigQuery dans la consoleGoogle Cloud .

Vous pouvez également créer et gérer des analyses de la qualité des données lorsque vous travaillez avec une table spécifique. Dans la console Google Cloud , sur la page BigQuery de la table, utilisez l'onglet Qualité des données. Procédez comme suit :

Dans la console Google Cloud , accédez à la page BigQuery.

Dans le volet Explorateur (à gauche), cliquez sur Ensembles de données, puis sur votre ensemble de données. Cliquez sur Présentation > Tables, puis sélectionnez la table dont vous souhaitez consulter les résultats de l'analyse de la qualité des données.

Cliquez sur l'onglet Qualité des données.

Selon que la table dispose ou non d'une analyse de la qualité des données dont les résultats sont publiés en tant que métadonnées Dataplex Universal Catalog, vous pouvez travailler avec les analyses de la qualité des données de la table de différentes manières :

Les résultats de l'analyse de la qualité des données sont publiés : les derniers résultats de l'analyse s'affichent sur la page.

Pour gérer les analyses de la qualité des données pour cette table, cliquez sur Analyse de la qualité des données, puis sélectionnez l'une des options suivantes :

Créer une analyse : créez une analyse de la qualité des données. Pour en savoir plus, consultez la section Créer une analyse de la qualité des données de ce document. Lorsque vous créez une analyse à partir de la page d'informations d'une table, celle-ci est présélectionnée.

Exécuter : exécutez l'analyse.

Modifier la configuration de l'analyse : modifiez les paramètres, y compris le nom à afficher, les filtres et la planification.

Pour modifier les règles sur la qualité des données, cliquez sur l'onglet Qualité des données, puis sur l'onglet Règles. Cliquez sur Modifier les règles. Modifiez les règles, puis cliquez sur Enregistrer.

Gérer les autorisations d'analyse : contrôlez qui peut accéder aux résultats de l'analyse. Pour en savoir plus, consultez la section Accorder l'accès aux résultats de l'analyse de la qualité des données de ce document.

Afficher l'historique des résultats : affichez des informations détaillées sur les jobs d'analyse de la qualité des données précédents. Pour en savoir plus, consultez les sections Afficher les résultats d'analyse de la qualité des données et Afficher l'historique des résultats d'analyse de ce document.

Afficher toutes les analyses : affichez la liste des analyses de qualité des données qui s'appliquent à cette table.

Les résultats de l'analyse de la qualité des données ne sont pas publiés : sélectionnez l'une des options ci-dessous.

Créer une analyse de la qualité des données : créez une analyse de la qualité des données. Pour en savoir plus, consultez la section Créer une analyse de la qualité des données de ce document. Lorsque vous créez une analyse à partir de la page d'informations d'une table, celle-ci est présélectionnée.

Afficher les analyses existantes : affichez la liste des analyses de qualité des données qui s'appliquent à cette table.

Afficher les analyses de qualité des données pour une table

Pour afficher les analyses de qualité des données qui s'appliquent à une table spécifique, procédez comme suit :

Dans la console Google Cloud , sur la page Curation des métadonnées de BigQuery, accédez à l'onglet Qualité et profilage des données.

Filtrez la liste par nom de table et type d'analyse.

Mettre à jour une analyse de la qualité des données

Vous pouvez modifier différents paramètres d'une analyse de la qualité des données existante, comme le nom à afficher, les filtres, la planification et les règles de qualité des données.

Console

Dans la console Google Cloud , sur la page Curation des métadonnées de BigQuery, accédez à l'onglet Qualité et profilage des données.

Cliquez sur le nom d'une analyse de la qualité des données.

Pour modifier les paramètres, y compris le nom à afficher, les filtres et la planification, cliquez sur Modifier. Modifiez les valeurs, puis cliquez sur Enregistrer.

Pour modifier les règles sur la qualité des données, cliquez sur l'onglet Règles actuelles sur la page des détails de l'analyse. Cliquez sur Modifier les règles. Modifiez les règles, puis cliquez sur Enregistrer.

gcloud

Pour modifier la description d'une analyse de la qualité des données, utilisez la commande gcloud dataplex datascans update data-quality :

gcloud dataplex datascans update data-quality DATASCAN \ --location=LOCATION \ --description=DESCRIPTION

Remplacez les éléments suivants :

DATASCAN: nom de l'analyse de la qualité des données à mettre à jour.LOCATION: région Google Cloud dans laquelle l'analyse de la qualité des données a été créée.DESCRIPTION: nouvelle description de l'analyse de la qualité des données.

C#

C#

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Go

Go

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Java

Java

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Python

Python

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Ruby

Ruby

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

REST

Pour modifier une analyse de la qualité des données, utilisez la méthode dataScans.patch.

Supprimer une analyse de la qualité des données

Console

Console

Dans la console Google Cloud , sur la page Curation des métadonnées de BigQuery, accédez à l'onglet Qualité et profilage des données.

Cliquez sur l'analyse que vous souhaitez supprimer.

Cliquez sur Supprimer, puis confirmez l'opération lorsque vous y êtes invité.

gcloud

gcloud

Pour supprimer une analyse de la qualité des données, utilisez la commande gcloud dataplex datascans delete :

gcloud dataplex datascans delete DATASCAN \ --location=LOCATION \ --async

Remplacez les variables suivantes :

DATASCAN: nom de l'analyse de la qualité des données à supprimer.LOCATION: région Google Cloud dans laquelle l'analyse de la qualité des données a été créée.

C#

C#

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Go

Go

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Java

Java

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Python

Python

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Ruby

Ruby

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

REST

REST

Pour supprimer une analyse de la qualité des données, utilisez la méthode dataScans.delete :

Étapes suivantes

- En savoir plus sur la gouvernance des données dans BigQuery