Analiza los datos para detectar problemas de calidad

En este documento, se explica cómo usar BigQuery y Dataplex Universal Catalog en conjunto para garantizar que los datos cumplan con las expectativas de calidad. La calidad automática de los datos de Dataplex Universal Catalog te permite definir y medir la calidad de los datos en tus tablas de BigQuery. Puedes automatizar el análisis de los datos, validarlos en función de reglas definidas y registrar alertas si tus datos no cumplen con los requisitos de calidad.

Para obtener más información sobre la calidad de los datos automáticos, consulta la descripción general de la calidad de los datos automáticos.

Antes de comenzar

-

Enable the Dataplex API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Opcional: Si quieres que Dataplex Universal Catalog genere recomendaciones para las reglas de calidad de los datos basadas en los resultados de un análisis del perfil de datos, crea y ejecuta el análisis del perfil de datos.

Roles obligatorios

En esta sección, se describen los roles y permisos de IAM necesarios para usar los análisis de calidad de los datos de Dataplex Universal Catalog.

Roles y permisos de los usuarios

Para obtener los permisos que necesitas para ejecutar y administrar análisis de calidad de los datos, pídele a tu administrador que te otorgue los siguientes roles de IAM:

-

Ejecuta un análisis de calidad de los datos en una tabla de BigQuery:

-

Usuario de trabajo de BigQuery (

roles/bigquery.jobUser) en el proyecto para ejecutar trabajos de análisis -

Visualizador de datos de BigQuery (

roles/bigquery.dataViewer) en la tabla de BigQuery que se analizará

-

Usuario de trabajo de BigQuery (

-

Publica los resultados del análisis de calidad de los datos en Dataplex Universal Catalog:

-

Editor de datos de BigQuery (

roles/bigquery.dataEditor) en la tabla analizada -

Editor del catálogo de Dataplex (

roles/dataplex.catalogEditor) en el grupo de entradas@bigqueryen la misma ubicación que la tabla

-

Editor de datos de BigQuery (

-

Realiza tareas específicas en recursos de

DataScan:-

Administrador de DataScan de Dataplex (

roles/dataplex.dataScanAdmin) en el proyecto para obtener acceso completo -

Creador de Dataplex DataScan (

roles/dataplex.dataScanCreator) en el proyecto para crear análisis -

Editor de DataScan de Dataplex (

roles/dataplex.dataScanEditor) en el proyecto para acceso de escritura -

Visualizador de DataScan de Dataplex (

roles/dataplex.dataScanViewer) en el proyecto para leer los metadatos del análisis -

Visualizador de datos de DataScan de Dataplex (

roles/dataplex.dataScanDataViewer) en el proyecto para leer los datos del análisis, incluidas las reglas y los resultados

-

Administrador de DataScan de Dataplex (

Para obtener más información sobre cómo otorgar roles, consulta Administra el acceso a proyectos, carpetas y organizaciones.

Estos roles predefinidos contienen los permisos necesarios para ejecutar y administrar análisis de calidad de los datos. Para ver los permisos exactos que son necesarios, expande la sección Permisos requeridos:

Permisos necesarios

Se requieren los siguientes permisos para ejecutar y administrar análisis de calidad de los datos:

-

Ejecuta un análisis de calidad de los datos en una tabla de BigQuery:

-

bigquery.jobs.createen el proyecto para ejecutar trabajos de análisis -

bigquery.tables.geten la tabla de BigQuery que se analizará -

bigquery.tables.getDataen la tabla de BigQuery que se analizará

-

-

Publica los resultados del análisis de calidad de los datos en Dataplex Universal Catalog:

-

bigquery.tables.updateen la tabla analizada -

dataplex.entryGroups.useDataQualityScorecardAspecten el grupo de entradas@bigqueryen la misma ubicación que la tabla

-

-

Crea un

DataScan:dataplex.datascans.createen el proyecto -

Borra un

DataScan:dataplex.datascans.deleteen el proyecto -

Ver los metadatos de

DataScan:dataplex.datascans.geten el proyecto -

Ver los detalles de

DataScan, incluidas las reglas y los resultados:dataplex.datascans.getDataen el proyecto -

Enumera los

DataScans:dataplex.datascans.listen el proyecto -

Ejecuta un

DataScan:dataplex.datascans.runen el proyecto -

Actualiza un

DataScan:dataplex.datascans.updateen el proyecto -

Obtener o establecer la política de IAM en un

DataScan:dataplex.datascans.getIamPolicyen el proyectodataplex.datascans.setIamPolicyen el proyecto

También puedes obtener estos permisos con roles personalizados o con otros roles predefinidos.

Si necesitas acceder a columnas protegidas por políticas de acceso a nivel de columnas de BigQuery, también necesitas permisos para esas columnas.

Roles y permisos de la cuenta de servicio de Dataplex Universal Catalog

Si no creaste ningún análisis de calidad de los datos o de perfil de datos, o bien si no tienes un lake de Dataplex Universal Catalog en este proyecto, crea un identificador de servicio ejecutando gcloud beta services identity create --service=dataplex.googleapis.com.

Este comando devuelve un identificador de servicio de Dataplex Universal Catalog si existe.

Para garantizar que la cuenta de servicio de Dataplex Universal Catalog del proyecto que contiene el análisis de calidad de los datos tenga los permisos necesarios para leer datos de varias fuentes y exportar resultados, pídele a tu administrador que otorgue los siguientes roles de IAM a la cuenta de servicio de Dataplex Universal Catalog del proyecto que contiene el análisis de calidad de los datos:

-

Leer datos de tablas de BigQuery:

Visualizador de datos de BigQuery (

roles/bigquery.dataViewer) en las tablas de BigQuery que se analizarán y en cualquier otra tabla a la que se haga referencia en las reglas -

Exporta los resultados del análisis a una tabla de BigQuery:

Editor de datos de BigQuery (

roles/bigquery.dataEditor) en el conjunto de datos y la tabla de resultados -

Analiza los datos de BigQuery organizados en un lago de Dataplex Universal Catalog:

-

Lector de metadatos de Dataplex (

roles/dataplex.metadataReader) en recursos de Dataplex -

Visualizador de Dataplex (

roles/dataplex.viewer) en recursos de Dataplex

-

Lector de metadatos de Dataplex (

-

Analiza una tabla externa de BigQuery desde Cloud Storage:

Visualizador de objetos de almacenamiento (

roles/storage.objectViewer) en el bucket de Cloud Storage

Para obtener más información sobre cómo otorgar roles, consulta Administra el acceso a proyectos, carpetas y organizaciones.

Estos roles predefinidos contienen los permisos necesarios para leer datos de diversas fuentes y exportar resultados. Para ver los permisos exactos que son necesarios, expande la sección Permisos requeridos:

Permisos necesarios

Se requieren los siguientes permisos para leer datos de varias fuentes y exportar resultados:

-

Leer datos de la tabla de BigQuery:

-

bigquery.tables.geten tablas de BigQuery -

bigquery.tables.getDataen tablas de BigQuery

-

-

Exporta los resultados del análisis a una tabla de BigQuery:

-

bigquery.datasets.geten el conjunto de datos y la tabla de resultados -

bigquery.tables.createen el conjunto de datos y la tabla de resultados -

bigquery.tables.geten el conjunto de datos y la tabla de resultados -

bigquery.tables.getDataen el conjunto de datos y la tabla de resultados -

bigquery.tables.updateen el conjunto de datos y la tabla de resultados -

bigquery.tables.updateDataen el conjunto de datos y la tabla de resultados

-

-

Analiza los datos de BigQuery organizados en un lago de Dataplex Universal Catalog:

-

dataplex.lakes.listen recursos de Dataplex -

dataplex.lakes.geten recursos de Dataplex -

dataplex.zones.listen recursos de Dataplex -

dataplex.zones.geten recursos de Dataplex -

dataplex.entities.listen recursos de Dataplex -

dataplex.entities.geten recursos de Dataplex -

dataplex.operations.geten recursos de Dataplex

-

-

Analiza una tabla externa de BigQuery desde Cloud Storage:

-

storage.buckets.geten el bucket de Cloud Storage -

storage.objects.geten el bucket de Cloud Storage

-

Es posible que tu administrador también pueda otorgar estos permisos a la cuenta de servicio de Dataplex Universal Catalog del proyecto que contiene el análisis de calidad de los datos con roles personalizados o con otros roles predefinidos.

Si necesitas acceder a columnas protegidas por políticas de acceso a nivel de columna de BigQuery, asigna permisos de la cuenta de servicio de Dataplex Universal Catalog para esas columnas.

Si una tabla tiene habilitadas las políticas de acceso a nivel de la fila de BigQuery, solo puedes analizar las filas visibles para la cuenta de servicio de Dataplex Universal Catalog. Ten en cuenta que los privilegios de acceso del usuario individual no se evalúan para las políticas a nivel de la fila.

Crea un análisis de calidad de los datos

Console

En la consola de Google Cloud , en la página Curación de metadatos de BigQuery, ve a la pestaña Generación de perfiles de datos y calidad.

Haz clic en Crear análisis de calidad de los datos.

En la ventana Define scan, completa los siguientes campos:

Opcional: Ingresa un nombre visible.

Ingresa un ID. Consulta las convenciones de nomenclatura de recursos.

Escribe una descripción (opcional).

En el campo Tabla, haz clic en Explorar. Elige la tabla que deseas analizar y, luego, haz clic en Seleccionar. Solo se admiten las tablas estándar de BigQuery.

En el caso de las tablas en conjuntos de datos multirregionales, elige una región en la que se creará el análisis de datos.

Para explorar las tablas organizadas en los data lakes de Dataplex Universal Catalog, haz clic en Explorar dentro de los data lakes de Dataplex.

En el campo Alcance, elige Incremental o Datos completos.

- Si eliges Incremental, en el campo Columna de marca de tiempo, selecciona una columna de tipo

DATEoTIMESTAMPde tu tabla de BigQuery que aumente a medida que se agreguen registros nuevos y que se pueda usar para identificar registros nuevos. Puede ser una columna que particiona la tabla.

- Si eliges Incremental, en el campo Columna de marca de tiempo, selecciona una columna de tipo

Para filtrar tus datos, selecciona la casilla de verificación Filtrar filas. Proporciona un filtro de filas que consta de una expresión de SQL válida que se puede usar como parte de una cláusula

WHEREen la sintaxis de GoogleSQL. Por ejemplo,col1 >= 0. El filtro puede ser una combinación de varias condiciones de columna. Por ejemplo,col1 >= 0 AND col2 < 10.Para muestrear tus datos, en la lista Tamaño de muestreo, selecciona un porcentaje de muestreo. Elige un valor de porcentaje entre 0.0% y 100.0% con hasta 3 dígitos decimales. Para conjuntos de datos más grandes, elige un porcentaje de muestreo más bajo. Por ejemplo, para una tabla de 1 PB, si ingresas un valor entre el 0.1% y el 1.0%, el análisis de calidad de los datos tomará muestras de entre 1 y 10 TB de datos. En el caso de los análisis de datos incrementales, el análisis de calidad de los datos aplica un muestreo al incremento más reciente.

Para publicar los resultados del análisis de calidad de los datos como metadatos de Dataplex Universal Catalog, selecciona la casilla de verificación Publicar los resultados en Dataplex Catalog.

Puedes ver los resultados del análisis más recientes en la pestaña Calidad de los datos de las páginas de BigQuery y Dataplex Universal Catalog de la tabla de origen. Para permitir que los usuarios accedan a los resultados del análisis publicado, consulta la sección Cómo otorgar acceso a los resultados del análisis de calidad de los datos de este documento.

En la sección Programación, elige una de las siguientes opciones:

Repetir: Ejecuta el análisis de calidad de los datos según un programa: por hora, diario, semanal, mensual o personalizado. Especifica la frecuencia con la que se ejecuta el análisis y a qué hora. Si eliges la opción personalizada, usa el formato cron para especificar el programa.

Según demanda: Ejecuta el análisis de calidad de los datos según demanda.

Ejecución única: Ejecuta el análisis de calidad de los datos una vez ahora y quítalo después del período de vida. Esta función está en vista previa.

Tiempo de actividad: El valor de tiempo de actividad es el período entre el momento en que se ejecuta la exploración y el momento en que se borra. Un análisis de calidad de los datos sin un tiempo de vida especificado se borra automáticamente 24 horas después de su ejecución. El tiempo de actividad puede variar de 0 segundos (eliminación inmediata) a 365 días.

Haz clic en Continuar.

En la ventana Reglas de calidad de los datos, define las reglas que se configurarán para este análisis de calidad de los datos.

Haz clic en Agregar reglas y, luego, elige una de las siguientes opciones.

Recomendaciones basadas en perfiles: Crea reglas a partir de las recomendaciones basadas en un análisis de perfil de datos existente.

Elegir columnas: Selecciona las columnas para las que deseas obtener reglas recomendadas.

Elegir proyecto para analizar: Si el análisis del perfil de datos se encuentra en un proyecto diferente del proyecto en el que estás creando el análisis de calidad de los datos, selecciona el proyecto desde el que se extraerán los análisis del perfil.

Elegir resultados de perfil: Selecciona uno o más resultados de perfil y, luego, haz clic en Aceptar. Se completará una lista de reglas sugeridas que puedes usar como punto de partida.

Selecciona la casilla de verificación de las reglas que deseas agregar y, luego, haz clic en Seleccionar. Una vez que las selecciones, las reglas se agregarán a tu lista de reglas actual. Luego, puedes editar las reglas.

Tipos de reglas integradas: Crea reglas a partir de reglas predefinidas. Consulta la lista de reglas predefinidas.

Elegir columnas: Selecciona las columnas para las que deseas seleccionar reglas.

Elige tipos de reglas: Selecciona los tipos de reglas que quieras elegir y, luego, haz clic en Aceptar. Los tipos de reglas que aparecen dependen de las columnas que seleccionaste.

Selecciona la casilla de verificación de las reglas que deseas agregar y, luego, haz clic en Seleccionar. Una vez que las selecciones, las reglas se agregarán a tu lista de reglas actual. Luego, puedes editar las reglas.

Regla de verificación de fila de SQL: Crea una regla de SQL personalizada para aplicar a cada fila.

En Dimensión, elige una dimensión.

En Umbral de aprobación, elige un porcentaje de registros que deben aprobar la verificación.

En Nombre de la columna, elige una columna.

En el campo Proporciona una expresión en SQL, ingresa una expresión en SQL que se evalúe como un valor booleano

true(aprobado) ofalse(reprobado). Para obtener más información, consulta Tipos de reglas de SQL personalizadas compatibles y los ejemplos en Cómo definir reglas de calidad de los datos.Haz clic en Agregar.

Regla de verificación de agregación de SQL: Crea una regla de condición de tabla de SQL personalizada.

En Dimensión, elige una dimensión.

En Nombre de la columna, elige una columna.

En el campo Proporciona una expresión en SQL, ingresa una expresión en SQL que se evalúe como un valor booleano

true(aprobado) ofalse(reprobado). Para obtener más información, consulta Tipos de reglas de SQL personalizadas compatibles y los ejemplos en Cómo definir reglas de calidad de los datos.Haz clic en Agregar.

Regla de aserción de SQL: Crea una regla de aserción de SQL personalizada para verificar si los datos tienen un estado no válido.

En Dimensión, elige una dimensión.

Opcional: En Nombre de la columna, elige una columna.

En el campo Proporciona una instrucción de SQL, ingresa una instrucción de SQL que devuelva las filas que coincidan con el estado no válido. Si se devuelven filas, esta regla falla. Omite el punto y coma final de la instrucción SQL. Para obtener más información, consulta Tipos de reglas de SQL personalizadas compatibles y los ejemplos en Cómo definir reglas de calidad de los datos.

Haz clic en Agregar.

Opcional: Para cualquier regla de calidad de los datos, puedes asignar un nombre de regla personalizado para usarlo en la supervisión y las alertas, y una descripción. Para ello, edita una regla y especifica los siguientes detalles:

- Nombre de la regla: Ingresa un nombre de regla personalizado de hasta 63 caracteres. El nombre de la regla puede incluir letras (a-z, A-Z), dígitos (0-9) y guiones (-), y debe comenzar con una letra y terminar con un número o una letra.

- Descripción: Ingresa una descripción de la regla con una longitud máxima de 1,024 caracteres.

Repite los pasos anteriores para agregar reglas adicionales al análisis de calidad de los datos. Cuando termines, haz clic en Continuar.

Opcional: Exporta los resultados del análisis a una tabla estándar de BigQuery. En la sección Export scan results to BigQuery table, haz lo siguiente:

En el campo Selecciona un conjunto de datos de BigQuery, haz clic en Explorar. Selecciona un conjunto de datos de BigQuery para almacenar los resultados del análisis de calidad de los datos.

En el campo Tabla de BigQuery, especifica la tabla en la que se almacenarán los resultados del análisis de calidad de los datos. Si usas una tabla existente, asegúrate de que sea compatible con el esquema de la tabla de exportación. Si la tabla especificada no existe, Dataplex Universal Catalog la crea por ti.

Opcional: Agrega etiquetas. Las etiquetas son pares clave-valor que te permiten agrupar objetos relacionados entre sí o con otros recursos de Google Cloud .

Opcional: Configura informes de notificaciones por correo electrónico para alertar a las personas sobre el estado y los resultados de un trabajo de análisis de calidad de los datos. En la sección Informe de notificaciones, haz clic en Agregar ID de correo electrónico y, luego, ingresa hasta cinco direcciones de correo electrónico. Luego, selecciona los casos para los que deseas enviar informes:

- Nivel de calidad (<=): Envía un informe cuando un trabajo se completa correctamente con un nivel de calidad de los datos inferior al objetivo especificado. Ingresa una puntuación de calidad objetivo entre 0 y 100.

- Fallas en el trabajo: Envía un informe cuando falla el trabajo en sí, independientemente de los resultados de calidad de los datos.

- Finalización del trabajo (correcto o incorrecto): Envía un informe cuando finaliza el trabajo, independientemente de los resultados de la calidad de los datos.

Haz clic en Crear.

Después de crear el análisis, puedes ejecutarlo en cualquier momento haciendo clic en Ejecutar ahora.

gcloud

Para crear un análisis de calidad de los datos, usa el comando gcloud dataplex datascans create data-quality.

Si los datos de origen están organizados en un lake de Dataplex Universal Catalog, incluye la marca --data-source-entity:

gcloud dataplex datascans create data-quality DATASCAN \

--location=LOCATION \

--data-quality-spec-file=DATA_QUALITY_SPEC_FILE \

--data-source-entity=DATA_SOURCE_ENTITY

Si los datos de origen no están organizados en un lake de Dataplex Universal Catalog, incluye la marca --data-source-resource:

gcloud dataplex datascans create data-quality DATASCAN \

--location=LOCATION \

--data-quality-spec-file=DATA_QUALITY_SPEC_FILE \

--data-source-resource=DATA_SOURCE_RESOURCE

Reemplaza las siguientes variables:

DATASCAN: Es el nombre del análisis de calidad de los datos.LOCATION: Es la región Google Cloud en la que se creará el análisis de la calidad de los datos.DATA_QUALITY_SPEC_FILE: Es la ruta de acceso al archivo JSON o YAML que contiene las especificaciones del análisis de calidad de los datos. El archivo puede ser un archivo local o una ruta de acceso de Cloud Storage con el prefijogs://. Usa este archivo para especificar las reglas de calidad de los datos del análisis. También puedes especificar detalles adicionales en este archivo, como filtros, porcentaje de muestreo y acciones posteriores al análisis, como la exportación a BigQuery o el envío de informes de notificación por correo electrónico. Consulta la documentación sobre la representación en JSON y el ejemplo de representación en YAML.DATA_SOURCE_ENTITY: Es la entidad de Dataplex Universal Catalog que contiene los datos para el análisis de calidad de los datos. Por ejemplo,projects/test-project/locations/test-location/lakes/test-lake/zones/test-zone/entities/test-entity.DATA_SOURCE_RESOURCE: Es el nombre del recurso que contiene los datos para el análisis de calidad de los datos. Por ejemplo,//bigquery.googleapis.com/projects/test-project/datasets/test-dataset/tables/test-table.

C#

C#

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Go

Go

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Java

Java

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Node.js

Node.js

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Python

Python

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Ruby

Ruby

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

REST

Para crear un análisis de calidad de los datos, usa el método dataScans.create.

La siguiente solicitud crea un análisis de calidad de los datos único:

POST https://dataplex.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/dataScans?data_scan_id=DATASCAN_ID { "data": { "resource": "//bigquery.googleapis.com/projects/PROJECT_ID/datasets/DATASET_ID/tables/TABLE_ID" }, "type": "DATA_QUALITY", "executionSpec": { "trigger": { "oneTime": { "ttl_after_scan_completion": "120s" } } }, "dataQualitySpec": { "rules": [ { "nonNullExpectation": {}, "column": "COLUMN_NAME", "dimension": "DIMENSION", "threshold": 1 } ] } }

Reemplaza lo siguiente:

PROJECT_ID: ID del proyectoLOCATION: Es la región en la que se creará el análisis de calidad de los datos.DATASCAN_ID: Es el ID de la exploración de calidad de los datos.DATASET_ID: Es el ID del conjunto de datos de BigQuery.TABLE_ID: Es el ID de la tabla de BigQuery.COLUMN_NAME: Es el nombre de la columna de la regla.DIMENSION: Es la dimensión de la regla, por ejemplo,VALIDITY.

Si deseas crear reglas para el análisis de calidad de los datos con recomendaciones de reglas basadas en los resultados de un análisis del perfil de datos, llama al método dataScans.jobs.generateDataQualityRules en el análisis del perfil de datos para obtener las recomendaciones.

Ejecuta un análisis de calidad de los datos

Console

En la consola de Google Cloud , en la página Curación de metadatos de BigQuery, ve a la pestaña Generación de perfiles de datos y calidad.

Haz clic en el análisis de calidad de los datos que deseas ejecutar.

Haz clic en Ejecutar ahora.

gcloud

Para ejecutar un análisis de calidad de los datos, usa el comando gcloud dataplex datascans run:

gcloud dataplex datascans run DATASCAN \ --location=LOCATION \

Reemplaza las siguientes variables:

LOCATION: Es la región Google Cloud en la que se creó el análisis de calidad de los datos.DATASCAN: Es el nombre del análisis de calidad de los datos.

C#

C#

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Go

Go

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Java

Java

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Python

Python

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Ruby

Ruby

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

REST

Para ejecutar un análisis de calidad de los datos, usa el método dataScans.run.

Visualiza los resultados del análisis de calidad de los datos

Console

En la consola de Google Cloud , en la página Curación de metadatos de BigQuery, ve a la pestaña Generación de perfiles de datos y calidad.

Haz clic en el nombre de un análisis de calidad de los datos.

En la sección Overview, se muestra información sobre los trabajos más recientes, como cuándo se ejecutó el análisis, la cantidad de registros analizados en cada trabajo, si se aprobaron todas las verificaciones de calidad de los datos y, si hubo errores, la cantidad de verificaciones de calidad de los datos que fallaron.

En la sección Configuración del análisis de calidad de los datos, se muestran detalles sobre el análisis.

Para ver información detallada sobre un trabajo, como las puntuaciones de calidad de los datos que indican el porcentaje de reglas que se aprobaron, las reglas que fallaron y los registros del trabajo, haz clic en la pestaña Historial de trabajos. Luego, haz clic en un ID de trabajo.

gcloud

Para ver los resultados de un trabajo de análisis de calidad de los datos, usa el comando gcloud dataplex datascans jobs describe:

gcloud dataplex datascans jobs describe JOB \ --location=LOCATION \ --datascan=DATASCAN \ --view=FULL

Reemplaza las siguientes variables:

JOB: Es el ID del trabajo de análisis de calidad de los datos.LOCATION: Es la Google Cloud región en la que se creó el análisis de calidad de los datos.DATASCAN: Es el nombre de la exploración de calidad de los datos a la que pertenece el trabajo.--view=FULL: Para ver el resultado del trabajo de análisis, especificaFULL.

C#

C#

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Go

Go

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Java

Java

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Python

Python

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Ruby

Ruby

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

REST

Para ver los resultados de un análisis de calidad de los datos, usa el método dataScans.get.

Visualiza los resultados publicados

Si los resultados del análisis de calidad de los datos se publican como metadatos de Dataplex Universal Catalog, puedes ver los resultados del análisis más recientes en las páginas de BigQuery y Dataplex Universal Catalog de laGoogle Cloud consola, en la pestaña Calidad de los datos de la tabla de origen.

En la consola de Google Cloud , ve a la página BigQuery.

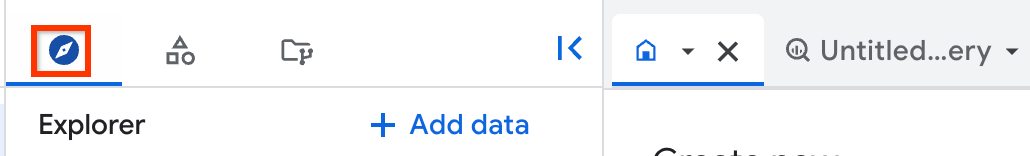

En el panel de la izquierda, haz clic en Explorar.

Si no ves el panel izquierdo, haz clic en Expandir panel izquierdo para abrirlo.

En el panel Explorador, haz clic en Conjuntos de datos y, luego, en tu conjunto de datos.

Haz clic en Resumen > Tablas y, luego, selecciona la tabla cuyos resultados del análisis de calidad de los datos deseas ver.

Haz clic en la pestaña Calidad de los datos.

Se muestran los resultados publicados más recientes.

Visualiza los resultados del análisis histórico

Dataplex Universal Catalog guarda el historial de análisis de calidad de los datos de los últimos 300 trabajos o del último año, lo que ocurra primero.

Console

En la consola de Google Cloud , en la página Curación de metadatos de BigQuery, ve a la pestaña Generación de perfiles de datos y calidad.

Haz clic en el nombre de un análisis de calidad de los datos.

Haz clic en la pestaña Historial de trabajos.

La pestaña Historial de trabajos proporciona información sobre los trabajos anteriores, como la cantidad de registros analizados en cada trabajo, el estado del trabajo, la hora en que se ejecutó el trabajo y si cada regla se aprobó o falló.

Para ver información detallada sobre un trabajo, haz clic en cualquiera de los trabajos de la columna ID del trabajo.

gcloud

Para ver los trabajos históricos de análisis de calidad de los datos, usa el comando gcloud dataplex datascans jobs list:

gcloud dataplex datascans jobs list \ --location=LOCATION \ --datascan=DATASCAN \

Reemplaza las siguientes variables:

LOCATION: Es la Google Cloud región en la que se creó el análisis de calidad de los datos.DATASCAN: Es el nombre del análisis de calidad de los datos para el que se visualizarán los trabajos históricos.

C#

C#

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Go

Go

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Java

Java

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Python

Python

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Ruby

Ruby

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

REST

Para ver los trabajos históricos de análisis de calidad de los datos, usa el método dataScans.jobs.list.

Otorga acceso a los resultados del análisis de calidad de los datos

Para permitir que los usuarios de tu organización vean los resultados del análisis, haz lo siguiente:

En la consola de Google Cloud , en la página Curación de metadatos de BigQuery, ve a la pestaña Generación de perfiles de datos y calidad.

Haz clic en el análisis de calidad de los datos cuyos resultados quieras compartir.

Haz clic en la pestaña Permisos.

Haz lo siguiente:

- Para otorgar acceso a una principal, haz clic en Otorgar acceso. Otorga el rol Visualizador de datos de DataScan de Dataplex al principal asociado.

- Para quitar el acceso de una principal, selecciona la principal de la que deseas quitar el rol Visualizador de datos de DataScan de Dataplex. Haz clic en Quitar acceso y, luego, confirma la acción cuando se te solicite.

Soluciona problemas relacionados con errores en la calidad de los datos

Puedes configurar alertas para las fallas en la calidad de los datos con los registros de Cloud Logging. Para obtener más información, incluidas consultas de muestra, consulta Cómo configurar alertas en Cloud Logging.

Para cada trabajo con reglas a nivel de la fila que fallan, Dataplex Universal Catalog proporciona una consulta para obtener los registros con errores. Ejecuta esta consulta para ver los registros que no coincidieron con tu regla.

Console

En la consola de Google Cloud , en la página Curación de metadatos de BigQuery, ve a la pestaña Generación de perfiles de datos y calidad.

Haz clic en el nombre del análisis de calidad de los datos cuyos registros deseas solucionar.

Haz clic en la pestaña Historial de trabajos.

Haz clic en el ID del trabajo que identificó errores de calidad de los datos.

En la ventana de resultados del trabajo que se abre, en la sección Reglas, busca la columna Consulta para obtener registros con errores. Haz clic en Copiar consulta al portapapeles para la regla que falló.

Ejecuta la consulta en BigQuery para ver los registros que provocaron la falla del trabajo.

gcloud

No compatible.

REST

Para obtener el trabajo que identificó las fallas de calidad de los datos, usa el método

dataScans.get.En el objeto de respuesta, el campo

failingRowsQuerymuestra la búsqueda.Ejecuta la consulta en BigQuery para ver los registros que provocaron la falla del trabajo.

Dataplex Universal Catalog también ejecuta la consulta de depuración, siempre que se haya incluido durante la creación de la regla. Los resultados de la consulta de depuración se incluyen en el resultado de cada regla. Esta función está en vista previa.

Console

No compatible.

gcloud

No compatible.

REST

Para obtener el trabajo que identificó las fallas de calidad de los datos, usa el método dataScans.get.

En el objeto de respuesta, el campo debugQueriesResultSets muestra los resultados de las consultas de depuración.

Administra los análisis de calidad de los datos de una tabla específica

En los pasos de este documento, se muestra cómo administrar los análisis de calidad de los datos en tu proyecto con la página Curación de metadatos > Generación de perfiles de datos y calidad de BigQuery en la consola deGoogle Cloud .

También puedes crear y administrar análisis de calidad de los datos cuando trabajas con una tabla específica. En la consola de Google Cloud , en la página de BigQuery para la tabla, usa la pestaña Calidad de los datos. Haz lo siguiente:

En la consola de Google Cloud , ve a la página BigQuery.

En el panel Explorador (en el panel izquierdo), haz clic en Conjuntos de datos y, luego, en tu conjunto de datos. Haz clic en Resumen > Tablas y, luego, selecciona la tabla cuyos resultados del análisis de calidad de los datos deseas ver.

Haz clic en la pestaña Calidad de los datos.

Según si la tabla tiene un análisis de calidad de los datos cuyos resultados se publican como metadatos de Dataplex Universal Catalog, puedes trabajar con los análisis de calidad de los datos de la tabla de las siguientes maneras:

Se publican los resultados del análisis de calidad de los datos: Los resultados del análisis más recientes se muestran en la página.

Para administrar los análisis de calidad de los datos de esta tabla, haz clic en Análisis de calidad de los datos y, luego, selecciona una de las siguientes opciones:

Crear análisis nuevo: Crea un nuevo análisis de calidad de los datos. Para obtener más información, consulta la sección Crea un análisis de calidad de los datos de este documento. Cuando creas un análisis desde la página de detalles de una tabla, esta se preselecciona.

Ejecutar ahora: Ejecuta el análisis.

Editar configuración de análisis: Edita la configuración, incluidos el nombre visible, los filtros y la programación.

Para editar las reglas de calidad de los datos, en la pestaña Calidad de los datos, haz clic en la pestaña Reglas. Haz clic en Modificar reglas. Actualiza las reglas y, luego, haz clic en Guardar.

Administrar permisos del análisis: Controla quién puede acceder a los resultados del análisis. Para obtener más información, consulta la sección Otorga acceso a los resultados del análisis de calidad de los datos de este documento.

Ver resultados históricos: Consulta información detallada sobre los trabajos de análisis de calidad de los datos anteriores. Para obtener más información, consulta las secciones Visualiza los resultados del análisis de calidad de los datos y Visualiza los resultados históricos del análisis de este documento.

Ver todos los análisis: Consulta una lista de los análisis de calidad de los datos que se aplican a esta tabla.

No se publican los resultados del análisis de calidad de los datos: Selecciona una de las siguientes opciones:

Crear análisis de calidad de los datos: Crea un análisis de calidad de los datos nuevo. Para obtener más información, consulta la sección Crea un análisis de calidad de los datos de este documento. Cuando creas un análisis desde la página de detalles de una tabla, esta se preselecciona.

Ver análisis existentes: Consulta una lista de los análisis de calidad de los datos que se aplican a esta tabla.

Visualiza los análisis de calidad de los datos de una tabla

Para ver los análisis de calidad de los datos que se aplican a una tabla específica, haz lo siguiente:

En la consola de Google Cloud , en la página Curación de metadatos de BigQuery, ve a la pestaña Generación de perfiles de datos y calidad.

Filtra la lista por nombre de tabla y tipo de análisis.

Actualiza un análisis de calidad de los datos

Puedes editar varios parámetros de configuración de un análisis de calidad de los datos existente, como el nombre visible, los filtros, la programación y las reglas de calidad de los datos.

Console

En la consola de Google Cloud , en la página Curación de metadatos de BigQuery, ve a la pestaña Generación de perfiles de datos y calidad.

Haz clic en el nombre de un análisis de calidad de los datos.

Para editar la configuración, incluidos el nombre visible, los filtros y la programación, haz clic en Editar. Edita los valores y haz clic en Guardar.

Para editar las reglas de calidad de los datos, en la página de detalles del análisis, haz clic en la pestaña Reglas actuales. Haz clic en Modificar reglas. Actualiza las reglas y, luego, haz clic en Guardar.

gcloud

Para actualizar la descripción de un análisis de calidad de los datos, usa el comando gcloud dataplex datascans update data-quality:

gcloud dataplex datascans update data-quality DATASCAN \ --location=LOCATION \ --description=DESCRIPTION

Reemplaza lo siguiente:

DATASCAN: Es el nombre de la exploración de calidad de los datos que se actualizará.LOCATION: Es la Google Cloud región en la que se creó el análisis de calidad de los datos.DESCRIPTION: Es la nueva descripción del análisis de calidad de los datos.

C#

C#

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Go

Go

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Java

Java

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Python

Python

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Ruby

Ruby

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

REST

Para editar un análisis de calidad de los datos, usa el método dataScans.patch.

Borra un análisis de calidad de los datos

Console

Console

En la consola de Google Cloud , en la página Curación de metadatos de BigQuery, ve a la pestaña Generación de perfiles de datos y calidad.

Haz clic en el análisis que quieras borrar.

Haz clic en Borrar y, luego, confirma cuando se te solicite.

gcloud

gcloud

Para borrar un análisis de calidad de los datos, usa el comando gcloud dataplex datascans delete:

gcloud dataplex datascans delete DATASCAN \ --location=LOCATION \ --async

Reemplaza las siguientes variables:

DATASCAN: Es el nombre del análisis de calidad de los datos que se borrará.LOCATION: Es la Google Cloud región en la que se creó el análisis de calidad de los datos.

C#

C#

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Go

Go

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Java

Java

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Python

Python

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Ruby

Ruby

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

REST

REST

Para borrar un análisis de calidad de los datos, usa el método dataScans.delete.

¿Qué sigue?

- Obtén más información sobre la administración de datos en BigQuery.