Data-Engineering-Agenten zum Erstellen und Ändern von Datenpipelines verwenden

Mit dem Data Engineering Agent können Sie Gemini in BigQuery verwenden, um Datenpipelines zum Laden und Verarbeiten von Daten in BigQuery zu erstellen, zu ändern und zu verwalten. Mit dem Data-Engineering-Agenten können Sie Datenpipelines aus verschiedenen Datenquellen mithilfe von Prompts in natürlicher Sprache generieren oder vorhandene Datenpipelines an Ihre Data-Engineering-Anforderungen anpassen. Der Data Engineering-Agent hat die folgenden Funktionen:

Natürliche Sprache für die Pipeline-Erstellung: Der Agent verwendet Gemini, um Ihre Daten zu verstehen und Ihre Anweisungen in einfacher Sprache zu interpretieren. Sie können den Data-Engineering-Agenten mit Anweisungen in natürlicher Sprache Datenpipelines erstellen oder bearbeiten lassen.

Dataform-Integration: Der Agent generiert und organisiert den erforderlichen Pipelinecode in SQLX-Dateien in einem Dataform-Repository. Der Agent ist im Dataform-Arbeitsbereich aktiv, sodass Dataform-Pipelines automatisch für den Agenten verfügbar sind.

Benutzerdefinierte Agent-Anweisungen: Sie können Agent-Anweisungen in natürlicher Sprache erstellen, um benutzerdefinierte Regeln für den Data Engineering Agent zu definieren. Agent-Anweisungen sind in Ihrer gesamten Organisation persistent und können nützlich sein, um organisationsweite Regeln wie Namenskonventionen oder Styleguides durchzusetzen.

Pipeline-Validierung: Der Agent validiert jeden generierten Code, um sicherzustellen, dass die Datenpipelines funktionieren.

Sie können Prompts in natürlicher Sprache mit dem Data-Engineering-Agenten verwenden, um SQLX-Dateien für Tabellen, Ansichten, Zusicherungen, Deklarationen und Vorgänge zu erstellen. Sie können den Data Engineering Agent beispielsweise für Folgendes verwenden:

- Daten aus externen Datenquellen wie Cloud Storage in verschiedenen Formaten wie CSV, AVRO oder PARQUET laden.

- Erstellen Sie BigQuery-Routinen (UDFs) oder verwenden Sie vorhandene, um benutzerdefinierte Analysen und Transformationen für Ihre Daten durchzuführen.

- Definieren Sie wiederverwendbare Richtlinien für den Agenten in natürlicher Sprache.

Weitere Beispiele für Prompts, die Sie mit dem Data-Engineering-Agenten verwenden können, finden Sie unter Beispiel-Prompts.

Beschränkungen

Für den Data Engineering Agent gelten die folgenden Einschränkungen:

- Der Data Engineering-Agent ist ein Pre-GA-Angebot und nicht für die Produktion vorgesehen.

- Der Data Engineering Agent unterstützt keine Befehle in natürlicher Sprache für die folgenden Dateitypen:

- Notebooks

- Datenvorbereitung

- JavaScript in SQLX

- Der Data Engineering-Agent kann keine Pipelines ausführen. Nutzer müssen Pipelines überprüfen und ausführen oder planen.

- Der Data Engineering-Agent kann SQL-Code, der von nicht vorhandenen Zwischenressourcen abhängt, nicht ohne vollständigen Pipelineaufruf (nutzergesteuert) validieren.

- Der Data Engineering Agent kann keine Weblinks oder URLs durchsuchen, die über Anweisungen oder direkte Prompts bereitgestellt werden.

- Beim Importieren von Dateien in eine Datei mit Agent-Anweisungen werden mit der Importsyntax

@nur Pfade unterstützt, die mit./,/oder einem Buchstaben beginnen. - Die Datenvorschau wird nur für Tabellen, Deklarationen oder Abfragen unterstützt, bei denen das Flag

hasOutputauftruegesetzt ist.

Unterstützte Regionen

Gemini in BigQuery wird über die folgenden Regionen bereitgestellt:

Nord- und Südamerika

- Iowa (

us-central1)

Europa

- Finnland (

europe-north1) - Frankfurt (

europe-west3)

Verarbeitungsregion ändern

Sie haben folgende Möglichkeiten, die Verarbeitungsregion für den Data-Engineering-Agenten zu ändern:

BigQuery-Pipelines

Wenn Sie BigQuery-Pipelines verwenden, können Sie die Verarbeitungsregion aktualisieren, indem Sie die Standardregion für Ihre Code-Assets festlegen. Weitere Informationen finden Sie unter Standardregion für Code-Assets festlegen.

Wenn die Standardregion nicht festgelegt ist, verarbeitet der Data Engineering Agent Ihre Daten global.

Dataform

Wenn Sie Dataform verwenden, können Sie die Verarbeitungsregion aktualisieren, indem Sie den Wert defaultLocation in der Datei mit den Dataform-Workflow-Einstellungen oder workflow_settings.yaml ändern. Weitere Informationen finden Sie unter Dataform-Workflow-Einstellungen konfigurieren.

Wenn der Wert defaultLocation nicht festgelegt ist, verarbeitet der Data Engineering Agent Ihre Daten global.

So verwendet der Data Engineering Agent Ihre Daten

Um Agent-Antworten von höherer Qualität zu generieren, kann der Data Engineering Agent zusätzliche Daten und Metadaten aus BigQuery und Dataplex Universal Catalog abrufen, einschließlich Beispielzeilen aus BigQuery-Tabellen und Datenprofilen, die in Dataplex Universal Catalog generiert wurden. Diese Daten werden nicht zum Trainieren des Data Engineering-Agents verwendet, sondern nur während der Agent-Unterhaltungen als zusätzlicher Kontext, um die Antworten des Agents zu optimieren.

Hinweise

Achten Sie darauf, dass Gemini in BigQuery für Ihr Google Cloud -Projekt aktiviert ist. Weitere Informationen finden Sie unter Gemini in BigQuery einrichten.

Sie müssen auch die Gemini Data Analytics API aktivieren.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM

role (roles/serviceusage.serviceUsageAdmin), which

contains the serviceusage.services.enable permission. Learn how to grant

roles.

Erforderliche Rollen

Bitten Sie Ihren Administrator, Ihnen die folgenden IAM-Rollen für das Projekt zuzuweisen, um die Berechtigungen zu erhalten, die Sie zur Verwendung des Data Engineering Agent benötigen:

-

Dataform-Code-Editor (

roles/dataform.codeEditor) -

BigQuery Job User (

roles/bigquery.jobuser)

Weitere Informationen zum Zuweisen von Rollen finden Sie unter Zugriff auf Projekte, Ordner und Organisationen verwalten.

Sie können die erforderlichen Berechtigungen auch über benutzerdefinierte Rollen oder andere vordefinierte Rollen erhalten.

Datenpipeline mit dem Data-Engineering-Agenten generieren

Wenn Sie den Data Engineering Agent in BigQuery verwenden möchten, wählen Sie eine der folgenden Optionen aus:

BigQuery-Pipelines

So verwenden Sie den Data Engineering Agent in der BigQuery-Pipelines-Benutzeroberfläche:

Rufen Sie die Seite BigQuery auf.

Klicken Sie im Abfrageeditor auf arrow_drop_down Neu erstellen > Pipeline.

Wählen Sie eine Option für die Anmeldedaten für die Ausführung aus und klicken Sie auf Jetzt loslegen. Diese Anmeldedaten werden nicht vom Agent verwendet, sind aber erforderlich, damit Sie die generierte Datenpipeline ausführen können.

Klicken Sie auf Agent-Funktionen für Datenpipeline ausprobieren.

Geben Sie im Feld Agent fragen einen Prompt in natürlicher Sprache ein, um eine Datenpipeline zu generieren. Beispiel:

Create dimension tables for a taxi trips star schema from new_york_taxi_trips.tlc_green_trips_2022. Generate surrogate keys and all the descriptive attributes.Nachdem Sie einen Prompt eingegeben haben, klicken Sie auf Senden.

Der Data Engineering Agent generiert eine Datenpipeline basierend auf Ihrem Prompt.

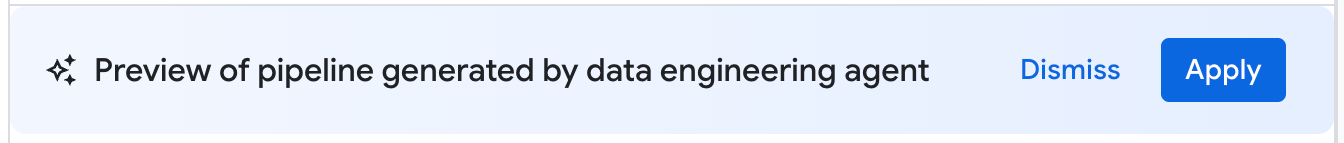

Die vom Data-Engineering-Agenten generierte Datenpipeline ist ein Vorschlag für eine Datenpipeline. Sie können auf einen Pipelineknoten klicken, um die generierte SQLX-Abfrage zu prüfen. Wenn Sie die vom Agent vorgeschlagene Datenpipeline anwenden möchten, klicken Sie auf Anwenden.

Dataform

Sie können den Data Engineering Agent in Dataform so verwenden:

Rufen Sie die Seite Dataform auf.

Wählen Sie ein Repository aus.

Wählen Sie einen Entwicklungsarbeitsbereich aus oder erstellen Sie einen.

Klicken Sie im Arbeitsbereich auf Agent fragen.

Geben Sie im angezeigten Prompt Agent fragen einen Prompt in natürlicher Sprache ein, um eine Datenpipeline zu erstellen. Beispiel:

Create dimension tables for a taxi trips star schema from new_york_taxi_trips.tlc_green_trips_2022. Generate surrogate keys and all the descriptive attributes.Nachdem Sie einen Prompt eingegeben haben, klicken Sie auf Senden.

Nachdem Sie den Prompt gesendet haben, generiert der Data Engineering-Agent eine Datenpipeline und ändert Dataform SQLX-Dateien basierend auf Ihrem Prompt. Der Agent wendet diese Änderungen direkt auf Ihre Arbeitsbereichdateien an.

Datenpipeline prüfen

In einer vom Data-Engineering-Agenten generierten Datenpipeline können Sie auf einen Pipelineknoten klicken, um ihn zu prüfen.

- Auf dem Tab Konfiguration wird die generierte SQLX-Abfrage angezeigt, die dem Knoten zugeordnet ist.

- Auf dem Tab Datenvorschau sehen Sie die Eingabe- und Ausgabetabelle der Datei. Sie können sich eine Vorschau Ihrer Datentransformation über diesen Knoten ansehen, indem Sie auf Aufgabe ausführen klicken, um die Aufgabe mit oder ohne Abhängigkeiten auszuführen.

Datenpipeline bearbeiten

Sie können Ihre Datenpipeline mit dem Data-Engineering-Agenten bearbeiten, indem Sie auf Agent fragen klicken und einen Prompt eingeben, in dem Sie eine Änderung an der Datenpipeline vorschlagen.

Prüfen Sie die vom Data-Engineering-Agenten vorgeschlagenen Änderungen und klicken Sie dann auf Übernehmen, um die Änderungen zu übernehmen.

Sie können eine SQLX-Abfrage auch manuell bearbeiten. Wählen Sie dazu einen Pipelineknoten aus und klicken Sie auf Öffnen.

Agent-Anweisungen für den Data Engineering Agent erstellen

Agent-Anweisungen sind Anweisungen in natürlicher Sprache für den Data Engineering-Agent, mit denen Sie persistente Anweisungen speichern können, damit der Agent eine Reihe benutzerdefinierter, vordefinierter Regeln befolgt. Verwenden Sie Agent-Anweisungen, wenn die Ergebnisse Ihres Agents in Ihrer gesamten Organisation einheitlich sein sollen, z. B. bei Namenskonventionen oder um einen Styleguide durchzusetzen.

Sie können eine GEMINI.MD-Kontextdatei als Agent-Anweisungsdatei für den Data Engineering Agent erstellen. Sie können Agent-Anweisungsdateien für die Verwendung in Ihrem lokalen Arbeitsbereich erstellen oder dieselben Anweisungsdateien in mehreren Datenpipelines über ein externes Repository verwenden.

So erstellen Sie Agent-Anweisungen:

- Klicken Sie unter Agent fragen auf Pipeline-Anweisungen.

- Klicken Sie im Bereich Anleitung für Pipeline auf Anleitungsdatei erstellen.

Geben Sie in der angezeigten Datei

GEMINI.MDIhre Anweisungen in natürlicher Sprache ein.Das folgende Beispiel zeigt eine Datei mit Agent-Anweisungen mit mehreren Regeln:

1. All event-specific tables MUST be prefixed with `cs_event_`. 2. The primary key for any player activity table is a composite key of `player_id` and `event_timestamp_micros`. 3. Filter out any player actions where `mana_spent` is greater than `max_mana_pool`. This is considered a data anomaly.Klicken Sie auf Speichern.

Informationen zur optimalen Strukturierung Ihrer Agent-Anweisungsdateien finden Sie unter Best Practices für Agent-Anweisungsdateien.

Agent-Anweisungen aus einem externen Repository laden

Sie können einen Satz von Agent-Anweisungen angeben, die in mehreren Datenpipelines wiederverwendet werden sollen, indem Sie ein externes Repository verknüpfen:

- Klicken Sie unter Agent fragen auf Pipeline-Anweisungen.

- Wählen Sie unter Externes Repository die Option Anleitungen aus externem Repository verwenden aus.

- Geben Sie in den dafür vorgesehenen Feldern ein Repository an, das Agent-Anweisungen enthält, die Sie mit Ihrer Datenpipeline verwenden möchten.

- Klicken Sie auf Speichern.

Zusätzliche lokale Dateien als Agent-Anweisungen importieren

Sie können auch andere Anweisungsdateien für den Data Engineering Agent mithilfe der @file.md-Syntax in die Datei GEMINI.md importieren. Weitere Informationen finden Sie unter Memory Import Processor.

Fehler bei Datenpipelines beheben

Wenn bei der Generierung der Datenpipeline Fehler auftreten, prüfen Sie, ob Sie alle Voraussetzungen für die Ausführung des Data Engineering-Agents erfüllt haben. Weitere Informationen finden Sie unter Vorbereitung.

Wenn bei der generierten Datenpipeline Fehler auftreten, können Sie den Data Engineering-Agenten mit den folgenden Schritten auffordern, Fehler in der Datenpipeline zu diagnostizieren und Empfehlungen zur Fehlerbehebung zu geben:

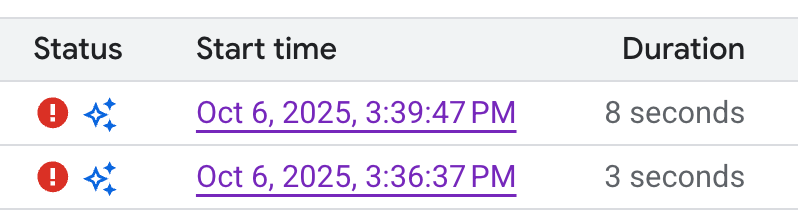

- Klicken Sie in Ihrer Pipeline oder Ihrem Entwicklungsarbeitsbereich auf den Tab Ausführungen.

Suchen Sie in der Liste der Ausführungen nach der fehlgeschlagenen Ausführung der Datenpipeline. Fehlerhafte Ausführungen werden in der Spalte Status der Ausführung angezeigt.

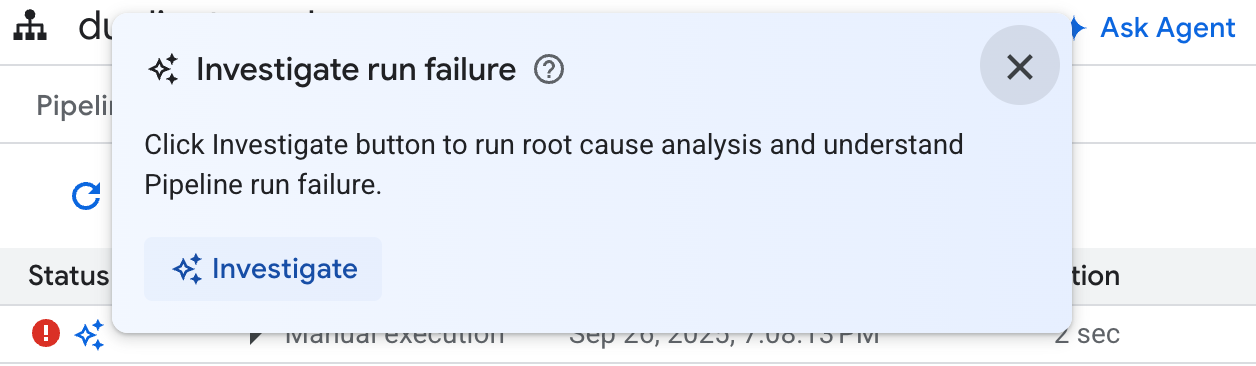

Bewegen Sie den Mauszeiger auf das Symbol und klicken Sie auf Untersuchen. Der Data Engineering Agent analysiert die Ausführung Ihrer Datenpipeline auf Fehler.

Wenn die Analyse abgeschlossen ist, erstellt der Data Engineering Agent einen Bericht im Bereich Beobachtungen und Hypothese. Dieser Bericht enthält:

- Beobachtungen und Datenpunkte, die aus den Ausführungsprotokollen der Datenpipeline extrahiert wurden

- Wahrscheinliche Ursachen für den Fehler

- Eine Reihe von umsetzbaren Schritten oder Empfehlungen zur Behebung des Problems

Mithilfe des Berichts zur Fehlerbehebung des Data Engineering Agent können Sie die Empfehlungen manuell umsetzen. Sie können den Data Engineering Agent auch anweisen, die Korrektur für Sie vorzunehmen. Gehen Sie dazu so vor:

- Kopieren Sie die Vorschläge aus dem Bericht zur Fehlerbehebung.

- Zurück zum Data Engineering Agent:

- Wenn Sie BigQuery-Pipelines verwenden, rufen Sie die Seite „Pipelines“ auf und klicken Sie auf Kundenservicemitarbeiter fragen.

- Wenn Sie Dataform verwenden, klicken Sie auf Agent fragen.

- Fügen Sie die Vorschläge in den Prompt ein und weisen Sie den Data Engineering-Agent an, die Korrekturen direkt an Ihrer Datenpipeline vorzunehmen.

- Klicken Sie auf Senden.

Beispiel-Prompts

In den folgenden Abschnitten finden Sie einige Beispiel-Prompts, die Sie mit dem Data Engineering Agent verwenden können, um Ihre Datenpipeline zu entwickeln.

Vorhandene Daten in einer neuen Tabelle zusammenfassen

Mit diesem Prompt leitet der Data-Engineering-Agent aus dem Schema und den Beispielen ab, wie Daten nach Schlüssel gruppiert werden. Der Agent richtet in der Regel eine neue Tabellenkonfiguration mit Tabellen- und Spaltenbeschreibungen ein.

Create a daily sales report from the

bigquery-public-data.thelook_ecommerce.order_items table into a

reporting.daily_sales_aggregation table.

Einer vorhandenen Tabelle Prüfungen zur Datenqualität hinzufügen

Mit diesem Prompt leitet der Agent auf Grundlage des Schemas und der Stichproben angemessene Qualitätsprüfungen für die Tabelle ab. Sie können dem Prompt auch einige subjektive Behauptungen hinzufügen.

Add data quality checks for bigquery-public-data.thelook_ecommerce.users.

Neue abgeleitete Spalte erstellen und der neuen Tabelle Datenqualitätsprüfungen hinzufügen

Im folgenden Prompt wird gezeigt, wie Sie gleichzeitig eine Tabelle und eine Spalte hinzufügen und Qualitätsprüfungen für die Tabelle festlegen können.

Create a new table named staging.products from

bigquery-public-data.thelook_ecommerce.products and add a calculated column

named gross_profit, which is the retail_price minus the cost.

Also, add the following assertions: ID must not be null and must be unique.

The retail_price must be greater than or equal to the cost. The department

column can only contain 'Men' or 'Women'.

UDFs als Teil der Modelldefinition erstellen

Der Data Engineering Agent kann auch die DDL zum Erstellen benutzerdefinierter Funktionen (User-Defined Functions, UDFs) einrichten. Der Agent erstellt die UDF zwar nicht, Sie können sie aber erstellen, indem Sie die Datenpipeline ausführen. Diese UDFs können in Modelldefinitionen in Ihrer Datenpipeline verwendet werden.

Create a user-defined function (UDF) named get_age_group that takes an integer

age as input and returns a string representing the age group ('Gen Z',

'Millennial', 'Gen X', 'Baby Boomer').

Use this UDF on the age column from the

bigquery-public-data.thelook_ecommerce.users table to create a new view called

reporting.user_age_demographics that includes user_id, age, and the calculated

age_group.

Best Practices

In den folgenden Abschnitten finden Sie Best Practices für die Arbeit mit dem Data Engineering Agent und Dataform.

Best Practices für den Data Engineering Agent

Agent-Anweisungen für häufige Anfragen verwenden: Wenn Sie häufig bestimmte Techniken anwenden oder dem Agenten immer wieder dieselben Korrekturen geben, können Sie die Agent-Anweisungen als zentralen Ort zum Speichern häufig verwendeter Anweisungen und Anfragen nutzen.

Geben Sie dem KI-Agenten mehr Kontext. Sie können dem Agenten zusätzlichen Kontext aus dem Dataplex Universal Catalog bereitstellen, indem Sie Glossarbegriffe an BigQuery-Tabellen und -Spalten anhängen und Datenprofilscans generieren. Glossarbegriffe können verwendet werden, um Spalten zu taggen, die zusätzlichen Kontext erfordern, z. B. Spalten mit personenidentifizierbaren Informationen, für die spezielle Anweisungen zur Verarbeitung erforderlich sind, oder um übereinstimmende Spalten mit unterschiedlichen Namen in verschiedenen Tabellen zu identifizieren. Mithilfe von Datenprofilscans kann der KI-Agent die Datenverteilung in den Spalten einer Tabelle besser nachvollziehen und spezifischere Zusicherungen zur Datenqualität erstellen. Weitere Informationen finden Sie unter Datenprofilerstellung.

Klar schreiben: Formulieren Sie Ihre Anfrage klar und vermeiden Sie vage Formulierungen. Geben Sie nach Möglichkeit Quell- und Zieldatenquellen an, wie im folgenden Beispiel:

Extract data from the sales.customers table in the us_west_1 region, and load

it into the reporting.dim_customers table in BigQuery. Match the schema of the

destination table.

Direkte und eingegrenzte Anfragen stellen: Stellen Sie jeweils nur eine Frage und halten Sie die Prompts kurz. Bei Prompts mit mehr als einer Frage können Sie die einzelnen Teile der Frage zur besseren Übersicht nummerieren, wie im folgenden Beispiel:

1. Create a new table named staging.events_cleaned. Use raw.events as the

source. This new table should filter out any records where the user_agent

matches the pattern '%bot%'. All original columns should be included.

2. Next, create a table named analytics.user_sessions. Use

staging.events_cleaned as the source. This table should calculate the

duration for each session by grouping by session_id and finding the

difference between the MAX(event_timestamp) and MIN(event_timestamp).

Geben Sie explizite Anweisungen und heben Sie wichtige Begriffe hervor. Sie können in Ihren Prompts wichtige Begriffe oder Konzepte hervorheben und bestimmte Anforderungen als wichtig kennzeichnen, wie im folgenden Beispiel:

When creating the staging.customers table, it is *VERY IMPORTANT* that you

transform the email column from the source table bronze.raw_customers.

Coalesce any NULL values in the email column to an empty string ''.

Operatorrangfolge angeben: Bei geordneten Aufgaben können Sie Ihren Prompt in Listen strukturieren, in denen die aufgeführten Elemente in kleine, fokussierte Schritte unterteilt sind, wie im folgenden Beispiel:

Create a pipeline with the following steps:

1. Extract data from the ecomm.orders table.

2. Join the extracted data with the marts.customers table on customer_id

3. Load the final result into the reporting.customer_orders table.

Optimieren und iterieren: Probieren Sie verschiedene Formulierungen und Ansätze aus, um herauszufinden, was die besten Ergebnisse liefert. Wenn der Agent ungültigen SQL-Code oder andere Fehler generiert, können Sie ihn mithilfe von Beispielen oder öffentlicher Dokumentation anleiten.

The previous query was incorrect because it removed the timestamp. Please

correct the SQL. Use the TIMESTAMP_TRUNC function to truncate the

event_timestamp to the nearest hour, instead of casting it as a DATE. For

example: TIMESTAMP_TRUNC(event_timestamp, HOUR).

Best Practices für Agent-Anweisungsdateien

Erstellen Sie Agent-Anweisungsdateien, um den Data Engineering Agent an Ihre Anforderungen anzupassen. Wenn Sie Agent-Anweisungen verwenden, empfehlen wir Folgendes:

- Alle Dateipfade in Dataform sind relativ zum Stammverzeichnis des Repository. Verwenden Sie relative Pfade für die

@file.md-Syntax, um Anweisungen korrekt inGEMINI.mdzu importieren. - In

GEMINI.mdimportierte Dateien können selbst Importe enthalten, wodurch eine verschachtelte Struktur entsteht. Um eine unendliche Rekursion zu verhindern, hatGEMINI.mdeine maximale Importtiefe von fünf Ebenen. - Wenn Sie Anweisungen für mehrere Datenpipelines freigeben möchten, speichern Sie sie in einem zentralen Dataform-Repository und verknüpfen Sie sie mit dem Dataform-Arbeitsrepository. Mit lokalen Anweisungen können Sie zentrale Regeln für pipelinespezifisches Verhalten überschreiben.

- Durch die Verwendung von Überschriften und Listen in der Agent-Anweisungsdatei können Sie Anweisungen für den Data Engineering-Agent organisieren und verdeutlichen.

- Geben Sie aussagekräftige Dateinamen an und fassen Sie ähnliche Anweisungen in einer Datei zusammen. Regeln mithilfe von Markdown-Überschriften logisch nach Kategorie, Funktion oder Funktionalität organisieren.

- Um widersprüchliche Anweisungen zu vermeiden, definieren Sie die spezifischen Bedingungen, unter denen jede Anweisung gilt, klar.

- Iterieren und optimieren Sie Ihre Prompts und Ihren Workflow. Das Verhalten von Agents ändert sich im Laufe der Zeit mit der Einführung von Agents und Modell-Upgrades. Wir empfehlen daher, Ihre Regeln mit verschiedenen Prompts zu wiederholen, um Bereiche zu identifizieren, die möglicherweise verbessert werden müssen. Halten Sie die Regelfile mit allen Änderungen an Ihrer Datenpipeline synchron.

Das folgende Beispiel zeigt eine Agent-Anweisungsdatei mit dem Namen GEMINI.md, in der unsere Best Practices für die effektive Verwendung des Data Engineering Agent angewendet werden:

### Naming Conventions

* Datasets: [business_domain]_[use_case] (e.g., ecommerce_sales)

* Tables:

- Raw/External: raw_[source_name]

- Staging: stg_[business_entity]

- Dimension: dim_[dimension_name]

- Fact: fct_[fact_name]

* Dataform Folders:

- sources

- staging

- marts

- dataProducts

* Views: vw_[view_name]

* Columns: snake_case (e.g., order_id, customer_name)

## Cloud Storage data load

* When ingesting data from Cloud Storage, create external tables.

## Null handling

* Filter out null id values

## String normalization

* Standardize string columns by converting to lower case

## Data Cleaning Guidelines

@./generic_cleaning.md