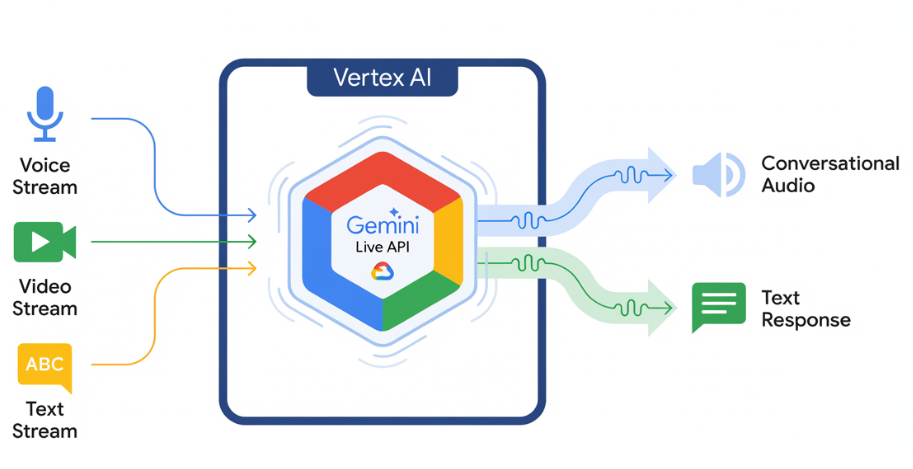

L'API Gemini Live permet des interactions vocales et vidéo en temps réel et à faible latence avec Gemini. Il traite les flux continus d'audio, de vidéo ou de texte pour fournir des réponses vocales immédiates et naturelles. Cela permet de créer une expérience conversationnelle naturelle pour vos utilisateurs.

Essayer l'API Gemini Live dans Vertex AI Studio

Exemples de cas d'utilisation

L'API Gemini Live peut être utilisée pour créer des agents vocaux et vidéo en temps réel pour divers secteurs, y compris :

- E-commerce et vente au détail : assistants d'achat qui proposent des recommandations personnalisées et agents d'assistance qui résolvent les problèmes des clients.

- Jeux vidéo : personnages non joueurs (PNJ) interactifs, assistants d'aide dans les jeux et traduction en temps réel du contenu des jeux.

- Interfaces nouvelle génération : expériences vocales et vidéo dans la robotique, les lunettes connectées et les véhicules.

- Santé : compagnons de santé pour l'assistance et l'éducation des patients.

- Services financiers : conseillers IA pour la gestion de patrimoine et les conseils d'investissement.

- Éducation : mentors et compagnons d'apprentissage basés sur l'IA qui fournissent des instructions et des commentaires personnalisés.

Principales fonctionnalités

L'API Gemini Live offre un ensemble complet de fonctionnalités pour créer des agents vocaux et vidéo robustes :

- Qualité audio élevée : l'API Gemini Live fournit une voix naturelle et réaliste dans plusieurs langues.

- Compatibilité multilingue : discutez dans l'une des 24 langues disponibles.

- Interruption : les utilisateurs peuvent interrompre le modèle à tout moment pour des interactions réactives.

- Dialogue affectif : adapte le style et le ton de la réponse en fonction de l'expression de l'utilisateur.

- Utilisation d'outils : intègre des outils tels que l'appel de fonction et la recherche Google pour des interactions dynamiques.

- Transcriptions audio : fournit des transcriptions textuelles des entrées utilisateur et des sorties du modèle.

- Audio proactif : (aperçu) Vous permet de contrôler quand et dans quels contextes le modèle répond.

Spécifications techniques

Le tableau suivant présente les spécifications techniques de l'API Gemini Live :

| Catégorie | Détails |

|---|---|

| Modes d'entrée | Audio (audio PCM 16 bits brut, 16 kHz, little-endian), images/vidéos (JPEG 1 FPS), texte |

| Modes de sortie | Audio (audio PCM 16 bits brut, 24 kHz, little-endian), texte |

| Protocole | Connexion WebSocket avec état (WSS) |

Modèles compatibles

Les modèles suivants sont compatibles avec l'API Gemini Live. Sélectionnez le modèle approprié en fonction de vos besoins d'interaction.

| ID du modèle | Disponibilité | Cas d'utilisation | Principales fonctionnalités |

|---|---|---|---|

gemini-live-2.5-flash-native-audio |

Disponibilité générale | Recommandation. Agents vocaux à faible latence. Prise en charge du changement de langue et du ton émotionnel. |

|

gemini-live-2.5-flash-preview-native-audio-09-2025 |

Version Preview publique | Rentabilité des agents vocaux en temps réel. |

|

Commencer

Sélectionnez le guide correspondant à votre environnement de développement :

Tutoriel sur le SDK Gen AI

Connectez-vous à l'API Gemini Live à l'aide du SDK Gen AI pour créer une application multimodale en temps réel avec un backend Python.

Tutoriel WebSocket

Connectez-vous à l'API Gemini Live à l'aide de WebSockets pour créer une application multimodale en temps réel avec un frontend JavaScript et un backend Python.

Tutoriel ADK

Créer un agent et utiliser Agent Development Kit (ADK) Streaming pour activer la communication vocale et vidéo

Intégration de partenaires

Si vous souhaitez effectuer une intégration avec certains de nos partenaires, sachez que ces plates-formes ont déjà intégré l'API Gemini Live via le protocole WebRTC pour simplifier le développement d'applications audio et vidéo en temps réel.