KI-Zonen sind spezielle Zonen, die für KI- und ML-Arbeitslasten (Künstliche Intelligenz und maschinelles Lernen) für Training und Inferenz verwendet werden. Sie bieten eine erhebliche Kapazität für ML-Beschleuniger (GPU und TPU).

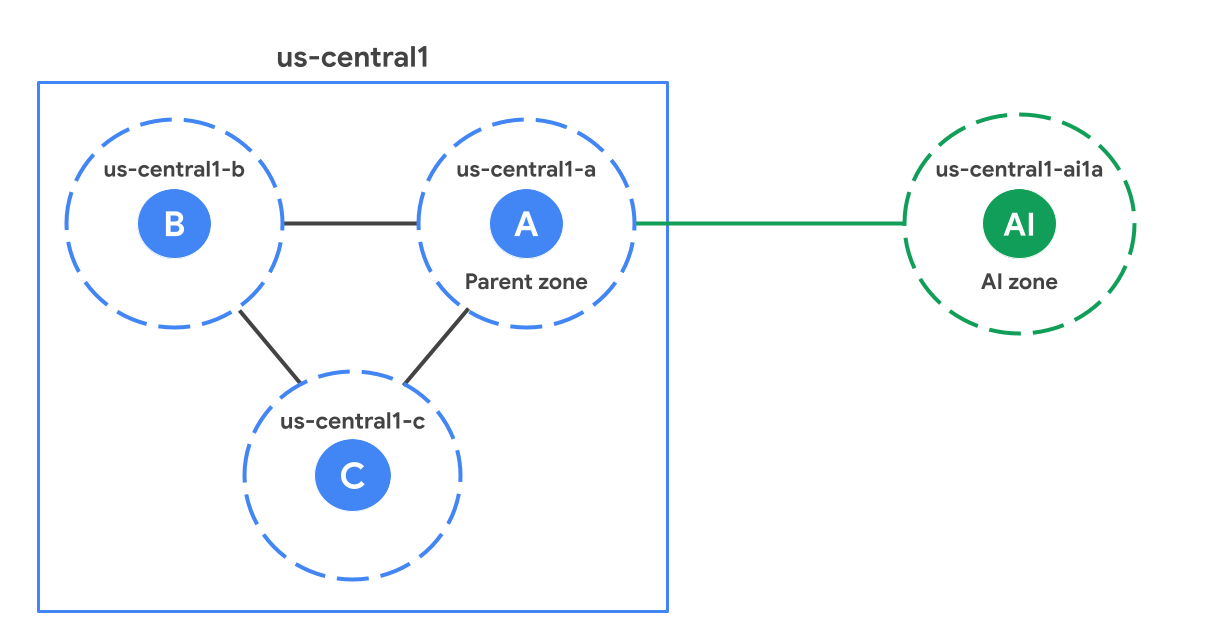

Innerhalb einer Region befinden sich KI-Zonen geografisch entfernt von Standardzonen (nicht KI-Zonen). Die folgende Abbildung zeigt ein Beispiel für eine KI-Zone (us-central1-ai1a), die sich relativ zu den Standardzonen in der Region us-central1 weiter entfernt befindet.

Elternbereich

Jede KI-Zone ist einer Standardzone in der Region zugeordnet, die als übergeordnete Zone bezeichnet wird. Eine übergeordnete Zone ist eine Standardzone mit demselben Suffix wie die KI-Zone. Im Diagramm ist us-central1-a beispielsweise die übergeordnete Zone von us-central1-ai1a. Sie teilen sich Softwareupdatepläne und manchmal auch die Infrastruktur. Das bedeutet, dass Software- oder Infrastrukturprobleme, die sich auf eine übergeordnete Zone auswirken, sich auch auf die KI-Zone auswirken können. Berücksichtigen Sie beim Entwerfen Ihrer Hochverfügbarkeitslösungen die Überlegungen zur Hochverfügbarkeit, um die Abhängigkeit von der übergeordneten Zone zu berücksichtigen.

Wann sollten KI-Zonen verwendet werden?

KI-Zonen sind für KI- und ML-Arbeitslasten optimiert. Anhand der folgenden Anleitung können Sie entscheiden, welche Ihrer Arbeitslasten am besten für KI-Zonen geeignet sind und welche besser in Standardzonen ausgeführt werden.

Empfohlen für:

Groß angelegtes Training:Ideal für groß angelegte Trainingsarbeitslasten wie das Training von Large Language Models (LLMs) und Foundation Models, da eine große Anzahl von Beschleunigern verfügbar ist.

Training, Feinabstimmung, Bulk-Inferenz und erneutes Training in kleinem Maßstab:KI-Zonen eignen sich gut für Arbeitslasten, die eine erhebliche Beschleunigerkapazität erfordern.

ML-Inferenz in Echtzeit:KI-Zonen unterstützen Inferenzarbeitslasten in Echtzeit. Die Leistung hängt vom Anwendungsdesign und den Anforderungen an die Modelllatenz ab, insbesondere wenn für die Arbeitslast Roundtrip-Anfragen an die übergeordnete Region erforderlich sind.

Nicht empfohlen für:

- Nicht-ML-Arbeitslasten:Da KI-Zonen nicht alle Google Cloud Dienste lokal anbieten, empfehlen wir, Ihre Nicht-ML-Arbeitslasten in den Standardzonen auszuführen.

Über eine KI-Zone auf Dienste zugreifen

Sie können über die KI-Zone auf alle Google Cloud Produkte in einer Google Cloud Region zugreifen. Der Zugriff auf Dienste in einer Google Cloud -Region über eine KI-Zone kann jedoch zu einer erhöhten Netzwerklatenz führen, da die KI-Zone physisch von den Standorten der Standardzonen der Region getrennt ist.

Bei bestimmten Produkten können zonale Ressourcen lokal in einer KI-Zone erstellt oder auf sie zugegriffen werden. Weitere Informationen zu diesen Diensten finden Sie in der folgenden Tabelle:

| Produkt | Beschreibung |

|---|---|

| Google Kubernetes Engine (GKE) | Einrichtung für die Verwendung von KI-Zonen in GKE-Clustern, einschließlich der Konfiguration mit Compute-Klassen, automatischer Knotenbereitstellung und GKE-Standardknotenpools. KI-Zonen in GKE verwenden |

| Cloud Storage | Konfiguration von Objektspeicher für Arbeitslasten in KI-Zonen, einschließlich zonalem Speicher zur Maximierung der Leistung bei aktiven Jobs und persistentem Speicher für Datasets und Modell-Checkpoints. KI-Zonen mit Cloud Storage verwenden |

| Compute Engine | Methoden zum Ermitteln verfügbarer KI-Zonen mit der Console, der Google Cloud CLI und der REST API, einschließlich des Filterns nach Namenskonvention, Beschleunigertyp oder Maschine Verfügbare KI-Zonen suchen |

Standorte

KI-Zonen sind an den folgenden Standorten verfügbar:

| KI-Zone | Standort der KI-Zone | Google Cloud -Region | Standort derGoogle Cloud -Region | Elternbereich |

|---|---|---|---|---|

us-south1-ai1b |

Austin, Texas, Nordamerika | us-south1 |

Dallas, Texas, Nordamerika | us-south1-b |

us-central1-ai1a |

Lincoln, Nebraska, Nordamerika | us-central1 |

Council Bluffs, Iowa, Nordamerika | us-central1-a |

KI-Zonen verwenden

Auf KI-Zonen kann über die Google Cloud Console, die Google Cloud CLI oder REST zugegriffen werden. Wenn Sie dieGoogle Cloud -Konsole zum Erstellen Ihrer VMs verwenden, müssen Sie jedoch manuell eine KI-Zone auswählen. Sie wird nicht automatisch ausgewählt, wie es bei Standardzonen der Fall ist. Wenn Sie KI-Zonen mit den folgenden Funktionen verwenden möchten, müssen Sie beim Einrichten dieser Ressourcen explizit eine KI-Zone auswählen.

Bestimmte Compute Engine- und GKE-Funktionen: KI-Zonen werden bei bestimmten regionalen Compute Engine- und GKE-Funktionen nicht automatisch ausgewählt (z. B. regionale verwaltete Instanzgruppen, regionale GKE-Cluster). Weitere Informationen zu GKE finden Sie in der GKE.

Einschränkungen für Arbeitslasten ohne Beschleuniger: Wenn Sie reine CPU-VMs in KI-Zonen ausführen, müssen Sie die von Compute Engine erzwungenen Einschränkungen beachten. Dazu gehören möglicherweise Anforderungen an das GPU:CPU-Verhältnis und Reservierungen.

Vertex AI: Für regionale Vertex AI-Produkte, die auf GKE basieren, muss GKE konfiguriert werden, damit KI-Zonen in regionalen Clustern enthalten sind. Sie müssen Vertex AI nicht aktivieren. Vertex AI verwaltet diese Konfiguration.

Google Cloud Service Metadata Locations API: Sie müssen das Flag

--extraLocationTypesaktivieren, wenn Sie die locations.list API verwenden, damit KI-Zonen nur für Nutzer angezeigt werden, die sie verwenden möchten.

KI-Zonen in GKE verwenden

Standardmäßig werden Ihre Arbeitslasten in GKE nicht in KI-Zonen bereitgestellt. Wenn Sie eine KI-Zone verwenden möchten, konfigurieren Sie eine der folgenden Optionen:

ComputeClasses:Legen Sie die höchste Priorität fest, um On-Demand-TPUs in einer KI-Zone anzufordern. Mit ComputeClasses können Sie eine priorisierte Liste von Hardwarekonfigurationen für Ihre Arbeitslasten definieren. Ein Beispiel finden Sie unter Compute-Klassen.

Automatische Knotenbereitstellung:Verwenden Sie eine

nodeSelectorodernodeAffinityin Ihrer Pod-Spezifikation, um die automatische Knotenbereitstellung anzuweisen, einen Knotenpool in der KI-Zone zu erstellen. Wenn Ihre Arbeitslast nicht explizit auf eine KI-Zone ausgerichtet ist, werden bei der automatischen Knotenbereitstellung nur Standardzonen berücksichtigt, wenn neue Knotenpools erstellt werden. Mit dieser Konfiguration wird sichergestellt, dass Arbeitslasten, für die keine KI-/ML-Modelle ausgeführt werden, in Standardzonen verbleiben, sofern Sie nichts anderes konfigurieren. Ein Beispiel für ein Manifest, in dem einnodeSelectorverwendet wird, finden Sie unter Standardzonen für automatisch erstellte Knoten festlegen.GKE Standard:Wenn Sie Ihre Knotenpools direkt verwalten, verwenden Sie beim Erstellen eines Knotenpools eine KI-Zone im Flag

--node-locations. Ein Beispiel finden Sie unter TPU-Arbeitslasten in GKE Standard bereitstellen.

Beschränkungen

Folgendes ist in KI-Zonen nicht verfügbar:

Überlegungen zum Design mit KI-Zonen

Beachten Sie beim Entwerfen Ihrer Anwendungen für die Verwendung von KI-Zonen Folgendes:

Überlegungen zur Hochverfügbarkeit (HA)

KI-Zonen teilen sich Software-Rollouts und Infrastruktur mit ihren übergeordneten Zonen. Um eine hohe Verfügbarkeit für Ihre Arbeitslasten zu gewährleisten, sollten Sie die folgenden Bereitstellungsmuster vermeiden, wenn Sie Zonen auswählen, unabhängig davon, ob dies automatisch oder manuell erfolgt:

Vermeiden Sie die Bereitstellung von HA-Arbeitslasten in einer KI-Zone und der zugehörigen übergeordneten Zone.

Vermeiden Sie die Bereitstellung von HA-Arbeitslasten in zwei KI-Zonen, die dieselbe übergeordnete Zone haben.

Best Practices

Wir empfehlen eine mehrstufige Speicherarchitektur, um Kosten, Langlebigkeit und Leistung in Einklang zu bringen:

- Cold Storage-Ebene:Verwenden Sie regionale Cloud Storage-Buckets in Standardzonen für die dauerhafte, äußerst robuste Speicherung Ihrer Trainings-Datasets und Modellprüfpunkte.

Leistungsebene:Verwenden Sie spezielle zonale Speicherdienste als Hochgeschwindigkeitscache oder temporären Scratch-Speicher. Durch diesen Ansatz wird die latenz zwischen Zonen eliminiert und der effektive Durchsatz bei aktiven Jobs maximiert.

Damit GPUs und TPUs vollständig ausgelastet bleiben und der Durchsatz maximiert wird, sollten Sie die Leistungsebene in derselben KI-Zone wie Ihre Rechenressourcen bereitstellen.

Die folgenden Speicherlösungen werden empfohlen, um die Leistung von KI- und ML-Systemen mit KI-Zonen zu optimieren:

| Speicherdienst | Beschreibung | Anwendungsfälle |

|---|---|---|

| Anywhere Cache-Funktion von Cloud Storage | Ein vollständig verwalteter, SSD-gestützter zonaler Lesecache, der häufig gelesene Daten aus einem Bucket in die KI-Zone überträgt. | Empfohlen für:

|

Nächste Schritte

- Liste der KI-Zonen ansehen

- In KI-Zonen verfügbare TPU-Typen und ‑Standorte ansehen

- Organisationsrichtlinie einrichten, um die VM-Erstellung in KI-Zonen einzuschränken