Daten mit cloudübergreifenden Vorgängen laden

Als BigQuery-Administrator oder -Analyst können Sie Daten aus einem Amazon Simple Storage Service-Bucket (Amazon S3) oder Azure Blob Storage in BigQuery-Tabellen laden. Sie können die übertragenen Daten entweder mit den Daten inGoogle Cloud -Regionen zusammenführen oder BigQuery-Funktionen wie BigQuery ML nutzen. Sie können auch Replikate materialisierter Ansichten bestimmter externer Quellen erstellen, um diese Daten in BigQuery verfügbar zu machen.

So können Sie Daten in BigQuery übertragen:

Übertragen Sie Daten mithilfe der Anweisung

LOAD DATAaus Dateien in Amazon S3 und Azure Blob Storage in BigQuery-Tabellen.Filtern Sie Daten aus Dateien in Amazon S3- oder Blob-Speicher, bevor Sie die Ergebnisse in BigQuery-Tabellen übertragen. Verwenden Sie dazu die Anweisung

CREATE TABLE AS SELECT. Verwenden Sie die AnweisungINSERT INTO SELECT, um Daten an die Zieltabelle anzuhängen. Die Datenbearbeitung wird auf die externen Tabellen angewendet, die auf Daten aus Amazon S3 oder Blob Storage verweisen.Erstellen Sie Replikate materialisierter Ansichten externer Amazon S3-, Apache Iceberg- oder Salesforce Data Cloud-Daten in einem BigQuery-Dataset, damit die Daten lokal in BigQuery verfügbar sind.

Kontingente und Limits

Informationen zu Kontingenten und Limits finden Sie unter Abfragejobs: Kontingente und Limits.

Hinweise

Um Google Cloud den zum Laden oder Filtern von Daten in anderen Clouds erforderlichen Lesezugriff zu gewähren, bitten Sie Ihren Administrator, eine Verbindung herzustellen und diese für Sie freizugeben. Informationen zum Erstellen von Verbindungen finden Sie unter Verbindung zu Amazon S3 herstellen oder Verbindung zu Blob Storage herstellen.

Erforderliche Rolle

Bitten Sie Ihren Administrator, Ihnen die IAM-Rolle BigQuery-Datenbearbeiter (roles/bigquery.dataEditor) für das Dataset zuzuweisen, um die Berechtigungen zu erhalten, die Sie zum Laden von Daten mit cloudübergreifenden Übertragungen benötigen.

Weitere Informationen zum Zuweisen von Rollen finden Sie unter Zugriff auf Projekte, Ordner und Organisationen verwalten.

Diese vordefinierte Rolle enthält die Berechtigungen, die zum Laden von Daten mit cloudübergreifenden Übertragungen erforderlich sind. Erweitern Sie den Abschnitt Erforderliche Berechtigungen, um die erforderlichen Berechtigungen anzuzeigen:

Erforderliche Berechtigungen

Die folgenden Berechtigungen sind erforderlich, um Daten mit cloudübergreifenden Übertragungen zu laden:

-

bigquery.tables.create -

bigquery.tables.get -

bigquery.tables.updateData -

bigquery.tables.update -

bigquery.jobs.create -

bigquery.connections.use

Sie können diese Berechtigungen auch mit benutzerdefinierten Rollen oder anderen vordefinierten Rollen erhalten.

Weitere Informationen zu IAM-Rollen in BigQuery finden Sie unter BigQuery-IAM-Rollen und -Berechtigungen.

Preise

Die mit Clouds übertragenen Byte werden Ihnen mithilfe der Anweisung LOAD in Rechnung gestellt. Preisinformationen finden Sie im Abschnitt „Omni Cross Cloud Data Transfer“ unter BigQuery Omni – Preise.

Die mit Clouds übertragenen Byte werden Ihnen mit der Anweisung CREATE TABLE AS SELECT oder der Anweisung INSERT INTO SELECT und für die Rechenkapazität in Rechnung gestellt.

Sowohl LOAD- als auch CREATE TABLE AS SELECT-Anweisungen erfordern Slots in den BigQuery Omni-Regionen, um Amazon S3- und Blob Storage-Dateien zu laden. Weitere Informationen finden Sie unter BigQuery Omni-Preise.

Bei Replikaten für materialisierte Ansichten externer Datenquellen können die Kosten auch Preise für materialisierte Ansichten umfassen.

Best Practices für Lade- und Filteroptionen

- Vermeiden Sie die Übertragung mehrerer Dateien, die kleiner als 5 MB sind. Erstellen Sie stattdessen eine externe Tabelle für Ihre Datei und exportieren Sie das Abfrageergebnis nach Amazon S3 oder Blob Storage, um eine größere Datei zu erstellen. Diese Methode verbessert die Übertragungszeit Ihrer Daten. Informationen zum Limit für die maximale Abfrageergebnis finden Sie unter Maximale Größe von Abfrageergebnissen in BigQuery Omni.

- Wenn sich die Quelldaten in einer mit GZIP komprimierten Datei befinden, legen Sie beim Erstellen externer Tabellen die Option

external_table_options.compressionaufGZIPfest.

Daten laden

Mit der Anweisung LOAD DATA [INTO|OVERWRITE] können Sie Daten in BigQuery laden.

Beschränkungen

- Die Verbindung und das Ziel-Dataset müssen zum selben Projekt gehören. Das projektübergreifende Laden von Daten wird nicht unterstützt.

LOAD DATAwird nur unterstützt, wenn Sie Daten von einem Amazon Simple Storage Service (Amazon S3) oder Azure Blob Storage in eine gemeinsame BigQuery-Region übertragen. Weitere Informationen finden Sie unter Standorte.- Sie können Daten aus einer beliebigen

US-Region in eineUS-Multi-Region übertragen. Sie können auch von einer beliebigenEU-Region zu einerEU-Multi-Region wechseln.

- Sie können Daten aus einer beliebigen

Beispiel

Beispiel 1

Im folgenden Beispiel wird eine Parquet-Datei mit dem Namen sample.parquet aus einem Amazon S3-Bucket mit einem Schema zur automatischen Erkennung in die Tabelle test_parquet geladen:

LOAD DATA INTO mydataset.testparquet FROM FILES ( uris = ['s3://test-bucket/sample.parquet'], format = 'PARQUET' ) WITH CONNECTION `aws-us-east-1.test-connection`

Beispiel 2

Im folgenden Beispiel wird eine CSV-Datei mit dem Präfix sampled* aus Ihrem Blob Storage in die Tabelle test_csv mit vordefinierter Spaltenpartitionierung nach Zeit geladen:

LOAD DATA INTO mydataset.test_csv (Number INT64, Name STRING, Time DATE) PARTITION BY Time FROM FILES ( format = 'CSV', uris = ['azure://test.blob.core.windows.net/container/sampled*'], skip_leading_rows=1 ) WITH CONNECTION `azure-eastus2.test-connection`

Beispiel 3

Im folgenden Beispiel wird die vorhandene Tabelle test_parquet mit Daten aus einer Datei namens sample.parquet mit einem Schema zur automatischen Erkennung überschrieben:

LOAD DATA OVERWRITE mydataset.testparquet FROM FILES ( uris = ['s3://test-bucket/sample.parquet'], format = 'PARQUET' ) WITH CONNECTION `aws-us-east-1.test-connection`

Daten filtern

Mit der Anweisung CREATE TABLE AS SELECT und der Anweisung INSERT INTO SELECT können Sie Daten vor der Übertragung in BigQuery filtern.

Beschränkungen

Wenn das Ergebnis der Abfrage

SELECT60 GiB in logischen Byte überschreitet, schlägt die Abfrage fehl. Die Tabelle wird nicht erstellt und es werden keine Daten übertragen. Informationen zum Reduzieren der gescannten Datengröße finden Sie unter In Abfragen verarbeitete Daten reduzieren.Temporäre Tabellen werden nicht unterstützt.

Die Übertragung des Geodaten-Formats Well-known Binary (WKB) wird nicht unterstützt.

Die

INSERT INTO SELECT-Anweisung unterstützt nicht die Übertragung von Daten in eine geclusterte Tabelle.Wenn die Zieltabelle in der

INSERT INTO SELECT-Anweisung mit der Quelltabelle in derSELECT-Abfrage übereinstimmt, ändert dieINSERT INTO SELECT-Anweisung keine Zeilen in der Zieltabelle. Die Zieltabelle wird nicht geändert, da BigQuery keine Daten über Regionen hinweg lesen kann.CREATE TABLE AS SELECTundINSERT INTO SELECTwerden nur unterstützt, wenn Sie Daten von einem Amazon S3- oder Blob Storage-Speicher in eine gemeinsame BigQuery-Region übertragen. Weitere Informationen finden Sie unter Standorte.- Sie können Daten aus einer beliebigen

US-Region in eineUS-Multi-Region übertragen. Sie können auch von einer beliebigenEU-Region zu einerEU-Multi-Region wechseln.

- Sie können Daten aus einer beliebigen

Beispiel

Beispiel 1

Angenommen, Sie haben eine BigLake-Tabelle mit dem Namen myawsdataset.orders, die auf Daten aus Amazon S3 verweist.

Sie möchten Daten aus dieser Tabelle in eine BigQuery-Tabelle myotherdataset.shipments am multiregionalen Standort „US“ übertragen.

Rufen Sie zuerst Informationen zur Tabelle myawsdataset.orders auf:

bq show myawsdataset.orders;

Die Ausgabe sieht in etwa so aus:

Last modified Schema Type Total URIs Expiration

----------------- -------------------------- ---------- ------------ -----------

31 Oct 17:40:28 |- l_orderkey: integer EXTERNAL 1

|- l_partkey: integer

|- l_suppkey: integer

|- l_linenumber: integer

|- l_returnflag: string

|- l_linestatus: string

|- l_commitdate: date

Rufen Sie als Nächstes Informationen zur Tabelle myotherdataset.shipments auf:

bq show myotherdataset.shipments

Die entsprechende Ausgabe sieht etwa so aus: Einige Spalten werden weggelassen, um die Ausgabe zu vereinfachen.

Last modified Schema Total Rows Total Bytes Expiration Time Partitioning Clustered Fields Total Logical

----------------- --------------------------- ------------ ------------- ------------ ------------------- ------------------ ---------------

31 Oct 17:34:31 |- l_orderkey: integer 3086653 210767042 210767042

|- l_partkey: integer

|- l_suppkey: integer

|- l_commitdate: date

|- l_shipdate: date

|- l_receiptdate: date

|- l_shipinstruct: string

|- l_shipmode: string

Mit der Anweisung CREATE TABLE AS SELECT können Sie jetzt Daten selektiv in die Tabelle myotherdataset.orders am multiregionalen Standort „US“ laden:

CREATE OR REPLACE TABLE myotherdataset.orders PARTITION BY DATE_TRUNC(l_commitdate, YEAR) AS SELECT * FROM myawsdataset.orders WHERE EXTRACT(YEAR FROM l_commitdate) = 1992;

Sie können dann einen Join-Vorgang mit der neu erstellten Tabelle ausführen:

SELECT orders.l_orderkey, orders.l_orderkey, orders.l_suppkey, orders.l_commitdate, orders.l_returnflag, shipments.l_shipmode, shipments.l_shipinstruct FROM myotherdataset.shipments JOIN `myotherdataset.orders` as orders ON orders.l_orderkey = shipments.l_orderkey AND orders.l_partkey = shipments.l_partkey AND orders.l_suppkey = shipments.l_suppkey WHERE orders.l_returnflag = 'R'; -- 'R' means refunded.

Wenn neue Daten verfügbar sind, hängen Sie die Daten des Jahres 1993 mit der Anweisung INSERT INTO SELECT an die Zieltabelle an:

INSERT INTO myotherdataset.orders SELECT * FROM myawsdataset.orders WHERE EXTRACT(YEAR FROM l_commitdate) = 1993;

Beispiel 2

Im folgenden Beispiel werden Daten in eine nach Aufnahmezeit partitionierte Tabelle eingefügt:

CREATE TABLE mydataset.orders(id String, numeric_id INT64) PARTITION BY _PARTITIONDATE;

Nachdem Sie eine partitionierte Tabelle erstellt haben, können Sie Daten in die nach Aufnahmezeit partitionierte Tabelle einfügen:

INSERT INTO mydataset.orders( _PARTITIONTIME, id, numeric_id) SELECT TIMESTAMP("2023-01-01"), id, numeric_id, FROM mydataset.ordersof23 WHERE numeric_id > 4000000;

Replikate für materialisierte Ansichten

Ein Replikat einer materialisierten Ansicht ist eine Replikation externer Amazon S3-Daten (Amazon Simple Storage Service), Apache Iceberg-Daten oder Salesforce Data Cloud-Daten in einem BigQuery-Dataset, damit die Daten lokal in BigQuery verfügbar sind. So können Sie Kosten für den Daten-Egress vermeiden und die Abfrageleistung verbessern. In BigQuery können Sie materialisierte Ansichten über BigLake-Metadaten-Cache-fähige Tabellen über Amazon Simple Storage Service (Amazon S3), Apache Iceberg oder Salesforce Data Cloud-Daten erstellen.

Mit einem Replikat für materialisierte Ansichten können Sie die Daten der materialisierten Ansicht in Amazon S3, Iceberg oder Data Cloud in Abfragen verwenden. Gleichzeitig vermeiden Sie Kosten für ausgehenden Datenverkehr und verbessern die Abfrageleistung. Bei einem Replikat einer materialisierten Ansicht werden die Amazon S3-, Iceberg- oder Data Cloud-Daten in einem Dataset in einer unterstützten BigQuery-Region repliziert, damit sie lokal in BigQuery verfügbar sind.

Hinweise

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator role

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator role

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

- Prüfen Sie, ob Sie die erforderlichen IAM-Berechtigungen (Identity and Access Management) haben, um die Aufgaben in diesem Abschnitt ausführen zu können.

-

bigquery.tables.create -

bigquery.tables.get -

bigquery.tables.getData -

bigquery.tables.replicateData -

bigquery.jobs.create - Erstellen Sie ein Dataset in einer Region, die Amazon S3 unterstützt.

- Erstellen Sie eine Quelltabelle im Dataset, das Sie im vorherigen Schritt erstellt haben. Die Quelltabelle kann einen der folgenden Tabellentypen haben:

- Eine Amazon S3 BigLake-Tabelle, für die das Metadaten-Caching aktiviert ist und die kein Iceberg-Dateiformat verwendet.

- Eine externe Apache Iceberg-Tabelle.

- Eine Data Cloud-Tabelle.

Rufen Sie in der Google Cloud Console die Seite BigQuery auf.

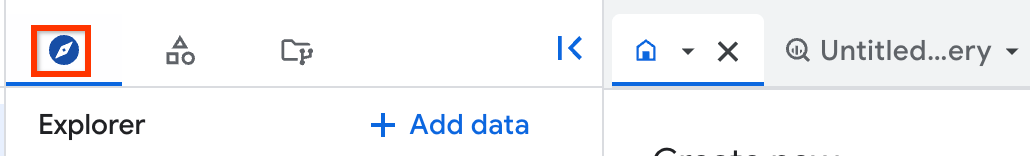

Klicken Sie im linken Bereich auf Explorer:

Wenn Sie den linken Bereich nicht sehen, klicken Sie auf Linken Bereich maximieren, um ihn zu öffnen.

Rufen Sie im Bereich Explorer das Projekt und das Dataset auf, in dem Sie das Replikat für die materialisierte Ansicht erstellen möchten, und klicken Sie dann auf Aktionen > Tabelle erstellen.

Gehen Sie im Dialogfeld Tabelle erstellen im Bereich Quelle so vor:

- Wählen Sie unter Tabelle erstellen aus die Option Vorhandene Tabelle/Ansicht aus.

- Geben Sie unter Project (Projekt) das Projekt ein, in dem sich die Quelltabelle oder ‑ansicht befindet.

- Geben Sie unter Dataset das Dataset ein, in dem sich die Quelltabelle oder ‑ansicht befindet.

- Geben Sie unter Ansicht die Quelltabelle oder ‑ansicht ein, die Sie replizieren möchten. Wenn Sie eine Ansicht auswählen, muss es sich um eine autorisierte Ansicht handeln. Andernfalls müssen sich alle Tabellen, die zum Generieren dieser Ansicht verwendet werden, im Dataset der Ansicht befinden.

Optional: Geben Sie unter Max. Veralterung der lokalen materialisierten Ansicht einen

max_staleness-Wert für die lokale materialisierte Ansicht ein.Gehen Sie auf der Seite Tabelle erstellen im Abschnitt Ziel so vor:

- Geben Sie unter Projekt das Projekt ein, in dem Sie das Replikat der materialisierten Ansicht erstellen möchten.

- Geben Sie unter Dataset das Dataset ein, in dem Sie das Replikat der materialisierten Ansicht erstellen möchten.

- Geben Sie unter Name der materialisierten Ansicht im Replikat einen Namen für das Replikat ein.

Optional: Geben Sie Tags und erweiterte Optionen für das Replikat der materialisierten Ansicht an. Wenn Sie keinen Datensatz für Lokales Dataset mit materialisierter Ansicht angeben, wird automatisch ein Datensatz im selben Projekt und in derselben Region wie die Quelldaten erstellt und

bq_auto_generated_local_mv_datasetgenannt. Wenn Sie keinen Namen für Name der lokalen materialisierten Ansicht angeben, wird automatisch ein Name im selben Projekt und in derselben Region wie die Quelldaten erstellt und das Präfixbq_auto_generated_local_mv_zugewiesen.Klicken Sie auf Tabelle erstellen.

- Erstellen Sie eine materialisierte Ansicht über die Basistabelle im von Ihnen erstellten Dataset. Sie können die materialisierte Ansicht auch in einem anderen Dataset erstellen, das sich in einer Amazon S3-Region befindet.

- Autorisieren Sie die materialisierte Ansicht für die Datasets, die die Quelltabellen enthalten, die in der Abfrage verwendet werden, mit der die materialisierte Ansicht erstellt wurde.

- Wenn Sie die manuelle Aktualisierung des Metadaten-Cache für die Quelltabelle konfiguriert haben, führen Sie das Systemverfahren

BQ.REFRESH_EXTERNAL_METADATA_CACHEaus, um den Metadaten-Cache zu aktualisieren. - Führen Sie das Systemverfahren

BQ.REFRESH_MATERIALIZED_VIEWaus, um die materialisierte Ansicht zu aktualisieren. Verwenden Sie zum Erstellen von Replikaten der materialisierten Ansicht die Anweisung

CREATE MATERIALIZED VIEW AS REPLICA OF:CREATE MATERIALIZED VIEW PROJECT_ID.BQ_DATASET.REPLICA_NAME OPTIONS(replication_interval_seconds=REPLICATION_INTERVAL) AS REPLICA OF PROJECT_ID.S3_DATASET.MATERIALIZED_VIEW_NAME;

Ersetzen Sie Folgendes:

PROJECT_ID: der Name Ihres Projekts, in dem Sie das Replikat für materialisierte Ansichten erstellen möchten, z. B.myproject.BQ_DATASET: der Name des BigQuery-Datasets, in dem Sie das Replikat für materialisierte Ansichten erstellen möchten, z. B.bq_dataset. Das Dataset muss sich in der BigQuery-Region befinden, die der Region der materialisierten Quellansicht zugeordnet ist.REPLICA_NAME: der Name des Replikats für materialisierte Ansichten, das Sie erstellen möchten, z. B.my_mv_replica.REPLICATION_INTERVAL: Gibt in Sekunden an, wie oft die Daten aus der materialisierten Ansicht in das Replikat repliziert werden. Wert, der nicht niedriger als "60" und nicht höher als "3.600" sein darf. Der Standardwert ist 300 (5 Minuten).S3_DATASET: der Name des Datasets, das die materialisierte Quellansicht enthält, z. B.s3_dataset.MATERIALIZED_VIEW_NAME: der Name der zu replizierenden materialisierten Ansicht, z. B.my_mv.

Im folgenden Beispiel wird ein Replikat für materialisierte Ansichten mit dem Namen

mv_replicainbq_dataseterstellt.CREATE MATERIALIZED VIEW `myproject.bq_dataset.mv_replica` OPTIONS( replication_interval_seconds=600 ) AS REPLICA OF `myproject.s3_dataset.my_s3_mv`

- Informationen zur Aktualität des Replikats der materialisierten Ansicht finden Sie im Feld Zuletzt geändert im Bereich Details des Replikats der materialisierten Ansicht.

- Prüfen Sie die Aktualität der materialisierten Quellansicht im Feld Zuletzt geändert im Bereich Details der materialisierten Ansicht.

- Sehen Sie sich im Bereich Details der materialisierten Ansicht das Feld Max. Veralterung an, um die Cache-Aktualität der Amazon S3-, Iceberg- oder Data Cloud-Tabellen-Metadaten zu sehen.

northamerica-northeast1northamerica-northeast2us-central1us-east1us-east4us-east5us-south1us-west1us-west2us-west3us-west4northamerica-northeast1northamerica-northeast2us-central1us-east1us-east4us-east5us-south1us-west1us-west2us-west3us-west4europe-central2europe-north1europe-southwest1europe-west1europe-west2europe-west3europe-west4europe-west6europe-west8europe-west9europe-west10asia-east1asia-east2asia-northeast1asia-northeast2asia-northeast3asia-south1asia-south2asia-southeast1australia-southeast1australia-southeast2- Sie können für materialisierte Ansichten keine Replikate für materialisierte Ansichten erstellen, die auf Tabellen basieren, die Folgendes verwenden:Sicherheit auf Zeilenebene oder Sicherheit auf Spaltenebene.

- Sie können kundenverwaltete Verschlüsselungsschlüssel (CMEKs) weder mit der materialisierten Quellansicht noch mit dem Replikat für materialisierte Ansichten verwenden.

- Sie können Replikate der materialisierten Ansicht nur für materialisierte Ansichten erstellen, die auf Tabellen basieren, die Metadaten-Caching verwenden.

- Sie können für eine bestimmte materialisierte Quellansicht nur ein einziges Replikat für materialisierte Ansichten erstellen.

- Sie können Replikate für materialisierte Ansichten nur für autorisierte materialisierte Ansichten erstellen.

- Informationen zu BigQuery ML.

- Weitere Informationen zu BigQuery Omni

- Informationen zum Ausführen von Abfragen

- VPC Service Controls für BigQuery Omni einrichten

- Wiederkehrende Ladejobs von Amazon S3 in BigQuery und Blob-Speicher in BigQuery planen und verwalten

Erforderliche Rollen

Bitten Sie Ihren Administrator, Ihnen die IAM-Rolle BigQuery-Administrator (roles/bigquery.admin) zuzuweisen, um die Berechtigungen zu erhalten, die Sie zum Ausführen der Aufgaben in diesem Abschnitt benötigen.

Weitere Informationen zum Zuweisen von Rollen finden Sie unter Zugriff auf Projekte, Ordner und Organisationen verwalten.

Diese vordefinierte Rolle enthält die Berechtigungen, die zum Ausführen der Aufgaben in diesem Abschnitt erforderlich sind. Maximieren Sie den Abschnitt Erforderliche Berechtigungen, um die notwendigen Berechtigungen anzuzeigen:

Erforderliche Berechtigungen

Die folgenden Berechtigungen sind zum Ausführen der Aufgaben in diesem Abschnitt erforderlich:

Sie können diese Berechtigungen auch mit benutzerdefinierten Rollen oder anderen vordefinierten Rollen erhalten.

Weitere Informationen zu BigQuery IAM finden Sie unter BigQuery-IAM-Rollen und -Berechtigungen.

Dataset für Replikate der materialisierten Ansicht vorbereiten

Bevor Sie ein Replikat für materialisierte Ansichten erstellen, müssen Sie die folgenden Aufgaben ausführen:

Replikate für materialisierte Ansichten erstellen

Wählen Sie eine der folgenden Optionen aus:

Console

Eine neue lokale materialisierte Ansicht wird erstellt (falls nicht angegeben) und im Quelldatensatz autorisiert. Anschließend wird das Replikat der materialisierten Ansicht im Zieldatensatz erstellt.

SQL

Nachdem Sie das Replikat der materialisierten Ansicht erstellt haben, fragt der Replikationsprozess die materialisierte Quellansicht auf Änderungen ab und repliziert Daten in das Replikat der materialisierten Ansicht. Dabei werden die Daten in dem in replication_interval_seconds oder max_staleness angegebenen Intervall aktualisiert. Wenn Sie das Replikat abfragen, bevor der erste Backfill abgeschlossen ist, wird der Fehler backfill in progress angezeigt. Sie können die Daten im Replikat für materialisierte Ansichten abfragen, nachdem die erste Replikation abgeschlossen ist.

Datenaktualität

Nachdem Sie das Replikat für materialisierte Ansichten erstellt haben, fragt der Replikationsprozess die materialisierte Quellansicht auf Änderungen ab und repliziert Daten in das Replikat für materialisierte Ansichten. Die Daten werden im Intervall repliziert, das Sie in der Option replication_interval_seconds der Anweisung CREATE MATERIALIZED VIEW AS REPLICA OF angegeben haben.

Zusätzlich zum Replikationsintervall wird die Aktualität der Replikatdaten für die materialisierte Ansicht auch dadurch beeinflusst, wie oft die materialisierte Ansicht aktualisiert wird und wie oft der Metadaten-Cache der Amazon S3-, Iceberg- oder Data Cloud-Tabelle, die der materialisierten Ansicht verwendet wird, aktualisiert wird.

Mit der Google Cloud -Console können Sie die Datenaktualität für das Replikat für materialisierte Ansichten und die Ressourcen prüfen, auf denen es basiert:

Unterstützte Regionen für Replikate materialisierter Ansichten

Verwenden Sie beim Erstellen von Replikaten für materialisierte Ansichten die Standortzuordnungen in der folgenden Tabelle:

| Speicherort der Quellansicht | Speicherort des Replikats für materialisierte Ansichten |

|---|---|

aws-us-east-1 |

Die US

Multiregion oder eine der folgenden Regionen:

|

aws-us-west-2 |

Die US

Multiregion oder eine der folgenden Regionen:

|

aws-eu-west-1 |

Die EU

Multiregion oder eine der folgenden Regionen:

|

aws-ap-northeast-2 |

Beliebige der folgenden Regionen:

|

aws-ap-southeast-2 |

Beliebige der folgenden Regionen:

|

Einschränkungen von Replikaten für materialisierte Ansichten

Preise für Replikate für materialisierte Ansichten

Die Verwendung von Replikaten für materialisierte Ansichten verursacht Kosten für Computing, ausgehende Datenübertragung und Speicher.