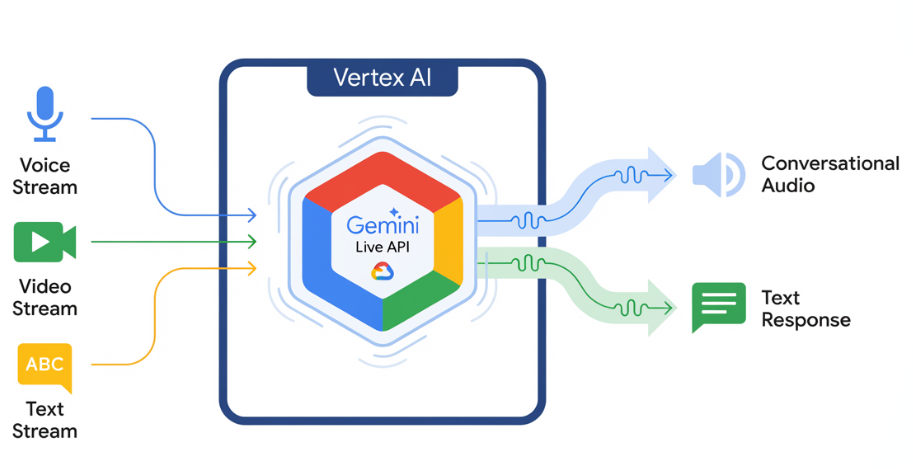

A API Gemini Live permite interações de voz e vídeo em tempo real e de baixa latência com o Gemini. Ele processa fluxos contínuos de áudio, vídeo ou texto para oferecer respostas faladas imediatas e semelhantes às humanas. Isso cria uma experiência de conversa natural para os usuários.

Testar a API Gemini Live no Vertex AI Studio

Exemplos de casos de uso

A API Gemini Live pode ser usada para criar agentes de voz e vídeo em tempo real para vários setores, incluindo:

- E-commerce e varejo:assistentes de compras que oferecem recomendações personalizadas e agentes de suporte que resolvem problemas dos clientes.

- Jogos:personagens não jogáveis (NPCs) interativos, assistentes de ajuda no jogo e tradução em tempo real do conteúdo do jogo.

- Interfaces de última geração:experiências ativadas por voz e vídeo em robótica, óculos inteligentes e veículos.

- Saúde:assistentes de saúde para suporte e educação de pacientes.

- Serviços financeiros:consultores de IA para gestão de patrimônio e orientação de investimentos.

- Educação:mentores e acompanhantes de aprendizado com IA que oferecem instruções e feedback personalizados.

Principais recursos

A API Gemini Live oferece um conjunto abrangente de recursos para criar agentes de voz e vídeo robustos:

- Alta qualidade de áudio: a API Gemini Live oferece fala natural e realista em vários idiomas.

- Suporte multilíngue: converse em 24 idiomas disponíveis.

- Interrupção: os usuários podem interromper o modelo a qualquer momento para interações responsivas.

- Diálogo afetivo: adapta o estilo e o tom da resposta para corresponder à expressão da entrada do usuário.

- Uso de ferramentas: integra ferramentas como chamada de função e Pesquisa Google para interações dinâmicas.

- Transcrição de áudio: fornece transcrições de texto da entrada do usuário e da saída do modelo.

- Áudio proativo: (prévia) Permite controlar quando e em quais contextos o modelo responde.

Especificações técnicas

A tabela a seguir descreve as especificações técnicas da API Gemini Live:

| Categoria | Detalhes |

|---|---|

| Modalidades de entrada | Áudio (áudio PCM bruto de 16 bits, 16 kHz, little-endian), imagens/vídeo (JPEG 1FPS), texto |

| Modalidades de saída | Áudio (áudio PCM bruto de 16 bits, 24 kHz, little endian), texto |

| Protocolo | Conexão WebSocket com estado (WSS) |

Modelos compatíveis

Os seguintes modelos são compatíveis com a API Gemini Live. Selecione o modelo adequado com base nos seus requisitos de interação.

| ID do modelo | Disponibilidade | Caso de uso | Principais recursos |

|---|---|---|---|

gemini-live-2.5-flash-native-audio |

Disponibilidade geral | Recomendado. Agentes de voz de baixa latência. Oferece suporte a troca multilíngue e tom emocional sem problemas. |

|

gemini-live-2.5-flash-preview-native-audio-09-2025 |

Pré-lançamento público | Custo-benefício em agentes de voz em tempo real. |

|

Primeiros passos

Selecione o guia que corresponde ao seu ambiente de desenvolvimento:

Tutorial do SDK de IA generativa

Conecte-se à API Gemini Live usando o SDK da IA generativa para criar um aplicativo multimodal em tempo real com um back-end em Python.

Tutorial do WebSocket

Conecte-se à API Gemini Live usando WebSockets para criar um aplicativo multimodal em tempo real com um front-end JavaScript e um back-end Python.

Tutorial do ADK

Crie um agente e use o ADK Streaming para ativar a comunicação por voz e vídeo.

Integrações com parceiros

Se você quiser fazer a integração com alguns dos nossos parceiros, essas plataformas já integraram a API Gemini Live ao protocolo WebRTC para simplificar o desenvolvimento de aplicativos de áudio e vídeo em tempo real.