En este documento se describen las funciones y configuraciones de ancho de banda de red de las instancias de Compute Engine con GPUs conectadas. Consulta información sobre el ancho de banda de red máximo, las configuraciones de tarjetas de interfaz de red (NIC) y las configuraciones de red VPC recomendadas para varios tipos de máquinas con GPU, incluidas las series A4X Max, A4X, A4, A3, A2, G4, G2 y N1. Conocer estas configuraciones puede ayudarte a optimizar el rendimiento de tus cargas de trabajo distribuidas en Compute Engine.

El ancho de banda de red máximo disponible para las instancias de computación con GPUs conectadas es el siguiente:

- A4X Max (superchips NVIDIA GB300 Ultra): hasta 3600 Gbps

- A4X (superchips NVIDIA GB200): hasta 2000 Gbps

- A4 (NVIDIA B200): hasta 3600 Gbps

- A3 Ultra (NVIDIA H200): hasta 3600 Gbps

- A3 Mega (NVIDIA H100): hasta 1600 Gbps

- A3 High (NVIDIA H100): hasta 1000 Gbps

- A3 Edge (NVIDIA H100): hasta 800 Gbps

- G4 (NVIDIA RTX PRO 6000): hasta 400 Gbps

- A2 (NVIDIA A100) y G2 (NVIDIA L4): hasta 100 Gbps

- N1 con GPUs NVIDIA T4 o V100: hasta 100 Gbps en función de la combinación de GPU y número de vCPUs

- N1 con GPUs NVIDIA P100 o P4: 32 Gbps

Revisar el ancho de banda de la red y la disposición de las NICs

En la siguiente sección se describe la configuración de red y la velocidad del ancho de banda de cada tipo de máquina con GPU.

Tipos de máquinas A4X Max y A4X

Las series de máquinas A4X Max y A4X, ambas basadas en la arquitectura NVIDIA Blackwell, se han diseñado para cargas de trabajo de IA distribuidas, exigentes y a gran escala. La principal diferencia entre ambos es el hardware de redes y los aceleradores que tienen asociados, tal como se indica en la siguiente tabla:

| Serie de máquinas A4X Max | Serie de máquinas A4X | |

|---|---|---|

| Hardware conectado | Superchips NVIDIA GB300 Ultra | Superchips NVIDIA GB200 |

| Redes de GPU a GPU | 4 SuperNICs NVIDIA ConnectX-8 (CX-8) que proporcionan 3200 Gbps de ancho de banda en una topología alineada de 8 vías | 4 NICs NVIDIA ConnectX-7 (CX-7) que proporcionan 1600 Gbps de ancho de banda en una topología alineada en 4 vías |

| Redes de uso general | 2 NICs inteligentes Titanium que proporcionan un ancho de banda de 400 Gbps | 2 NICs inteligentes Titanium que proporcionan un ancho de banda de 400 Gbps |

| Ancho de banda de red máximo total | 3600 Gbps | 2000 Gbps |

Arquitectura de red de varias capas

Las instancias de computación A4X Max y A4X usan una arquitectura de red jerárquica de varias capas con un diseño alineado con los raíles para optimizar el rendimiento de varios tipos de comunicación. En esta topología, las instancias se conectan a través de varios planos de red independientes, denominados carriles.

- Las instancias A4X Max usan una topología alineada con carriles de 8 vías en la que cada una de las cuatro NICs ConnectX-8 de 800 Gbps se conecta a dos carriles independientes de 400 Gbps.

- Las instancias A4X usan una topología alineada en 4 carriles en la que cada una de las cuatro NICs ConnectX-7 se conecta a un carril independiente.

Las capas de red de estos tipos de máquinas son las siguientes:

Comunicación entre nodos y entre subbloques (NVLink): una estructura NVLink de alta velocidad interconecta las GPUs para ofrecer una comunicación de alto ancho de banda y baja latencia. Esta estructura conecta todas las GPUs de una misma instancia y se extiende por un subbloque, que consta de 18 instancias A4X Max o A4X (un total de 72 GPUs). De esta forma, las 72 GPUs de un subbloque pueden comunicarse como si estuvieran en un único servidor de GPUs a gran escala.

Comunicación entre subbloques (NICs ConnectX con RoCE): para escalar cargas de trabajo más allá de un solo subbloque, estas máquinas usan NICs NVIDIA ConnectX. Estas NICs usan RDMA sobre Ethernet convergente (RoCE) para proporcionar una comunicación de alto ancho de banda y baja latencia entre subbloques, lo que te permite crear clústeres de entrenamiento a gran escala con miles de GPUs.

Redes de uso general (NICs inteligentes Titanium): además de las redes de GPU especializadas, cada instancia tiene dos NICs inteligentes Titanium, que proporcionan un ancho de banda combinado de 400 Gbps para tareas de redes generales. Esto incluye el tráfico de almacenamiento, gestión y conexión a otros servicios de Google Cloud o a Internet público.

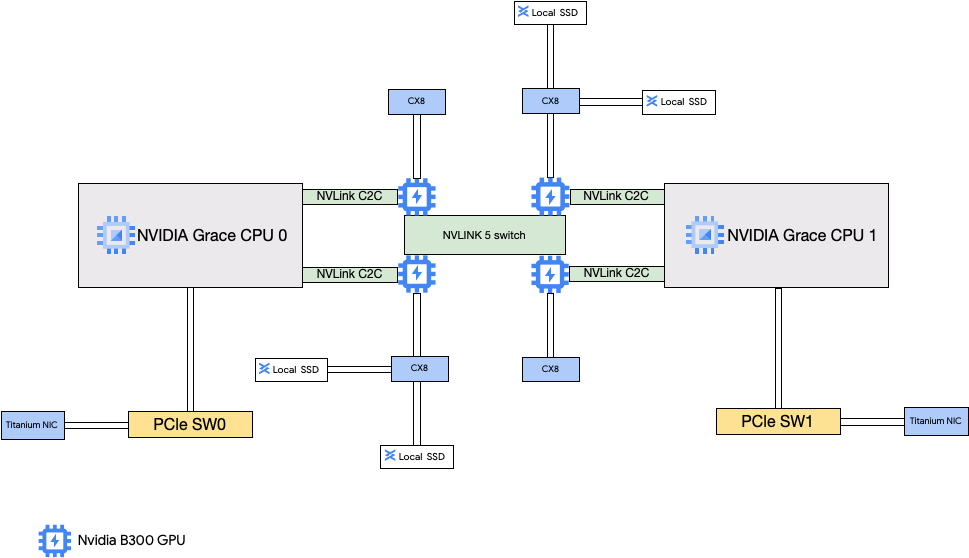

Arquitectura A4X Max

La arquitectura A4X Max se basa en los superchips NVIDIA GB300 Ultra. Una característica clave de este diseño es la conexión directa de las cuatro SuperNICs NVIDIA ConnectX-8 (CX-8) de 800 Gbps a las GPUs. Estas NICs forman parte de una topología de red alineada con rieles de 8 vías en la que cada NIC se conecta a dos rieles de 400 Gbps independientes. Esta ruta directa habilita RDMA, lo que proporciona un ancho de banda alto y una latencia baja para la comunicación entre GPUs de diferentes subbloques. Estas instancias de Compute Engine también incluyen SSDs locales de alto rendimiento que están conectadas a las NICs ConnectX-8, lo que permite omitir el bus PCIe para acceder a los datos más rápido.

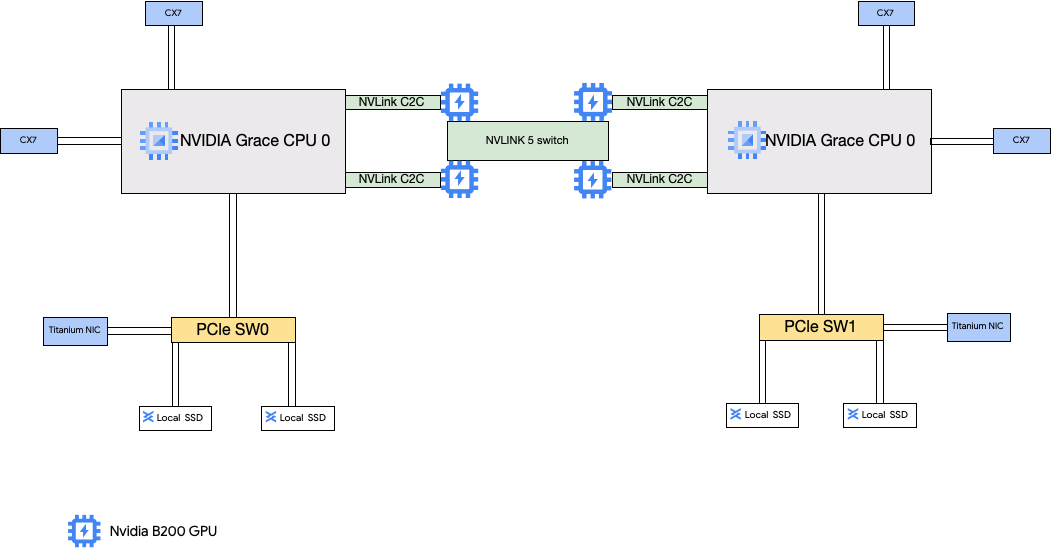

Arquitectura A4X

La arquitectura A4X usa superchips NVIDIA GB200. En esta configuración, las cuatro NICs NVIDIA ConnectX-7 (CX-7) están conectadas a la CPU del host. Esta configuración proporciona una red de alto rendimiento para la comunicación entre GPUs de subbloques.

Configuración de la red de nube privada virtual (VPC) de A4X Max

Para usar todas las funciones de red de estos tipos de máquinas, debes crear redes de VPC y asociarlas a tus instancias. Para usar todas las NICs disponibles, debes crear redes de VPC de la siguiente manera:

Dos redes de VPC normales para las NICs inteligentes Titanium.

- En A4X Max, estas redes VPC usan el controlador de dispositivo PF de LAN IDPF de Intel.

- En el caso de A4X, estas redes de VPC usan la interfaz de red NIC virtual de Google (gVNIC).

Se necesita una red de VPC con el perfil de red RoCE para las NICs ConnectX cuando creas clústeres de varios subbloques A4X Max o A4X. La red de VPC de RoCE debe tener una subred por cada carril de red. Esto significa que hay ocho subredes para las instancias A4X Max y cuatro para las instancias A4X. Si usas un solo subbloque, puedes omitir esta red de VPC porque la estructura NVLink de varios nodos gestiona la comunicación directa entre GPUs.

Para configurar estas redes, consulta el artículo Crear redes de VPC de la documentación de AI Hypercomputer.

Tipos de máquinas A4X Max y A4X

A4X Max

| Superchips NVIDIA GB300 Grace Blackwell Ultra conectados | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memoria de la instancia (GB) | SSD local conectada (GiB) | Número de NICs físicas | Ancho de banda de red máximo (Gbps)2 | Número de GPUs | Memoria de la GPU3 (GB HBM3e) |

a4x-maxgpu-4g-metal |

144 | 960 | 12.000 | 6 | 3600 | 4 | 1116 |

1Una vCPU se implementa como un único hiperhilo de hardware en una de las plataformas de CPU disponibles.

2El ancho de banda de salida máximo no puede superar el número indicado. El ancho de banda de salida real depende de la dirección IP de destino y de otros factores.

Para obtener más información sobre el ancho de banda de red, consulta la sección Ancho de banda de red.

3La memoria de la GPU es la memoria de un dispositivo de GPU que se puede usar para

almacenar datos temporalmente. Es independiente de la memoria de la instancia y se ha diseñado específicamente para gestionar las mayores demandas de ancho de banda de tus cargas de trabajo con un uso intensivo de gráficos.

A4X

| Superchips NVIDIA GB200 Grace Blackwell conectados | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memoria de la instancia (GB) | SSD local conectada (GiB) | Número de NICs físicas | Ancho de banda de red máximo (Gbps)2 | Número de GPUs | Memoria de la GPU3 (GB HBM3e) |

a4x-highgpu-4g |

140 | 884 | 12.000 | 6 | 2000 | 4 | 744 |

1Una vCPU se implementa como un único hiperhilo de hardware en una de las plataformas de CPU disponibles.

2El ancho de banda de salida máximo no puede superar el número indicado. El ancho de banda de salida real depende de la dirección IP de destino y de otros factores.

Para obtener más información sobre el ancho de banda de red, consulta la sección Ancho de banda de red.

3La memoria de la GPU es la memoria de un dispositivo de GPU que se puede usar para

almacenar datos temporalmente. Es independiente de la memoria de la instancia y se ha diseñado específicamente para gestionar las mayores demandas de ancho de banda de tus cargas de trabajo con un uso intensivo de gráficos.

Tipos de máquinas A4 y A3 Ultra

Los tipos de máquinas A4 tienen GPUs NVIDIA B200 conectadas y los tipos de máquinas A3 Ultra tienen GPUs NVIDIA H200 conectadas.

Estos tipos de máquina proporcionan ocho tarjetas de interfaz de red (NICs) NVIDIA ConnectX-7 (CX-7) y dos NICs virtuales de Google (gVNIC). Las ocho NICs CX-7 ofrecen un ancho de banda de red total de 3200 Gbps. Estas NICs están dedicadas únicamente a la comunicación de alto ancho de banda entre GPUs y no se pueden usar para otras necesidades de red, como el acceso público a Internet. Como se indica en el siguiente diagrama, cada NIC CX-7 se alinea con una GPU para optimizar el acceso a memoria no uniforme (NUMA). Las ocho GPUs pueden comunicarse rápidamente entre sí mediante el puente NVLink que las conecta. Las otras dos tarjetas de interfaz de red gVNIC son NICs inteligentes que proporcionan 400 Gbps adicionales de ancho de banda de red para requisitos de redes de uso general. En conjunto, las tarjetas de interfaz de red proporcionan un ancho de banda de red máximo total de 3600 Gbps para estas máquinas.

Para usar estas NICs, debes crear tres redes de nube privada virtual (VPC) de la siguiente manera:

- Dos redes de VPC normales: cada gVNIC debe conectarse a una red de VPC diferente.

- Una red de VPC RoCE: las ocho NICs CX-7 comparten la misma red de VPC RoCE

Para configurar estas redes, consulta el artículo Crear redes de VPC de la documentación de AI Hypercomputer.

A4

| GPUs NVIDIA B200 Blackwell conectadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memoria de la instancia (GB) | SSD local conectada (GiB) | Número de NICs físicas | Ancho de banda de red máximo (Gbps)2 | Número de GPUs | Memoria de la GPU3 (GB HBM3e) |

a4-highgpu-8g |

224 | 3968 | 12.000 | 10 | 3600 | 8 | 1440 |

1Una vCPU se implementa como un único hiperhilo de hardware en una de las plataformas de CPU disponibles.

2El ancho de banda de salida máximo no puede superar el número indicado. El ancho de banda de salida real depende de la dirección IP de destino y de otros factores.

Para obtener más información sobre el ancho de banda de red, consulta la sección Ancho de banda de red.

3La memoria de la GPU es la memoria de un dispositivo de GPU que se puede usar para

almacenar datos temporalmente. Es independiente de la memoria de la instancia y se ha diseñado específicamente para gestionar las mayores demandas de ancho de banda de tus cargas de trabajo con un uso intensivo de gráficos.

A3 Ultra

| GPUs NVIDIA H200 conectadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memoria de la instancia (GB) | SSD local conectada (GiB) | Número de NICs físicas | Ancho de banda de red máximo (Gbps)2 | Número de GPUs | Memoria de la GPU3 (GB HBM3e) |

a3-ultragpu-8g |

224 | 2952 | 12.000 | 10 | 3600 | 8 | 1128 |

1Una vCPU se implementa como un único hiperhilo de hardware en una de las plataformas de CPU disponibles.

2El ancho de banda de salida máximo no puede superar el número indicado. El ancho de banda de salida real depende de la dirección IP de destino y de otros factores.

Para obtener más información sobre el ancho de banda de red, consulta la sección Ancho de banda de red.

3La memoria de la GPU es la memoria de un dispositivo de GPU que se puede usar para

almacenar datos temporalmente. Es independiente de la memoria de la instancia y se ha diseñado específicamente para gestionar las mayores demandas de ancho de banda de tus cargas de trabajo con un uso intensivo de gráficos.

Tipos de máquinas A3 Mega, High y Edge

Estos tipos de máquinas tienen GPUs H100 conectadas. Cada uno de estos tipos de máquinas tiene un número fijo de GPUs y vCPUs, así como un tamaño de memoria.

- Máquinas virtuales A3 con una sola NIC: en las máquinas virtuales A3 con entre 1 y 4 GPUs conectadas, solo hay disponible una tarjeta de interfaz de red (NIC) física.

- Máquinas virtuales A3 con varias NICs: en las máquinas virtuales A3 con 8 GPUs conectadas, hay disponibles varias NICs físicas. En estos tipos de máquinas A3, las NICs se organizan de la siguiente manera en un bus Peripheral Component Interconnect Express (PCIe):

- En el tipo de máquina A3 Mega, se puede usar una configuración de NIC de 8+1. Con esta configuración, 8 NICs comparten el mismo bus PCIe y 1 NIC reside en un bus PCIe independiente.

- En el tipo de máquina A3 High, se puede usar una configuración de NICs de 4+1. Con esta configuración, 4 NICs comparten el mismo bus PCIe y 1 NIC se encuentra en un bus PCIe independiente.

- Para el tipo de máquina A3 Edge: se puede usar una configuración de NIC de 4+1. Con esta configuración, 4 NICs comparten el mismo bus PCIe y 1 NIC se encuentra en un bus PCIe independiente. Estas 5 NICs proporcionan un ancho de banda de red total de 400 Gbps para cada VM.

Las NICs que comparten el mismo bus PCIe tienen una alineación de acceso a memoria no uniforme (NUMA) de una NIC por cada dos GPUs NVIDIA H100. Estas NICs son ideales para la comunicación de alto ancho de banda entre GPUs dedicadas. La NIC física que reside en un bus PCIe independiente es ideal para otras necesidades de redes. Para obtener instrucciones sobre cómo configurar la red de las máquinas virtuales A3 High y A3 Edge, consulta el artículo sobre cómo configurar redes MTU de jumbo frames.

A3 Mega

| GPUs NVIDIA H100 conectadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memoria de la instancia (GB) | SSD local conectada (GiB) | Número de NICs físicas | Ancho de banda de red máximo (Gbps)2 | Número de GPUs | Memoria de la GPU3 (GB HBM3) |

a3-megagpu-8g |

208 | 1872 | 6000 | 9 | 1800 | 8 | 640 |

A3 High

| GPUs NVIDIA H100 conectadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memoria de la instancia (GB) | SSD local conectada (GiB) | Número de NICs físicas | Ancho de banda de red máximo (Gbps)2 | Número de GPUs | Memoria de la GPU3 (GB HBM3) |

a3-highgpu-1g |

26 | 234 | 750 | 1 | 25 | 1 | 80 |

a3-highgpu-2g |

52 | 468 | 1500 | 1 | 50 | 2 | 160 |

a3-highgpu-4g |

104 | 936 | 3000 | 1 | 100 | 4 | 320 |

a3-highgpu-8g |

208 | 1872 | 6000 | 5 | 1000 | 8 | 640 |

A3 Edge

| GPUs NVIDIA H100 conectadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memoria de la instancia (GB) | SSD local conectada (GiB) | Número de NICs físicas | Ancho de banda de red máximo (Gbps)2 | Número de GPUs | Memoria de la GPU3 (GB HBM3) |

a3-edgegpu-8g |

208 | 1872 | 6000 | 5 |

|

8 | 640 |

1Una vCPU se implementa como un único hiperhilo de hardware en una de las plataformas de CPU disponibles.

2El ancho de banda de salida máximo no puede superar el número indicado. El ancho de banda de salida real depende de la dirección IP de destino y de otros factores.

Para obtener más información sobre el ancho de banda de red, consulta la sección Ancho de banda de red.

3La memoria de la GPU es la memoria de un dispositivo de GPU que se puede usar para

almacenar datos temporalmente. Es independiente de la memoria de la instancia y se ha diseñado específicamente para gestionar las mayores demandas de ancho de banda de tus cargas de trabajo con un uso intensivo de gráficos.

Tipos de máquinas A2

Cada tipo de máquina A2 tiene un número fijo de GPUs NVIDIA A100 de 40 GB o NVIDIA A100 de 80 GB conectadas. Cada tipo de máquina también tiene un número de vCPUs y un tamaño de memoria fijos.

La serie de máquinas A2 está disponible en dos tipos:

- A2 Ultra: estos tipos de máquinas tienen GPUs A100 de 80 GB y discos SSD local conectados.

- A2 estándar: estos tipos de máquinas tienen GPUs A100 de 40 GB conectadas.

A2 Ultra

| GPUs NVIDIA A100 de 80 GB conectadas | ||||||

|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memoria de la instancia (GB) | SSD local conectada (GiB) | Ancho de banda de red máximo (Gbps)2 | Número de GPUs | Memoria de la GPU3 (GB HBM2e) |

a2-ultragpu-1g |

12 | 170 | 375 | 24 | 1 | 80 |

a2-ultragpu-2g |

24 | 340 | 750 | 32 | 2 | 160 |

a2-ultragpu-4g |

48 | 680 | 1500 | 50 | 4 | 320 |

a2-ultragpu-8g |

96 | 1360 | 3000 | 100 | 8 | 640 |

A2 Standard

| GPUs NVIDIA A100 de 40 GB conectadas | ||||||

|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memoria de la instancia (GB) | SSD local compatible | Ancho de banda de red máximo (Gbps)2 | Número de GPUs | Memoria de la GPU3 (GB HBM2) |

a2-highgpu-1g |

12 | 85 | Sí | 24 | 1 | 40 |

a2-highgpu-2g |

24 | 170 | Sí | 32 | 2 | 80 |

a2-highgpu-4g |

48 | 340 | Sí | 50 | 4 | 160 |

a2-highgpu-8g |

96 | 680 | Sí | 100 | 8 | 320 |

a2-megagpu-16g |

96 | 1360 | Sí | 100 | 16 | 640 |

1Una vCPU se implementa como un único hiperhilo de hardware en una de las plataformas de CPU disponibles.

2El ancho de banda de salida máximo no puede superar el número indicado. El ancho de banda de salida real depende de la dirección IP de destino y de otros factores.

Para obtener más información sobre el ancho de banda de red, consulta la sección Ancho de banda de red.

3La memoria de la GPU es la memoria de un dispositivo de GPU que se puede usar para

almacenar datos temporalmente. Es independiente de la memoria de la instancia y se ha diseñado específicamente para gestionar las mayores demandas de ancho de banda de tus cargas de trabajo con un uso intensivo de gráficos.

Tipos de máquinas G4

Los tipos de máquinas G4 optimizadas para aceleradores

usan

GPUs NVIDIA RTX PRO 6000 Blackwell Server Edition (nvidia-rtx-pro-6000)

y son

adecuados para cargas de trabajo de simulación de NVIDIA Omniverse, aplicaciones con un uso intensivo de gráficos, transcodificación de vídeo y escritorios virtuales. Los tipos de máquinas G4 también ofrecen una solución de bajo coste para realizar inferencias de un solo host y ajuste de modelos en comparación con los tipos de máquinas de la serie A.

| GPUs NVIDIA RTX PRO 6000 conectadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memoria de la instancia (GB) | Máximo de SSD Titanium admitido (GiB)2 | Número de NICs físicas | Ancho de banda de red máximo (Gbps)3 | Número de GPUs | Memoria de la GPU4 (GB GDDR7) |

g4-standard-48 |

48 | 180 | 1500 | 1 | 50 | 1 | 96 |

g4-standard-96 |

96 | 360 | 3000 | 1 | 100 | 2 | 192 |

g4-standard-192 |

192 | 720 | 6000 | 1 | 200 | 4 | 384 |

g4-standard-384 |

384 | 1440 | 12.000 | 2 | 400 | 8 | 17. |

1Una vCPU se implementa como un único hiperhilo de hardware en una de las plataformas de CPU disponibles.

2Puedes añadir discos SSD de Titanium al crear una instancia de G4. Para saber el número de discos que puedes conectar, consulta Tipos de máquinas que requieren que elijas un número de discos SSD locales.

3El ancho de banda de salida máximo no puede superar el número indicado. El ancho de banda de salida real depende de la dirección IP de destino y de otros factores.

Consulta Ancho de banda de red.

La memoria de la GPU es la memoria de un dispositivo de GPU que se puede usar para

almacenar datos temporalmente. Es independiente de la memoria de la instancia y se ha diseñado específicamente para gestionar las mayores demandas de ancho de banda de tus cargas de trabajo con un uso intensivo de gráficos.

Tipos de máquinas G2

Los tipos de máquinas G2 optimizadas para aceleradores tienen GPUs NVIDIA L4 conectadas y son ideales para cargas de trabajo de inferencia optimizadas para costes, con un uso intensivo de gráficos y de computación de alto rendimiento.

Cada tipo de máquina G2 también tiene una memoria predeterminada y un intervalo de memoria personalizado. El intervalo de memoria personalizado define la cantidad de memoria que puedes asignar a tu instancia para cada tipo de máquina. También puedes añadir discos SSD locales al crear una instancia G2. Para saber el número de discos que puedes conectar, consulta Tipos de máquinas que requieren que elijas un número de discos SSD locales.

Para que se apliquen las tasas de ancho de banda de red más altas (50 Gbps o más) a la mayoría de las instancias de GPU, te recomendamos que uses la NIC virtual de Google (gVNIC). Para obtener más información sobre cómo crear instancias de GPU que usen gVNIC, consulta Crear instancias de GPU que usen anchos de banda más altos.

| GPUs NVIDIA L4 conectadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memoria de instancia predeterminada (GB) | Intervalo de memoria de instancia personalizada (GB) | SSD local máxima admitida (GiB) | Ancho de banda de red máximo (Gbps)2 | Número de GPUs | Memoria de la GPU3 (GB GDDR6) |

g2-standard-4 |

4 | 16 | De 16 a 32 | 375 | 10 | 1 | 24 |

g2-standard-8 |

8 | 32 | De 32 a 54 | 375 | 16 | 1 | 24 |

g2-standard-12 |

12 | 48 | 48-54 | 375 | 16 | 1 | 24 |

g2-standard-16 |

16 | 64 | De 54 a 64 | 375 | 32 | 1 | 24 |

g2-standard-24 |

24 | 96 | De 96 a 108 | 750 | 32 | 2 | 48 |

g2-standard-32 |

32 | 128 | De 96 a 128 | 375 | 32 | 1 | 24 |

g2-standard-48 |

48 | 192 | De 192 a 216 | 1500 | 50 | 4 | 96 |

g2-standard-96 |

96 | 384 | De 384 a 432 | 3000 | 100 | 8 | 192 |

1Una vCPU se implementa como un único hiperhilo de hardware en una de las plataformas de CPU disponibles.

2El ancho de banda de salida máximo no puede superar el número indicado. El ancho de banda de salida real depende de la dirección IP de destino y de otros factores.

Para obtener más información sobre el ancho de banda de red, consulta la sección Ancho de banda de red.

3La memoria de la GPU es la memoria de un dispositivo de GPU que se puede usar para

almacenar datos temporalmente. Es independiente de la memoria de la instancia y se ha diseñado específicamente para gestionar las mayores demandas de ancho de banda de tus cargas de trabajo con un uso intensivo de gráficos.

Tipos de máquinas N1 con GPU

En el caso de las instancias de máquina virtual (VM) de uso general N1 que tengan GPUs T4 y V100 conectadas, puedes obtener un ancho de banda de red máximo de hasta 100 Gbps, en función de la combinación de GPU y del número de vCPUs. Para el resto de las instancias de GPU N1, consulta la página de resumen.

Consulta la siguiente sección para calcular el ancho de banda de red máximo disponible para tus instancias T4 y V100 en función del modelo de GPU, la vCPU y el número de GPUs.

Menos de 5 vCPUs

En las instancias T4 y V100 que tienen 5 vCPUs o menos, se puede usar un ancho de banda de red máximo de 10 Gbps.

Más de 5 vCPUs

En las instancias T4 y V100 que tienen más de 5 vCPUs, el ancho de banda de red máximo se calcula en función del número de vCPUs y GPUs de esa VM.

Para que se apliquen las tasas de ancho de banda de red más altas (50 Gbps o más) a la mayoría de las instancias de GPU, te recomendamos que uses la NIC virtual de Google (gVNIC). Para obtener más información sobre cómo crear instancias de GPU que usen gVNIC, consulta Crear instancias de GPU que usen anchos de banda más altos.

| Modelo de GPU | Número de GPUs | Cálculo del ancho de banda de red máximo |

|---|---|---|

| NVIDIA V100 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 32) |

|

| 4 | min(vcpu_count * 2, 50) |

|

| 8 | min(vcpu_count * 2, 100) |

|

| NVIDIA T4 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 50) |

|

| 4 | min(vcpu_count * 2, 100) |

Ajustes de MTU y tipos de máquinas con GPU

Para aumentar el rendimiento de la red, defina un valor de unidad de transmisión máxima (MTU) más alto para sus redes VPC. Los valores de MTU más altos aumentan el tamaño de los paquetes y reducen la sobrecarga del encabezado de los paquetes, lo que a su vez incrementa el rendimiento de los datos de la carga útil.

En el caso de los tipos de máquinas con GPU, recomendamos los siguientes ajustes de MTU para tus redes de VPC.

| Tipo de máquina con GPU | MTU recomendada (en bytes) | |

|---|---|---|

| Red de VPC normal | Red VPC de RoCE | |

|

8896 | 8896 |

|

8244 | N/A |

|

8896 | N/A |

Cuando defina el valor de MTU, tenga en cuenta lo siguiente:

- 8192 son dos páginas de 4 KB.

- Se recomienda usar 8244 en las máquinas virtuales A3 Mega, A3 High y A3 Edge para las NICs de GPU que tengan habilitada la división de encabezados.

- Utilice el valor 8896, a menos que se indique lo contrario en la tabla.

Crear máquinas con GPU de gran ancho de banda

Para crear instancias de GPU que usen anchos de banda de red más altos, utiliza uno de los siguientes métodos en función del tipo de máquina:

Para crear instancias A2, G2 y N1 que usen anchos de banda de red más altos, consulta Usar un ancho de banda de red más alto en instancias A2, G2 y N1. Para probar o verificar la velocidad del ancho de banda de estas máquinas, puedes usar la prueba de rendimiento. Para obtener más información, consulta Comprobar el ancho de banda de la red.

Para crear instancias A3 Mega que usen anchos de banda de red más altos, consulta Desplegar un clúster de Slurm A3 Mega para el entrenamiento de aprendizaje automático. Para probar o verificar la velocidad del ancho de banda de estas máquinas, utiliza una prueba de rendimiento siguiendo los pasos que se indican en Comprobar el ancho de banda de la red.

En el caso de las instancias A3 High y A3 Edge que usan anchos de banda de red más altos, consulta Crear una VM A3 con GPUDirect-TCPX habilitado. Para probar o verificar la velocidad del ancho de banda de estas máquinas, puedes usar la prueba de rendimiento. Para obtener más información, consulta Comprobar el ancho de banda de la red.

En el caso de otros tipos de máquinas optimizadas para aceleradores, no es necesario hacer nada para usar un ancho de banda de red mayor. Al crear una instancia tal como se describe en la documentación, ya se usa un ancho de banda de red alto. Para saber cómo crear instancias para otros tipos de máquinas optimizadas para aceleradores, consulta Crear una VM con GPUs conectadas.

Siguientes pasos

- Consulta más información sobre las plataformas de GPU.

- Consulta cómo crear instancias con GPUs vinculadas.

- Consulta información sobre cómo usar un mayor ancho de banda de la red.

- Consulta los precios de las GPUs.