Este documento descreve as capacidades e as configurações da largura de banda da rede para instâncias do Compute Engine com GPUs anexadas. Saiba mais sobre a largura de banda máxima da rede, as disposições da placa de rede (NIC) e as configurações de rede VPC recomendadas para vários tipos de máquinas de GPU, incluindo as séries A4X Max, A4X, A4, A3, A2, G4, G2 e N1. Compreender estas configurações pode ajudar a otimizar o desempenho das suas cargas de trabalho distribuídas no Compute Engine.

A largura de banda máxima da rede disponível para instâncias de computação com GPUs anexadas é a seguinte:

- A4X Max (NVIDIA GB300 Ultra Superchips): até 3600 Gbps

- A4X (NVIDIA GB200 Superchips): até 2000 Gbps

- A4 (NVIDIA B200): até 3600 Gbps

- A3 Ultra (NVIDIA H200): até 3600 Gbps

- A3 Mega (NVIDIA H100): até 1600 Gbps

- A3 High (NVIDIA H100): até 1000 Gbps

- A3 Edge (NVIDIA H100): até 800 Gbps

- G4 (NVIDIA RTX PRO 6000): até 400 Gbps

- A2 (NVIDIA A100) e G2 (NVIDIA L4): até 100 Gbps

- N1 com GPUs NVIDIA T4 ou V100: até 100 Gbps com base na combinação da GPU e do número de vCPUs

- N1 com GPUs NVIDIA P100 ou P4: 32 Gbps

Reveja a largura de banda da rede e a disposição da NIC

Use a secção seguinte para rever a disposição da rede e a velocidade da largura de banda para cada tipo de máquina com GPU.

Tipos de máquinas A4X Max e A4X

As séries de máquinas A4X Max e A4X, ambas baseadas na arquitetura NVIDIA Blackwell, foram concebidas para cargas de trabalho de IA distribuídas e exigentes em grande escala. O principal fator de diferenciação entre os dois é o hardware de rede e os aceleradores anexados, conforme descrito na tabela seguinte:

| Série de máquinas A4X Max | Série de máquinas A4X | |

|---|---|---|

| Hardware ligado | NVIDIA GB300 Ultra Superchips | Superchips NVIDIA GB200 |

| Redes GPU a GPU | 4 NVIDIA ConnectX-8 (CX-8) SuperNICs que oferecem 3200 Gbps de largura de banda numa topologia alinhada com carris de 8 vias | 4 NICs NVIDIA ConnectX-7 (CX-7) que oferecem uma largura de banda de 1600 Gbps numa topologia alinhada em calhas de 4 vias |

| Redes de utilização geral | 2 NICs inteligentes Titanium que oferecem uma largura de banda de 400 Gbps | 2 NICs inteligentes Titanium que oferecem uma largura de banda de 400 Gbps |

| Largura de banda máxima total da rede | 3600 Gbps | 2000 Gbps |

Arquitetura de rede de várias camadas

As instâncias de computação A4X Max e A4X usam uma arquitetura de rede hierárquica de várias camadas com um design alinhado com o carril para otimizar o desempenho de vários tipos de comunicação. Nesta topologia, as instâncias estabelecem ligação em vários planos de rede independentes, denominados rails.

- As instâncias A4X Max usam uma topologia alinhada com carris de 8 vias, em que cada uma das quatro NICs ConnectX-8 de 800 Gbps se liga a dois carris separados de 400 Gbps.

- As instâncias A4X usam uma topologia alinhada com calhas de 4 vias, em que cada uma das quatro NICs ConnectX-7 se liga a uma calha separada.

As camadas de rede para estes tipos de máquinas são as seguintes:

Comunicação intra-nó e intra-subbloco (NVLink): uma interligação de tecido NVLink de alta velocidade interliga GPUs para comunicação de alta largura de banda e baixa latência. Esta estrutura interliga todas as GPUs numa única instância e estende-se por um subbloco, que consiste em 18 instâncias A4X Max ou A4X (um total de 72 GPUs). Isto permite que todas as 72 GPUs num subbloco comuniquem como se estivessem num único servidor de GPU de grande escala.

Comunicação entre subblocos (NICs ConnectX com RoCE): para dimensionar as cargas de trabalho para além de um único subbloco, estas máquinas usam NICs NVIDIA ConnectX. Estas NICs usam RDMA over Converged Ethernet (RoCE) para oferecer comunicação de elevada largura de banda e baixa latência entre subblocos, o que lhe permite criar clusters de preparação em grande escala com milhares de GPUs.

Rede de fins gerais (NICs inteligentes de titânio): além das redes de GPU especializadas, cada instância tem duas NICs inteligentes de titânio, que oferecem uma largura de banda combinada de 400 Gbps para tarefas de rede gerais. Isto inclui tráfego para armazenamento, gestão e ligação a outros serviços ou à Internet pública. Google Cloud

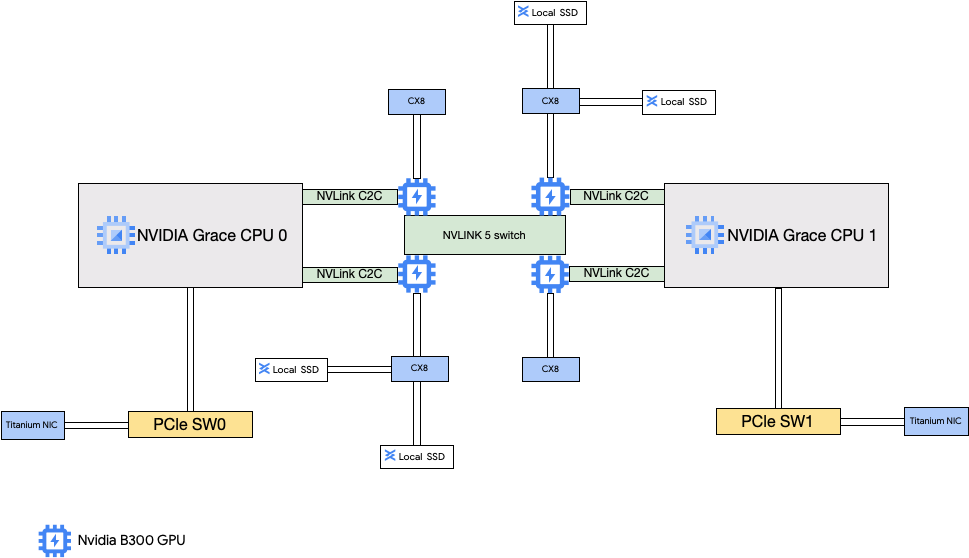

Arquitetura A4X Max

A arquitetura A4X Max é criada com base nos superchips NVIDIA GB300 Ultra. Uma caraterística fundamental deste design é a ligação direta das quatro SuperNICs NVIDIA ConnectX-8 (CX-8) de 800 Gbps às GPUs. Estas NICs fazem parte de uma topologia de rede alinhada de 8 vias, em que cada NIC se liga a 2 vias separadas de 400 Gbps. Este caminho direto ativa o RDMA, oferecendo uma largura de banda elevada e uma latência baixa para a comunicação entre GPUs em diferentes subblocos. Estas instâncias do Compute Engine também incluem SSDs locais de alto desempenho que estão anexados às NICs ConnectX-8, ignorando o barramento PCIe para um acesso mais rápido aos dados.

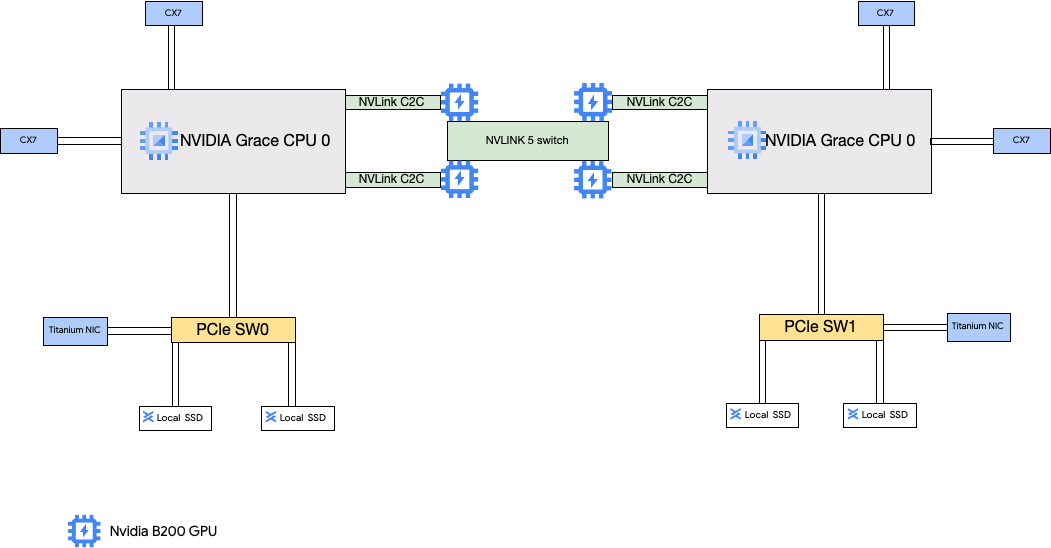

Arquitetura A4X

A arquitetura A4X usa superchips GB200 da NVIDIA. Nesta configuração, as quatro NICs NVIDIA ConnectX-7 (CX-7) estão ligadas à CPU do anfitrião. Esta configuração oferece uma rede de elevado desempenho para a comunicação entre GPUs entre subblocos.

Configuração da rede da nuvem virtual privada (VPC) do A4X Max e do A4X

Para usar as capacidades de rede completas destes tipos de máquinas, tem de criar e anexar redes VPC às suas instâncias. Para usar todas as NICs disponíveis, tem de criar redes VPC da seguinte forma:

Duas redes da VPC normais para as NICs inteligentes Titanium.

- Para o A4X Max, estas redes VPC usam o controlador do dispositivo Intel IDPF LAN PF.

- Para o A4X, estas redes VPC usam a interface de rede Google Virtual NIC (gVNIC).

É necessária uma rede VPC com o perfil de rede RoCE para as NICs ConnectX quando cria clusters de vários subblocos A4X Max ou A4X. A rede de VPC RoCE tem de ter uma sub-rede para cada carril de rede. Isto significa oito sub-redes para instâncias A4X Max e quatro sub-redes para instâncias A4X. Se usar um único subbloco, pode omitir esta rede da VPC porque a estrutura NVLink de vários nós processa a comunicação direta entre GPUs.

Para configurar estas redes, consulte o artigo Crie redes VPC na documentação do AI Hypercomputer.

Tipos de máquinas A4X Max e A4X

A4X Max

| Superchips NVIDIA GB300 Grace Blackwell anexados | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memória da instância (GB) | SSD local associado (GiB) | Contagem de NICs físicas | Largura de banda máxima da rede (Gbps)2 | Número de GPUs | Memória da GPU3 (GB HBM3e) |

a4x-maxgpu-4g-metal |

144 | 960 | 12 000 | 6 | 3600 | 4 | 1116 |

1Uma vCPU é implementada como um único hiperthread de hardware numa das

plataformas de CPU disponíveis.

2A largura de banda de saída máxima não pode exceder o número indicado. A largura de banda de saída real depende do endereço IP de destino e de outros fatores.

Para mais informações sobre a largura de banda da rede,

consulte o artigo Largura de banda da rede.

3A memória da GPU é a memória num dispositivo GPU que pode ser usada para o

armazenamento temporário de dados. É separada da memória da instância e foi

concebida especificamente para processar as exigências de largura de banda mais elevadas das suas cargas de trabalho com utilização intensiva de gráficos.

A4X

| GB200 Grace Blackwell Superchips anexados | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memória da instância (GB) | SSD local associado (GiB) | Contagem de NICs físicas | Largura de banda máxima da rede (Gbps)2 | Número de GPUs | Memória da GPU3 (GB HBM3e) |

a4x-highgpu-4g |

140 | 884 | 12 000 | 6 | 2000 | 4 | 744 |

1Uma vCPU é implementada como um único hiperthread de hardware numa das

plataformas de CPU disponíveis.

2A largura de banda de saída máxima não pode exceder o número indicado. A largura de banda de saída real depende do endereço IP de destino e de outros fatores.

Para mais informações sobre a largura de banda da rede,

consulte o artigo Largura de banda da rede.

3A memória da GPU é a memória num dispositivo GPU que pode ser usada para o

armazenamento temporário de dados. É separada da memória da instância e foi

concebida especificamente para processar as exigências de largura de banda mais elevadas das suas cargas de trabalho com utilização intensiva de gráficos.

Tipos de máquinas A4 e A3 Ultra

Os tipos de máquinas A4 têm GPUs NVIDIA B200 anexadas e os tipos de máquinas A3 Ultra têm GPUs NVIDIA H200 anexadas.

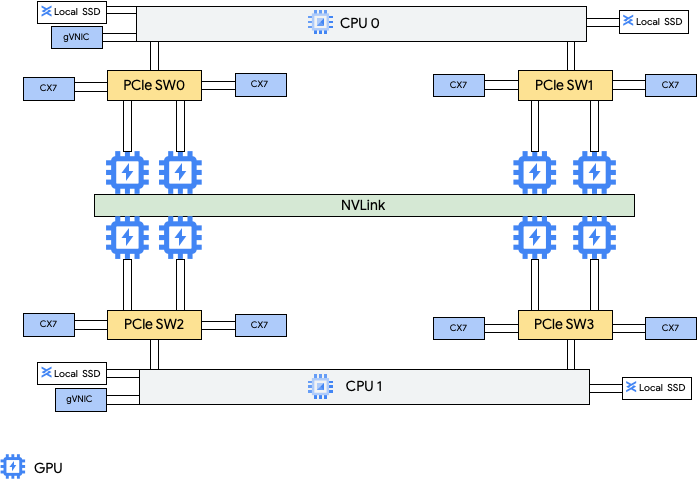

Estes tipos de máquinas oferecem oito placas de interface de rede (NICs) NVIDIA ConnectX-7 (CX-7) e duas NICs virtuais da Google (gVNIC). As oito NICs CX-7 oferecem uma largura de banda de rede total de 3200 Gbps. Estas NICs são dedicadas apenas à comunicação de GPU para GPU de largura de banda elevada e não podem ser usadas para outras necessidades de rede, como o acesso público à Internet. Conforme descrito no diagrama seguinte, cada NIC CX-7 está alinhada com uma GPU para otimizar o acesso à memória não uniforme (NUMA). Todas as oito GPUs podem comunicar rapidamente entre si através da ponte NVLink que as liga. As outras duas placas de rede gVNIC são NICs inteligentes que oferecem 400 Gbps adicionais de largura de banda da rede para requisitos de rede de uso geral. Em conjunto, as placas de interface de rede oferecem uma largura de banda de rede máxima total de 3600 Gbps para estas máquinas.

Para usar estas várias NICs, tem de criar 3 redes da nuvem privada virtual da seguinte forma:

- Duas redes VPC normais: cada gVNIC tem de ser anexada a uma rede VPC diferente

- Uma rede VPC RoCE: todas as oito NICs CX-7 partilham a mesma rede VPC RoCE

Para configurar estas redes, consulte o artigo Crie redes VPC na documentação do AI Hypercomputer.

A4

| GPUs NVIDIA B200 Blackwell anexadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memória da instância (GB) | SSD local associado (GiB) | Contagem de NICs físicas | Largura de banda máxima da rede (Gbps)2 | Número de GPUs | Memória da GPU3 (GB HBM3e) |

a4-highgpu-8g |

224 | 3968 | 12 000 | 10 | 3600 | 8 | 1440 |

1Uma vCPU é implementada como um único hiperthread de hardware numa das

plataformas de CPU disponíveis.

2A largura de banda de saída máxima não pode exceder o número indicado. A largura de banda de saída real depende do endereço IP de destino e de outros fatores.

Para mais informações sobre a largura de banda da rede, consulte o artigo

Largura de banda da rede.

3A memória da GPU é a memória num dispositivo GPU que pode ser usada para o

armazenamento temporário de dados. É separada da memória da instância e foi

concebida especificamente para processar as exigências de largura de banda mais elevadas das suas cargas de trabalho com utilização intensiva de gráficos.

A3 Ultra

| GPUs NVIDIA H200 anexadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memória da instância (GB) | SSD local associado (GiB) | Contagem de NICs físicas | Largura de banda máxima da rede (Gbps)2 | Número de GPUs | Memória da GPU3 (GB HBM3e) |

a3-ultragpu-8g |

224 | 2952 | 12 000 | 10 | 3600 | 8 | 1128 |

1Uma vCPU é implementada como um único hiperthread de hardware numa das

plataformas de CPU disponíveis.

2A largura de banda de saída máxima não pode exceder o número indicado. A largura de banda de saída real depende do endereço IP de destino e de outros fatores.

Para mais informações sobre a largura de banda da rede,

consulte o artigo Largura de banda da rede.

3A memória da GPU é a memória num dispositivo GPU que pode ser usada para o

armazenamento temporário de dados. É separada da memória da instância e foi

concebida especificamente para processar as exigências de largura de banda mais elevadas das suas cargas de trabalho com utilização intensiva de gráficos.

Tipos de máquinas A3 Mega, High e Edge

Estes tipos de máquinas têm GPUs H100 anexadas. Cada um destes tipos de máquinas tem uma quantidade fixa de GPUs, vCPUs e tamanho da memória.

- VMs A3 com uma única NIC: para VMs A3 com 1 a 4 GPUs anexadas, só está disponível uma placa de rede (NIC) física.

- VMs A3 com várias NICs: para VMs A3 com 8 GPUs anexadas, estão disponíveis várias NICs físicas. Para estes tipos de máquinas A3, as NICs estão organizadas da seguinte forma num barramento Peripheral Component Interconnect Express (PCIe):

- Para o tipo de máquina A3 Mega: está disponível uma disposição de NIC de 8+1. Com esta disposição, 8 NICs partilham o mesmo barramento PCIe e 1 NIC reside num barramento PCIe separado.

- Para o tipo de máquina A3 High: está disponível uma disposição de NIC de 4+1. Com esta disposição, 4 NICs partilham o mesmo barramento PCIe e 1 NIC reside num barramento PCIe separado.

- Para o tipo de máquina A3 Edge: está disponível uma disposição de NIC de 4+1. Com esta disposição, 4 NICs partilham o mesmo barramento PCIe e 1 NIC reside num barramento PCIe separado. Estas 5 NICs oferecem uma largura de banda de rede total de 400 Gbps para cada VM.

As NICs que partilham o mesmo barramento PCIe têm um alinhamento de acesso à memória não uniforme (NUMA) de uma NIC por cada duas GPUs NVIDIA H100. Estas NICs são ideais para comunicação GPU a GPU dedicada de elevada largura de banda. A NIC física que reside num barramento PCIe separado é ideal para outras necessidades de rede. Para obter instruções sobre como configurar a rede para VMs A3 High e A3 Edge, consulte o artigo Configure redes MTU de frames jumbo.

A3 Mega

| GPUs NVIDIA H100 anexadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memória da instância (GB) | SSD local associado (GiB) | Contagem de NICs físicas | Largura de banda máxima da rede (Gbps)2 | Número de GPUs | Memória da GPU3 (GB HBM3) |

a3-megagpu-8g |

208 | 1872 | 6000 | 9 | 1800 | 8 | 640 |

A3 High

| GPUs NVIDIA H100 anexadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memória da instância (GB) | SSD local associado (GiB) | Contagem de NICs físicas | Largura de banda máxima da rede (Gbps)2 | Número de GPUs | Memória da GPU3 (GB HBM3) |

a3-highgpu-1g |

26 | 234 | 750 | 1 | 25 | 1 | 80 |

a3-highgpu-2g |

52 | 468 | 1500 | 1 | 50 | 2 | 160 |

a3-highgpu-4g |

104 | 936 | 3000 | 1 | 100 | 4 | 320 |

a3-highgpu-8g |

208 | 1872 | 6000 | 5 | 1000 | 8 | 640 |

A3 Edge

| GPUs NVIDIA H100 anexadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memória da instância (GB) | SSD local associado (GiB) | Contagem de NICs físicas | Largura de banda máxima da rede (Gbps)2 | Número de GPUs | Memória da GPU3 (GB HBM3) |

a3-edgegpu-8g |

208 | 1872 | 6000 | 5 |

|

8 | 640 |

1Uma vCPU é implementada como um único hiperthread de hardware numa das

plataformas de CPU disponíveis.

2A largura de banda de saída máxima não pode exceder o número indicado. A largura de banda de saída real depende do endereço IP de destino e de outros fatores.

Para mais informações sobre a largura de banda da rede,

consulte o artigo Largura de banda da rede.

3A memória da GPU é a memória num dispositivo GPU que pode ser usada para o

armazenamento temporário de dados. É separada da memória da instância e foi

concebida especificamente para processar as exigências de largura de banda mais elevadas das suas cargas de trabalho com utilização intensiva de gráficos.

Tipos de máquinas A2

Cada tipo de máquina A2 tem um número fixo de GPUs NVIDIA A100 de 40 GB ou NVIDIA A100 de 80 GB anexadas. Cada tipo de máquina também tem uma contagem de vCPU fixa e um tamanho de memória.

As máquinas da série A2 estão disponíveis em dois tipos:

- A2 Ultra: estes tipos de máquinas têm GPUs A100 de 80 GB e discos SSD locais anexados.

- A2 Standard: estes tipos de máquinas têm GPUs A100 de 40 GB anexadas.

A2 Ultra

| GPUs NVIDIA A100 de 80 GB anexadas | ||||||

|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memória da instância (GB) | SSD local associado (GiB) | Largura de banda máxima da rede (Gbps)2 | Número de GPUs | Memória GPU3 (GB HBM2e) |

a2-ultragpu-1g |

12 | 170 | 375 | 24 | 1 | 80 |

a2-ultragpu-2g |

24 | 340 | 750 | 32 | 2 | 160 |

a2-ultragpu-4g |

48 | 680 | 1500 | 50 | 4 | 320 |

a2-ultragpu-8g |

96 | 1360 | 3000 | 100 | 8 | 640 |

A2 Standard

| GPUs NVIDIA A100 de 40 GB anexadas | ||||||

|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memória da instância (GB) | SSD local suportado | Largura de banda máxima da rede (Gbps)2 | Número de GPUs | Memória da GPU3 (GB HBM2) |

a2-highgpu-1g |

12 | 85 | Sim | 24 | 1 | 40 |

a2-highgpu-2g |

24 | 170 | Sim | 32 | 2 | 80 |

a2-highgpu-4g |

48 | 340 | Sim | 50 | 4 | 160 |

a2-highgpu-8g |

96 | 680 | Sim | 100 | 8 | 320 |

a2-megagpu-16g |

96 | 1360 | Sim | 100 | 16 | 640 |

1Uma vCPU é implementada como um único hiperthread de hardware numa das

plataformas de CPU disponíveis.

2A largura de banda de saída máxima não pode exceder o número indicado. A largura de banda de saída real depende do endereço IP de destino e de outros fatores.

Para mais informações sobre a largura de banda da rede,

consulte o artigo Largura de banda da rede.

3A memória da GPU é a memória num dispositivo GPU que pode ser usada para o

armazenamento temporário de dados. É separada da memória da instância e foi

concebida especificamente para processar as exigências de largura de banda mais elevadas das suas cargas de trabalho com utilização intensiva de gráficos.

Tipos de máquinas G4

Os tipos de máquinas otimizados para aceleradores G4

usam

GPUs NVIDIA RTX PRO 6000 Blackwell Server Edition (nvidia-rtx-pro-6000)

e são

adequados para cargas de trabalho de simulação do NVIDIA Omniverse, aplicações com uso intensivo de gráficos, transcodificação de vídeo e desktops virtuais. Os tipos de máquinas G4 também oferecem uma solução de baixo custo para

realizar a inferência de anfitrião único e o ajuste de modelos em comparação com os tipos de máquinas da série A.

| GPUs NVIDIA RTX PRO 6000 anexadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memória da instância (GB) | SSD Titanium máximo suportado (GiB)2 | Contagem de NICs físicas | Largura de banda máxima da rede (Gbps)3 | Número de GPUs | Memória da GPU4 (GB GDDR7) |

g4-standard-48 |

48 | 180 | 1500 | 1 | 50 | 1 | 96 |

g4-standard-96 |

96 | 360 | 3000 | 1 | 100 | 2 | 192 |

g4-standard-192 |

192 | 720 | 6000 | 1 | 200 | 4 | 384 |

g4-standard-384 |

384 | 1440 | 12 000 | 2 | 400 | 8 | 768 |

1Uma vCPU é implementada como um único hiperthread de hardware numa das

plataformas de CPU disponíveis.

2Pode adicionar discos SSD de titânio quando cria uma instância G4. Para saber o número de discos que pode anexar, consulte o artigo Tipos de máquinas que exigem que escolha um número de discos SSD locais.

3A largura de banda de saída máxima não pode exceder o número indicado. A largura de banda de saída real depende do endereço IP de destino e de outros fatores.

Consulte o artigo Largura de banda da rede.

4A memória da GPU é a memória num dispositivo de GPU que pode ser usada para

armazenamento temporário de dados. É separada da memória da instância e foi

concebida especificamente para processar as exigências de largura de banda mais elevadas das suas cargas de trabalho com utilização intensiva de gráficos.

Tipos de máquinas G2

Os tipos de máquinas G2 otimizados para aceleradores têm GPUs NVIDIA L4 anexadas e são ideais para inferência otimizada em função dos custos, cargas de trabalho de computação de alto desempenho e com utilização intensiva de gráficos.

Cada tipo de máquina G2 também tem uma memória predefinida e um intervalo de memória personalizado. O intervalo de memória personalizado define a quantidade de memória que pode atribuir à sua instância para cada tipo de máquina. Também pode adicionar discos SSD locais quando cria uma instância G2. Para saber o número de discos que pode anexar, consulte o artigo Tipos de máquinas que exigem que escolha um número de discos SSD locais.

Para aplicar as taxas de largura de banda da rede mais elevadas (50 Gbps ou superior) à maioria das instâncias de GPU, recomendamos que use a NIC virtual da Google (gVNIC). Para mais informações sobre como criar instâncias de GPU que usam gVNIC, consulte o artigo Criar instâncias de GPU que usam larguras de banda mais elevadas.

| GPUs NVIDIA L4 anexadas | |||||||

|---|---|---|---|---|---|---|---|

| Tipo de máquina | Número de vCPUs1 | Memória da instância predefinida (GB) | Intervalo de memória da instância personalizado (GB) | Máximo de SSD local suportado (GiB) | Largura de banda máxima da rede (Gbps)2 | Número de GPUs | Memória GPU3 (GB GDDR6) |

g2-standard-4 |

4 | 16 | 16 a 32 | 375 | 10 | 1 | 24 |

g2-standard-8 |

8 | 32 | 32 a 54 | 375 | 16 | 1 | 24 |

g2-standard-12 |

12 | 48 | 48 a 54 | 375 | 16 | 1 | 24 |

g2-standard-16 |

16 | 64 | 54 a 64 | 375 | 32 | 1 | 24 |

g2-standard-24 |

24 | 96 | 96 a 108 | 750 | 32 | 2 | 48 |

g2-standard-32 |

32 | 128 | 96 a 128 | 375 | 32 | 1 | 24 |

g2-standard-48 |

48 | 192 | 192 a 216 | 1500 | 50 | 4 | 96 |

g2-standard-96 |

96 | 384 | 384 a 432 | 3000 | 100 | 8 | 192 |

1Uma vCPU é implementada como um único hiperthread de hardware numa das

plataformas de CPU disponíveis.

2A largura de banda de saída máxima não pode exceder o número indicado. A largura de banda de saída real depende do endereço IP de destino e de outros fatores.

Para mais informações sobre a largura de banda da rede,

consulte o artigo Largura de banda da rede.

3A memória da GPU é a memória num dispositivo GPU que pode ser usada para o

armazenamento temporário de dados. É separada da memória da instância e foi

concebida especificamente para processar as exigências de largura de banda mais elevadas das suas cargas de trabalho com utilização intensiva de gráficos.

Tipos de máquinas N1 + GPU

Para instâncias de máquinas virtuais (VM) de uso geral N1 com GPUs T4 e V100 anexadas, pode obter uma largura de banda de rede máxima de até 100 Gbps, com base na combinação da GPU e da contagem de vCPUs. Para todas as outras instâncias de GPU N1, consulte a vista geral.

Reveja a secção seguinte para calcular a largura de banda máxima da rede disponível para as suas instâncias T4 e V100 com base no modelo de GPU, na vCPU e na quantidade de GPUs.

Menos de 5 vCPUs

Para instâncias T4 e V100 com 5 vCPUs ou menos, está disponível uma largura de banda de rede máxima de 10 Gbps.

Mais de 5 vCPUs

Para instâncias T4 e V100 com mais de 5 vCPUs, a largura de banda máxima da rede é calculada com base no número de vCPUs e GPUs dessa VM.

Para aplicar as taxas de largura de banda da rede mais elevadas (50 Gbps ou superior) à maioria das instâncias de GPU, recomendamos que use a NIC virtual da Google (gVNIC). Para mais informações sobre como criar instâncias de GPU que usam gVNIC, consulte o artigo Criar instâncias de GPU que usam larguras de banda mais elevadas.

| Modelo da GPU | Número de GPUs | Cálculo da largura de banda máxima da rede |

|---|---|---|

| NVIDIA V100 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 32) |

|

| 4 | min(vcpu_count * 2, 50) |

|

| 8 | min(vcpu_count * 2, 100) |

|

| NVIDIA T4 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 50) |

|

| 4 | min(vcpu_count * 2, 100) |

Definições de MTU e tipos de máquinas com GPU

Para aumentar a taxa de transferência da rede, defina um valor da unidade de transmissão máxima (MTU) mais elevado para as suas redes VPC. Os valores de MTU mais elevados aumentam o tamanho dos pacotes e reduzem a sobrecarga do cabeçalho do pacote, o que, por sua vez, aumenta a taxa de transferência de dados de carga útil.

Para tipos de máquinas de GPU, recomendamos as seguintes definições de MTU para as suas redes VPC.

| Tipo de máquina com GPU | MTU recomendado (em bytes) | |

|---|---|---|

| Rede da VPC normal | Rede da VPC RoCE | |

|

8896 | 8896 |

|

8244 | N/A |

|

8896 | N/A |

Quando definir o valor da MTU, tenha em atenção o seguinte:

- 8192 são duas páginas de 4 KB.

- Recomendamos o valor 8244 nas VMs A3 Mega, A3 High e A3 Edge para NICs de GPU com a divisão de cabeçalhos ativada.

- Use um valor de 8896, salvo indicação em contrário na tabela.

Crie máquinas de GPU com largura de banda elevada

Para criar instâncias de GPU que usam larguras de banda de rede mais elevadas, use um dos seguintes métodos com base no tipo de máquina:

Para criar instâncias A2, G2 e N1 que usam larguras de banda de rede mais elevadas, consulte o artigo Use larguras de banda de rede mais elevadas para instâncias A2, G2 e N1. Para testar ou validar a velocidade da largura de banda destas máquinas, pode usar o teste de referência. Para mais informações, consulte o artigo Verificar a largura de banda da rede.

Para criar instâncias A3 Mega que usam larguras de banda de rede mais elevadas, consulte o artigo Implemente um cluster Slurm A3 Mega para a preparação de ML. Para testar ou validar a velocidade da largura de banda destas máquinas, use um teste de referência seguindo os passos em Verificar a largura de banda da rede.

Para instâncias A3 High e A3 Edge que usam larguras de banda de rede mais elevadas, consulte o artigo Crie uma VM A3 com o GPUDirect-TCPX ativado. Para testar ou validar a velocidade da largura de banda destas máquinas, pode usar o teste de referência. Para mais informações, consulte o artigo Verificar a largura de banda da rede.

Para outros tipos de máquinas otimizados para aceleradores, não é necessária nenhuma ação para usar uma largura de banda de rede superior. A criação de uma instância, conforme documentado, já usa uma largura de banda de rede elevada. Para saber como criar instâncias para outros tipos de máquinas otimizados para aceleradores, consulte o artigo Crie uma VM com GPUs anexadas.

O que se segue?

- Saiba mais sobre as plataformas de GPU.

- Saiba como criar instâncias com GPUs anexadas.

- Saiba mais sobre a opção Usar largura de banda de rede mais elevada.

- Saiba mais acerca dos preços das GPUs.