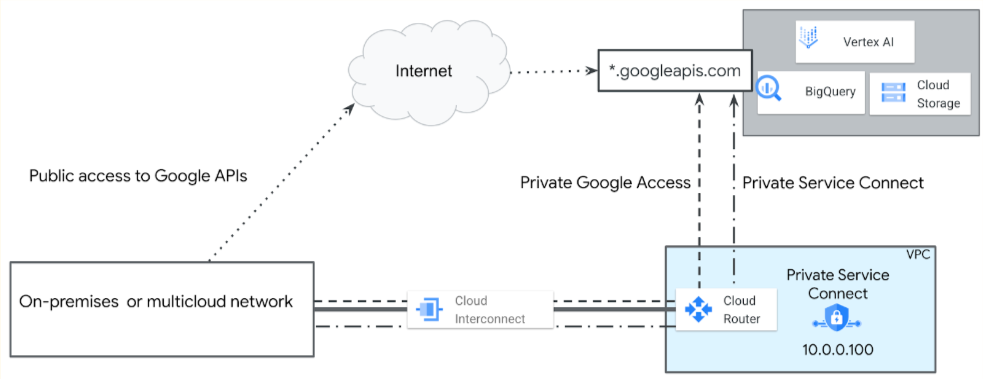

Le tue applicazioni possono connettersi alle API nell'ambiente di produzione di Google da Google Cloud o da reti ibride (on-premise e multicloud). Google Cloud offre le seguenti opzioni di accesso pubblico e privato, che offrono raggiungibilità globale e sicurezza SSL/TLS:

- Accesso a internet pubblico: invia traffico a

REGION-aiplatform.googleapis.com. - Endpoint Private Service Connect per le API di Google: utilizza un indirizzo IP interno definito dall'utente, ad esempio

10.0.0.100, per accedere aREGION-aiplatform.googleapis.como a un nome DNS assegnato, ad esempioaiplatform-genai1.p.googleapis.com.

Il seguente diagramma illustra queste opzioni di accesso.

Alcuni producer di servizi Vertex AI richiedono la connessione ai loro servizi tramite endpoint Private Service Connect o interfacce Private Service Connect. Questi servizi sono elencati nella tabella Opzioni di accesso privato per Vertex AI.

Scelta tra endpoint Vertex AI regionali e globali

L'endpoint regionale Vertex AI

(REGION-aiplatform.googleapis.com) è il modo standard per

accedere alle API di Google. Per le applicazioni di cui è stato eseguito il deployment in più Google Cloud

regioni, ti consigliamo vivamente di utilizzare l'endpoint globale

(aiplatform.googleapis.com) per una chiamata API coerente e una progettazione più solida,

a meno che il modello o la funzionalità che ti interessa non sia disponibile solo a livello regionale. I vantaggi

dell'utilizzo dell'endpoint globale includono:

- Disponibilità di modelli e funzionalità: alcuni dei modelli e delle funzionalità più recenti, specializzati o specifici per regione all'interno di Vertex AI vengono inizialmente o permanentemente offerti solo tramite un endpoint regionale (ad esempio

us-central1-aiplatform.googleapis.com). Se la tua applicazione dipende da una di queste risorse specifiche, devi utilizzare l'endpoint regionale corrispondente alla posizione della risorsa. Questo è il vincolo principale quando determini la tua strategia di endpoint. - Semplificazione della progettazione multiregionale: se un modello supporta l'endpoint globale, il suo utilizzo elimina la necessità che l'applicazione cambi dinamicamente l'endpoint API in base alla regione di deployment corrente. Una singola configurazione statica funziona per tutte le regioni, semplificando notevolmente il deployment, i test e le operazioni.

- Mitigazione della limitazione della frequenza (evitando gli errori

429): per i modelli supportati, il routing delle richieste tramite l'endpoint globale distribuisce il traffico internamente sulla rete di Google al servizio regionale disponibile più vicino. Questa distribuzione può spesso contribuire ad alleviare la congestione localizzata del servizio o gli errori di limite di frequenza regionale (429), sfruttando il backbone di Google per il bilanciamento del carico interno.

Per verificare la disponibilità globale dei modelli partner, consulta la scheda Globale nella tabella Google Cloud Posizioni degli endpoint del modello, che elenca anche le posizioni regionali.

Considerazioni sul VPC condiviso di Vertex AI

L'utilizzo di un VPC condiviso è una Google Cloud best practice per stabilire una governance solida della rete e dell'organizzazione. Questo modello separa le responsabilità designando un progetto host centrale, gestito dagli amministratori della sicurezza di rete, e più progetti di servizio, utilizzati dai team delle applicazioni.

Questa separazione consente agli amministratori di rete di gestire e applicare centralmente la sicurezza di rete (incluse regole firewall, subnet e route) delegando la creazione e la gestione delle risorse (ad esempio VM, cluster GKE e fatturazione) ai progetti di servizio.

Un VPC condiviso sblocca un approccio alla segmentazione multilivello consentendo quanto segue:

- Segmentazione amministrativa e di fatturazione: ogni progetto di servizio (ad esempio "Finance-AI-Project" o "Marketing-AI-Project") ha una propria fatturazione, quote e proprietà delle risorse. In questo modo, un singolo team non può consumare l'intera quota dell'organizzazione e viene fornita un'attribuzione chiara dei costi.

- IAM e segmentazione dell'accesso: puoi applicare autorizzazioni IAM granulari a livello di progetto, ad esempio:

- Al gruppo Google "Finance Users" viene concesso il ruolo/aiplatform.user solo nel progetto "Finance-AI-Project".

- Al gruppo Google "Marketing Users" viene concesso lo stesso ruolo solo nel progetto "Marketing-AI-Project".

- Questa configurazione garantisce che gli utenti del gruppo Finance possano accedere solo agli endpoint, ai modelli e alle risorse Vertex AI associati al proprio progetto. Sono completamente isolati dai carichi di lavoro di AI del team di marketing.

Applicazione a livello di API: l'endpoint API Vertex AI stesso è progettato per applicare questa segmentazione basata sul progetto. Come mostrato nella struttura della chiamata API, l'ID progetto è una parte obbligatoria dell'URI:

https://aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/global/publishers/google/models/${MODEL_ID}:streamGenerateContent

Quando un utente effettua questa chiamata, il sistema verifica che l'identità autenticata disponga delle autorizzazioni IAM necessarie per il ${PROJECT_ID} specifico fornito nell'URL. Se l'utente dispone delle autorizzazioni solo per

"Finance-AI-Project", ma tenta di chiamare l'API utilizzando l'ID

"Marketing-AI-Project", la richiesta verrà negata. Questo approccio fornisce un framework solido e scalabile, garantendo che, man mano che la tua organizzazione adotta l'AI, mantieni una chiara separazione di compiti, costi e limiti di sicurezza.

Accesso a internet pubblico all'API Vertex AI

Se la tua applicazione utilizza un servizio Google elencato nella

tabella dei metodi di accesso supportati per Vertex AI

come internet pubblico,

la tua applicazione può accedere all'API eseguendo una ricerca DNS sull'endpoint del servizio

(REGION-aiplatform.googleapis.com o aiplatform.googleapis.com),

che restituisce

indirizzi IP virtuali instradabili pubblicamente. Puoi utilizzare l'API da

qualsiasi parte del mondo, purché tu disponga di una connessione a internet.

Tuttavia, il traffico inviato dalle risorse Google Cloud a questi indirizzi IP rimane all'interno della rete di Google. Per limitare l'accesso pubblico all'API Vertex AI, sono necessari i Controlli di servizio VPC.

Endpoint Private Service Connect per l'API Vertex AI

Con Private Service Connect, puoi creare endpoint privati

utilizzando indirizzi IP interni globali all'interno della tua rete VPC.

Puoi assegnare nomi DNS a questi indirizzi IP interni con nomi significativi

come aiplatform-genai1.p.googleapis.com e

bigtable-adsteam.p.googleapis.com. Questi nomi e indirizzi IP sono

interni alla tua rete VPC e a qualsiasi rete on-premise

che vi è connessa tramite servizi di rete ibrida.

Puoi controllare il traffico diretto a un determinato endpoint e dimostrare che rimane all'interno di Google Cloud.

- Puoi creare un indirizzo IP endpoint Private Service Connect globale (/32) definito dall'utente. Per saperne di più, consulta Requisiti per gli indirizzi IP.

- Crea l'endpoint Private Service Connect nella stessa rete VPC del router Cloud.

- Puoi assegnare nomi DNS a questi indirizzi IP interni con nomi significativi

come

aiplatform-prodpsc.p.googleapis.com. Per saperne di più, vedi Informazioni sull'accesso alle API di Google tramite endpoint. - In un VPC condiviso, implementa l'endpoint Private Service Connect nel progetto host.

Considerazioni sul deployment

Di seguito sono riportate alcune considerazioni importanti che influiscono sul modo in cui utilizzi l'accesso privato Google e Private Service Connect per accedere all'API Vertex AI.

Accesso privato Google

Come best practice, devi abilitare l'accesso privato Google sulle subnet VPC per consentire alle risorse di calcolo (come le istanze VM di Compute Engine e GKE) che non hanno indirizzi IP esterni di raggiungere Google Cloud servizi e API (come Vertex AI, Cloud Storage e BigQuery).

Pubblicità IP

Devi annunciare l'intervallo di subnet di accesso privato Google o l'indirizzo IP dell'endpoint Private Service Connect agli ambienti on-premise e multicloud da router Cloud come route personalizzata annunciata. Per saperne di più, consulta Pubblicizzare intervalli IP personalizzati.

Regole firewall

Devi assicurarti che la configurazione del firewall degli ambienti on-premise e multicloud consenta il traffico in uscita dagli indirizzi IP delle subnet di accesso privato Google o Private Service Connect.

Configurazione DNS

- La tua rete on-premise deve avere zone e record DNS configurati in modo che

una richiesta a

REGION-aiplatform.googleapis.comoaiplatform.googleapis.comvenga risolta nell'indirizzo IP della subnet di accesso privato Google o dell'endpoint Private Service Connect. - Puoi creare zone private gestite di Cloud DNS e utilizzare una policy del server in entrata di Cloud DNS oppure configurare server dei nomi on-premise. Ad esempio, puoi utilizzare BIND o Microsoft Active Directory DNS.

- Se la tua rete on-premise è connessa a una rete VPC, puoi utilizzare Private Service Connect per accedere alle API e ai servizi Google dagli host on-premise utilizzando l'indirizzo IP interno dell'endpoint. Per saperne di più, vedi Accedere all'endpoint da host on-premise.