Este documento descreve como pode configurar um agente LangGraph ReAct ou um agente de IA generativa criado com a estrutura do Agent Development Kit (ADK) para enviar comandos e respostas multimodais para o seu Google Cloud projeto. Também descreve como pode ver, analisar e avaliar o seu conteúdo multimédia multimodal armazenado:

Use a página Explorador de rastreios para ver comandos ou respostas individuais, ou para ver uma conversa completa. Tem opções para ver o conteúdo multimédia num formato renderizado ou não processado. Para saber mais, consulte o artigo Veja comandos e respostas multimodais.

Use os serviços do BigQuery para analisar os dados multimodais. Por exemplo, pode usar uma função como

AI.GENERATEpara resumir uma conversa. Para saber mais, consulte o artigo Analise os dados de pedidos e respostas através do BigQuery.Use o SDK da Vertex AI para avaliar uma conversa. Por exemplo, pode usar o Google Colaboratory para fazer uma análise de sentimentos. Para saber mais, consulte o artigo Execute avaliações nos dados de comandos e respostas com o Colaboratory.

Tipos de suportes que pode recolher

Pode recolher os seguintes tipos de suportes de dados:

- Áudio.

- Documentos.

- Imagens.

- Texto simples e texto formatado em Markdown.

- Google Video.

Os seus comandos e respostas podem incluir conteúdo inline e links. Os links podem direcionar para recursos públicos ou para contentores do Cloud Storage.

Onde são armazenados os seus comandos e respostas

Quando a sua aplicação com agente cria ou recebe comandos ou respostas, o SDK que a sua aplicação usa invoca a instrumentação do OpenTelemetry. Esta instrumentação formata os comandos e as respostas, bem como os dados multimodais que possam conter, de acordo com a versão 1.37.0 das convenções semânticas da IA gen do OpenTelemetry. As versões superiores também são suportadas.

Em seguida, a instrumentação do OpenTelemetry faz o seguinte:

Cria identificadores de objetos para comandos e dados de respostas e, em seguida, escreve esses dados no seu contentor do Cloud Storage. As entradas no seu contentor do Cloud Storage são guardadas no formato JSON Lines.

Envia dados de registo e rastreio para o seu Google Cloud projeto, onde os serviços de registo e rastreio carregam e armazenam os dados. As convenções semânticas do OpenTelemetry determinam muitos dos atributos e campos anexados às suas entradas de registo ou aos seus intervalos de rastreio.

Quando a instrumentação do OpenTelemetry cria objetos de contentores do Cloud Storage, também escreve uma entrada de registo que contém referências a esses objetos. O exemplo seguinte mostra parte de uma entrada de registo que inclui referências de objetos:

{ ... "labels": { "gen_ai.system": "vertex_ai", "event.name": "gen_ai.client.inference.operation.details", "gen_ai.output.messages_ref": "gs://my-bucket/eso9aP7NA_GX2PgPkrOi-Qg_output.jsonl", "gen_ai.system_instructions_ref": "gs://my-bucket/eso9aP7NA_GX2PgPkrOi-Qg_system_instructions.jsonl", "gen_ai.input.messages_ref": "gs://my-bucket/eso9aP7NA_GX2PgPkrOi-Qg_input.jsonl" }, "logName": "projects/my-project/logs/gen_ai.client.inference.operation.details", "trace": "projects/my-project/traces/963761020fc7713e4590cad89ad03229", "spanId": "1234512345123451", ... }No exemplo de entrada do registo, repare no seguinte:

- A etiqueta

"event.name": "gen_ai.client.inference.operation.details"indica que a entrada de registo contém referências a objetos do Cloud Storage. - As etiquetas cujas chaves incluem

gen_aireferem-se a um objeto num contentor do Cloud Storage. - Todas as entradas de registo que contêm referências de objetos são escritas no mesmo registo, que tem o nome

projects/my-project/logs/gen_ai.client.inference.operation.details.

Para saber como mostrar entradas de registo que contêm referências de objetos, consulte a secção Encontre todas as entradas de registo que fazem referência a comandos e respostas deste documento.

- A etiqueta

Recolha comandos e respostas multimodais

O SDK que a sua aplicação usa invoca automaticamente o OpenTelemetry para armazenar os seus comandos e respostas, e para enviar dados de registo e rastreio para o seu projeto do Google Cloud . Não precisa de modificar a sua aplicação. No entanto, tem de configurar o seu Google Cloud projeto e o SDK que está a usar.

Para recolher e ver os seus comandos e respostas multimodais a partir de uma aplicação, faça o seguinte:

Configure o seu projeto:

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vertex AI, Cloud Storage, Telemetry, Cloud Logging, and Cloud Trace APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. Certifique-se de que tem um contentor do Cloud Storage. Quando necessário, crie um contentor do Cloud Storage.

Recomendamos que faça o seguinte:

Crie o seu contentor do Cloud Storage na mesma localização que o contentor de registos que armazena os dados de registo da sua aplicação. Esta configuração torna as consultas do BigQuery mais eficientes.

Certifique-se de que a classe de armazenamento do seu contentor do Cloud Storage suporta tabelas externas. Esta capacidade permite-lhe consultar os seus comandos e respostas com o BigQuery. Se não planeia usar as predefinições para um novo contentor do Cloud Storage, antes de criar o contentor, reveja Criar tabelas externas do Cloud Storage.

Defina o período de retenção do seu contentor do Cloud Storage para corresponder ao período de retenção do contentor de registos que armazena as suas entradas de registo. O período de retenção predefinido para os dados de registo é de 30 dias. Para saber como definir o período de retenção do seu contentor do Cloud Storage, consulte o artigo Bloqueio de contentores.

Conceda à conta de serviço que a sua aplicação usa a autorização

storage.objects.createno seu contentor do Cloud Storage. Esta autorização permite que a sua aplicação escreva objetos no seu contentor do Cloud Storage. Estes objetos armazenam os comandos e as respostas que a sua aplicação autónoma cria ou recebe. Para mais informações, consulte o artigo Defina e faça a gestão de políticas de IAM em contentores.

-

Configure o SDK:

Instale e atualize as seguintes dependências:

ADK

google-adk>=1.16.0opentelemetry-instrumentation-google-genai>=0.4b0fsspec[gcs]

LangGraph

opentelemetry-instrumentation-vertexai==2.2b0(ou posterior)opentelemetry-instrumentation-google-genai>=0.4b0fsspec[gcs]

Se estiver a usar o ADK, atualize a invocação da sua aplicação para ativar a flag

otel_to_cloud:Se estiver a usar a CLI para o ADK, execute o seguinte comando:

adk web --otel_to_cloud [other options]Caso contrário, transmita a flag quando criar a app FastAPI:

get_fast_api_app(..., otel_to_cloud=True)

Defina as seguintes variáveis de ambiente:

Instrua o OpenTelemetry a formatar objetos do Google Cloud Storage como linhas JSON.

OTEL_INSTRUMENTATION_GENAI_UPLOAD_FORMAT='jsonl'Instrua o OpenTelemetry a carregar dados de comandos e respostas em vez de incorporar este conteúdo em intervalos de rastreio. As referências aos objetos carregados estão incluídas numa entrada de registo.

OTEL_INSTRUMENTATION_GENAI_COMPLETION_HOOK='upload'Instruir o OpenTelemetry para usar as convenções semânticas mais recentes para IA generativa.

OTEL_SEMCONV_STABILITY_OPT_IN='gen_ai_latest_experimental'Especifique o caminho para os objetos:

OTEL_INSTRUMENTATION_GENAI_UPLOAD_BASE_PATH='gs://STORAGE_BUCKET/PATH'Na expressão anterior, STORAGE_BUCKET refere-se ao nome do contentor do Cloud Storage. PATH refere-se ao caminho onde os objetos são armazenados.

Para agentes LangGraph ReAct, instrua o OpenTelemetry a capturar automaticamente dados de registo:

OTEL_PYTHON_LOGGING_AUTO_INSTRUMENTATION_ENABLED='true'

Veja comandos e respostas multimodais

Para determinar os comandos e as respostas a apresentar para um intervalo, o Cloud Trace envia consultas para ler dados de registo e ler dados armazenados num contentor do Cloud Storage. As suas funções de gestão de identidade e de acesso (IAM) nos recursos consultados determinam se os dados são devolvidos. Em alguns casos, pode ver uma mensagem de erro. Por exemplo, se não tiver autorização para ler dados de um contentor do Cloud Storage, as tentativas de aceder a esses dados resultam num erro de autorização recusada.

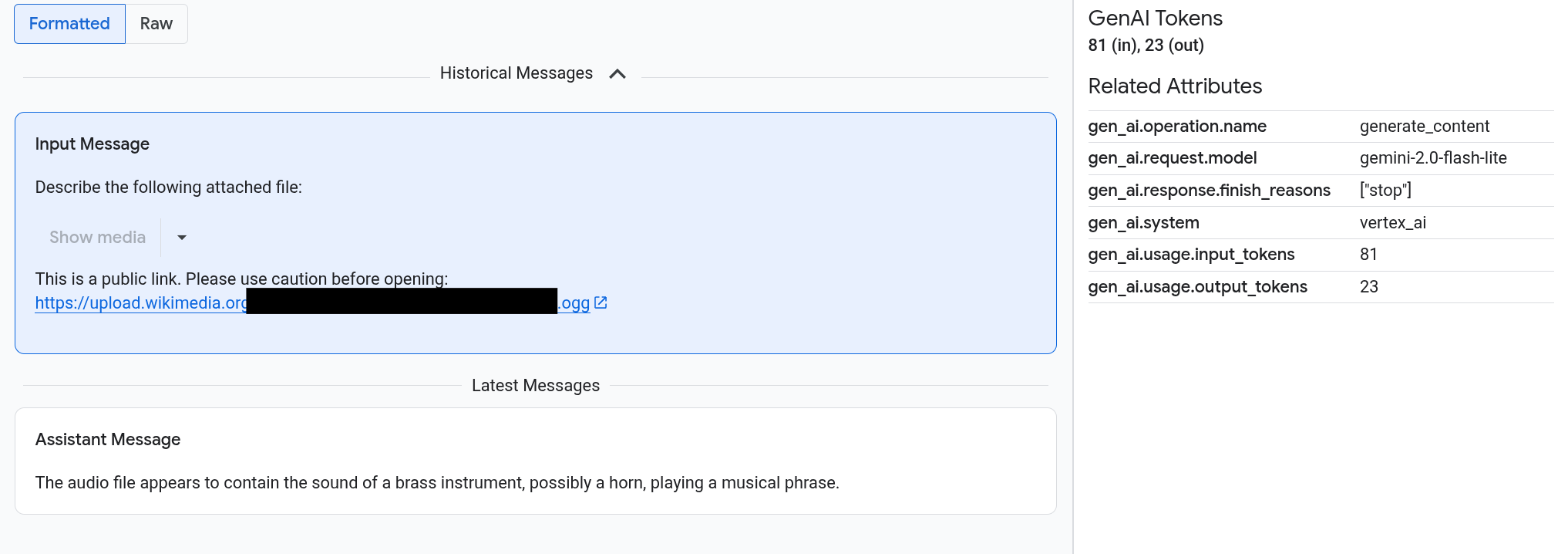

Os comandos e as respostas aparecem num formato semelhante a um chat, e seleciona se as imagens, por exemplo, são renderizadas automaticamente ou aparecem no formato de origem. Da mesma forma, pode ver o histórico completo da conversa ou apenas ver os comandos e as respostas anexados a um intervalo.

Por exemplo, o exemplo seguinte ilustra como os comandos e as respostas são apresentados e como os atributos do OpenTelemetry são resumidos:

Antes de começar

Para receber as autorizações de que precisa para ver os seus comandos e respostas multimodais, peça ao seu administrador que lhe conceda as seguintes funções do IAM no projeto:

-

Utilizador do Cloud Trace (

roles/cloudtrace.user) -

Visualizador de registos (

roles/logging.viewer) -

Visualizador de objetos de armazenamento (

roles/storage.objectViewer)

Para mais informações sobre a atribuição de funções, consulte o artigo Faça a gestão do acesso a projetos, pastas e organizações.

Também pode conseguir as autorizações necessárias através de funções personalizadas ou outras funções predefinidas.

Encontre intervalos que contêm comandos e respostas multimodais

Para encontrar os intervalos que contêm comandos e respostas multimodais, faça o seguinte:

-

Na Google Cloud consola, aceda à página Explorador de rastreios:

Aceda ao Explorador de rastreios

Também pode encontrar esta página através da barra de pesquisa.

No painel Filtro de intervalo, aceda à secção Nome do intervalo e selecione

generate_content.Em alternativa, adicione o filtro

gen_ai.operation.name: generate_content.Selecione um intervalo na lista de intervalos.

É apresentada a página Detalhes do intervalo. Esta página apresenta o intervalo, no contexto do rastreio. Se um nome de intervalo tiver um botão com a etiqueta Entradas/Saídas,

, significa que existem

eventos de IA generativa disponíveis. A secção seguinte, Explore os seus comandos e respostas multimodais, explica como

os dados são apresentados e as opções de visualização.

, significa que existem

eventos de IA generativa disponíveis. A secção seguinte, Explore os seus comandos e respostas multimodais, explica como

os dados são apresentados e as opções de visualização.

Explore os seus comandos e respostas multimodais

O separador Entradas/Saídas contém duas secções.

Uma secção apresenta os comandos e as respostas, e a outra secção apresenta OpenTelemetry: Attributes. Este separador

só é apresentado quando os intervalos enviados para o rastreio

seguem as convenções semânticas de IA gen do OpenTelemetry,

versão 1.37.0 ou superior,

o que resulta em mensagens cujos nomes começam por gen_ai.

O separador Entradas/Saídas mostra as suas mensagens num formato semelhante a um chat. Controla as mensagens apresentadas e o respetivo formato através das opções no separador:

- Para ver a conversa completa, expanda o painel Mensagens anteriores.

- Para ver apenas os comandos e as respostas no intervalo selecionado, use o painel Mensagens mais recentes.

Para ver imagens, vídeos ou outros conteúdos multimédia, selecione Formatado.

O sistema nem sempre mostra conteúdo multimédia. Para sua proteção, se um comando ou uma resposta incluir um link para uma imagem, um documento ou um vídeo público, tem de confirmar que quer que o conteúdo multimédia seja apresentado. Da mesma forma, se um comando ou uma resposta incluir conteúdo multimédia armazenado no seu contentor do Cloud Storage e se o conteúdo multimédia for muito grande, tem de confirmar que quer que o conteúdo multimédia seja apresentado.

Alguns conteúdos multimédia, como imagens e vídeos, são apresentados com um menu anexado. Pode usar este menu para realizar ações como transferir uma imagem para uma unidade local. As opções do menu dependem do tipo de suporte.

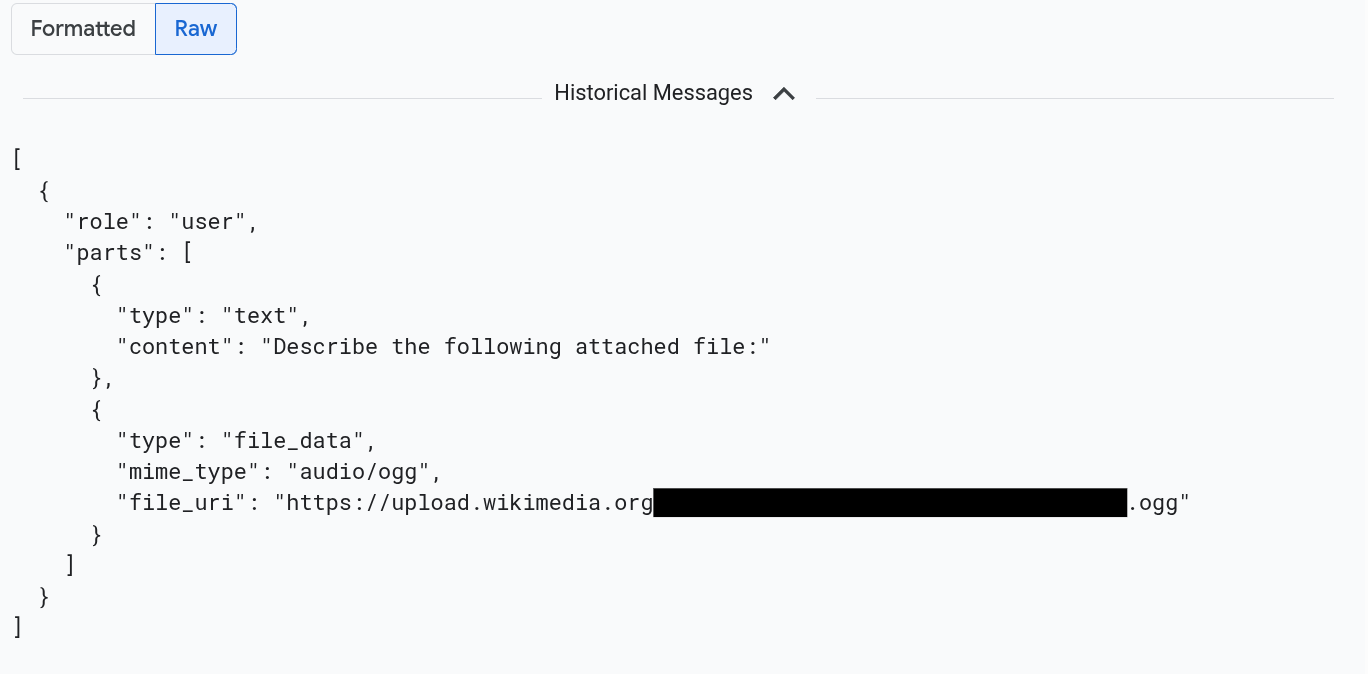

Para ver as mensagens formatadas em JSON, selecione Raw. Com esta seleção, o conteúdo multimédia, como imagens, não é renderizado.

Por exemplo, a imagem seguinte ilustra como uma conversa aparece no formato não processado:

Encontre todas as entradas de registo que fazem referência a comandos e respostas

Para listar as entradas do registo que incluem referências de objetos a comandos e respostas multimodais, faça o seguinte:

-

Na Google Cloud consola, aceda à página Explorador de registos:

Aceda ao Explorador de registos

Se usar a barra de pesquisa para encontrar esta página, selecione o resultado cuja legenda é Registo.

No seletor de projetos, selecione o seu Google Cloud projeto.

Na barra de ferramentas, expanda Todos os nomes de registos, introduza

gen_aino filtro e, de seguida, selecione o registo denominado gen_ai.client.inference.operation.details.Os passos anteriores adicionam a seguinte consulta ao Explorador de registos:

logName="projects/PROJECT_ID/logs/gen_ai.client.inference.operation.details"Se preferir, pode copiar a declaração e colá-la no painel Consulta do Explorador de registos, mas substitua PROJECT_ID pelo ID do seu projeto antes de copiar a declaração.

Também pode filtrar os dados do registo por valor da etiqueta. Por exemplo, se adicionar o filtro seguinte, apenas são apresentadas as entradas do registo que contêm a etiqueta especificada:

labels."event.name"="gen_ai.client.inference.operation.details"Para ver os comandos e as respostas referenciados por uma entrada de registo, na entrada de registo, clique em

Ver detalhes do rastreio.

Para saber como usar as opções no separador Entradas/Saídas, consulte a secção Explore os seus comandos e respostas multimodais deste documento.

Analise dados de pedidos e respostas com o BigQuery

Pode analisar os comandos e as respostas que o seu contentor do Cloud Storage armazena através do BigQuery. Antes de realizar esta análise, conclua os seguintes passos:

- Ative as APIs necessárias e certifique-se de que lhe foram atribuídos os papéis do IAM necessários.

- Crie um conjunto de dados associado no seu contentor de registos.

- Conceda autorização ao BigQuery para ler a partir do seu contentor do Cloud Storage.

- Crie uma tabela externa.

Depois de criar a tabela externa, junta os dados no contentor de registos à tabela externa e realiza a análise nos dados unidos. Esta secção ilustra como juntar as tabelas e extrair campos específicos. Também ilustra como analisar a tabela unida com as funções do BigQuery ML.

Antes de começar

As funções do IAM indicadas nesta secção são necessárias para realizar ações como atualizar um contentor de registos e criar uma tabela externa. No entanto, após a conclusão da configuração, são necessários menos autorizações para executar consultas.

-

Enable the BigQuery and BigQuery Connection APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Para receber as autorizações de que precisa para configurar o sistema de modo a poder ver os seus comandos e respostas multimodais no BigQuery, peça ao seu administrador que lhe conceda as seguintes funções de IAM no projeto:

-

Logs Configuration Writer (

roles/logging.configWriter) -

Administrador de armazenamento (

roles/storage.admin) -

Administrador da ligação do BigQuery (

roles/bigquery.connectionAdmin) -

Visualizador de dados do BigQuery (

roles/bigquery.dataViewer) -

Utilizador do BigQuery Studio (

roles/bigquery.studioUser)

Para mais informações sobre a atribuição de funções, consulte o artigo Faça a gestão do acesso a projetos, pastas e organizações.

Também pode conseguir as autorizações necessárias através de funções personalizadas ou outras funções predefinidas.

-

Logs Configuration Writer (

Crie um conjunto de dados associado no seu contentor de registos

Para determinar se o contentor de registos que armazena os seus dados de registo foi atualizado para o Log Analytics, execute o seguinte comando:

gcloud logging buckets describe LOG_BUCKET_ID --location=LOCATIONSubstitua o seguinte antes de executar o comando:

- LOG_BUCKET_ID: o ID do contentor de registos.

- LOCATION: a localização do contentor de registos.

Quando um contentor de registos é atualizado para o Log Analytics, os resultados do comando

describeincluem a seguinte declaração:analyticsEnabled: trueSe o seu contentor de registos não for atualizado, execute o seguinte comando:

gcloud logging buckets update LOG_BUCKET_ID --location=LOCATION --enable-analytics --asyncA atualização pode demorar vários minutos a ser concluída. Quando o comando

describeindica que olifecycleStateéACTIVE, a atualização está concluída.Para criar um conjunto de dados associado no seu contentor de registos, execute o seguinte comando:

gcloud logging links create LINKED_DATASET_NAME --bucket=LOG_BUCKET_ID --location=LOCATIONSubstitua o seguinte antes de executar o comando:

- LOG_BUCKET_ID: o ID do contentor de registos.

- LOCATION: a localização do contentor de registos.

- LINKED_DATASET_NAME: nome do conjunto de dados associado a criar.

O conjunto de dados associado permite que o BigQuery leia os dados de registo armazenados no seu contentor de registos. Para saber mais, consulte o artigo Consultar um conjunto de dados do BigQuery associado.

Para confirmar que o link existe, execute o seguinte comando:

gcloud logging links list --bucket=LOG_BUCKET_ID --location=LOCATIONQuando for bem-sucedido, a resposta ao comando anterior inclui a seguinte linha:

LINK_ID: LINKED_DATASET_NAME

Conceda autorização ao BigQuery para ler a partir do seu contentor do Cloud Storage

Para criar uma ligação do BigQuery, execute o seguinte comando:

bq mk --connection --location=CONNECTION_LOCATION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_IDSubstitua o seguinte antes de executar o comando:

- PROJECT_ID: o identificador do projeto.

- CONNECTION_ID: o ID da associação a criar.

- CONNECTION_LOCATION: a localização da ligação.

Quando o comando for concluído com êxito, é apresentada uma mensagem semelhante à seguinte:

Connection 151560119848.CONNECTION_LOCATION.CONNECTION_ID successfully createdValide a ligação.

bq show --connection PROJECT_ID.CONNECTION_LOCATION.CONNECTION_IDA resposta a este comando apresenta o ID da associação e uma conta de serviço:

{"serviceAccountId": "bqcx-151560119848-s1pd@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}Conceda à conta de serviço da associação do BigQuery uma função do IAM que lhe permita ler dados armazenados no seu contentor do Cloud Storage:

gcloud storage buckets add-iam-policy-binding gs://STORAGE_BUCKET \ --member=serviceAccount:SERVICE_ACCT_EMAIL \ --role=roles/storage.objectViewerSubstitua o seguinte antes de executar o comando:

- STORAGE_BUCKET: o nome do seu contentor do Cloud Storage.

- SERVICE_ACCT_EMAIL: o endereço de email da sua conta de serviço.

Crie uma tabela externa do BigLake

Para usar o BigQuery para consultar dados que o BigQuery não armazena, crie uma tabela externa. Uma vez que um contentor do Cloud Storage armazena os comandos e as respostas, crie uma tabela externa do BigLake.

-

Na Google Cloud consola, aceda à página BigQuery:

Também pode encontrar esta página através da barra de pesquisa.

No editor de consultas, introduza a seguinte declaração:

CREATE OR REPLACE EXTERNAL TABLE `PROJECT_ID.EXT_TABLE_DATASET_NAME.EXT_TABLE_NAME` ( -- Schema matching the JSON structure in a Cloud Storage bucket. parts ARRAY< STRUCT< type STRING, content STRING, -- multimodal attachments mime_type STRING, uri STRING, data BYTES, -- tool calls id STRING, name STRING, arguments JSON, response JSON > >, role STRING, `index` INT64, ) WITH CONNECTION `PROJECT_ID.CONNECTION_LOCATION.CONNECTION_ID` OPTIONS ( format = 'NEWLINE_DELIMITED_JSON', uris = ['gs://STORAGE_BUCKET/PATH/*'], ignore_unknown_values = TRUE );Substitua o seguinte antes de executar o comando:

- PROJECT_ID: o identificador do projeto.

- EXT_TABLE_DATASET_NAME: o nome do conjunto de dados a criar.

- EXT_TABLE_NAME: o nome da tabela do BigLake externa a criar.

- CONNECTION_LOCATION: a localização do seu CONNECTION_ID.

- CONNECTION_ID: o ID da associação.

- STORAGE_BUCKET: o nome do contentor do Cloud Storage.

- PATH: o caminho para os comandos e as respostas. A

OTEL_INSTRUMENTATION_GENAI_UPLOAD_BASE_PATHvariável de ambiente especifica o caminho.

Clique em Executar.

Para saber mais acerca das tabelas externas, consulte o seguinte:

Junte a tabela externa aos dados de registo

Esta secção ilustra como pode analisar os seus comandos multimodais no BigQuery. A solução baseia-se na junção da sua tabela BigLake externa com os dados de registo, o que lhe permite obter objetos do seu contentor do Cloud Storage. O exemplo junta-se ao URI das mensagens de entrada, gen_ai.input.messages. Também pode juntar-se ao URI das mensagens de saída, gen_ai.output.messages, ou às instruções do sistema, gen_ai.system_instructions.

Para juntar a sua tabela externa do BigLake aos dados de registo, faça o seguinte:

-

Na Google Cloud consola, aceda à página BigQuery:

Também pode encontrar esta página através da barra de pesquisa.

No editor de consultas, introduza a seguinte consulta, que junta os dados de registo e a tabela externa no caminho para as entradas do contentor do Cloud Storage:

-- Query the linked dataset for completion logs. FROM-- Join completion log entries with the external table. |> JOIN `PROJECT_ID.EXT_TABLE_DATASET_NAME.EXT_TABLE_NAME` ON messages_ref_uri = _FILE_NAME |> RENAME `index` AS message_idx -- Flatten. |> CROSS JOIN UNNEST(parts) AS part WITH OFFSET AS part_idx -- Print fields. |> SELECT insert_id, labels, timestamp, trace, span_id, role, part.content, part.uri, part.mime_type, TO_HEX(MD5(part.data)) AS data_md5_hex, part.id AS tool_id, part.name AS tool_name, part.arguments AS tool_args, part.response AS tool_response, message_idx, part_idx, |> ORDER BY timestamp, message_idx, part_idx; |> LIMIT 10;PROJECT_ID.LINKED_DATASET_NAME._AllLogs|> WHERE log_name = 'projects/PROJECT_ID/logs/gen_ai.client.inference.operation.details' AND timestamp > TIMESTAMP_SUB(CURRENT_TIMESTAMP(), INTERVAL 1 DAY) |> SELECT insert_id, timestamp, labels, trace, span_id, STRING(labels['gen_ai.input.messages_ref']) AS messages_ref_uriSubstitua o seguinte antes de executar a consulta:

- PROJECT_ID: o identificador do projeto.

- LINKED_DATASET_NAME: o nome do conjunto de dados associado.

- EXT_TABLE_DATASET_NAME: o nome do conjunto de dados para a tabela BigLake externa.

- EXT_TABLE_NAME: o nome da tabela externa do BigLake.

Opcional: a consulta anterior filtra pelo nome do registo e pela data/hora. Se quiser filtrar também por um ID de rastreio específico, adicione a seguinte declaração à cláusula

WHERE:AND trace = 'projects/PROJECT_ID/traces/TRACE_ID'Na expressão anterior, substitua TRACE_ID pela string hexadecimal de 16 bytes que contém um ID de rastreio.

Use funções do BigQuery ML

Pode usar funções do BigQuery ML, como

AI.GENERATE

nos comandos e nas respostas armazenados no seu contentor do Cloud Storage.

Por exemplo, a seguinte consulta junta as entradas do registo de conclusão com a tabela externa, nivela e filtra o resultado da junção. Em seguida, o comando

é executado AI.GENERATE para analisar se as entradas contêm uma imagem e gerar

um resumo de cada entrada:

-- Query the linked dataset for completion logs.

FROM PROJECT_ID.LINKED_DATASET_NAME._AllLogs

|> WHERE

log_name = 'projects/PROJECT_ID/logs/gen_ai.client.inference.operation.details'

AND timestamp > TIMESTAMP_SUB(CURRENT_TIMESTAMP(), INTERVAL 1 DAY)

|> SELECT

insert_id,

timestamp,

labels,

trace,

span_id,

STRING(labels['gen_ai.input.messages_ref']) AS messages_ref_uri

-- Join completion log entries with the external table.

|> JOIN `PROJECT_ID.EXT_TABLE_DATASET_NAME.EXT_TABLE_NAME`

ON messages_ref_uri = _FILE_NAME

|> RENAME `index` AS message_idx

-- Flatten.

|> CROSS JOIN UNNEST(parts) AS part WITH OFFSET AS part_idx

|> WHERE part.uri IS NOT NULL AND part.uri LIKE 'gs://%'

|> LIMIT 10

-- Use natural language to search for images, and then summarize the entry.

|> EXTEND

AI.GENERATE(

(

'Describe the attachment in one sentence and whether the image contains a diagram.',

OBJ.FETCH_METADATA(OBJ.MAKE_REF(part.uri, 'CONNECTION_LOCATION.CONNECTION_ID'))),

connection_id => 'CONNECTION_LOCATION.CONNECTION_ID',

endpoint => 'gemini-2.5-flash-lite',

output_schema => 'description STRING, is_match BOOLEAN') AS gemini_summary

|> SELECT insert_id, trace, span_id, timestamp, part_idx, part.uri, part.mime_type, gemini_summary

|> WHERE gemini_summary.is_match = TRUE

|> ORDER BY timestamp DESC

Substitua o seguinte antes de executar a consulta:

- PROJECT_ID: o identificador do projeto.

- LINKED_DATASET_NAME: o nome do conjunto de dados associado.

- EXT_TABLE_DATASET_NAME: o nome do conjunto de dados para a tabela BigLake externa.

- EXT_TABLE_NAME: o nome da tabela externa do BigLake.

- CONNECTION_LOCATION: a localização do seu CONNECTION_ID.

- CONNECTION_ID: o ID da associação.

Execute avaliações nos dados de pedidos-respostas com o Colaboratory

Pode avaliar os seus comandos e respostas através do SDK Vertex AI para Python.

Para executar avaliações através de um bloco de notas do Google Colaboratory, faça o seguinte:

Para ver um bloco de notas de exemplo, clique em

evaluating_observability_datasets.ipynb.O GitHub é aberto e apresenta instruções para usar o bloco de notas.

Selecione Abrir no Colab.

O Colaboratory é aberto e apresenta o ficheiro

evaluating_observability_datasets.ipynb.Na barra de ferramentas, clique em Copiar para o Drive.

O Colaboratory cria um bloco de notas de cópia, guarda-o no seu Drive e, em seguida, abre a cópia.

Na sua cópia, aceda à secção intitulada Defina as informações do projeto do Google Cloud e introduza o seu Google Cloud ID do projeto e uma localização suportada pela Vertex AI. Por exemplo, pode definir a localização como

"us-central1".Aceda à secção com o título Carregue conjuntos de dados de IA gen no Google Observability e introduza valores para as seguintes origens:

- INPUT_SOURCE

- OUTPUT_SOURCE

- SYSTEM_SOURCE

Pode encontrar valores para estes campos através das etiquetas

gen_aianexadas às suas entradas de registo. Por exemplo, para INPUT_SOURCE, o valor é semelhante ao seguinte:'gs://STORAGE_BUCKET/PATH/REFERENCE_inputs.jsonl'Na expressão anterior, os campos têm os seguintes significados:

- STORAGE_BUCKET: o nome do contentor do Cloud Storage.

- PATH: o caminho para os comandos e as respostas.

- REFERENCE: o identificador dos dados no seu contentor do Cloud Storage.

Para obter informações sobre como encontrar valores para estas origens, consulte o artigo Encontre todas as entradas de registo que fazem referência a comandos e respostas.

Na barra de ferramentas, clique em Executar tudo.