Choisir des modèles et une infrastructure pour votre application d'IA générative

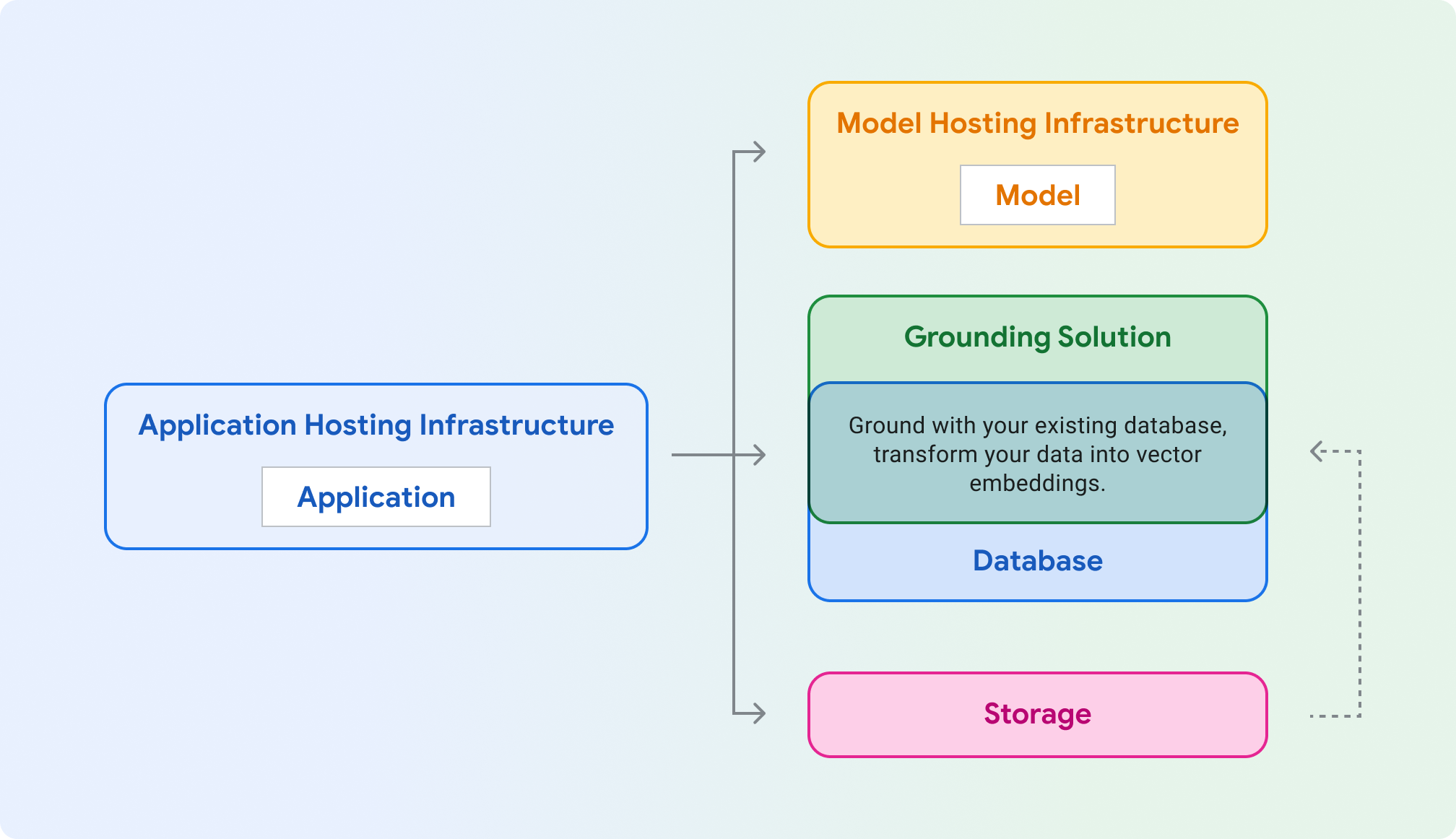

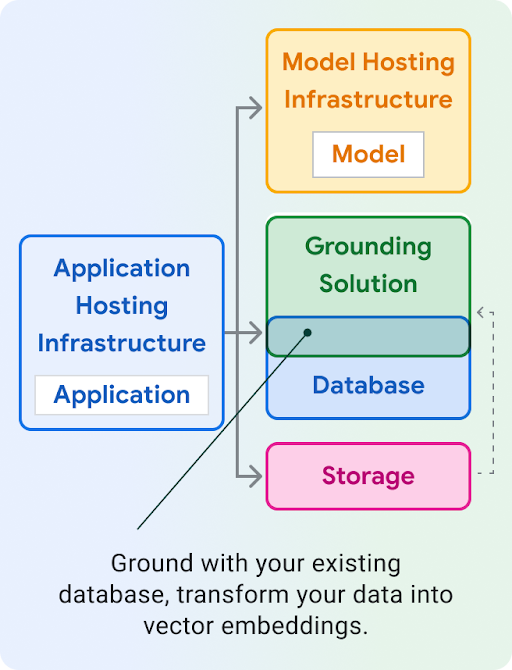

Hébergement d'application : calculez pour héberger votre application. Votre application peut utiliser les bibliothèques clientes et SDK de Google Cloud pour communiquer avec différents produits Cloud.

Hébergement de modèles : hébergement évolutif et sécurisé pour un modèle génératif.

Modèle : modèle génératif pour le texte, le chat, les images, le code, les représentations vectorielles continues et le multimodal.

Solution d'ancrage : ancrez la sortie du modèle sur des sources d'informations vérifiables et mises à jour.

Base de données: stockez les données de votre application. Vous pouvez réutiliser votre base de données existante comme solution d'ancrage, en augmentant les requêtes via une requête SQL et/ou en stockant vos données sous forme d'embeddings à l'aide d'une extension telle que pgvector.

Stockage: stockez des fichiers, tels que des images, des vidéos ou des interfaces Web statiques. Vous pouvez également utiliser le stockage pour les données brutes d'ancrage (par exemple, PDF) que vous convertissez ensuite en embeddings et stockez dans une base de données vectorielle.

Les sections ci-dessous présentent chacun de ces composants et vous aident à choisir les produits Google Cloud à essayer.

Infrastructure d'hébergement d'applications

Choisissez un produit pour héberger et diffuser votre charge de travail d'application, qui appelle le modèle génératif.

Infrastructure d'hébergement de modèles

Google Cloud propose plusieurs solutions pour héberger un modèle génératif, de la plate-forme Vertex AI phare à l'hébergement portable et personnalisable sur Google Kubernetes Engine.

Vous utilisez Gemini et avez besoin de fonctionnalités d'entreprise telles que la mise à l'échelle, la sécurité, la confidentialité des données et l'observabilité.

Vous souhaitez bénéficier d'une infrastructure entièrement gérée, avec des API et des outils d'IA générative de premier ordre ?

Votre modèle nécessite-t-il un noyau spécialisé, un ancien système d'exploitation ou des conditions de licence spéciales ?

Modèle

Google Cloud fournit un ensemble de modèles de fondation de pointe via Vertex AI, y compris Gemini. Vous pouvez également déployer un modèle tiers vers Vertex AI Model Garden ou l'auto-hébergement sur GKE, Cloud Run ou Compute Engine.

Génération d'embeddings pour la recherche, la classification ou le clustering ?

Vous souhaitez générer du texte. Souhaitez-vous inclure des images ou des vidéos dans vos invites de texte ? (Multimode)

D'accord, uniquement des invites textuelles. Vous souhaitez exploiter le modèle phare le plus performant de Google ?

Déployez un modèle Open Source sur : Vertex AI (Model Garden) GKE (HuggingFace)

Ancrage et RAG

Pour garantir des réponses de modèle précises et éclairées, ancrez votre application d'IA générative sur des données en temps réel. C'est ce que l'on appelle la génération augmentée par récupération (RAG).

Si vous souhaitez générer du contenu basé sur des informations à jour provenant d'Internet, les modèles Gemini peuvent évaluer si les connaissances du modèle sont suffisantes ou si un ancrage avec la recherche Google est nécessaire.

Vous pouvez implémenter une mise à la terre à l'aide d'un indice de vos données avec un moteur de recherche. De nombreux moteurs de recherche stockent désormais des représentations vectorielles continues dans une base de données vectorielle, qui est un format optimal pour les opérations telles que la recherche de similarité. Google Cloud propose plusieurs solutions de base de données vectorielle pour différents cas d'utilisation.

Remarque: Vous pouvez baser vos données sur des bases de données non vectorielles en interrogeant une base de données existante telle que Cloud SQL ou Firestore, puis en utilisant le résultat de la requête dans la requête de votre modèle.

Souhaitez-vous une solution optimisée entièrement gérée qui prend en charge la plupart des sources de données et empêche l'accès direct aux représentations vectorielles continues sous-jacentes ?

Voulez-vous créer un moteur de recherche pour le RAG à l'aide d'un orchestrateur géré avec une interface semblable à celle de LlamaIndex ?

Avez-vous besoin d'une recherche vectorielle à faible latence, d'une diffusion à grande échelle ou d'une base de données vectorielle spécialisée et optimisée ?

Vos données sont-elles accessibles de manière automatisée (OLTP) ? Utilisez-vous déjà une base de données SQL ?

Vous souhaitez utiliser les modèles d'IA de Google directement à partir de votre base de données ? Nécessitent-ils une faible latence ?

Vous disposez d'un grand ensemble de données analytiques (OLAP) ? Avez-vous besoin d'un traitement par lot et d'un accès fréquent aux tables SQL par des humains ou des scripts (data science) ?

Ancrage avec les API

Vertex AI Extensions (version bêta privée)

Composants LangChain

Ancrage dans Vertex AI

Démarrer la création

Configurer votre environnement de développement pour Google Cloud

Configurer LangChain

LangChain est un framework Open Source pour les applications d'IA générative qui vous permet d'intégrer du contexte dans vos requêtes et d'agir en fonction de la réponse du modèle.

Afficher des exemples de code et déployer des exemples d'applications

Affichez des exemples de code sélectionnés pour des cas d'utilisation courants et déployez des exemples d'applications d'IA générative sécurisées, efficaces, résilientes, performantes et économiques.