In diesem Dokument werden die Kubernetes-Clusteroptionen und -Funktionen beschrieben, die in Google Distributed Cloud (GDC) mit Air Gap verfügbar sind. Kubernetes-Cluster bieten einen verwalteten Kubernetes-Dienst mit Google Kubernetes Engine (GKE), mit dem Sie Containerarbeitslasten mit Kubernetes-Methoden nach Industriestandard bereitstellen und ausführen können.

Dieses Dokument richtet sich an Zielgruppen wie IT-Administratoren in der Gruppe der Plattformadministratoren und Anwendungsentwickler in der Gruppe der Anwendungsoperatoren, die für die Verwaltung von Containerarbeitslasten in ihrer Organisation verantwortlich sind. Weitere Informationen finden Sie unter Dokumentation zu Zielgruppen für GDC mit Air Gap.

GKE in einer Umgebung ohne Verbindung

GKE on GDC ist ein verwalteter Kubernetes-Dienst, der die wichtigsten Funktionen von GKE in Ihre getrennte Umgebung bringt. In der Dokumentation werden von GKE auf GDC verwaltete Cluster als Kubernetes-Cluster bezeichnet. Weitere Informationen zu Kubernetes-Konzepten finden Sie unter Kubernetes lernen.

Mit GKE on GDC können Sie Containerarbeitslasten in Ihrer getrennten Umgebung erstellen und verwalten, ähnlich wie bei der Verwendung von GKE in der öffentlichen Google Cloud.

In der folgenden Tabelle werden Cluster in GDC und Google Cloudverglichen:

| Feature | Beschreibung | GKE auf GDC | GKE auf Google Cloud |

|---|---|---|---|

| Vollständig getrennt | Kann in einer Umgebung ohne Internetverbindung verwendet werden. | Ja | Nein |

| Sicherungslösung | Dienst zum Erstellen von Kopien von Daten und Konfigurationen für einen Cluster, um den Datenschutz zu gewährleisten und die Wiederherstellung nach Ausfällen, Fehlern oder Cyberangriffen zu ermöglichen. | Backup for GDC | Backup for GKE |

| Integriertes Logging und Monitoring | Dienst, der das Erfassen und Analysieren von Logs mit dem Monitoring von Leistungskennzahlen kombiniert, um einen umfassenden Überblick über das Clusterverhalten zu erhalten. | Prometheus, Grafana und Loki | Cloud Logging und Cloud Monitoring |

| Verwaltete Container Registry | Dienst, der Container-Images hostet und organisiert und die Infrastruktur, Verfügbarkeit und Sicherheit der Images übernimmt. | Managed Harbor Service | Artifact Registry |

| Container-Isolation | Containeranwendungen und ihre Abhängigkeiten können separat und unabhängig voneinander und vom Hostsystem gehalten werden. | Ja | Ja |

| Unterstützung für GPU und TPU | Hochleistungs-Computing-Einheiten, die eine verbesserte Verarbeitung ermöglichen. | Nur GPUs | GPUs und TPUs |

| Horizontales Pod-Autoscaling | Automatische Anpassung der Anzahl der Pod-Replikate in einem Deployment oder einer anderen Arbeitslast basierend auf beobachteten Messwerten wie CPU- oder Arbeitsspeicherauslastung. | Ja | Ja |

| Linux-Container | Isolierte Umgebung zum Ausführen von Anwendungen auf einem Linux-Host. | Ja | Ja |

| Benutzeroberfläche für Cluster | Grafische Benutzeroberfläche, die eine benutzerfreundliche, visuelle Möglichkeit zum Verwalten und Überwachen eines Clusters bietet. | Nur gemeinsamer Cluster | Ja |

| Benutzeroberfläche für Clusterressourcen | Grafische Benutzeroberfläche, die eine benutzerfreundliche, visuelle Möglichkeit bietet, die Containerarbeitslasten eines Clusters zu verwalten und zu überwachen. | Schreibgeschützt | Ja |

Weitere Informationen zu GKE und den in der öffentlichen Google Cloudverfügbaren Funktionen finden Sie unter GKE-Dokumentation.

Vorteile von Kubernetes-Clustern

GKE on GDC bietet wichtige Vorteile für Ihre Kubernetes-Cluster, z. B.:

- Multi-Cluster-Lebenszyklusverwaltung: Stellen Sie mehrere Cluster gleichzeitig in GDC für eine Vielzahl von gehosteten Instanzen für Ihre Containerarbeitslasten bereit.

- Vollständig unterstützte Kubernetes-Distribution: Erstellen Sie Cluster mit aktuellen Standard-Kubernetes-Funktionen.

- Kostentransparenz: Sie können die Nutzung und Statistiken in Echtzeit im Blick behalten und so Ihre Kubernetes-Kosten kontinuierlich überwachen.

- Verwaltung mehrerer Teams: Sie können mehreren Nutzergruppen Zugriff auf Kubernetes-Cluster gewähren, um flexible Verwaltungsgrenzen zu schaffen.

- Automatisierte Kubernetes-Arbeitsabläufe: Mit der automatischen Knotenbereitstellung und dem horizontalen Pod-Autoscaling lassen sich Ihre Containerarbeitslasten nahtlos verwalten.

Alle diese Funktionen sind standardmäßig in GKE auf GDC enthalten und können mit Clustern verwendet werden, die vom verwalteten Kubernetes-Dienst erstellt wurden.

GDC-Clusterarchitektur

Kubernetes-Cluster sind logisch voneinander getrennt, um unterschiedliche Fehlerbereiche und Isolierungsgarantien zu bieten. In einigen Fällen sind sie sogar physisch getrennt.

Sie konfigurieren einen Kubernetes-Cluster entweder als freigegebenen Cluster oder als Standardcluster. Ein freigegebener Cluster erstreckt sich über mehrere Projekte. Ein Standardcluster ist auf ein einzelnes Projekt beschränkt. Weitere Informationen finden Sie unter Kubernetes-Clusterkonfigurationen.

Ein Kubernetes-Cluster besteht aus einer Steuerungsebene und Worker-Maschinen, die als Knoten bezeichnet werden. Die Steuerungsebene und die Knoten bilden das Kubernetes-Cluster-Orchestrierungssystem. GKE on GDC verwaltet die gesamte zugrunde liegende Infrastruktur der Cluster, einschließlich der Steuerungsebene und aller Systemkomponenten. Sie sind für die Verwaltung der Worker-Knoten verantwortlich, auf denen Ihre containerisierten Arbeitslasten ausgeführt werden.

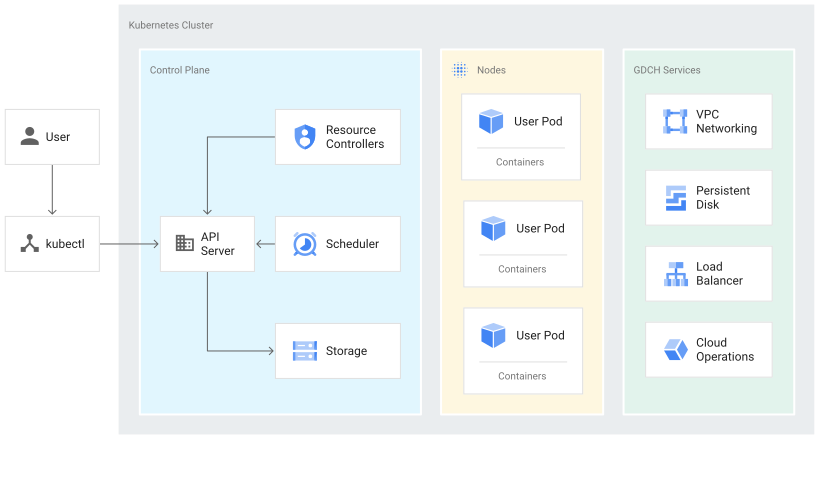

Das folgende Diagramm zeigt die Architektur eines Kubernetes-Clusters:

Dieses Diagramm zeigt einen Kubernetes-Cluster mit den folgenden Komponenten:

- Steuerungsebene, die einen API-Server und vordefinierte Dienste wie Speicher und standardmäßige Pod-Planung umfasst.

- Worker-Knoten, auf denen Containerarbeitslasten ausgeführt werden.

- GDC-Dienste wie VPC-Netzwerke und Load-Balancing, die vom verwalteten Dienst GKE on GDC bereitgestellt werden.

Informationen zur Steuerungsebene

Die Steuerungsebene führt Prozesse wie den Kubernetes API-Server, den Planer und die Kernressourcen-Controller aus. GKE on GDC verwaltet den Lebenszyklus der Steuerungsebene von der Clustererstellung bis zum Löschen. Hierzu gehören Upgrades der Kubernetes-Version, die auf der Steuerungsebene ausgeführt wird. Diese Upgrades werden von GDC entweder automatisch durchgeführt oder von Ihnen manuell gesteuert, falls Sie Upgrades vor dem automatisch geplanten Termin ausführen möchten.

Steuerungsebene und die Kubernetes API

Die Steuerungsebene ist der einheitliche Endpunkt für Ihren Cluster. Sie interagieren mit der Steuerungsebene über Kubernetes API-Aufrufe. Die Steuerungsebene führt den Kubernetes API-Serverprozess (kube-apiserver) zur Verarbeitung von API-Anfragen aus. So können Sie Kubernetes API-Aufrufe ausführen:

- Direkte Anrufe: KRM

- Indirekte Aufrufe: Kubernetes-Befehlszeilenclients wie die kubectl-Befehlszeile oder die GDC-Konsole.

Der API-Serverprozess ist der Hub für sämtliche Kommunikation, die sich an den Cluster richtet. Alle internen Clusterkomponenten wie Knoten, Systemprozesse und Anwendungscontroller fungieren als Clients des API-Servers.

Ihre API-Anfragen teilen Kubernetes mit, was Ihr ausgewählter Status für die Objekte in Ihrem Cluster ist. Kubernetes versucht, diesen Status ständig zu erhalten. Mit Kubernetes können Sie Objekte in der API imperativ oder deklarativ konfigurieren.

Worker-Knoten verwalten

Die Steuerungsebene verwaltet, was auf allen Knoten des Clusters ausgeführt wird. Auf der Steuerungsebene werden Arbeitslasten geplant und der Lebenszyklus, die Skalierung und Upgrades der Arbeitslasten verwaltet. Die Steuerungsebene verwaltet außerdem die Netzwerk- und Speicherressourcen für diese Arbeitslasten. Die Steuerungsebene und die Knoten kommunizieren über Kubernetes-APIs miteinander.

Knoten

Knoten sind die Worker-Maschinen, auf denen Ihre Containeranwendungen und andere Arbeitslasten ausgeführt werden. Die einzelnen Maschinen sind virtuelle Maschinen (VMs), die von GKE auf GDC erstellt werden. Die Steuerungsebene verwaltet und empfängt Aktualisierungen für den selbst gemeldeten Status jedes Knotens.

Ein Knoten führt die Dienste aus, die zur Unterstützung der Container erforderlich sind, aus denen die Arbeitslasten Ihres Clusters bestehen. Hierzu gehören die Laufzeit und der Kubernetes-Knoten-Agent oder das Kubelet, das mit der Steuerungsebene kommuniziert und dafür verantwortlich ist, die auf dem betreffenden Knoten geplanten Container zu starten und auszuführen.

GKE on GDC führt auch eine Reihe von Systemcontainern aus, die als Agenten pro Knoten ausgeführt werden, sogenannte DaemonSets, die Funktionen wie Logerfassung und Netzwerkverbindungen innerhalb des Clusters bereitstellen.

Knoten werden in einem Knotenpool gruppiert. Ein Knotenpool ist eine Gruppe von Knoten in einem Cluster, die dieselbe Konfiguration und dieselben Merkmale haben. Ein einzelner Knoten lässt sich in einem Knotenpool nicht konfigurieren.

Benutzerdefinierte Knotenpools sind nützlich, wenn Sie Pods planen müssen, die mehr Ressourcen benötigen als andere, z. B. mehr Arbeitsspeicher oder lokalen Speicherplatz. Wenn Sie mehr Kontrolle über die Planung von Pods benötigen, können Sie Knotenmarkierungen verwenden.

Weitere Informationen finden Sie unter Knotenpools verwalten.

Kubernetes-Clusterkonfigurationen

Die folgenden Clusterkonfigurationen sind mit dem GKE on GDC-Dienst verfügbar, um Ihre Containerarbeitslasten in einer Organisation zu verwalten:

- Gemeinsamer Cluster: Ein Kubernetes-Cluster mit Organisationsbereich, der sich über mehrere Projekte erstreckt und nicht von einem einzelnen Projekt verwaltet, sondern an diese angehängt wird.

- Standardcluster: Ein Kubernetes-Cluster mit Projektbereich, der Clusterressourcen innerhalb eines Projekts verwaltet und nicht mehrere Projekte umfassen kann.

Sie können den Cluster auswählen, der Ihren Anforderungen für die Verwaltung von Containerarbeitslasten am besten entspricht. Weitere Informationen finden Sie unter Kubernetes-Clusterkonfigurationen.

GPU-Arbeitslasten in einem Cluster

GDC bietet Unterstützung für NVIDIA-GPUs für Kubernetes-Cluster und führt Ihre GPU-Geräte als Nutzerarbeitslasten aus. Beispielsweise möchten Sie möglicherweise Notebooks für künstliche Intelligenz (KI) und maschinelles Lernen (ML) in einer GPU-Umgebung ausführen. Sie müssen Ihren Cluster so konfigurieren, dass er GPU-Geräte unterstützt, indem Sie GPU-Maschinen für ihn bereitstellen. Eine Liste der unterstützten Maschinentypen für Kubernetes-Cluster in GDC finden Sie unter Clusterknotenmaschinen.

GPUs werden statisch zugewiesen. Die ersten vier GPUs sind immer für Arbeitslasten wie vortrainierte KI- und ML-APIs vorgesehen. Diese GPUs werden nicht in einem Kubernetes-Cluster ausgeführt. Die verbleibenden GPUs sind für Kubernetes-Cluster verfügbar. KI- und ML-Notebooks werden auf Kubernetes-Clustern ausgeführt.

Achten Sie darauf, GPU-Maschinen für die richtigen Clustertypen zuzuweisen, damit Komponenten wie KI- und ML-APIs in Ihrem Cluster ausgeführt werden können. Weitere Informationen finden Sie unter Freigegebenen Cluster erstellen oder Standardcluster erstellen.

Einschränkungen für GKE auf GDC

Die folgenden GKE-Funktionen sind Einschränkungen, die für GKE auf GDC nicht verfügbar sind:

- Automatisierte Clusterverwaltung

- Automatische Knotenreparaturen: Die Clusterüberwachung behebt automatisch Probleme mit Knoten, sodass weniger manuelle Eingriffe erforderlich sind.

- Automatische Clusterupgrades: Automatisierte Kubernetes-Versionsupgrades für die Steuerungsebene und die Worker-Knoten eines Clusters, damit der Cluster mit einer unterstützten und sicheren Version ausgeführt wird.

- Cluster-Autoscaling: Automatische Anpassung der Größe eines Clusters durch Hinzufügen oder Entfernen von Knoten basierend auf den Anforderungen der Arbeitslast.

- GKE Autopilot: Ein vollständig verwalteter Betriebsmodus, der die Infrastrukturverwaltung übernimmt.

- Vertikales Pod-Autoscaling: Automatische Anpassung der CPU- und Arbeitsspeicheranfragen und -limits für die Pods eines Clusters basierend auf der bisherigen Nutzung.

- Multi-Cloud

- Multi-Cloud-Cluster anhängen: Sie können Cluster in anderen Cloud-Umgebungen erstellen und über dieGoogle Cloud -Konsole verwalten.

- Connect-Gateway: Sie können mit Ihrer Google Cloud -Identität eine Verbindung zu Clustern anderer Cloud-Anbieter herstellen, um sich zu authentifizieren.

- Multi-Cluster-Ingress: Stellen Sie freigegebene Load-Balancing-Ressourcen clusterübergreifend bereit.

- Vorgänge

- Verwaltung von Ressourcen in mehreren Zonen: Der Cluster und seine Container erstrecken sich als regionale oder globale Ressource über mehrere Zonen.

- Unterstützung für Windows-Container: Isolierte Umgebung zum Ausführen von Anwendungen auf einem Windows-Host.