Questa pagina descrive come attivare la replica in tempo reale dei dati dalle applicazioni SAP a Google Cloud utilizzando SAP Landscape Transformation (SLT). I contenuti si applicano ai plug-in SAP SLT Replication e SAP SLT No RFC Replication, disponibili in Cloud Data Fusion Hub. Mostra le configurazioni per il sistema di origine SAP, SLT, Cloud Storage e Cloud Data Fusion per eseguire le seguenti operazioni:

- Trasferisci i metadati e i dati delle tabelle SAP a Google Cloud utilizzando SAP SLT.

- Crea un job di replica Cloud Data Fusion che legge i dati da un bucket Cloud Storage.

La replica SAP SLT ti consente di replicare i tuoi dati in modo continuo e in tempo reale dalle origini SAP in BigQuery. Puoi configurare ed eseguire trasferimenti di dati dai sistemi SAP senza programmazione.

Il processo di replica SLT di Cloud Data Fusion è il seguente:

- I dati provengono da un sistema di origine SAP.

- SLT monitora e legge i dati e li invia a Cloud Storage.

- Cloud Data Fusion estrae i dati dal bucket di archiviazione e li scrive in BigQuery.

Puoi trasferire i dati dai sistemi SAP supportati, inclusi quelli ospitati in Google Cloud.

Per ulteriori informazioni, consulta la panoramica di SAP su Google Cloud e i dettagli dell'assistenza.

Prima di iniziare

Per utilizzare questo plug-in, devi avere conoscenze di dominio nelle seguenti aree:

- Creazione di pipeline in Cloud Data Fusion

- Gestione dell'accesso con IAM

- Configurazione di sistemi ERP (Enterprise Resource Planning) on-premise e SAP Cloud

Amministratori e utenti che eseguono le configurazioni

Le attività in questa pagina vengono eseguite da persone con i seguenti ruoli in Google Cloud o nel sistema SAP:

| Tipo di utente | Descrizione |

|---|---|

| Amministratore Google Cloud | Gli utenti a cui è assegnato questo ruolo sono amministratori degli account Google Cloud. |

| Utente Cloud Data Fusion | Gli utenti a cui è assegnato questo ruolo sono autorizzati a progettare ed eseguire

pipeline di dati. Devono disporre almeno del ruolo Visualizzatore Data Fusion

(

roles/datafusion.viewer). Se utilizzi

il controllo degli accessi basato sui ruoli, potresti avere bisogno di

altri

ruoli.

|

| Amministratore SAP | Gli utenti a cui è assegnato questo ruolo sono amministratori del sistema SAP. Hanno accesso per scaricare il software dal sito del servizio SAP. Non è un ruolo IAM. |

| Utente SAP | Gli utenti a cui è assegnato questo ruolo sono autorizzati a connettersi a un sistema SAP. Non è un ruolo IAM. |

Operazioni di replica supportate

Il plug-in SAP SLT Replication supporta le seguenti operazioni:

Modellazione dei dati: tutte le operazioni di modellazione dei dati (record insert, delete e

update) sono supportate da questo plug-in.

Definizione dei dati: come descritto nella nota SAP 2055599 (per la visualizzazione è richiesto l'accesso all'assistenza SAP), esistono limitazioni in merito alle modifiche alla struttura della tabella del sistema di origine replicate automaticamente da SLT. Alcune operazioni di definizione dei dati non sono supportate nel plug-in (devi propagarle manualmente).

- Supportato:

- Aggiungi un campo non chiave (dopo aver apportato le modifiche in SE11, attiva la tabella utilizzando SE14)

- Non supportato:

- Aggiungi/elimina campo chiave

- Elimina campo non chiave

- Modificare i tipi di dati

Requisiti SAP

Nel sistema SAP sono necessari i seguenti elementi:

- Hai installato SLT Server versione 2011 SP17 o successive nel sistema SAP di origine (incorporato) o come sistema hub SLT dedicato.

- Il sistema SAP di origine è SAP ECC o SAP S/4HANA, che supporta DMIS 2011 SP17 o versioni successive, come DMIS 2018, DMIS 2020.

- Il tuo componente aggiuntivo dell'interfaccia utente SAP deve essere compatibile con la tua versione di SAP Netweaver.

Il tuo pacchetto di assistenza supporta la classe

/UI2/CL_JSONPL 12o versioni successive. In caso contrario, implementa l'ultima nota SAP per la classe/UI2/CL_JSONcorrectionsin base alla versione del componente aggiuntivo dell'interfaccia utente, ad esempio la nota SAP 2798102 perPL12.Sono in vigore le seguenti misure di sicurezza:

Requisiti di Cloud Data Fusion

- Hai bisogno di un'istanza Cloud Data Fusion, versione 6.4.0 o successive, di qualsiasi edizione.

- Al account di servizio assegnato all'istanza Cloud Data Fusion vengono concessi i ruoli richiesti (vedi Concessione dell'autorizzazione utente del account di servizio account).

- Per le istanze Cloud Data Fusion private, è necessario il peering VPC.

Requisiti perGoogle Cloud

- Attiva l'API Cloud Storage nel tuo progetto Google Cloud .

- All'utente Cloud Data Fusion deve essere concessa l'autorizzazione per creare cartelle nel bucket Cloud Storage (vedi Ruoli IAM per Cloud Storage).

- (Facoltativo) Imposta i criteri di conservazione, se richiesto dalla tua organizzazione.

Crea il bucket di archiviazione

Prima di creare un job di replica SLT,crea il bucket Cloud Storage. Il job trasferisce i dati nel bucket e aggiorna il bucket di staging ogni cinque minuti. Quando esegui il job, Cloud Data Fusion legge i dati nel bucket di archiviazione e li scrive in BigQuery.

Se SLT è installato su Google Cloud

Il server SLT deve disporre dell'autorizzazione per creare e modificare oggetti Cloud Storage nel bucket che hai creato.

Come minimo, concedi i seguenti ruoli al account di servizio:

- Creatore token service account (

roles/iam.serviceAccountTokenCreator) - Consumer utilizzo dei servizi (

roles/serviceusage.serviceUsageConsumer) - Storage Object Admin (

roles/storage.objectAdmin)

Se SLT non è installato su Google Cloud

Installa Cloud VPN o Cloud Interconnect tra la VM SAP e Google Cloud per consentire la connessione a un endpoint di metadati interno (vedi Configurazione dell'accesso privato Google per gli host on-premise.

Se non è possibile mappare i metadati interni:

Installa Google Cloud CLI in base al sistema operativo dell'infrastruttura su cui è in esecuzione SLT.

Crea un account di servizio nel progetto Google Cloud in cui è abilitato Cloud Storage.

Sul sistema operativo SLT, autorizza l'accesso a Google Cloud con un service account.

Crea una chiave API per il account di servizio e autorizza l'ambito correlato a Cloud Storage.

Importa la chiave API in gcloud CLI installata in precedenza utilizzando l'interfaccia a riga di comando.

Per abilitare il comando gcloud CLI che stampa il token di accesso, configura il comando del sistema operativo SAP nello strumento di transazione SM69 nel sistema SLT.

Stampa di un token di accesso

L'amministratore SAP configura il comando del sistema operativo SM69, che

recupera un token di accesso da Google Cloud.

Crea uno script per stampare un token di accesso e configura un comando del sistema operativo SAP per chiamare lo script come utente <sid>adm dall'host SAP LT Replication Server.

Linux

Per creare un comando del sistema operativo:

Sull'host SAP LT Replication Server, in una directory accessibile a

<sid>adm, crea uno script bash che contenga le seguenti righe:PATH_TO_GCLOUD_CLI/bin/gcloud auth print-access-token SERVICE_ACCOUNT_NAMEUtilizzando l'interfaccia utente SAP, crea un comando del sistema operativo esterno:

- Inserisci la transazione

SM69. - Fai clic su Crea.

- Nella sezione Comando del riquadro Comando esterno, inserisci

il nome del comando, ad esempio

ZGOOGLE_CDF_TOKEN. Nella sezione Definizione:

- Nel campo Comando del sistema operativo, inserisci

shcome estensione del file di script. Nel campo Parametri per il comando del sistema operativo, inserisci:

/PATH_TO_SCRIPT/FILE_NAME.sh

- Nel campo Comando del sistema operativo, inserisci

Fai clic su Salva.

Per testare lo script, fai clic su Esegui.

Fai di nuovo clic su Esegui.

Viene restituito un Google Cloud token e visualizzato nella parte inferiore del riquadro dell'interfaccia utente SAP.

- Inserisci la transazione

Windows

Utilizzando l'interfaccia utente SAP, crea un comando del sistema operativo esterno:

- Inserisci la transazione

SM69. - Fai clic su Crea.

- Nella sezione Comando del riquadro Comando esterno, inserisci il

nome del comando, ad esempio

ZGOOGLE_CDF_TOKEN. Nella sezione Definizione:

- Nel campo Operating System Command (Comando del sistema operativo), inserisci

cmd /c. Nel campo Parametri per il comando del sistema operativo, inserisci:

gcloud auth print-access-token SERVICE_ACCOUNT_NAME

- Nel campo Operating System Command (Comando del sistema operativo), inserisci

Fai clic su Salva.

Per testare lo script, fai clic su Esegui.

Fai di nuovo clic su Esegui.

Viene restituito e visualizzato un token Google Cloud nella parte inferiore del riquadro dell'interfaccia utente SAP.

Requisiti SLT

Il connettore SLT deve essere configurato come segue:

- Il connettore supporta SAP ECC NW 7.02, DMIS 2011 SP17 e versioni successive.

- Configura una connessione RFC o di database tra SLT e il sistema Cloud Storage.

- Configura i certificati SSL:

- Scarica i seguenti certificati CA dal

repository Google Trust Services:

- GTS Root R1

- GTS CA 1C3

- Nell'interfaccia utente di SAP, utilizza la transazione

STRUSTper importare sia il certificato radice sia quello subordinato nella cartellaSSL Client (Standard) PSE.

- Scarica i seguenti certificati CA dal

repository Google Trust Services:

- Internet Communication Manager (ICM) deve essere configurato per HTTPS. Assicurati che

le porte HTTP e HTTPS siano mantenute e attivate nel sistema SAP SLT.

Puoi verificarlo tramite il codice transazione

SMICM > Services. - Abilita l'accesso alle Google Cloud API sulla VM in cui è ospitato il sistema SAP SLT. Ciò consente la comunicazione privata tra i serviziGoogle Cloud senza il routing tramite internet pubblico.

- Assicurati che la rete possa supportare il volume e la velocità richiesti per il trasferimento dei dati tra l'infrastruttura SAP e Cloud Storage. Per un'installazione riuscita, sono consigliati Cloud VPN e/o Cloud Interconnect. Il throughput dell'API di streaming dipende dalle quote client concesse al tuo progetto Cloud Storage.

Configura il server di replica SLT

L'utente SAP esegue i seguenti passaggi.

Nei passaggi successivi, connetti il server SLT al sistema di origine e al bucket in Cloud Storage, specificando il sistema di origine, le tabelle di dati da replicare e il bucket di archiviazione di destinazione.

Configura Google ABAP SDK

Per configurare SLT per la replica dei dati (una volta per istanza Cloud Data Fusion), segui questi passaggi:

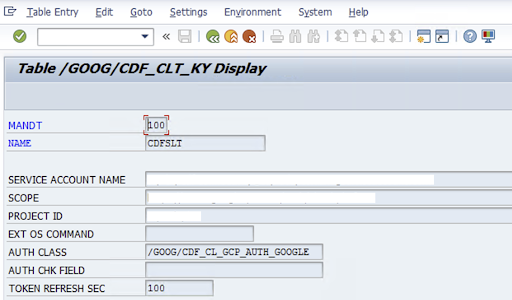

Per configurare il connettore SLT, l'utente SAP inserisce le seguenti informazioni nella schermata di configurazione (transazione SAP

/GOOG/CDF_SETTINGS) relative alla chiave del service account per il trasferimento dei dati a Cloud Storage. Google Cloud Configura le seguenti proprietà nella tabella /GOOG/CDF_CLT_KY utilizzando la transazione SE16 e annota questa chiave:- NAME: il nome della chiave dell'account di servizio (ad esempio,

CDFSLT) - NOME SERVICE ACCOUNT: il nome del account di servizio IAM

- SCOPE: l'ambito del account di servizio

- ID PROGETTO: l'ID del tuo progetto Google Cloud

- (Facoltativo) EXT OS Command: utilizza questo campo solo se SLT non è installato su Google Cloud

AUTH CLASS: se il comando del sistema operativo è configurato nella tabella

/GOOG/CDF_CLT_KY, utilizza il valore fisso:/GOOG/CDF_CL_GCP_AUTH.TOKEN REFRESH SEC: durata dell'aggiornamento del token di autorizzazione

- NAME: il nome della chiave dell'account di servizio (ad esempio,

Crea la configurazione della replica

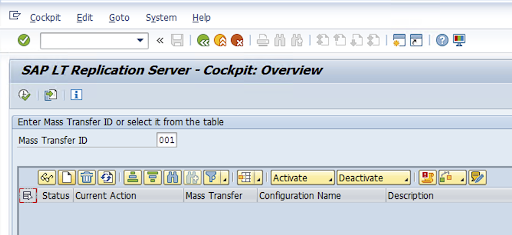

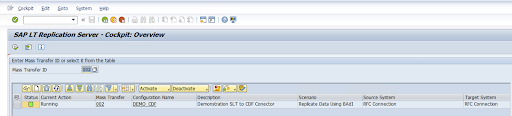

Crea una configurazione di replica nel codice di transazione: LTRC.

- Prima di procedere con la configurazione di LTRC, assicurati che la connessione RFC tra SLT e il sistema SAP di origine sia stabilita.

- Per una configurazione SLT, potrebbero essere assegnate più tabelle SAP per la replica.

Vai al codice transazione

LTRCe fai clic su Nuova configurazione.

Inserisci il Nome configurazione e la Descrizione e fai clic su Avanti.

Specifica la connessione RFC del sistema di origine SAP e fai clic su Avanti.

In Dettagli connessione sistema di destinazione, seleziona Altro.

Espandi il campo Scenario for RFC Communication (Scenario per la comunicazione RFC), seleziona SLT SDK e fai clic su Avanti.

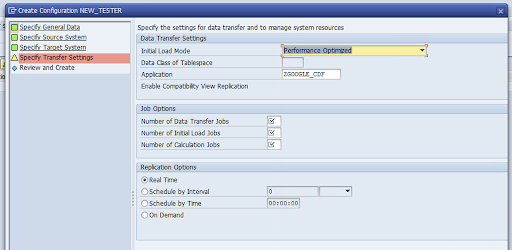

Vai alla finestra Specifica impostazioni di trasferimento e inserisci il nome dell'applicazione:

ZGOOGLE_CDF.

Inserisci il Numero di job di trasferimento dei dati, il Numero di job di caricamento iniziale e il Numero di job di calcolo. Per ulteriori informazioni sulle prestazioni, consulta la Guida all'ottimizzazione delle prestazioni di SAP LT Replication Server.

Fai clic su In tempo reale > Avanti.

Rivedi la configurazione e fai clic su Salva. Prendi nota dell'ID trasferimento di massa per i passaggi successivi.

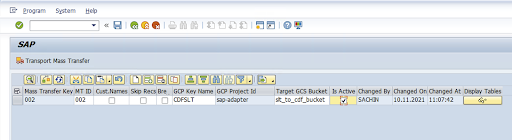

Per mantenere l'ID trasferimento collettivo e i dettagli della tabella SAP, esegui la transazione SAP:

/GOOG/CDF_SETTINGS.Fai clic su Esegui o premi

F8.Crea una nuova voce facendo clic sull'icona Aggiungi riga.

Inserisci ID trasferimento collettivo, Chiave di trasferimento collettivo, Nome chiave GCP e Bucket GCS di destinazione. Seleziona la casella di controllo È attivo e salva le modifiche.

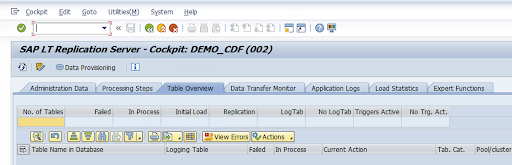

Seleziona la configurazione nella colonna Nome configurazione e fai clic su Provisioning dei dati.

(Facoltativo) Personalizza i nomi della tabella e dei campi.

Fai clic su Nomi personalizzati e salva.

Fai clic su Display.

Crea una nuova voce facendo clic sui pulsanti Aggiungi riga o Crea.

Inserisci il nome della tabella SAP e il nome della tabella esterna da utilizzare in BigQuery e salva le modifiche.

Fai clic sul pulsante Visualizza nella colonna Campi di visualizzazione per mantenere la mappatura dei campi della tabella.

Si apre una pagina con le mappature suggerite. (Facoltativo) Modifica il nome del campo temporaneo e la descrizione del campo, poi salva le mappature.

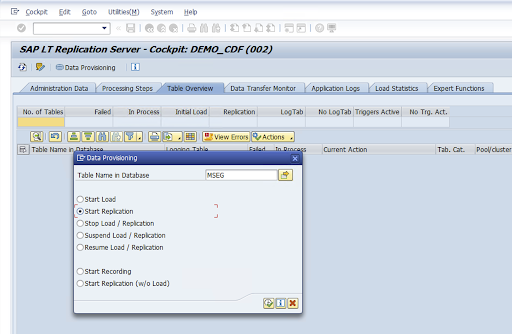

Vai alla transazione LTRC.

Seleziona il valore nella colonna Nome configurazione e fai clic su Provisioning dati.

Inserisci il nome della tabella nel campo Nome tabella nel database e seleziona lo scenario di replica.

Fai clic su Esegui. Viene attivata l'implementazione dell'SDK SLT e inizia il trasferimento dei dati al bucket di destinazione in Cloud Storage.

Installa i file di trasporto SAP

Per progettare ed eseguire job di replica in Cloud Data Fusion, i componenti SAP vengono forniti come file di trasporto SAP archiviati in un file ZIP. Il download è disponibile quando deploy il plug-in in Cloud Data Fusion Hub.

Per installare i trasporti SAP:

Passaggio 1: carica i file della richiesta di trasporto

- Accedi al sistema operativo dell'istanza SAP.

- Utilizza il codice transazione SAP

AL11per ottenere il percorso della cartellaDIR_TRANS. In genere, il percorso è/usr/sap/trans/. - Copia i file co nella cartella

DIR_TRANS/cofiles. - Copia i file di dati nella

cartella

DIR_TRANS/data. - Imposta l'utente e il gruppo di dati e del cofile su

<sid>admesapsys.

Passaggio 2: importa i file delle richieste di trasporto

L'amministratore SAP può importare i file di richiesta di trasporto utilizzando il sistema di gestione dei trasporti SAP o il sistema operativo:

Sistema di gestione dei trasporti SAP

- Accedi al sistema SAP come amministratore SAP.

- Inserisci l'STMS della transazione.

- Fai clic su Panoramica > Importazioni.

- Nella colonna Coda, fai doppio clic sull'SID corrente.

- Fai clic su Extra > Altre richieste > Aggiungi.

- Seleziona l'ID richiesta di trasporto e fai clic su Continua.

- Seleziona la richiesta di trasporto nella coda di importazione e poi fai clic su Richiesta > Importa.

- Inserisci il numero cliente.

Nella scheda Opzioni, seleziona Sovrascrivi originali e Ignora versione componente non valida (se disponibile).

(Facoltativo) Per importare nuovamente i trasporti in un secondo momento, fai clic su Lascia le richieste di trasporto in coda per l'importazione successiva e Importa di nuovo le richieste di trasporto. Questa funzionalità è utile per gli upgrade e i ripristini dei backup del sistema SAP.

Fai clic su Continua.

Verifica che il modulo della funzione e i ruoli di autorizzazione siano stati importati correttamente utilizzando transazioni come

SE80ePFCG.

Sistema operativo

- Accedi al sistema SAP come amministratore SAP.

Aggiungi richieste al buffer di importazione:

tp addtobuffer TRANSPORT_REQUEST_ID SIDAd esempio:

tp addtobuffer IB1K903958 DD1Importa le richieste di trasporto:

tp import TRANSPORT_REQUEST_ID SID client=NNN U1238Sostituisci

NNNcon il numero cliente. Ad esempio:tp import IB1K903958 DD1 client=800 U1238Verifica che il modulo funzionale e i ruoli di autorizzazione siano stati importati correttamente utilizzando le transazioni appropriate, ad esempio

SE80ePFCG.

Autorizzazioni SAP obbligatorie

Per eseguire una pipeline di dati in Cloud Data Fusion, devi disporre di un utente SAP. L'utente SAP

deve essere di tipo Comunicazioni o Dialogo. Per evitare di utilizzare le risorse di dialogo SAP, è consigliabile il tipo di comunicazione. Gli utenti possono essere creati dall'amministratore SAP utilizzando il codice di transazione SAP SU01.

Per gestire e configurare il connettore per SAP sono necessarie autorizzazioni SAP, una combinazione di oggetti di autorizzazione standard SAP e del nuovo connettore. Mantieni gli oggetti di autorizzazione in base ai criteri di sicurezza della tua organizzazione. Il seguente elenco descrive alcune autorizzazioni importanti necessarie per il connettore:

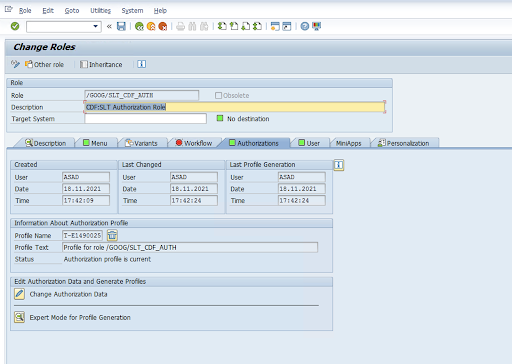

Oggetto autorizzazione: l'oggetto autorizzazione

ZGOOGCDFMTviene spedito come parte del ruolo Richiesta di trasporto.Creazione ruolo: crea un ruolo utilizzando il codice transazione

PFCG.

Per gli oggetti di autorizzazione SAP standard, la tua organizzazione gestisce le autorizzazioni con il proprio meccanismo di sicurezza.

Per gli oggetti di autorizzazione personalizzati, fornisci i valori nei campi di autorizzazione per gli oggetti di autorizzazione

ZGOOGCDFMT.Per controllo dell'accesso granulare,

ZGOOGCDFMTfornisce l'autorizzazione basata sui gruppi di autorizzazione. Gli utenti con accesso completo, parziale o nullo ai gruppi di autorizzazione ricevono l'accesso in base al gruppo di autorizzazione assegnato nel loro ruolo./GOOG/SLT_CDF_AUTH: ruolo con accesso a tutti i gruppi di autorizzazione. Per limitare l'accesso specifico a un determinato gruppo di autorizzazione, mantieni il FICDF del gruppo di autorizzazione nella configurazione.

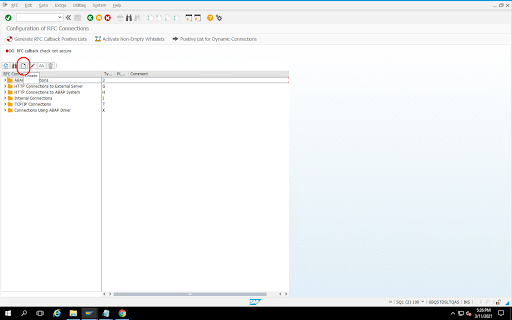

Crea una destinazione RFC per l'origine

Prima di iniziare la configurazione, assicurati che la connessione RFC sia stabilita tra origine e destinazione.

Vai al codice della transazione

SM59.Fai clic su Crea > Tipo di connessione 3 (connessione ABAP).

Nella finestra Impostazioni tecniche, inserisci i dettagli della destinazione RFC.

Fai clic sulla scheda Logon and Security (Accesso e sicurezza) per gestire le credenziali RFC (utente e password RFC).

Fai clic su Salva.

Fai clic su Test connessione. Dopo aver superato il test, puoi procedere.

Verifica che il test di autorizzazione RFC sia riuscito.

Fai clic su Utilità > Test > Test di autorizzazione.

Configurare il plug-in

Per configurare il plug-in, esegui il deployment dall'hub, crea un job di replica e configura l'origine e la destinazione con i seguenti passaggi.

Deployment del plug-in in Cloud Data Fusion

L'utente Cloud Data Fusion esegue i seguenti passaggi.

Prima di poter eseguire il job di replica Cloud Data Fusion, implementa il plug-in di replica SAP SLT:

Vai all'istanza:

Nella console Google Cloud , vai alla pagina Istanze di Cloud Data Fusion.

Attiva la replica in un'istanza nuova o esistente:

- Per una nuova istanza, fai clic su Crea istanza, inserisci un nome per l'istanza, fai clic su Aggiungi acceleratori, seleziona la casella di controllo Replica e fai clic su Salva.

- Per un'istanza esistente, consulta Attiva la replica su un'istanza esistente.

Fai clic su Visualizza istanza per aprire l'istanza nell'interfaccia web di Cloud Data Fusion.

Fai clic su Hub.

Vai alla scheda SAP, fai clic su SAP SLT e poi su SAP SLT Replication Plugin o SAP SLT No RFC Replication Plugin.

Fai clic su Esegui il deployment.

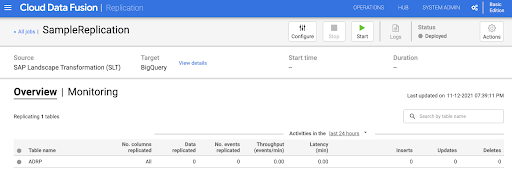

Crea un job di replica

Il plug-in di replica SAP SLT legge i contenuti delle tabelle SAP utilizzando un bucket di staging dell'API Cloud Storage.

Per creare un job di replica per il trasferimento dei dati:

Nell'istanza Cloud Data Fusion aperta, fai clic su Home > Replicazione > Crea un job di replicazione. Se non è presente l'opzione Replica, attiva la replica per l' istanza.

Inserisci un nome e una descrizione univoci per il job di replica.

Fai clic su Avanti.

Configurare l'origine

Configura l'origine inserendo i valori nei seguenti campi:

- ID progetto: l'ID del tuo progetto Google Cloud (questo campo è precompilato)

Percorso GCS di replica dei dati: il percorso Cloud Storage che contiene i dati per la replica. Deve corrispondere al percorso configurato nei job SAP SLT. Internamente, il percorso fornito viene concatenato con

Mass Transfer IDeSource Table Name:Formato:

gs://<base-path>/<mass-transfer-id>/<source-table-name>Esempio:

gs://slt_bucket/012/MARAGUID: il GUID SLT, un identificatore univoco assegnato all'ID trasferimento collettivo SAP SLT.

ID trasferimento collettivo: l'ID trasferimento collettivo SLT è un identificatore univoco assegnato alla configurazione in SAP SLT.

Percorso GCS della libreria SAP JCo: il percorso di archiviazione che contiene i file della libreria SAP JCo caricati dall'utente. Le librerie SAP JCo possono essere scaricate dal portale di assistenza SAP. (Rimossa nella versione 0.10.0 del plug-in.)

Host del server SLT: nome host o indirizzo IP del server SLT. (Rimossa nella versione 0.10.0 del plug-in.)

Numero sistema SAP: numero del sistema di installazione fornito dall'amministratore di sistema (ad esempio,

00). (Rimosso nella versione 0.10.0 del plug-in.)SAP Client: il client SAP da utilizzare (ad esempio,

100). (Rimosso nella versione 0.10.0 del plug-in.)Lingua SAP: lingua di accesso a SAP (ad esempio,

EN). (Rimossa nella versione 0.10.0 del plug-in.)SAP Logon Username: nome utente SAP. (Rimossa nella versione 0.10.0 del plug-in.)

- Consigliato: se il nome utente di SAP Logon cambia periodicamente, utilizza una macro.

Password di accesso SAP (M): password utente SAP per l'autenticazione utente.

- Consigliato: utilizza macro sicure per i valori sensibili, ad esempio le password. (Rimossa nella versione 0.10.0 del plug-in.)

Sospendi la replica SLT quando il job CDF si arresta: tenta di arrestare il job di replica SLT (per le tabelle coinvolte) quando il job di replica Cloud Data Fusion si arresta. Potrebbe non riuscire se il job in Cloud Data Fusion si arresta in modo imprevisto.

Replica dati esistenti: indica se replicare i dati esistenti dalle tabelle di origine. Per impostazione predefinita, i job replicano i dati esistenti dalle tabelle di origine. Se impostato su

false, tutti i dati esistenti nelle tabelle di origine vengono ignorati e vengono replicate solo le modifiche apportate dopo l'avvio del job.Chiave del service account: la chiave da utilizzare quando interagisci con Cloud Storage. Il account di servizio deve disporre dell'autorizzazione di scrittura in Cloud Storage. Quando viene eseguito su una VM Google Cloud , questo valore deve essere impostato su

auto-detectper utilizzare il account di servizio collegato alla VM.

Fai clic su Avanti.

Configurare il target

Per scrivere dati in BigQuery, il plug-in richiede l'accesso in scrittura sia a BigQuery sia a un bucket di staging. Gli eventi di modifica vengono prima scritti in batch da SLT a Cloud Storage. Vengono quindi caricati nelle tabelle di gestione temporanea in BigQuery. Le modifiche apportate alla tabella di gestione temporanea vengono unite alla tabella di destinazione finale utilizzando una query di unione BigQuery.

La tabella di destinazione finale include tutte le colonne originali della tabella di origine

più una colonna _sequence_num aggiuntiva. Il numero di sequenza garantisce che

i dati non vengano duplicati o persi in scenari di errore del replicatore.

Configura l'origine inserendo i valori nei seguenti campi:

- ID progetto: progetto del set di dati BigQuery. Quando viene eseguito su un cluster Dataproc, questo campo può essere lasciato vuoto, in modo da utilizzare il progetto del cluster.

- Credenziali: consulta Credenziali.

- Chiave del service account: i contenuti della chiave del account di servizio da utilizzare quando interagisci con Cloud Storage e BigQuery. Quando viene eseguito su un cluster Dataproc, questo campo deve essere lasciato vuoto, in modo da utilizzare iaccount di serviziont del cluster.

- Nome del set di dati: nome del set di dati da creare in BigQuery. È facoltativo e, per impostazione predefinita, il nome del set di dati corrisponde al nome del database di origine. Un nome valido deve contenere solo lettere, numeri e trattini bassi e la lunghezza massima può essere di 1024 caratteri. I caratteri non validi vengono sostituiti con un trattino basso nel nome del set di dati finale e i caratteri che superano il limite di lunghezza vengono troncati.

- Nome chiave di crittografia: la chiave di crittografia gestita dal cliente (CMEK) utilizzata per proteggere le risorse create da questa destinazione. Il nome della chiave di crittografia deve essere

nel formato

projects/<project-id>/locations/<key-location>/keyRings/<key-ring-name>/cryptoKeys/<key-name>. - Località: la località in cui vengono creati il set di dati BigQuery e

il bucket di gestione temporanea Cloud Storage. Ad esempio,

us-east1per i bucket regionali,usper i bucket multiregionali (vedi Località). Questo valore viene ignorato se viene specificato un bucket esistente, poiché il bucket di staging e il set di dati BigQuery vengono creati nella stessa località del bucket. Bucket di staging: il bucket in cui vengono scritti gli eventi di modifica prima di essere caricati nelle tabelle di staging. Le modifiche vengono scritte in una directory che contiene il nome e lo spazio dei nomi del replicatore. È sicuro utilizzare lo stesso bucket in più replicatori all'interno della stessa istanza. Se viene condiviso da replicatori in più istanze, assicurati che lo spazio dei nomi e il nome siano univoci, altrimenti il comportamento non è definito. Il bucket deve trovarsi nella stessa posizione del set di dati BigQuery. Se non viene fornito, viene creato un nuovo bucket per ogni job denominato

df-rbq-<namespace-name>-<job-name>-<deployment-timestamp>.Intervallo di caricamento (secondi): numero di secondi da attendere prima di caricare un batch di dati in BigQuery.

Prefisso tabella di staging: le modifiche vengono scritte prima in una tabella di staging prima di essere unite alla tabella finale. I nomi delle tabelle di staging vengono generati anteponendo questo prefisso al nome della tabella di destinazione.

Richiedi intervento manuale di eliminazione: indica se è necessaria un'azione amministrativa manuale per eliminare tabelle e set di dati quando viene rilevato un evento di eliminazione di una tabella o di un database. Se impostato su true, il replicatore non elimina una tabella o un set di dati. Al contrario, l'operazione non va a buon fine e viene riprovata finché la tabella o il set di dati non esiste. Se il set di dati o la tabella non esistono, non è necessario alcun intervento manuale. L'evento viene ignorato come di consueto.

Attiva eliminazioni temporanee: se è impostato su true, quando la destinazione riceve un evento di eliminazione, la colonna

_is_deleteddel record viene impostata sutrue. In caso contrario, il record viene eliminato dalla tabella BigQuery. Questa configurazione non ha effetto per un'origine che genera eventi in modo non sequenziale e i record vengono sempre eliminati temporaneamente dalla tabella BigQuery.

Fai clic su Avanti.

Credenziali

Se il plug-in viene eseguito su un cluster Dataproc, la chiave account di servizio deve essere impostata sul rilevamento automatico. Le credenziali vengono lette automaticamente dall'ambiente cluster.

Se il plug-in non viene eseguito su un cluster Dataproc, deve essere fornito il percorso di una chiave del account di servizio. La chiave del account di servizio si trova nella pagina IAM della console Google Cloud . Assicurati che la chiave dell'account disponga dell'autorizzazione per accedere a BigQuery. Il file della chiave dell'account di servizio deve essere disponibile su ogni nodo del cluster e deve essere leggibile da tutti gli utenti che eseguono il job.

Limitazioni

- Le tabelle devono avere una chiave primaria per essere replicate.

- Le operazioni di ridenominazione delle tabelle non sono supportate.

- Le modifiche alle tabelle sono parzialmente supportate.

- Una colonna non nullable esistente può essere modificata in una colonna nullable.

- È possibile aggiungere nuove colonne che accettano valori null a una tabella esistente.

- Qualsiasi altro tipo di modifica allo schema della tabella non andrà a buon fine.

- Le modifiche alla chiave primaria non andranno a buon fine, ma i dati esistenti non verranno riscritti per rispettare l'unicità della nuova chiave primaria.

Seleziona tabelle e trasformazioni

Nel passaggio Seleziona tabelle e trasformazioni, viene visualizzato un elenco di tabelle selezionate per la replica nel sistema SLT.

- Seleziona le tabelle da replicare.

- (Facoltativo) Seleziona altre operazioni sullo schema, ad esempio Inserimenti, Aggiornamenti o Eliminazioni.

- Per visualizzare lo schema, fai clic su Colonne da replicare per una tabella.

(Facoltativo) Per rinominare le colonne nello schema:

- Durante la visualizzazione dello schema, fai clic su Trasforma > Rinomina.

- Nel campo Rinomina, inserisci un nuovo nome e fai clic su Applica.

- Per salvare il nuovo nome, fai clic su Aggiorna e Salva.

Fai clic su Avanti.

(Facoltativo) Configurare le proprietà avanzate

Se sai quanti dati replichi in un'ora, puoi selezionare l'opzione appropriata.

Rivedi valutazione

Il passaggio Esamina valutazione esegue la scansione per rilevare problemi di schema, funzionalità mancanti o problemi di connettività che si verificano durante la replica.

Nella pagina Rivedi valutazione, fai clic su Visualizza mappature.

In caso di problemi, questi devono essere risolti prima di poter procedere.

(Facoltativo) Se hai rinominato le colonne quando hai selezionato le tabelle e le trasformazioni, verifica che i nuovi nomi siano corretti in questo passaggio.

Fai clic su Avanti.

Visualizza il riepilogo e implementa il job di replica

Nella pagina Esamina i dettagli del job di replica, esamina le impostazioni e fai clic su Esegui il deployment del job di replica.

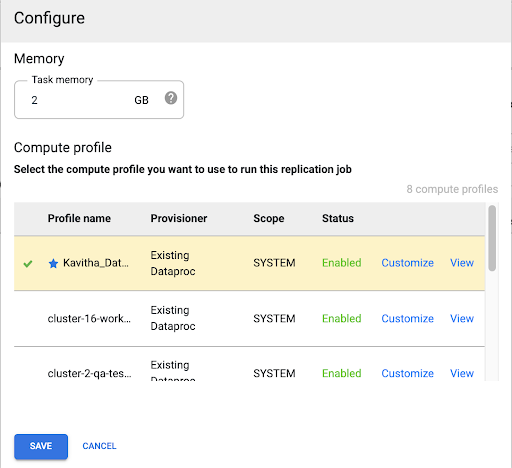

Seleziona un profilo Compute Engine

Dopo aver eseguito il deployment del job di replica, fai clic su Configura da qualsiasi pagina dell'interfaccia web di Cloud Data Fusion.

Seleziona il profilo Compute Engine che vuoi utilizzare per eseguire questo job di replica.

Fai clic su Salva.

Avviare il job di replica

- Per eseguire il job di replica, fai clic su Avvia.

(Facoltativo) Ottimizza il rendimento

Per impostazione predefinita, il plug-in è configurato per prestazioni ottimali. Per ulteriori ottimizzazioni, vedi Argomenti di runtime.

Le prestazioni della comunicazione SLT e Cloud Data Fusion dipendono da questi fattori:

- SLT sul sistema di origine rispetto a un sistema SLT centrale dedicato (opzione preferita)

- Elaborazione dei job in background sul sistema SLT

- Processi di lavoro di dialogo sul sistema SAP di origine

- Il numero di processi di job in background allocati a ogni ID trasferimento collettivo nella scheda Amministrazione LTRC

- Impostazioni LTRS

- Hardware (CPU e memoria) del sistema SLT

- Il database utilizzato (ad esempio HANA, Sybase o DB2)

- La larghezza di banda internet (connettività tra il sistema SAP e Google Cloud su internet)

- Utilizzo (carico) preesistente sul sistema

- Il numero di colonne nella tabella. Con più colonne, la replica diventa lenta e la latenza può aumentare.

Per i caricamenti iniziali, sono consigliati i seguenti tipi di lettura nelle impostazioni LTRS:

| sistema SLT | Sistema di origine | Tipo di tabella | Tipo di lettura consigliato [caricamento iniziale] |

|---|---|---|---|

| SLT 3.0 standalone [DMIS 2018_1_752 SP 2] |

S/4 HANA 1909 | Trasparente (piccolo/medio) Trasparente (grande) Tabella cluster |

1 calcolo dell'intervallo 1 calcolo dell'intervallo 4 code mittente |

| SLT embedded [S4CORE 104 HANA 1909] |

N/D | Trasparente (piccolo/medio) Trasparente (grande) Tabella cluster |

1 calcolo dell'intervallo 1 calcolo dell'intervallo 4 code mittente |

| SLT 2.0 standalone [DMIS 2011_1_731 SP 17] |

ECC NW 7.02 | Trasparente (piccolo/medio) Trasparente (grande) Tabella cluster |

5 coda del mittente 5 coda del mittente 4 coda del mittente |

| SLT embedded [DMIS 2011_1_700 SP 17] |

N/D | Trasparente (piccolo/medio) Trasparente (grande) Tabella cluster |

5 coda del mittente 5 coda del mittente 4 coda del mittente |

- Per la replica, utilizza Nessun intervallo per migliorare il rendimento:

- Gli intervalli devono essere utilizzati solo quando i backlog vengono generati in una tabella di logging con latenza elevata.

- Utilizzo di un calcolo dell'intervallo: il tipo di lettura per il caricamento iniziale non è consigliato in caso di sistemi SLT 2.0 e non HANA.

- Utilizzando un solo calcolo dell'intervallo: il tipo di lettura per il caricamento iniziale potrebbe comportare record duplicati in BigQuery.

- Le prestazioni sono sempre migliori quando viene utilizzato un sistema SLT autonomo.

- Un sistema SLT autonomo è sempre consigliato se l'utilizzo delle risorse del sistema di origine è già elevato.

Argomenti di runtime

snapshot.thread.count: passa il numero di thread da avviare per eseguire il caricamento dei datiSNAPSHOT/INITIALin parallelo. Per impostazione predefinita, utilizza il numero di vCPU disponibili nel cluster Dataproc in cui viene eseguito il job di replica.Consigliato: imposta questo parametro solo nei casi in cui hai bisogno di un controllo preciso sul numero di thread paralleli (ad esempio, per ridurre l'utilizzo sul cluster).

poll.file.count: passa il numero di file da sondare dal percorso Cloud Storage fornito nel campo Percorso GCS di replica dei dati nell'interfaccia web. Per impostazione predefinita, il valore è500per sondaggio, ma in base alla configurazione del cluster, può essere aumentato o diminuito.Consigliato: imposta questo parametro solo se hai requisiti rigorosi per il ritardo di replica. Valori più bassi potrebbero ridurre il ritardo. Puoi utilizzarlo per migliorare la velocità effettiva (se non risponde, utilizza valori superiori a quello predefinito).

bad.files.base.path: passa il percorso Cloud Storage di base in cui vengono copiati tutti i file di dati errati o difettosi trovati durante la replica. Ciò è utile quando esistono requisiti rigorosi per il controllo dei dati e deve essere utilizzata una posizione specifica per registrare i trasferimenti non riusciti.Per impostazione predefinita, tutti i file errati vengono copiati dal percorso Cloud Storage fornito nel campo Percorso Cloud Storage di replica dei dati nell'interfaccia web.

Pattern del percorso finale dei file di dati difettosi:

gs://BASE_FILE_PATH/MASS_TRANSFER_ID/SOURCE_TABLE_NAME/bad_files/REPLICATION_JOB_NAME/REPLICATION_JOB_ID/BAD_FILE_NAME

Esempio:

gs://slt_to_cdf_bucket/001/MARA/bad_files/MaraRepl/05f97349-7398-11ec-9443-8 ac0640fc83c/20220205_1901205168830_DATA_INIT.xml

I criteri per un file non valido sono un file XML danneggiato o non valido, valori PK mancanti o un problema di mancata corrispondenza del tipo di dati del campo.

Dettagli dell'assistenza

Prodotti e versioni SAP supportati

- SAP_BASIS versione 702, SP-Level 0016 e successive.

- Release SAP_ABA 702, SP-Level 0016 e versioni successive.

- DMIS 2011_1_700, SP-Level 0017 e versioni successive.

Versioni di SLT supportate

Sono supportate le versioni 2 e 3 di SLT.

Modelli di deployment SAP supportati

SLT come sistema autonomo o incorporato nel sistema di origine.

Note SAP che devono essere implementate prima di iniziare a utilizzare SLT

Se il tuo pacchetto di assistenza non include correzioni della classe /UI2/CL_JSON per PL

12 o versioni successive, implementa l'ultima nota SAP per le correzioni della classe /UI2/CL_JSON,

ad esempio la nota SAP 2798102 per PL12.

Consigliato: implementa le note SAP consigliate dal report

CNV_NOTE_ANALYZER_SLT in base alla condizione del sistema centrale o di origine. Per

maggiori informazioni, consulta

la nota SAP 3016862

(è necessario l'accesso a SAP).

Se SAP è già configurato, non è necessario implementare ulteriori note. Per eventuali errori o problemi specifici, consulta la nota SAP centrale per la tua release SLT.

Limiti per il volume di dati o la larghezza dei record

Non esiste un limite definito per il volume di dati estratti e la larghezza dei record.

Velocità effettiva prevista per il plug-in SAP SLT Replication

Per un ambiente configurato in base alle linee guida riportate in Ottimizza il rendimento, il plug-in può estrarre circa 13 GB all'ora per il caricamento iniziale e 3 GB all'ora per la replica (CDC). Le prestazioni effettive possono variare in base al carico del sistema Cloud Data Fusion e SAP o al traffico di rete.

Supporto dell'estrazione delta (dati modificati) di SAP

L'estrazione delta SAP è supportata.

Obbligatorio: peering tenant per le istanze Cloud Data Fusion

Il peering tenant è obbligatorio quando l'istanza Cloud Data Fusion viene creata con un indirizzo IP interno. Per saperne di più sul peering tenant, consulta Creazione di un'istanza privata.

Risoluzione dei problemi

Il job di replica continua a riavviarsi

Se il job di replica continua a riavviarsi automaticamente, aumenta la memoria del cluster del job di replica ed esegui di nuovo il job di replica.

Duplicati nel sink BigQuery

Se definisci il numero di job paralleli nelle impostazioni avanzate del plug-in di replica SAP SLT, quando le tabelle sono di grandi dimensioni, si verifica un errore che causa la duplicazione delle colonne nel sink BigQuery.

Per evitare il problema, rimuovi i job paralleli per il caricamento dei dati.

Scenari di errore

La seguente tabella elenca alcuni messaggi di errore comuni (il testo tra virgolette verrà sostituito dai valori effettivi al runtime):

| ID messaggio | Messaggio | Azione consigliata |

|---|---|---|

CDF_SAP_SLT_01402 |

Service account type is not defined for

SERVICE_ACCT_NAME_FROM_UI. |

Assicurati che il percorso Cloud Storage fornito sia corretto. |

CDF_SAP_SLT_01403 |

Service account key provided is not valid due to error:

ROOT_CAUSE. Please provide a valid service account key for

service account type : SERVICE_ACCT_NAME_FROM_UI. |

Controlla la causa principale visualizzata nel messaggio e prendi i provvedimenti opportuni. |

CDF_SAP_SLT_01404 |

Mass Transfer ID could not be found. Please ensure that it exists

in given GCS Bucket. |

Verifica che l'ID trasferimento collettivo fornito sia nel formato corretto. |

CDF_SAP_SLT_01502 |

The specified data replication GCS path 'slt_to_cdf_bucket_1' or

Mass Transfer ID '05C' could not be found. Please ensure that it exists in

GCS. |

Assicurati che il percorso Cloud Storage fornito sia corretto. |

CDF_SAP_SLT_01400 |

Metadata file not found. The META_INIT.json file is not present or

file is present with invalid format. |

Controlla la causa principale visualizzata nel messaggio e prendi i provvedimenti opportuni. |

CDF_SAP_SLT_03408 |

Failed to start the event reader. |

Controlla la causa principale visualizzata nel messaggio e prendi i provvedimenti opportuni. |

CDF_SAP_SLT_03409 |

Error while processing TABLE_NAME file for source table

gs://CLOUD_STORAGE_BUCKET_NAME/MT_ID/TABLE_NAME

/FILE_NAME. Root cause: ROOT_CAUSE. |

Controlla la causa principale visualizzata nel messaggio e prendi i provvedimenti opportuni. |

CDF_SAP_SLT_03410 |

Failed to replicate data for source table TABLE_NAME

from file: gs://CLOUD_STORAGE_BUCKET_NAME/MT_ID/

TABLE_NAME/FILE_NAME. Root cause:

ROOT_CAUSE. |

Controlla la causa principale visualizzata nel messaggio e prendi i provvedimenti opportuni. |

CDF_SAP_SLT_03411 |

Failed data replication for source table TABLE_NAME.

Root cause: ROOT_CAUSE. |

Controlla la causa principale visualizzata nel messaggio e prendi i provvedimenti opportuni. |

CDF_SAP_SLT_03412 |

Failed to create target table for source table

TABLE_NAME. Root cause: ROOT_CAUSE. |

Controlla la causa principale visualizzata nel messaggio e prendi i provvedimenti opportuni. |

Mappatura dei tipi di dati

La seguente tabella mostra il mapping tra i tipi di dati utilizzati nelle applicazioni SAP e Cloud Data Fusion.

| Tipo di dati SAP | Tipo ABAP | Descrizione (SAP) | Tipo di dati Cloud Data Fusion |

|---|---|---|---|

| Numerico | |||

| INT1 | b | Numero intero a 1 byte | int |

| INT2 | s | Numero intero a 2 byte | int |

| INT4 | i | Numero intero a 4 byte | int |

| INT8 | 8 | Intero a 8 byte | long |

| DIC | p | Numero compresso in formato BCD (DEC) | decimal |

| DF16_DEC DF16_RAW |

a | Virgola mobile decimale a 8 byte IEEE 754r | decimal |

| DF34_DEC DF34_RAW |

e | Virgola mobile decimale a 16 byte IEEE 754r | decimal |

| FLTP | f | Numero binario in virgola mobile | double |

| Carattere | |||

| CHAR LCHR |

c | Stringa di caratteri | string |

| SSTRING GEOM_EWKB |

string | Stringa di caratteri | string |

| STRING GEOM_EWKB |

string | CLOB di stringa di caratteri | bytes |

| NUMC ACCP |

n | Testo numerico | string |

| Byte | |||

| RAW LRAW |

x | Dati binari | bytes |

| RAWSTRING | xstring | BLOB di stringa di byte | bytes |

| Data/ora | |||

| DATS | d | Data | date |

| Tims | t | Ora | time |

| TIMESTAMP | utcl | ( Utclong ) TimeStamp |

timestamp |

Passaggi successivi

- Scopri di più su Cloud Data Fusion.

- Scopri di più su SAP su Google Cloud.