Vector Search est un moteur de recherche vectorielle puissant basé sur une technologie révolutionnaire développée par Google Research. Grâce à l'algorithme ScaNN, Vector Search vous permet de créer des systèmes de recherche et de recommandation nouvelle génération, ainsi que des applications d'IA générative.

Vous pouvez bénéficier des mêmes recherches et technologies que celles qui alimentent les produits Google principaux, y compris la recherche Google, YouTube et Google Play. Vous bénéficiez ainsi de l'évolutivité, de la disponibilité et des performances qui ont fait leurs preuves pour gérer des ensembles de données volumineux et fournir des résultats ultra-rapides à l'échelle mondiale. Vector Search est une solution de niveau entreprise qui vous permet d'implémenter des fonctionnalités de recherche sémantique de pointe dans vos propres applications.

|

|

Infinite Fleurs : découvrez la créativité assistée par l'IA en pleine floraison |

|

Premiers pas

Démonstration interactive de Vector Search : Découvrez la démonstration en direct pour obtenir un exemple réaliste de ce que la technologie de recherche vectorielle peut faire et prendre une longueur d'avance avec Vector Search.

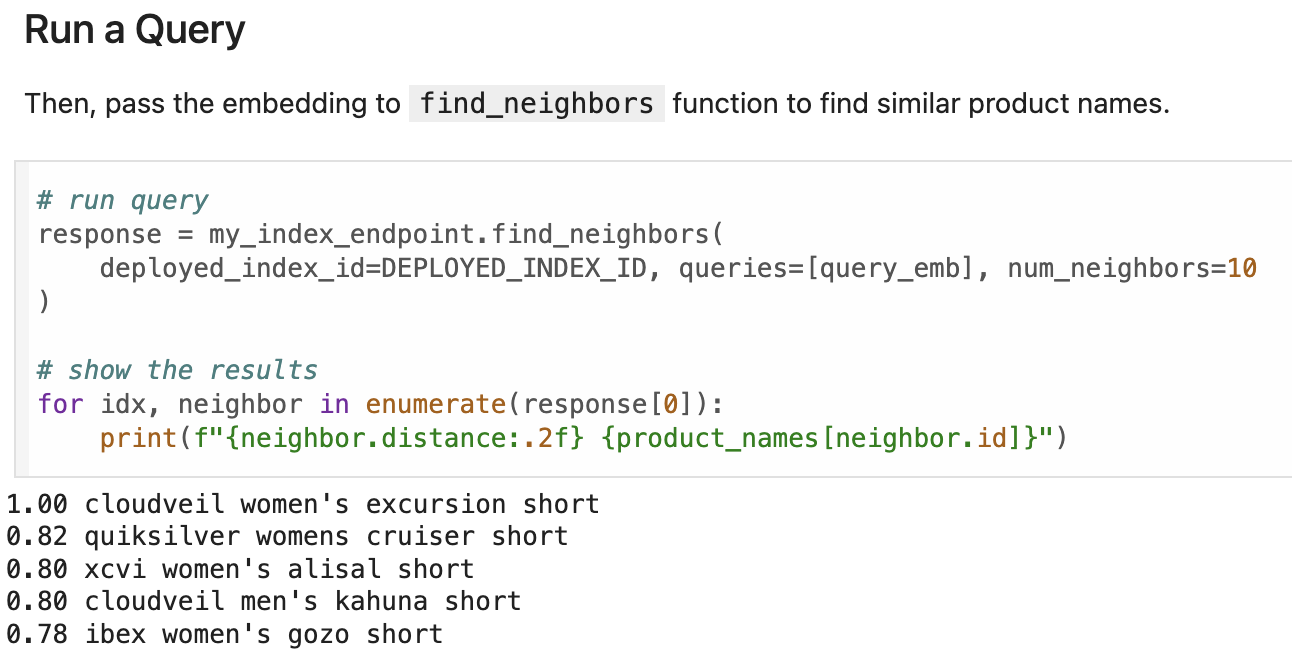

Guide de démarrage rapide de Vector Search : essayez Vector Search en 30 minutes en créant, en déployant et en interrogeant un index Vector Search à l'aide d'un exemple d'ensemble de données. Ce tutoriel aborde la configuration, la préparation des données, la création d'index, le déploiement, l'interrogation et le nettoyage.

Avant de commencer : préparez vos embeddings en choisissant et en entraînant un modèle, puis en préparant vos données. Choisissez ensuite un point de terminaison public ou privé sur lequel déployer votre index de requête.

Tarifs et simulateur de coût Vector Search : les tarifs Vector Search incluent le coût des machines virtuelles utilisées pour héberger les index déployés, ainsi que les frais de création et de mise à jour des index. Même une configuration minimale (moins de 100 $par mois) peut prendre en charge un débit élevé pour les cas d'utilisation de taille moyenne. Pour estimer vos coûts mensuels :

- Accédez au simulateur de coût Google Cloud.

- Cliquez sur Ajouter à l'estimation.

- Recherchez Vertex AI.

- Cliquez sur le bouton Vertex AI.

- Sélectionnez Vertex AI Vector Search dans le menu déroulant Type de service.

- Conservez les paramètres par défaut ou configurez les vôtres. Le coût mensuel estimé s'affiche dans le panneau Détails des coûts.

Documentation

Gérer les index et les points de terminaison

Créer un point de terminaison d'index

Rubriques avancées

Cas d'utilisation et blogs

La technologie de recherche vectorielle devient un hub central pour les entreprises qui utilisent l'IA. Comme les bases de données relationnelles dans les systèmes informatiques, il relie divers éléments commerciaux tels que des documents, des contenus, des produits, des utilisateurs, des événements et d'autres entités en fonction de leur pertinence. Au-delà de la recherche de contenus multimédias classiques tels que des documents et des images, Vector Search peut également générer des recommandations intelligentes, faire correspondre des problèmes commerciaux à des solutions et même associer des signaux IoT à des alertes de surveillance. Il s'agit d'un outil polyvalent et essentiel pour naviguer dans le paysage en pleine expansion des données d'entreprise optimisées par l'IA.

|

Recherche / Récupération d'informations

Systèmes de recommandation |

Comment la recherche vectorielle Vertex AI permet de créer des applications d'IA générative hautes performances : la recherche vectorielle alimente diverses applications, y compris les systèmes de RAG, les moteurs de recommandation, les chatbots, la recherche multimodale, etc. La recherche hybride améliore encore les résultats pour les termes spécifiques. Des clients comme Bloomreach, eBay et Mercado Libre utilisent Vertex AI pour ses performances, son évolutivité et sa rentabilité. Ils bénéficient ainsi d'avantages tels que des recherches plus rapides et une augmentation des conversions. eBay utilise Vector Search pour les recommandations : met en avant la façon dont eBay utilise Vector Search pour son système de recommandation. Cette technologie permet à eBay de trouver des produits similaires dans son vaste catalogue, ce qui améliore l'expérience utilisateur. Mercari s'appuie sur la technologie de recherche vectorielle de Google pour créer une nouvelle plate-forme de marché : explique comment Mercari utilise la recherche vectorielle pour améliorer sa nouvelle plate-forme de marché. Vector Search alimente les recommandations de la plate-forme, ce qui aide les utilisateurs à trouver plus efficacement les produits qui les intéressent. Vertex AI Embeddings for Text : faciliter l'ancrage des LLM : se concentre sur l'ancrage des LLM à l'aide de Vertex AI Embeddings pour les données textuelles. La recherche vectorielle joue un rôle important dans la recherche de passages de texte pertinents qui garantissent que les réponses du modèle sont ancrées dans des informations factuelles. Qu'est-ce que la recherche multimodale : les LLM avec vision modifient les entreprises : présente la recherche multimodale, qui combine les LLM avec la compréhension visuelle. Il explique comment la recherche vectorielle traite et compare les données textuelles et d'image, ce qui permet d'offrir des expériences de recherche plus complètes. Débloquez la recherche multimodale à grande échelle : combinez la puissance du texte et des images avec Vertex AI : décrit la création d'un moteur de recherche multimodal avec Vertex AI qui combine la recherche de texte et d'images à l'aide d'une méthode d'ensemble de rang réciproque biaisé pondéré. Cela améliore l'expérience utilisateur et fournit des résultats plus pertinents. Soumettre la récupération profonde à un scaling à l'aide des outils de recommandation TensorFlow et de Vector Search : explique comment créer un système de recommandation de playlists à l'aide des outils de recommandation TensorFlow et de Vector Search, en abordant les modèles de récupération profonde, l'entraînement, le déploiement et le scaling. |

|

IA générative : récupération pour RAG et les agents |

Vertex AI et Denodo débloquent les données d'entreprise avec l'IA générative : montre comment l'intégration de Vertex AI à Denodo permet aux entreprises d'utiliser l'IA générative pour obtenir des insights à partir de leurs données. Vector Search est essentiel pour accéder efficacement aux données pertinentes et les analyser dans un environnement d'entreprise. Infinite Nature et la nature des secteurs : cette démo "sauvage" montre les diverses possibilités de l'IA : présente une démo qui illustre le potentiel de l'IA dans différents secteurs. Elle utilise Vector Search pour générer des recommandations et effectuer des recherches sémantiques multimodales. Infinite Fleurs : découvrez la créativité assistée par l'IA en pleine floraison : Infinite Fleurs de Google, une expérience d'IA utilisant les modèles Vector Search, Gemini et Imagen, génère des bouquets de fleurs uniques en fonction des requêtes des utilisateurs. Cette technologie illustre le potentiel de l'IA pour inspirer la créativité dans divers secteurs. LlamaIndex pour le RAG sur Google Cloud : décrit comment utiliser LlamaIndex pour faciliter la génération augmentée de récupération (RAG) avec de grands modèles de langage. LlamaIndex utilise la recherche vectorielle pour récupérer des informations pertinentes dans une base de connaissances, ce qui permet d'obtenir des réponses plus précises et plus adaptées au contexte. RAG et ancrage sur Vertex AI : examine les techniques de RAG et d'ancrage sur Vertex AI. La recherche vectorielle permet d'identifier des informations d'ancrage pertinentes lors de la récupération, ce qui rend le contenu généré plus précis et plus fiable. Vector Search sur LangChain : fournit un guide sur l'utilisation de Vector Search avec LangChain pour créer et déployer un index de base de données vectorielle pour les données textuelles, y compris les systèmes de questions-réponses et le traitement des PDF. |

|

Informatique décisionnelle, analyse de données, surveillance et plus |

Exploiter l'IA en temps réel grâce à l'ingestion en flux continu dans Vertex AI : découvrez la mise à jour en flux continu dans Vector Search et comment elle fournit des fonctionnalités d'IA en temps réel. Cette technologie permet de traiter et d'analyser en temps réel les flux de données entrants. |

Ressources associées

Vous pouvez utiliser les ressources suivantes pour commencer à utiliser Vector Search :

Notebooks et solutions

|

|

|

Démarrage rapide de Vertex AI Vector Search : fournit une présentation de Vector Search. Il est conçu pour les utilisateurs qui découvrent la plate-forme et souhaitent se lancer rapidement. |

Premiers pas avec les embeddings de texte et la recherche vectorielle : présente les embeddings de texte et la recherche vectorielle. Il explique comment ces technologies fonctionnent et comment elles peuvent être utilisées pour améliorer les résultats de recherche. |

|

|

|

Combiner la recherche sémantique et la recherche par mot clé : tutoriel sur la recherche hybride avec Vertex AI Vector Search : fournit des instructions sur l'utilisation de Vector Search pour la recherche hybride. Il décrit les étapes à suivre pour configurer un système de recherche hybride. |

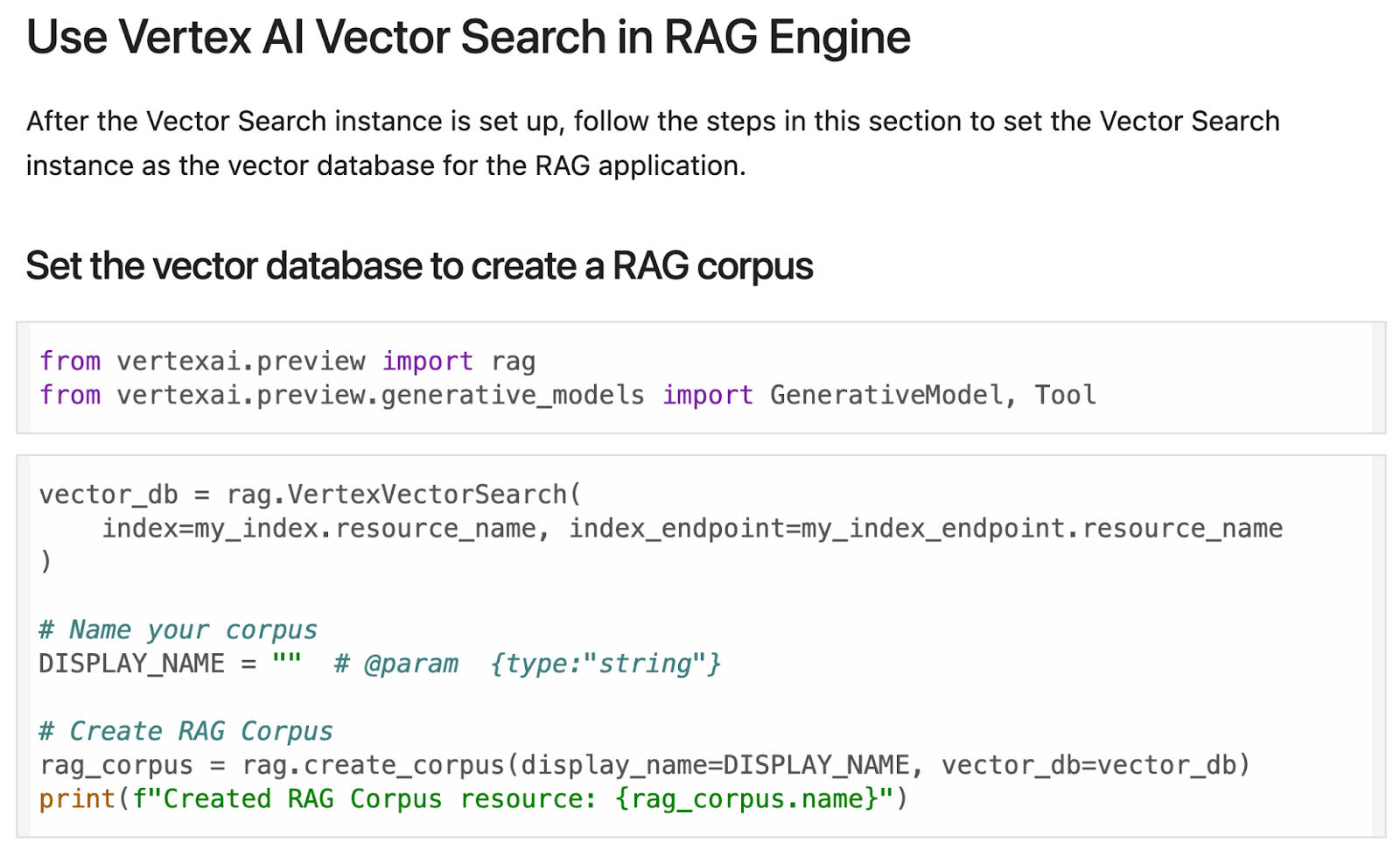

Moteur RAG Vertex AI avec Vector Search : explore l'utilisation du moteur RAG Vertex AI avec Vector Search. Il aborde les avantages de l'utilisation conjointe de ces deux technologies et fournit des exemples de leur utilisation dans des applications concrètes. |

|

|

|

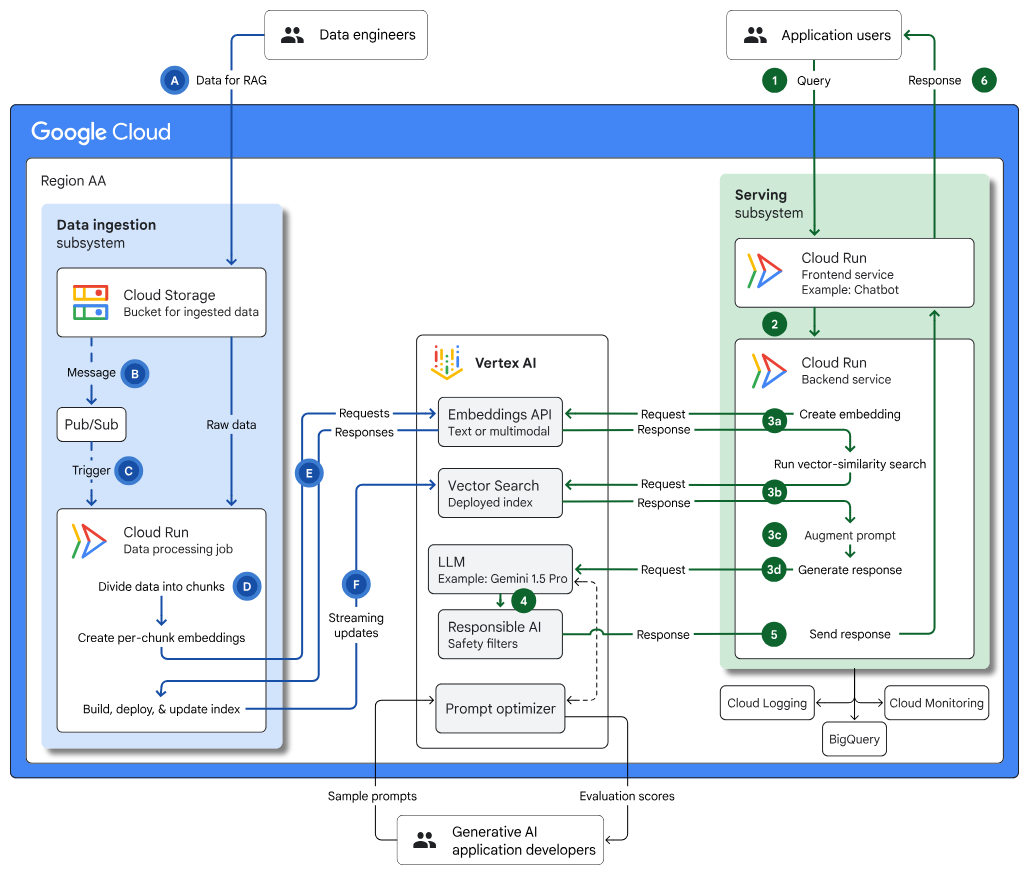

Infrastructure pour une application d'IA générative compatible avec RAG à l'aide de Vertex AI et de la recherche vectorielle : décrit l'architecture permettant de créer une application d'IA générative et RAG à l'aide de la recherche vectorielle, de Cloud Run et de Cloud Storage, en couvrant les cas d'utilisation, les choix de conception et les considérations clés. |

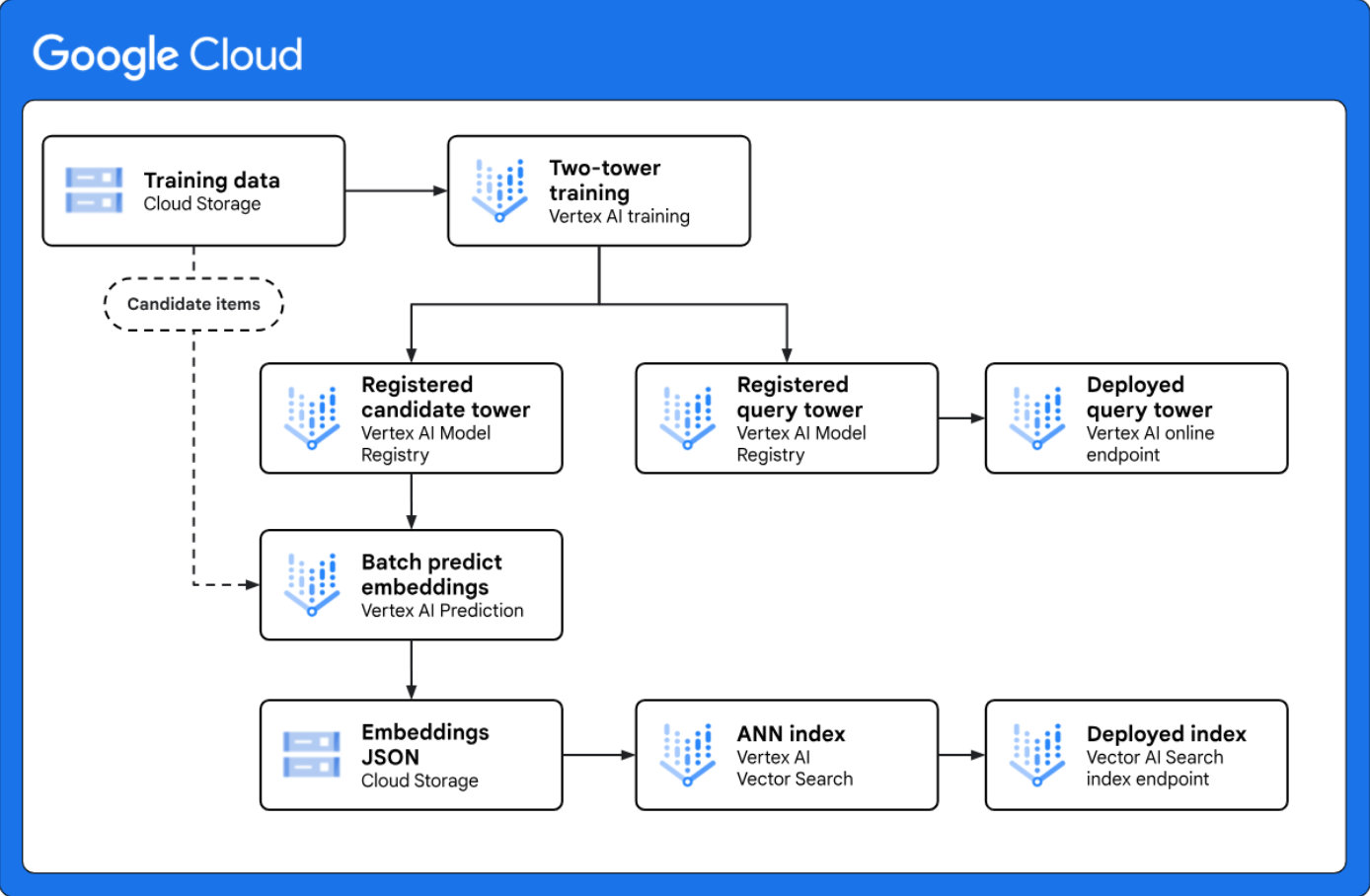

Implémenter la récupération à deux tours pour la génération de candidats à grande échelle : fournit une architecture de référence qui vous montre comment implémenter un workflow de génération de candidats à deux tours de bout en bout avec Vertex AI. Le framework de modélisation à deux tours est une technique de récupération puissante pour les cas d'utilisation de personnalisation, car il apprend la similarité sémantique entre deux entités différentes, telles que les requêtes Web et les éléments candidats. |

Formation

Premiers pas avec Vector Search et les embeddings Vector Search permet de trouver des éléments similaires ou associés. Il peut être utilisé pour les recommandations, la recherche, les chatbots et la classification de texte. Le processus consiste à créer des embeddings, à les importer dans Google Cloudet à les indexer pour les interroger. Cet atelier se concentre sur les embeddings de texte à l'aide de Vertex AI, mais des embeddings peuvent être générés pour d'autres types de données.

Recherche vectorielle et embeddings Ce cours présente la recherche vectorielle et décrit comment l'utiliser afin de créer une application de recherche avec des API LLM pour les embeddings. Il comprend des leçons conceptuelles sur la recherche vectorielle et l'embedding textuel (ou "plongement textuel"), des démonstrations pratiques de création d'une recherche vectorielle sur Vertex AI, ainsi qu'un atelier pratique.

Comprendre et appliquer les embeddings de texte

L'API Vertex AI Embeddings génère des embeddings de texte, qui sont des représentations numériques de texte utilisées pour des tâches telles que l'identification d'éléments similaires.

Dans ce cours, vous allez utiliser des embeddings textuels pour des tâches telles que la classification et la recherche sémantique. Vous combinerez la recherche sémantique avec des LLM pour créer des systèmes de questions-réponses à l'aide de Vertex AI.

Cours d'initiation au Machine Learning : embeddings Ce cours présente les embeddings de mots et les compare aux représentations creuses. Il explore les méthodes permettant d'obtenir des embeddings et fait la différence entre les embeddings statiques et contextuels.

Produits associés

Vertex AI Embeddings Présentation de l'API Embeddings. Cas d'utilisation des embeddings de texte et multimodaux, ainsi que des liens vers des ressources supplémentaires et des services Google Cloud associés.

API Vertex AI Search Ranking L'API Ranking reclasse les documents en fonction de leur pertinence par rapport à une requête à l'aide d'un modèle de langage pré-entraîné, ce qui permet d'obtenir des scores précis. Elle est idéale pour améliorer les résultats de recherche provenant de diverses sources, y compris la recherche vectorielle.

Vertex AI Feature Store Vous permet de gérer et de diffuser des données de caractéristiques à l'aide de BigQuery comme source de données. Il provisionne des ressources pour la diffusion en ligne et sert de couche de métadonnées pour diffuser les dernières valeurs de caractéristiques directement depuis BigQuery. Feature Store permet de récupérer instantanément les valeurs de caractéristiques pour les éléments renvoyés par Vector Store pour les requêtes.

Vertex AI Pipelines Vertex AI Pipelines permet d'automatiser, de surveiller et de gérer vos systèmes de ML sans serveur en orchestrant les workflows de ML avec des pipelines de ML. Vous pouvez exécuter par lot des pipelines de ML définis à l'aide des frameworks Kubeflow Pipelines ou TensorFlow Extended (TFX). Les pipelines permettent de créer des pipelines automatisés pour générer des embeddings, créer et mettre à jour des index Vector Search, et configurer un MLOps pour les systèmes de recherche et de recommandation de production.

Ressources détaillées

Améliorer votre cas d'utilisation d'IA générative avec les types de tâches et les embeddings Vertex AI Se concentre sur l'amélioration des applications d'IA générative à l'aide des types de tâches et des embeddings Vertex AI. Vector Search peut être utilisé avec des embeddings de type de tâche pour améliorer le contexte et la précision du contenu généré en trouvant des informations plus pertinentes.

TensorFlow Recommenders Bibliothèque Open Source permettant de créer des systèmes de recommandation. Il simplifie le processus de la préparation des données au déploiement et permet de créer des modèles flexibles. TFRS propose des tutoriels et des ressources, et permet de créer des modèles de recommandation sophistiqués.

TensorFlow Ranking TensorFlow Ranking est une bibliothèque Open Source permettant de créer des modèles d'apprentissage de classement (LTR) neuronaux évolutifs. Il est compatible avec diverses fonctions de perte et métriques de classement, avec des applications dans les domaines de la recherche, des recommandations et autres. La bibliothèque est activement développée par Google AI.

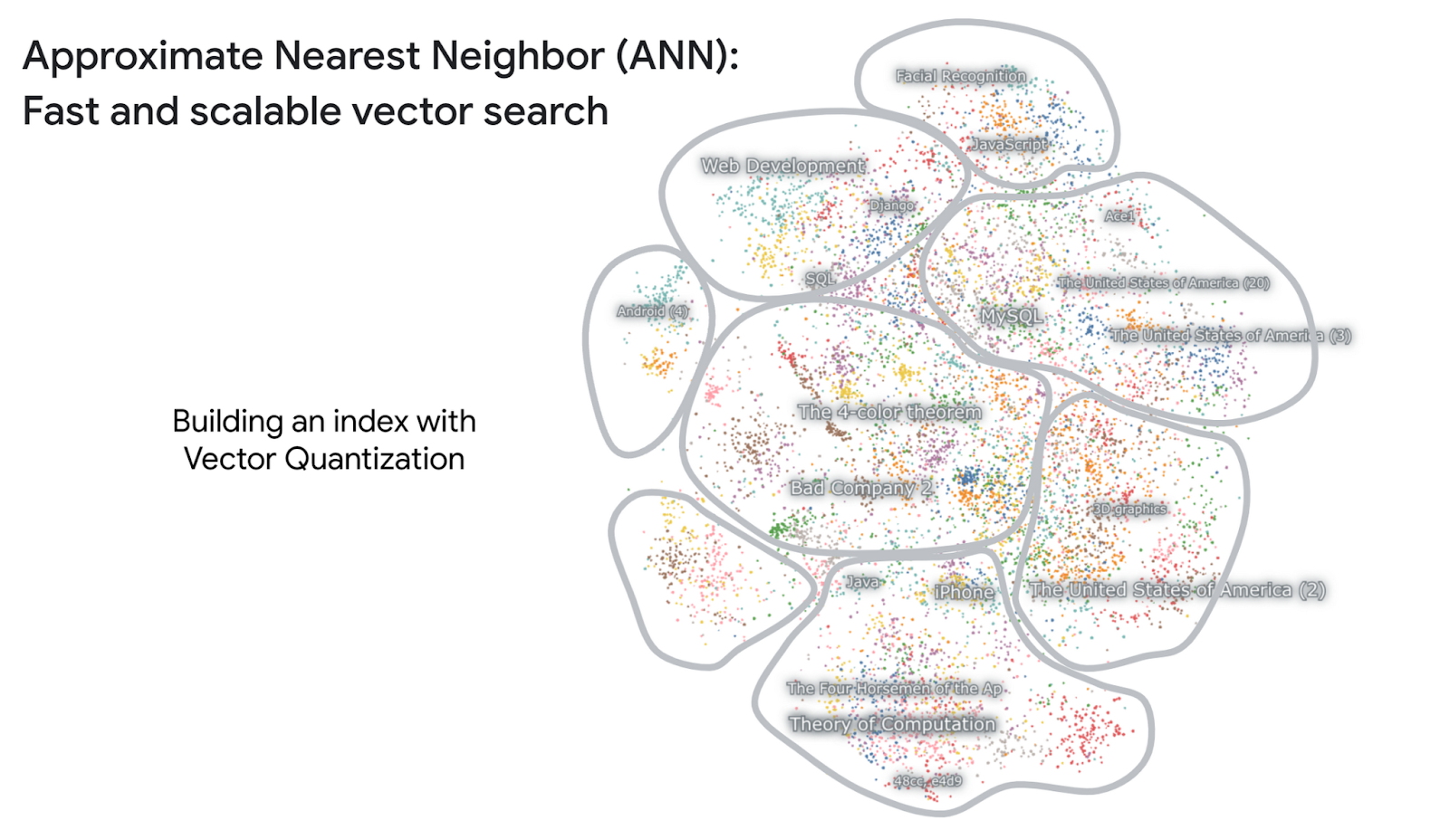

Présentation de ScaNN : recherche efficace de similarités vectorielles ScaNN de Google, un algorithme de recherche efficace de similarités vectorielles, utilise une nouvelle technique pour améliorer la précision et la rapidité de la recherche des voisins les plus proches. Il surpasse les méthodes existantes et présente de nombreuses applications dans les tâches de machine learning nécessitant une recherche sémantique. Les efforts de recherche de Google couvrent divers domaines, y compris le ML fondamental et les impacts sociétaux de l'IA.

SOAR : de nouveaux algorithmes pour une recherche vectorielle encore plus rapide avec ScaNN L'algorithme SOAR de Google améliore l'efficacité de la recherche vectorielle en introduisant une redondance contrôlée, ce qui permet des recherches plus rapides avec des index plus petits. SOAR attribue des vecteurs à plusieurs clusters, ce qui crée des chemins de recherche de "sauvegarde" pour améliorer les performances.

Vidéos similaires

Premiers pas avec Vector Search à l'aide de Vertex AI

Vector Search est un outil puissant pour créer des applications basées sur l'IA. Cette vidéo présente la technologie et fournit un guide détaillé pour vous aider à vous lancer.

Découvrir la recherche hybride avec Vector Search

La recherche vectorielle peut être utilisée pour la recherche hybride, ce qui vous permet de combiner la puissance de la recherche vectorielle avec la flexibilité et la rapidité d'un moteur de recherche conventionnel. Cette vidéo présente la recherche hybride et vous montre comment utiliser Vector Search pour la recherche hybride.

Vous utilisez déjà la recherche vectorielle ! Devenir un expert

Saviez-vous que vous utilisez probablement la recherche vectorielle tous les jours sans le savoir ? De la recherche d'un produit insaisissable sur les réseaux sociaux à l'identification d'une chanson qui vous trotte dans la tête, la recherche vectorielle est la magie de l'IA qui se cache derrière ces expériences quotidiennes.

Le nouvel embedding "task type" de l'équipe DeepMind améliore la qualité de la recherche RAG

Améliorez la précision et la pertinence de vos systèmes RAG grâce aux nouveaux embeddings de type de tâche développés par l'équipe Google DeepMind. Découvrez les difficultés courantes liées à la qualité de la recherche RAG et comment les embeddings de type de tâche peuvent combler efficacement le fossé sémantique entre les questions et les réponses, ce qui permet d'améliorer la récupération et les performances RAG.

Terminologie de Vector Search

Cette liste contient certains termes clés que vous devez comprendre pour utiliser Vector Search :

Vecteur : un vecteur est une liste de valeurs flottantes ayant une magnitude et une direction. Il permet de représenter n'importe quel type de données, comme des nombres, des points dans l'espace et des directions.

Embedding : un embedding (ou "plongement") est un type de vecteur utilisé pour représenter les données de manière à capturer leur signification sémantique. Les embeddings sont généralement créés à l'aide de techniques de machine learning et sont souvent utilisés dans le traitement du langage naturel (TLN) et d'autres applications de machine learning.

Embeddings denses : les embeddings denses représentent la signification sémantique du texte à l'aide de tableaux contenant principalement des valeurs non nulles. Avec les embeddings denses, des résultats de recherche similaires peuvent être renvoyés en fonction de la similarité sémantique.

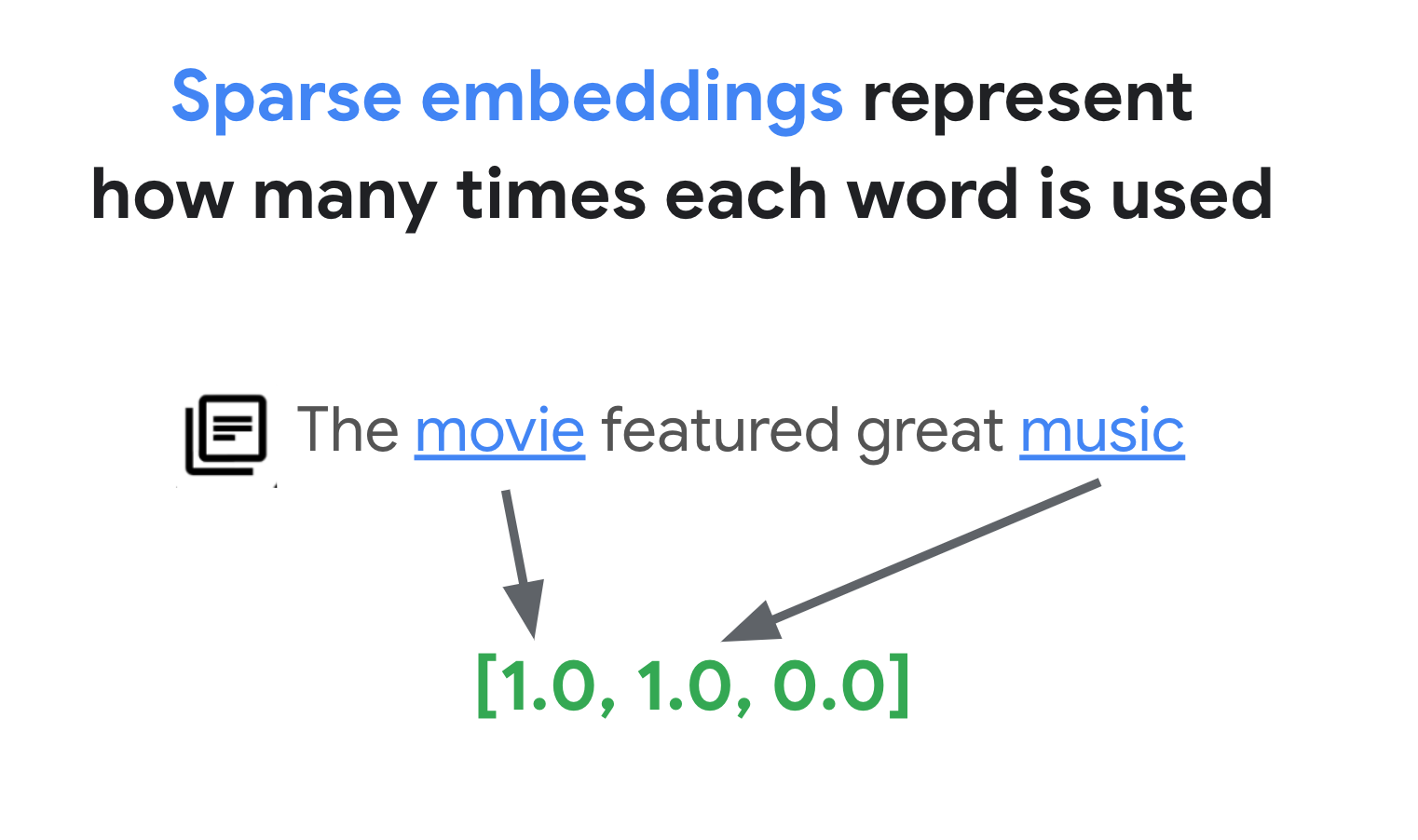

Embeddings clairsemés : les embeddings clairsemés représentent la syntaxe du texte à l'aide de tableaux à haute dimensionnalité contenant très peu de valeurs non nulles par rapport aux embeddings denses. Les embeddings clairsemés sont souvent utilisés pour les recherches par mot clé.

Recherche hybride : la recherche hybride utilise des embeddings denses et clairsemés, ce qui vous permet de combiner la recherche par mot clé et la recherche sémantique. Vector Search est compatible avec la recherche basée sur des embeddings denses, des embeddings creux et la recherche hybride.

Index : ensemble de vecteurs déployés pour la recherche de similarités. Les vecteurs peuvent être ajoutés à un index ou supprimés de celui-ci. Les requêtes de recherche de similarités sont émises sur un index spécifique et recherchent les vecteurs de cet index.

Vérité terrain : terme faisant référence à la vérification de l'exactitude du machine learning par rapport au monde réel (par exemple, un ensemble de données de vérité terrain).

Rappel : pourcentage de voisins les plus proches renvoyés par l'index qui sont de vrais voisins les plus proches. Par exemple, si une requête de 20 voisins les plus proches renvoie un résultat de 19 voisins les plus proches de "vérité terrain", le rappel est de 19 / 20 x 100 = 95 %.

Restreindre : fonctionnalité qui limite les recherches à un sous-ensemble de l'index à l'aide de règles booléennes. La restriction est également appelée "filtrage". Vector Search vous permet d'utiliser le filtrage numérique et le filtrage des attributs de texte.