TPU v5e

En este documento, se describen la arquitectura y los parámetros de configuración admitidos de Cloud TPU v5e.

La TPU v5e admite el entrenamiento de host único y de varios hosts, y la inferencia de host único. La inferencia de varios hosts se admite con Sax. Para obtener más información, consulta Interferencia de Cloud TPU.

Arquitectura del sistema

Cada chip v5e contiene un TensorCore. Cada TensorCore tiene cuatro unidades de multiplicación de matrices (MXU), una unidad vectorial y una unidad escalar.

En el siguiente diagrama, se ilustra un chip TPU v5e.

En la siguiente tabla, se muestran las especificaciones clave del chip y sus valores para la versión v5e.

| Especificaciones clave del chip | Valores de v5e |

|---|---|

| Procesamiento máximo por chip (bf16) | 197 TFLOPS |

| Capacidad y ancho de banda de HBM2 | 16 GB, 819 GBps |

| BW de interconexión entre chips | 1,600 Gbps |

En la siguiente tabla, se muestran las especificaciones de los Pods y sus valores para la versión v5e.

| Especificaciones clave del Pod | Valores de v5e |

|---|---|

| Tamaño del pod de TPU | 256 chips |

| Topología de interconexión | Toro 2D |

| Procesamiento máximo por Pod | 100 PetaOps (Int8) |

| Ancho de banda total reducido por Pod | 51.2 TB/s |

| Ancho de banda de bisección por Pod | 1.6 TB/s |

| Ancho de banda de la red del centro de datos por Pod | 6.4 Tbps |

Configuraciones

La Cloud TPU v5e es un producto combinado de entrenamiento y, a su vez, inferencia (entrega). Los trabajos de entrenamiento están optimizados para la capacidad de procesamiento y la disponibilidad, mientras que los trabajos de entrega están optimizados para la latencia. Un trabajo de entrenamiento en las TPU aprovisionadas para la entrega podría tener una disponibilidad más baja y, de manera similar, un trabajo de entrega ejecutado en las TPU aprovisionadas para el entrenamiento podría tener una latencia más alta.

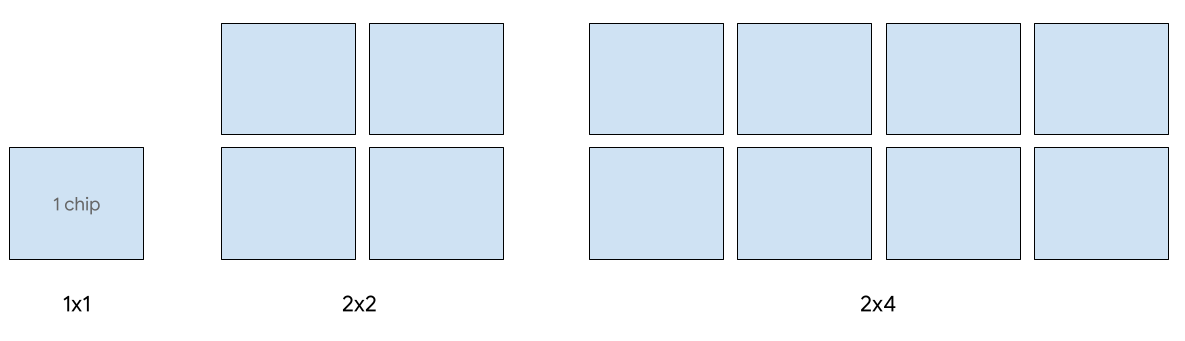

Se admiten las siguientes formas de corte 2D para la versión v5e:

| Topología | Cantidad de chips TPU | Cantidad de hosts |

|---|---|---|

| 1x1 | 1 | 1/8 |

| 2x2 | 4 | 1/2 |

| 2x4 | 8 | 1 |

| 4x4 | 16 | 2 |

| 4x8 | 32 | 4 |

| 8x8 | 64 | 8 |

| 8x16 | 128 | 16 |

| 16x16 | 256 | 32 |

Tipos de VMs

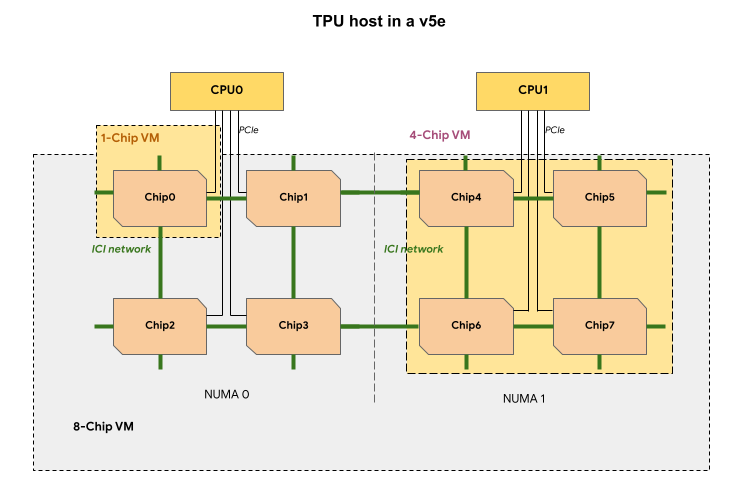

Cada VM de TPU en una porción de TPU v5e contiene 1, 4 u 8 chips. En las porciones de 4 chips y más pequeñas, todos los chips TPU comparten el mismo nodo de acceso a la memoria no uniforme (NUMA).

En el caso de las VMs de las TPU v5e con 8 chips, la comunicación entre la CPU y la TPU será más eficiente dentro de las particiones NUMA. Por ejemplo, en la siguiente figura, la comunicación CPU0-Chip0 será más rápida que la comunicación CPU0-Chip4.

En la siguiente tabla, se muestra una comparación de los tipos de VM de TPU v5e:

| Tipo de VM | Tipo de máquina (API de GKE) | Cantidad de CPU virtuales por VM | RAM (GB) por VM | Cantidad de nodos de NUMA por VM |

|---|---|---|---|---|

| VM con 1 chip | ct5lp-hightpu-1t |

24 | 48 | 1 |

| VM con 4 chips | ct5lp-hightpu-4t |

112 | 192 | 1 |

| VM con 8 chips | ct5lp-hightpu-8t |

224 | 384 | 2 |

Tipos de Cloud TPU v5e para la entrega

Se admite la entrega en un solo host para hasta 8 chips v5e. Se admiten los siguientes parámetros de configuración: porciones de 1 x 1, 2 x 2 y 2 x 4. Cada porción tiene 1, 4 y 8 chips, respectivamente.

Si deseas aprovisionar las TPU para un trabajo de entrega, usa uno de los siguientes tamaños de porción de la TPU en tu solicitud de creación de la TPU en la CLI o la API:

| Cantidad de chips TPU | Tipo de máquina (API de GKE) |

|---|---|

1 |

ct5lp-hightpu-1t |

4 |

ct5lp-hightpu-4t |

8 |

ct5lp-hightpu-8t |

Para obtener más información sobre la administración de las TPU, consulta Administra las TPU. Si deseas obtener más información sobre la arquitectura del sistema de Cloud TPU, consulta Arquitectura del sistema.

Sax admite la entrega en más de 8 chips de v5e, también llamada entrega de varios hosts. Para obtener más información, consulta Inferencia de Cloud TPU.

Tipos de Cloud TPU v5e para el entrenamiento

Se admite el entrenamiento para hasta 256 chips.

Si deseas aprovisionar las TPU para un trabajo de entrenamiento con la TPU v5e, usa uno de los siguientes tamaños de porción de la TPU en tu solicitud de creación de la TPU de la CLI o la API:

| Cantidad de chips TPU | Tipo de máquina (API de GKE) | Topología |

|---|---|---|

16 |

ct5lp-hightpu-4t |

4x4 |

32 |

ct5lp-hightpu-4t |

4x8 |

64 |

ct5lp-hightpu-4t |

8x8 |

128 |

ct5lp-hightpu-4t |

8x16 |

256 |

ct5lp-hightpu-4t |

16x16 |

Para obtener más información sobre la administración de las TPU, consulta Administra las TPU. Si deseas obtener más información sobre la arquitectura del sistema de Cloud TPU, consulta Arquitectura del sistema.