TPU7x (Ironwood)

En esta página, se describen la arquitectura y los parámetros de configuración disponibles para la TPU7x, la TPU más reciente disponible en Google Cloud. TPU7x es la primera versión de la familia Ironwood, la TPU de séptima generación de Google Cloud. La generación de Ironwood está diseñada para el entrenamiento y la inferencia de la IA a gran escala.

Con una capacidad de 9,216 chips por Pod, la TPU7x comparte muchas similitudes con la TPU v5p. La TPU7x proporciona un alto rendimiento para los modelos densos y de MoE a gran escala, el entrenamiento previo, el muestreo y la inferencia con mucha decodificación.

Para usar TPU7x, debes usar Google Kubernetes Engine (GKE). Para obtener más información, consulta Acerca de las TPU en GKE.

También puedes usar TPU7x y GKE con el Cluster Director de TPU. Cluster Director de TPU está disponible a través de una reserva en el modo All Capacity, que te brinda acceso completo a toda tu capacidad reservada (sin retenciones) y visibilidad total de la topología del hardware de TPU y el estado de utilización y de funcionamiento. Para obtener más información, consulta Descripción general del modo All Capacity.

Para obtener acceso a la TPU7x, comunícate con tu equipo de cuentas.

Arquitectura del sistema

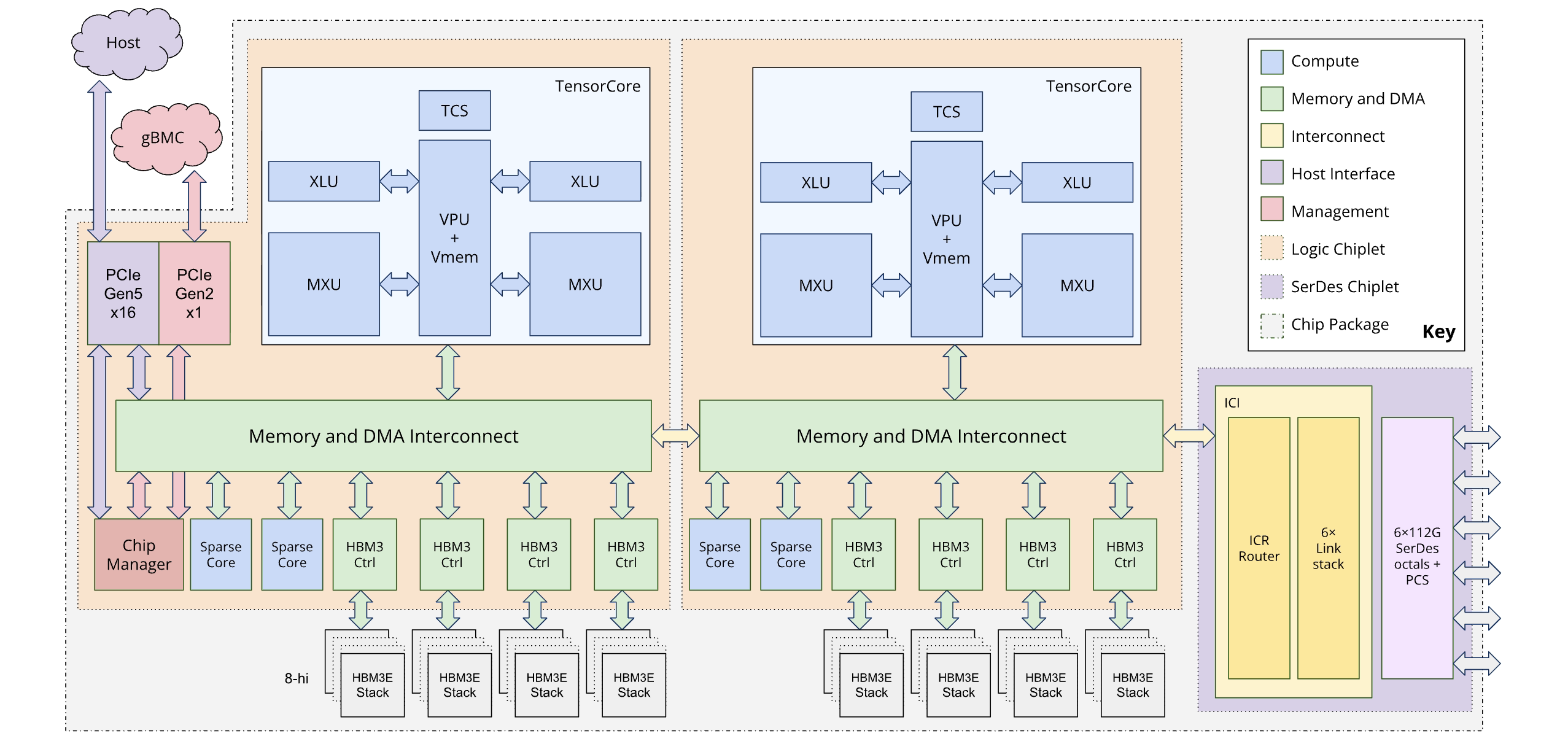

Cada chip TPU7x contiene dos TensorCores y cuatro SparseCores. En la siguiente tabla, se muestran las especificaciones clave y sus valores para la TPU7x en comparación con las generaciones anteriores.

| Especificación | v5p | v6e (Trillium) | TPU7x (Ironwood) |

|---|---|---|---|

| Cantidad de chips por Pod | 8,960 | 256 | 9,216 |

| Procesamiento máximo por chip (BF16) (Tflops) | 459 | 918 | 2,307 |

| Procesamiento máximo por chip (FP8) (Tflops) | 459 | 918 | 4,614 |

| Capacidad de HBM por chip (GiB) | 95 | 32 | 192 |

| Ancho de banda de HBM por chip (GB/s) | 2,765 | 1,638 | 7,380 |

| Cantidad de CPU virtuales (VM de 4 chips) | 208 | 180 | 224 |

| RAM (GB) (VM de 4 chips) | 448 | 720 | 960 |

| Cantidad de TensorCores por chip | 2 | 1 | 2 |

| Cantidad de SparseCores por chip | 4 | 2 | 4 |

| Ancho de banda de interconexión entre chips (ICI) bidireccional por chip (GB/s) | 1200 | 800 | 1200 |

| Ancho de banda de la red del centro de datos (DCN) por chip (GB/s) | 50 | 100 | 100 |

En el siguiente diagrama, se ilustra la arquitectura de Ironwood:

Arquitectura de doble chiplet

El modelo de programación de Ironwood te permite acceder a dos dispositivos de TPU en lugar de la arquitectura de un solo núcleo lógico (también conocido como MegaCore) que se usaba en generaciones anteriores (TPU v4 y v5p). Este cambio mejora la rentabilidad y la eficiencia de la fabricación del chip. Si bien esto representa un cambio arquitectónico, el nuevo diseño garantiza que puedas reutilizar los modelos de software existentes con cambios mínimos.

Las TPU de Ironwood se componen de dos chiplets distintos. Esto se diferencia del espacio de memoria unificado de la arquitectura MegaCore.

Composición de los chiplets: Cada chiplet es una unidad autónoma con un TensorCore, dos SparseCores y 96 GB de memoria de alto ancho de banda (HBM).

Interconexión de alta velocidad: Los dos chiplets están conectados por una interfaz de chip a chip (D2D) que es seis veces más rápida que una interconexión entre chips (ICI) 1D. La comunicación entre chiplets se administra con operaciones colectivas.

Exposición del modelo y el framework de programación

El modelo de programación de Ironwood es similar al de las generaciones de TPU anteriores a la v4, como la TPU v3. La nueva arquitectura se expone de las siguientes maneras:

Dos dispositivos por chip: Los frameworks como JAX exponen cada chip de Ironwood como dos "dispositivos" separados, uno para cada chiplet.

Topología 4D: JAX agrega una cuarta dimensión a la topología para especificar cuál de los dos dispositivos integrados en el chip se debe usar. Esto te permite usar modelos de software existentes con una modificación mínima.

Para obtener más información sobre cómo lograr un rendimiento óptimo con la arquitectura de doble chiplet, consulta Recomendaciones de rendimiento para la arquitectura de doble chiplet de Ironwood.

Parámetros de configuración admitidos

Los chips TPU7x tienen una conexión directa con los chips vecinos más cercanos en 3 dimensiones, lo que genera una malla 3D de conexiones de red. Las porciones de más de 64 chips se componen de uno o más "cubos" de chips de 4x4x4.

En la siguiente tabla, se muestran las formas de corte 3D comunes que se admiten para TPU7x:

| Topología | Chips TPU | Hosts | VMs | Cubos | Permiso |

|---|---|---|---|---|---|

| 2x2x1 | 4 | 1 | 1 | 1/16 | Único host |

| 2x2x2 | 8 | 2 | 2 | 1/8 | Varios hosts |

| 2x2x4 | 16 | 4 | 4 | 1/4 | Varios hosts |

| 2x4x4 | 32 | 8 | 8 | 1/2 | Varios hosts |

| 4x4x4 | 64 | 16 | 16 | 1 | Varios hosts |

| 4x4x8 | 128 | 32 | 32 | 2 | Varios hosts |

| 4x8x8 | 256 | 64 | 64 | 4 | Varios hosts |

| 8x8x8 | 512 | 128 | 128 | 8 | Varios hosts |

| 8x8x16 | 1024 | 256 | 256 | 16 | Varios hosts |

| 8x16x16 | 2,048 | 512 | 512 | 32 | Varios hosts |

VM de TPU7x

Cada máquina virtual (VM) de TPU7x contiene 4 chips. Cada VM tiene acceso a dos nodos de NUMA. Para obtener más información sobre los nodos de NUMA, consulta Acceso no uniforme a la memoria en Wikipedia.

Todas las porciones de TPU7x usan VMs de host completo con 4 chips. Las especificaciones técnicas de una VM de TPU7x son las siguientes:

- Cantidad de CPU virtuales por VM: 224

- RAM por VM: 960 GB

- Cantidad de nodos de NUMA por VM: 2

Hyperdisk

De forma predeterminada, el disco de arranque de la VM para TPU7x es Hyperdisk Balanced. Puedes conectar discos de Hyperdisk Balanced adicionales a tu VM de TPU para obtener más almacenamiento.

Para obtener más información sobre Hyperdisk, consulta Descripción general de Hyperdisk. Para obtener más información sobre las opciones de almacenamiento de Cloud TPU, consulta Opciones de almacenamiento para datos de Cloud TPU.

¿Qué sigue?

- Usa TPU7x con GKE.

- Usa TPU7x con el Cluster Director de TPU.

- Usa la plataforma de diagnóstico de AA de Google Cloud para optimizar y diagnosticar tus cargas de trabajo.

- Ejecuta una carga de trabajo de entrenamiento con una receta optimizada para la TPU7x.

- Ejecuta una microcomparativa de TPU7x.