TPU7x (Ironwood)

Auf dieser Seite werden die Architektur und die verfügbaren Konfigurationen für TPU7x beschrieben, die neueste TPU, die auf Google Cloudverfügbar ist. TPU7x ist die erste Version der Ironwood-Familie, Google Cloudder siebten Generation von TPUs. Die Ironwood-Generation ist für umfangreiches KI-Training und ‑Inferenz konzipiert.

Mit 9.216 Chips pro Pod hat TPU7x viele Ähnlichkeiten mit TPU v5p. TPU7x bietet eine hohe Leistung für umfangreiche dichte und MoE-Modelle, Vortraining, Sampling und Inferenz mit hohem Decodierungsaufwand.

Wenn Sie TPU7x verwenden möchten, müssen Sie Google Kubernetes Engine (GKE) verwenden. Weitere Informationen finden Sie unter TPUs in der GKE.

Sie können auch TPU7x und GKE mit TPU Cluster Director verwenden. TPU Cluster Director ist über eine Reservierung im Modus „All Capacity“ verfügbar. Damit haben Sie vollen Zugriff auf Ihre gesamte reservierte Kapazität (keine Rückstellungen) und vollständigen Einblick in die TPU-Hardwaretopologie, den Auslastungsstatus und den Status. Weitere Informationen finden Sie unter Übersicht über den Modus „Alle Kapazitäten“.

Wenn Sie Zugriff auf TPU7x erhalten möchten, wenden Sie sich an Ihr Account-Management-Team.

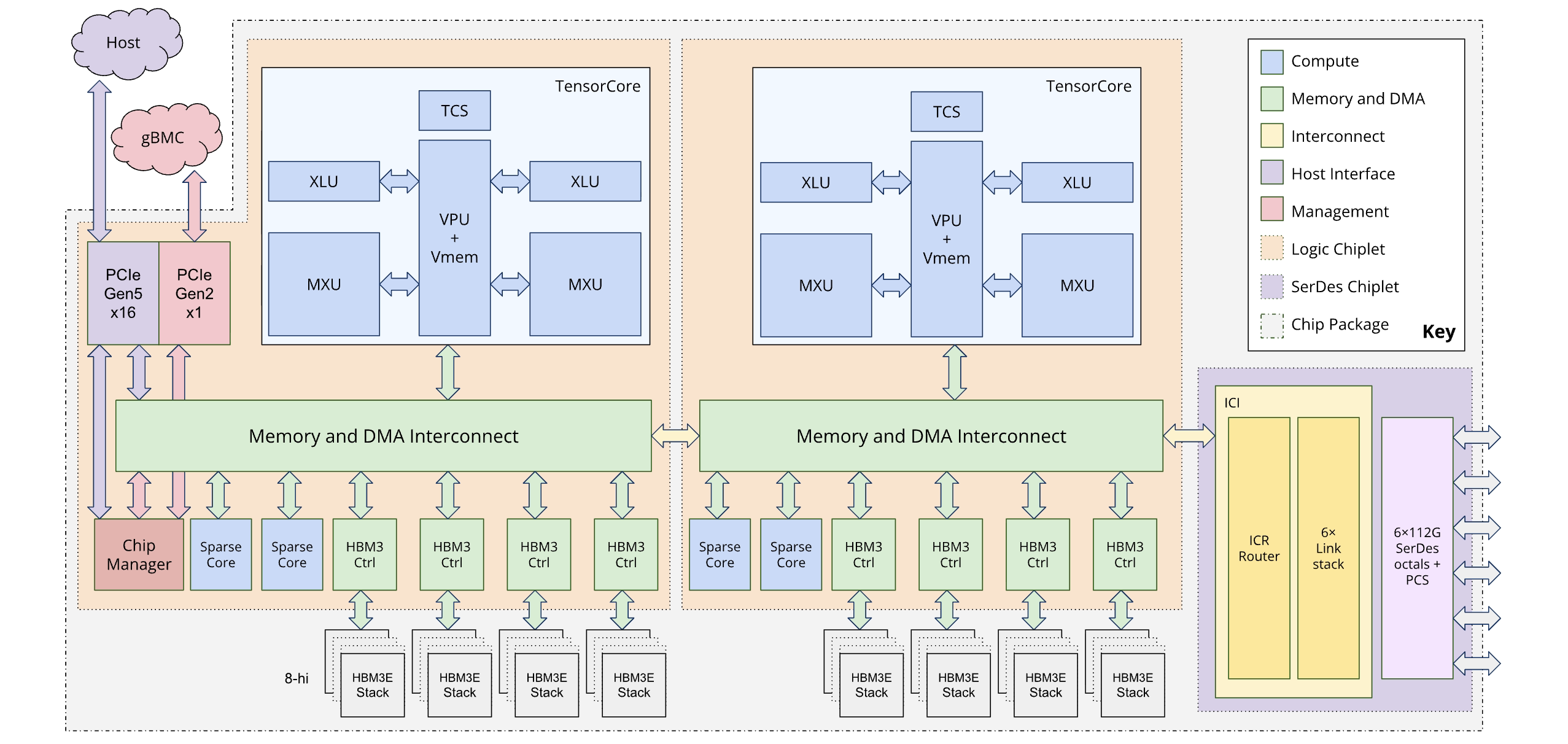

Systemarchitektur

Jeder TPU7x-Chip enthält zwei TensorCores und vier SparseCores. In der folgenden Tabelle sind die wichtigsten Spezifikationen und ihre Werte für TPU7x im Vergleich zu früheren Generationen aufgeführt.

| Spezifikation | v5p | v6e (Trillium) | TPU7x (Ironwood) |

|---|---|---|---|

| Anzahl der Chips pro Pod | 8960 | 256 | 9216 |

| Maximale Rechenleistung pro Chip (BF16) (TFLOPs) | 459 | 918 | 2307 |

| Maximale Rechenleistung pro Chip (FP8) (TFLOPs) | 459 | 918 | 4614 |

| HBM-Kapazität pro Chip (GiB) | 95 | 32 | 192 |

| HBM-Bandbreite pro Chip (GBps) | 2765 | 1638 | 7380 |

| Anzahl der vCPUs (VM mit 4 Chips) | 208 | 180 | 224 |

| RAM (GB) (VM mit 4 Chips) | 448 | 720 | 960 |

| Anzahl der TensorCores pro Chip | 2 | 1 | 2 |

| Anzahl der SparseCores pro Chip | 4 | 2 | 4 |

| Bidirektionale ICI-Bandbreite (Inter-Chip Interconnect) pro Chip (GBps) | 1.200 | 800 | 1.200 |

| Bandbreite des Rechenzentrumsnetzwerks (Data Center Network, DCN) pro Chip (Gbit/s) | 50 | 100 | 100 |

Das folgende Diagramm veranschaulicht die Architektur von Ironwood:

Dual-Chiplet-Architektur

Mit dem Ironwood-Programmiermodell können Sie auf zwei TPU-Geräte zugreifen, anstatt auf den einzelnen logischen Kern (auch als MegaCore bezeichnet), der in früheren Generationen (TPU v4 und v5p) verwendet wurde. Diese Änderung verbessert die Kosteneffizienz und Effizienz der Chipherstellung. Das neue Design stellt zwar eine architektonische Umstellung dar, sorgt aber dafür, dass Sie vorhandene Softwaremodelle mit minimalen Änderungen wiederverwenden können.

Ironwood-TPUs bestehen aus zwei verschiedenen Chiplets. Dies unterscheidet sich vom einheitlichen Speicherplatz der MegaCore-Architektur.

Chiplet-Zusammensetzung: Jedes Chiplet ist eine in sich geschlossene Einheit mit einem TensorCore, zwei SparseCores und 96 GB High-Bandwidth Memory (HBM).

Hochgeschwindigkeitsverbindung: Die beiden Chiplets sind über eine Die-to-Die-Schnittstelle (D2D) verbunden, die sechsmal schneller ist als eine 1D-Inter-Chip-Interconnect-Verbindung (ICI). Die Kommunikation zwischen Chiplets wird über kollektive Vorgänge verwaltet.

Programmiermodell und Framework-Offenlegung

Das Programmiermodell für Ironwood ähnelt dem von TPU-Generationen vor v4, z. B. TPU v3. Die neue Architektur wird auf folgende Weise verfügbar gemacht:

Zwei Geräte pro Chip:Frameworks wie JAX stellen jeden Ironwood-Chip als zwei separate „Geräte“ dar, eines für jedes Chiplet.

4D-Topologie:JAX fügt der Topologie eine vierte Dimension hinzu, um anzugeben, welches der beiden On-Chip-Geräte verwendet werden soll. So können Sie vorhandene Softwaremodelle mit minimalen Änderungen verwenden.

Weitere Informationen zur optimalen Leistung mit der Dual-Chiplet-Architektur finden Sie unter Leistungsempfehlungen für die Dual-Chiplet-Architektur von Ironwood.

Unterstützte Konfigurationen

TPU7x-Chips haben eine direkte Verbindung zu den nächstgelegenen benachbarten Chips in 3 Dimensionen, was zu einem 3D-Mesh von Netzwerkverbindungen führt. Slices mit mehr als 64 Chips bestehen aus einem oder mehreren 4 × 4 × 4-Cubes von Chips.

In der folgenden Tabelle sind die gängigen 3D-Slice-Formen aufgeführt, die für TPU7x unterstützt werden:

| Topologie | TPU-Chips | Hosts | VMs | Cubes | Umfang |

|---|---|---|---|---|---|

| 2x2x1 | 4 | 1 | 1 | 1/16 | Einzelner Host |

| 2x2x2 | 8 | 2 | 2 | 1/8 | Mehrere Hosts |

| 2x2x4 | 16 | 4 | 4 | 1/4 | Mehrere Hosts |

| 2x4x4 | 32 | 8 | 8 | 1/2 | Mehrere Hosts |

| 4x4x4 | 64 | 16 | 16 | 1 | Mehrere Hosts |

| 4 x 4 x 8 | 128 | 32 | 32 | 2 | Mehrere Hosts |

| 4 x 8 x 8 | 256 | 64 | 64 | 4 | Mehrere Hosts |

| 8 x 8 x 8 | 512 | 128 | 128 | 8 | Mehrere Hosts |

| 8 x 8 x 16 | 1.024 | 256 | 256 | 16 | Mehrere Hosts |

| 8 x 16 x 16 | 2.048 | 512 | 512 | 32 | Mehrere Hosts |

TPU7x-VM

Jede TPU7x-VM enthält 4 Chips. Jede VM hat Zugriff auf zwei NUMA-Knoten. Weitere Informationen zu NUMA-Knoten finden Sie im Wikipedia-Artikel zu Non-Uniform Memory Access.

Alle TPU7x-Slices verwenden Full-Host-VMs mit 4 Chips. Die technischen Spezifikationen für eine TPU7x-VM sind:

- Anzahl der vCPUs pro VM: 224

- RAM pro VM: 960 GB

- Anzahl der NUMA-Knoten pro VM: 2

Hyperdisk

Standardmäßig ist das VM-Bootlaufwerk für TPU7x Hyperdisk Balanced. Sie können Ihrer TPU-VM zusätzliche Hyperdisk Balanced-Laufwerke für zusätzlichen Speicherplatz zuweisen.

Weitere Informationen zu Hyperdisk finden Sie unter Hyperdisk – Übersicht. Weitere Informationen zu Speicheroptionen für Cloud TPU finden Sie unter Speicheroptionen für Cloud TPU-Daten.

Nächste Schritte

- TPU7x mit GKE verwenden

- TPU7x mit TPU Cluster Director verwenden

- Google Cloud ML Diagnostics-Plattform zum Optimieren und Diagnostizieren Ihrer Arbeitslasten verwenden

- Trainings-Workload mit einem für TPU7x optimierten Rezept ausführen

- TPU7x-Microbenchmark ausführen