En esta página, se describe cómo habilitar la replicación de datos en tiempo real desde aplicaciones de SAP a Google Cloud con SAP Landscape Transformation (SLT). El contenido se aplica a los complementos SAP SLT Replication y SAP SLT No RFC Replication, que están disponibles en Cloud Data Fusion Hub. Muestra la configuración del sistema fuente de SAP, SLT, Cloud Storage y Cloud Data Fusion para realizar las siguientes acciones:

- Envía metadatos y datos de tablas de SAP a Google Cloud con SAP SLT.

- Crea un trabajo de replicación de Cloud Data Fusion que lea los datos de un bucket de Cloud Storage.

La replicación de SAP SLT te permite replicar tus datos de forma continua y en tiempo real desde las fuentes de SAP hasta BigQuery. Puedes configurar y ejecutar transferencias de datos desde sistemas de SAP sin programación.

El proceso de replicación de SLT de Cloud Data Fusion es el siguiente:

- Los datos provienen de un sistema fuente de SAP.

- El SLT hace un seguimiento de los datos, los lee y los envía a Cloud Storage.

- Cloud Data Fusion extrae los datos del bucket de almacenamiento y los escribe en BigQuery.

Puedes transferir datos desde sistemas SAP compatibles, incluidos los sistemas SAP alojados en Google Cloud.

Para obtener más información, consulta la Descripción general de SAP en Google Cloud y los detalles de asistencia.

Antes de comenzar

Para usar este complemento, necesitarás conocimientos de dominio en las siguientes áreas:

- Compila canalizaciones en Cloud Data Fusion

- Administración de acceso con IAM

- Configuración de sistemas de planificación de recursos empresariales (ERP) locales y en la nube de SAP

Administradores y usuarios que realizan las configuraciones

Las tareas de esta página las realizan personas con los siguientes roles en Google Cloud o en su sistema SAP:

| Tipo de usuario | Descripción |

|---|---|

| Administrador de Google Cloud | Los usuarios con este rol son administradores de cuentas de Google Cloud. |

| Usuario de Cloud Data Fusion | Los usuarios a los que se les asignó este rol están autorizados para diseñar y ejecutar canalizaciones de datos. Se les otorga, como mínimo, el rol de Visualizador de Data Fusion (

roles/datafusion.viewer). Si usas el control de acceso basado en roles, es posible que necesites roles adicionales.

|

| Administrador de SAP | Los usuarios con este rol son administradores del sistema SAP. Tiene acceso para descargar software desde el sitio del servicio de SAP. No es un rol de IAM. |

| Usuario de SAP | Los usuarios con este rol están autorizados a conectarse a un sistema SAP. No es un rol de IAM. |

Operaciones de replicación admitidas

El complemento de replicación de SAP SLT admite las siguientes operaciones:

Modelado de datos: Este complemento admite todas las operaciones de modelado de datos (registros insert, delete y update).

Definición de datos: Como se describe en la Nota de SAP 2055599 (se requiere acceso de asistencia de SAP para verla), existen limitaciones en cuanto a qué cambios en la estructura de la tabla del sistema de origen se replican automáticamente con SLT. Algunas operaciones de definición de datos no se admiten en el complemento (debes propagarlas manualmente).

- Compatible:

- Agrega un campo sin clave (después de realizar cambios en SE11, activa la tabla con SE14).

- No compatible:

- Agregar o borrar el campo de clave

- Borra el campo que no es clave

- Modifica los tipos de datos

Requisitos de SAP

Los siguientes elementos son obligatorios en tu sistema SAP:

- Tienes instalada la versión 2011 SP17 o posterior de SLT Server en el sistema SAP de origen (incorporado) o como un sistema central de SLT dedicado.

- Tu sistema SAP de origen es SAP ECC o SAP S/4HANA, que admite DMIS 2011 SP17 o versiones posteriores, como DMIS 2018 o DMIS 2020.

- Tu complemento de interfaz de usuario de SAP debe ser compatible con tu versión de SAP NetWeaver.

Tu paquete de asistencia admite la clase

/UI2/CL_JSONPL 12o posterior. De lo contrario, implementa la Nota de SAP más reciente para la clase/UI2/CL_JSONcorrectionssegún la versión del complemento de la interfaz de usuario, como la Nota de SAP 2798102 paraPL12.Se implementaron las siguientes medidas de seguridad:

Requisitos de Cloud Data Fusion

- Necesitas una instancia de Cloud Data Fusion, versión 6.4.0 o posterior, de cualquier edición.

- La cuenta de servicio asignada a la instancia de Cloud Data Fusion tiene los roles necesarios (consulta Cómo otorgar permiso de usuario de cuenta de servicio).

- Para las instancias privadas de Cloud Data Fusion, se requiere el intercambio de tráfico entre VPCs.

Requisitos deGoogle Cloud

- Habilita la API de Cloud Storage en tu proyecto de Google Cloud .

- El usuario de Cloud Data Fusion debe tener permiso para crear carpetas en el bucket de Cloud Storage (consulta Roles de IAM para Cloud Storage).

- Opcional: Establece la política de retención, si tu organización lo requiere.

Crea el bucket de almacenamiento

Antes de crear un trabajo de replicación de SLT, crea el bucket de Cloud Storage. El trabajo transfiere datos al bucket y actualiza el bucket de transferencia cada cinco minutos. Cuando ejecutas el trabajo, Cloud Data Fusion lee los datos del bucket de almacenamiento y los escribe en BigQuery.

Si SLT está instalado en Google Cloud

El servidor de SLT debe tener permiso para crear y modificar objetos de Cloud Storage en el bucket que creaste.

Como mínimo, otorga los siguientes roles a la cuenta de servicio:

- Creador de tokens de cuenta de servicio (

roles/iam.serviceAccountTokenCreator) - Consumidor de Service Usage (

roles/serviceusage.serviceUsageConsumer) - Administrador de objetos de almacenamiento (

roles/storage.objectAdmin)

Si SLT no está instalado en Google Cloud

Instala Cloud VPN o Cloud Interconnect entre la VM de SAP yGoogle Cloud para permitir la conexión a un extremo de metadatos interno (consulta Configura el Acceso privado a Google para hosts locales).

Si no se pueden asignar los metadatos internos, haz lo siguiente:

Instala Google Cloud CLI según el sistema operativo de la infraestructura en la que se ejecuta SLT.

Crea una cuenta de servicio en el proyecto Google Cloud en el que está habilitado Cloud Storage.

En el sistema operativo de SLT, autoriza el acceso a Google Cloud con una cuenta de servicio.

Crea una clave de API para la cuenta de servicio y autoriza el alcance relacionado con Cloud Storage.

Importa la clave de API a gcloud CLI que instalaste antes con la CLI.

Para habilitar el comando de gcloud CLI que imprime el token de acceso, configura el comando del sistema operativo de SAP en la herramienta de transacción SM69 del sistema SLT.

Imprime un token de acceso

El administrador de SAP configura el comando del sistema operativo, SM69, que recupera un token de acceso de Google Cloud.

Crea una secuencia de comandos para imprimir un token de acceso y configura un comando del sistema operativo SAP para llamar a la secuencia de comandos como usuario <sid>adm desde el host de SAP LT Replication Server.

Linux

Para crear un comando del SO, haz lo siguiente:

En el host de SAP LT Replication Server, en un directorio al que pueda acceder

<sid>adm, crea una secuencia de comandos bash que contenga las siguientes líneas:PATH_TO_GCLOUD_CLI/bin/gcloud auth print-access-token SERVICE_ACCOUNT_NAMECrea un comando externo del SO con la interfaz de usuario de SAP:

- Ingresa la transacción

SM69. - Haz clic en Crear.

- En la sección Comando del panel Comando externo, ingresa el nombre del comando, como

ZGOOGLE_CDF_TOKEN. En la sección Definición:

- En el campo Comando del sistema operativo, ingresa

shcomo la extensión del archivo de secuencia de comandos. En el campo Parámetros para el comando del sistema operativo, ingresa lo siguiente:

/PATH_TO_SCRIPT/FILE_NAME.sh

- En el campo Comando del sistema operativo, ingresa

Haz clic en Guardar.

Para probar la secuencia de comandos, haz clic en Ejecutar.

Haz clic de nuevo en Ejecutar.

Se muestra un token Google Cloud en la parte inferior del panel de la interfaz de usuario de SAP.

- Ingresa la transacción

Windows

Crea un comando de sistema operativo externo con la interfaz de usuario de SAP:

- Ingresa la transacción

SM69. - Haz clic en Crear.

- En la sección Comando del panel Comando externo, ingresa el nombre del comando, como

ZGOOGLE_CDF_TOKEN. En la sección Definición:

- En el campo Comando del sistema operativo, ingresa

cmd /c. En el campo Parámetros para el comando del sistema operativo, ingresa lo siguiente:

gcloud auth print-access-token SERVICE_ACCOUNT_NAME

- En el campo Comando del sistema operativo, ingresa

Haz clic en Guardar.

Para probar la secuencia de comandos, haz clic en Ejecutar.

Haz clic de nuevo en Ejecutar.

Se muestra un token de Google Cloud en la parte inferior del panel de la interfaz de usuario de SAP.

Requisitos de SLT

El conector SLT debe tener la siguiente configuración:

- El conector admite SAP ECC NW 7.02, DMIS 2011 SP17 y versiones posteriores.

- Configura una conexión de base de datos o RFC entre SLT y el sistema de Cloud Storage.

- Configura los certificados SSL:

- Descarga los siguientes certificados de la CA del repositorio de Google Trust Services:

- GTS Root R1

- GTS CA 1C3

- En la interfaz de usuario de SAP, usa la transacción

STRUSTpara importar el certificado raíz y el subordinado a la carpetaSSL Client (Standard) PSE.

- Descarga los siguientes certificados de la CA del repositorio de Google Trust Services:

- Internet Communication Manager (ICM) debe configurarse para HTTPS. Asegúrate de que los puertos HTTP y HTTPS se mantengan y activen en el sistema SAP SLT.

Esto se puede verificar con el código de transacción

SMICM > Services. - Habilita el acceso a las APIs de Google Cloud en la VM en la que se aloja el sistema SAP SLT. Esto permite la comunicación privada entre los servicios deGoogle Cloud sin enrutamiento a través de Internet pública.

- Asegúrate de que la red pueda admitir el volumen y la velocidad requeridos de la transferencia de datos entre la infraestructura de SAP y Cloud Storage. Para una instalación exitosa, se recomienda Cloud VPN o Cloud Interconnect. El rendimiento de la API de transmisión depende de las cuotas de cliente que se hayan otorgado a tu proyecto de Cloud Storage.

Configura el servidor de replicación de SLT

El usuario de SAP realiza los siguientes pasos.

En los siguientes pasos, conectarás el servidor SLT al sistema de origen y al bucket en Cloud Storage, y especificarás el sistema de origen, las tablas de datos que se replicarán y el bucket de almacenamiento de destino.

Configura el SDK de Google ABAP

Para configurar SLT para la replicación de datos (una vez por instancia de Cloud Data Fusion), sigue estos pasos:

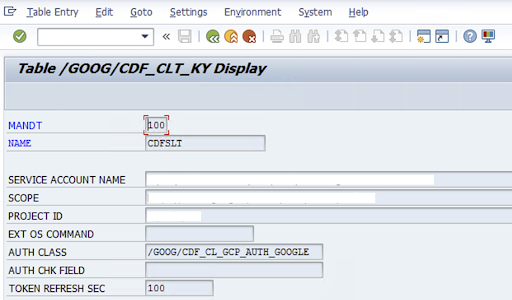

Para configurar el conector de SLT, el usuario de SAP ingresa la siguiente información en la pantalla de configuración (transacción de SAP

/GOOG/CDF_SETTINGS) sobre la clave de la cuenta de servicio para transferir datos a Cloud Storage. Google Cloud Configura las siguientes propiedades en la tabla /GOOG/CDF_CLT_KY con la transacción SE16 y anota esta clave:- NAME: El nombre de la clave de tu cuenta de servicio (por ejemplo,

CDFSLT) - NOMBRE DE LA CUENTA DE SERVICIO: Es el nombre de la cuenta de servicio de IAM.

- SCOPE: Es el alcance de la cuenta de servicio.

- ID DEL PROYECTO: Es el ID de tu Google Cloud proyecto.

- Opcional: Comando del SO externo: Usa este campo solo si SLT no está instalado en Google Cloud

CLASE DE AUTORIZACIÓN: Si el comando del SO está configurado en la tabla

/GOOG/CDF_CLT_KY, usa el valor fijo:/GOOG/CDF_CL_GCP_AUTH.TOKEN REFRESH SEC: Duración de la actualización del token de autorización

- NAME: El nombre de la clave de tu cuenta de servicio (por ejemplo,

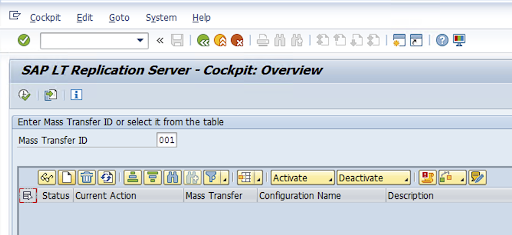

Crea la configuración de replicación

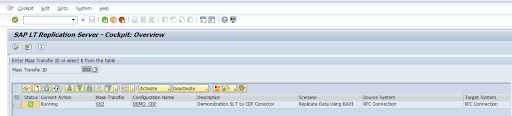

Crea una configuración de replicación en el código de transacción: LTRC.

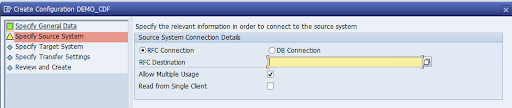

- Antes de continuar con la configuración de LTRC, asegúrate de que se haya establecido la conexión RFC entre SLT y el sistema SAP de origen.

- Para una configuración de SLT, es posible que haya varias tablas de SAP asignadas para la replicación.

Ve al código de transacción

LTRCy haz clic en Nueva configuración.

Ingresa el Nombre de la configuración y la Descripción, y haz clic en Siguiente.

Especifica la conexión RFC del sistema SAP de origen y haz clic en Siguiente.

En Target System Connection Details, selecciona Other.

Expande el campo Scenario for RFC Communication, selecciona SLT SDK y haz clic en Next.

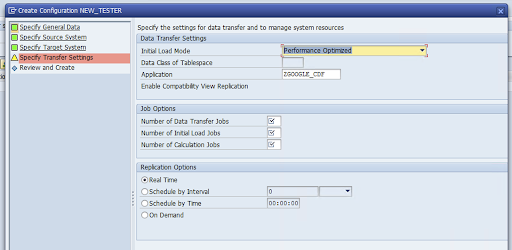

Ve a la ventana Specify Transfer Settings y, luego, ingresa el nombre de la aplicación:

ZGOOGLE_CDF.

Ingresa la cantidad de trabajos de transferencia de datos, la cantidad de trabajos de carga iniciales y la cantidad de trabajos de cálculo. Para obtener más información sobre el rendimiento, consulta la guía de optimización del rendimiento de SAP LT Replication Server.

Haz clic en En tiempo real > Siguiente.

Revisa la configuración y haz clic en Guardar. Anota el ID de transferencia masiva para los siguientes pasos.

Para mantener el ID de transferencia masiva y los detalles de la tabla de SAP, ejecuta la transacción de SAP:

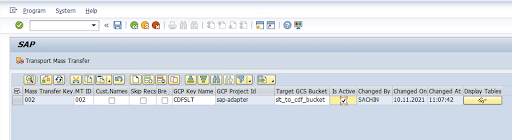

/GOOG/CDF_SETTINGS.Haz clic en Ejecutar o presiona

F8.Haz clic en el ícono de agregar fila para crear una entrada nueva.

Ingresa el ID de transferencia masiva, la clave de transferencia masiva, el nombre de la clave de GCP y el bucket de GCS de destino. Selecciona la casilla de verificación Is Active y guarda los cambios.

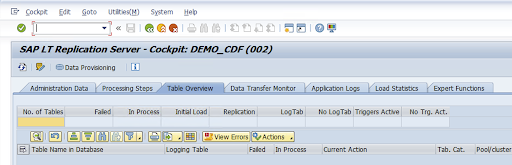

Selecciona la configuración en la columna Nombre de configuración y haz clic en Aprovisionamiento de datos.

Opcional: Personaliza los nombres de la tabla y los campos.

Haz clic en Nombres personalizados y guarda los cambios.

Haz clic en Pantalla.

Haz clic en los botones Agregar fila o Crear para crear una entrada nueva.

Ingresa el nombre de la tabla de SAP y el nombre de la tabla externa que se usarán en BigQuery, y guarda los cambios.

Haz clic en el botón Ver en la columna Campos de visualización para mantener la asignación de los campos de la tabla.

Se abrirá una página con las asignaciones sugeridas. Opcional: Edita el Nombre del campo temporal y la Descripción del campo, y, luego, guarda las asignaciones.

Ve a la transacción LTRC.

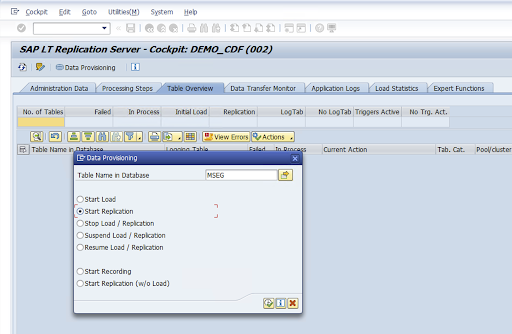

Selecciona el valor en la columna Configuration Name y haz clic en Data Provisioning.

Ingresa el nombre de la tabla en el campo Nombre de la tabla en la base de datos y selecciona la situación de replicación.

Haz clic en Ejecutar. Esto activa la implementación del SDK de SLT y comienza a transferir los datos al bucket de destino en Cloud Storage.

Instala archivos de transporte de SAP

Para diseñar y ejecutar trabajos de replicación en Cloud Data Fusion, los componentes de SAP se entregan como archivos de transporte de SAP que se archivan en un archivo zip. La descarga está disponible cuando implementas el complemento en el Centro de noticias de Cloud Data Fusion.

Para instalar los transportes de SAP, sigue estos pasos:

Paso 1: Sube los archivos de solicitud de transporte

- Accede al sistema operativo de la instancia de SAP.

- Usa el código de transacción

AL11de SAP para obtener la ruta de acceso de la carpetaDIR_TRANS. Por lo general, la ruta es/usr/sap/trans/. - Copia los coarchivos a la carpeta

DIR_TRANS/cofiles. - Copia los archivos de datos a la carpeta

DIR_TRANS/data. - Establece el usuario y el grupo de datos y el archivo compartido en

<sid>admysapsys.

Paso 2: Importa los archivos de solicitud de transporte

El administrador de SAP puede importar los archivos de solicitud de transporte con el sistema de administración de transporte de SAP o el sistema operativo:

Sistema de administración de transporte de SAP

- Accede al sistema SAP como administrador de SAP.

- Ingresa el STMS de la transacción.

- Haz clic en Overview > Imports.

- En la columna Cola, haz doble clic en el SID actual.

- Haz clic en Adicionales > Otras solicitudes > Agregar.

- Selecciona el ID de la solicitud de transporte y haz clic en Continuar.

- Selecciona la solicitud de transporte en la cola de importación y, luego, haz clic en Solicitud > Importar.

- Ingresa el número de cliente.

En la pestaña Opciones, selecciona Reemplazar originales y, también, Ignorar versión de componente no válida (si está disponible).

Opcional: Si deseas volver a importar los transportes más adelante, haz clic en Dejar solicitudes de transporte en la cola para importarlas más tarde y Volver a importar solicitudes de transporte. Esto es útil para las actualizaciones del sistema SAP y las restauraciones de copias de seguridad.

Haz clic en Continuar.

Verifica que el módulo de función y los roles de autorización se hayan importado de forma correcta con transacciones, como

SE80yPFCG.

Sistema operativo

- Accede al sistema SAP como administrador de SAP.

Agrega solicitudes al búfer de importación:

tp addtobuffer TRANSPORT_REQUEST_ID SIDPor ejemplo:

tp addtobuffer IB1K903958 DD1.Importa las solicitudes de transporte:

tp import TRANSPORT_REQUEST_ID SID client=NNN U1238Reemplaza

NNNpor el número de cliente. Por ejemplo:tp import IB1K903958 DD1 client=800 U1238Verifica que el módulo de función y los roles de autorización se hayan importado de forma correcta mediante las transacciones adecuadas, como

SE80yPFCG.

Autorizaciones necesarias de SAP

Para ejecutar una canalización de datos en Cloud Data Fusion, necesitas un usuario de SAP. El usuario de SAP debe ser de tipo Communications o Dialog. Para evitar el uso de recursos de diálogo de SAP, se recomienda el tipo de comunicaciones. El administrador de SAP puede crear usuarios con el código de transacción SU01 de SAP.

Se requieren autorizaciones de SAP para mantener y configurar el conector para SAP, una combinación de objetos de autorización estándar de SAP y del conector nuevo. Mantienes los objetos de autorización según las políticas de seguridad de tu organización. En la siguiente lista, se describen algunas autorizaciones importantes que necesita el conector:

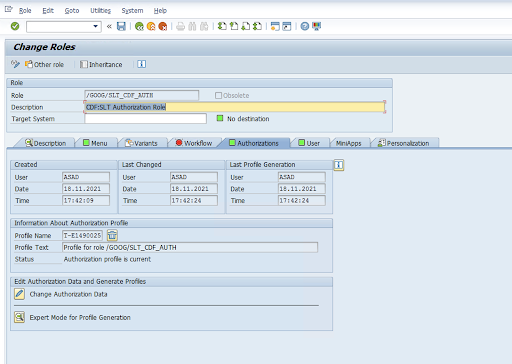

Objeto de autorización: El objeto de autorización

ZGOOGCDFMTse incluye como parte del rol de solicitud de transporte.Creación de roles: Crea un rol con el código de transacción

PFCG.

En el caso de los objetos de autorización estándar de SAP, tu organización administra los permisos con su propio mecanismo de seguridad.

Para los objetos de autorización personalizados, proporciona valores en los campos de autorización para los objetos de autorización

ZGOOGCDFMT.Para el control de acceso detallado,

ZGOOGCDFMTproporciona autorización basada en grupos de autorización. Los usuarios con acceso completo, parcial o nulo a los grupos de autorización reciben acceso según el grupo de autorización asignado en su rol./GOOG/SLT_CDF_AUTH: Es el rol con acceso a todos los grupos de autorización. Para restringir el acceso a un grupo de autorización en particular, mantén el FICDF del grupo de autorización en la configuración.

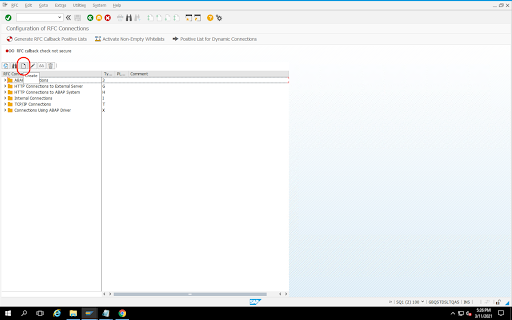

Crea un destino de RFC para la fuente

Antes de comenzar con la configuración, asegúrate de que la conexión RFC esté establecida entre el origen y el destino.

Ve al código de transacción

SM59.Haz clic en Create > Connection Type 3 (ABAP Connection).

En la ventana Configuración técnica, ingresa los detalles sobre el destino de RFC.

Haz clic en la pestaña Logon and Security para mantener las credenciales de RFC (usuario y contraseña de RFC).

Haz clic en Guardar.

Haz clic en Connection Test. Después de una prueba exitosa, puedes continuar.

Verifica que la prueba de autorización de RFC se haya realizado correctamente.

Haz clic en Utilidades > Prueba > Prueba de autorización.

Cómo configurar el complemento

Para configurar el complemento, impleméntalo desde el Hub, crea un trabajo de replicación y configura el origen y el destino con los siguientes pasos.

Implementa el complemento en Cloud Data Fusion

El usuario de Cloud Data Fusion realiza los siguientes pasos.

Antes de ejecutar el trabajo de replicación de Cloud Data Fusion, implementa el complemento de replicación de SAP SLT:

Sigue estos pasos para ir a tu instancia:

En la consola de Google Cloud , ve a la página Instancias de Cloud Data Fusion.

Habilita la replicación en una instancia nueva o existente:

- Para una instancia nueva, haz clic en Crear instancia, ingresa un nombre de instancia, haz clic en Agregar aceleradores, selecciona la casilla de verificación Replicación y haz clic en Guardar.

- Si se trata de una instancia existente, consulta Habilita la replicación en una instancia existente.

Haz clic en Ver instancia para abrir la instancia en la interfaz web de Cloud Data Fusion.

Haz clic en Hub.

Ve a la pestaña SAP, haz clic en SAP SLT y, luego, en SAP SLT Replication Plugin o SAP SLT No RFC Replication Plugin.

Haz clic en Implementar.

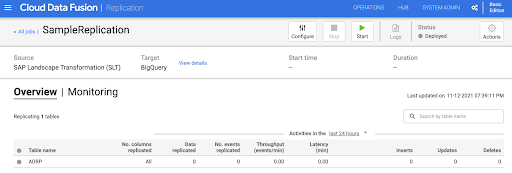

Crea un trabajo de replicación

El complemento de SAP SLT Replication lee el contenido de las tablas de SAP con un bucket de transferencia de la API de Cloud Storage.

Para crear un trabajo de replicación para tu transferencia de datos, sigue estos pasos:

En la instancia abierta de Cloud Data Fusion, haz clic en Página principal > Replicación > Crear un trabajo de replicación. Si no hay una opción de Replicación, habilita la replicación para la instancia.

Ingresa un Nombre y una Descripción únicos para el trabajo de replicación.

Haz clic en Siguiente.

Configura la fuente

Para configurar la fuente, ingresa valores en los siguientes campos:

- ID del proyecto: Es el ID de tu proyecto de Google Cloud (este campo se completa previamente).

Ruta de acceso de GCS de replicación de datos: Es la ruta de acceso de Cloud Storage que contiene datos para la replicación. Debe ser la misma ruta que se configuró en los trabajos de SAP SLT. De forma interna, la ruta de acceso proporcionada se concatena con

Mass Transfer IDySource Table Name:Formato:

gs://<base-path>/<mass-transfer-id>/<source-table-name>Ejemplo:

gs://slt_bucket/012/MARAGUID: Es el GUID de SLT, un identificador único asignado al ID de transferencia masiva de SAP SLT.

ID de transferencia masiva: El ID de transferencia masiva de SLT es un identificador único asignado a la configuración en SAP SLT.

Ruta de acceso de GCS de la biblioteca de SAP JCo: Es la ruta de acceso de almacenamiento que contiene los archivos de la biblioteca de SAP JCo subidos por el usuario. Las bibliotecas de SAP JCo se pueden descargar desde el portal de asistencia de SAP. (Se quitó en la versión 0.10.0 del complemento).

Host del servidor SLT: Nombre de host o dirección IP del servidor SLT. (Se quitó en la versión 0.10.0 del complemento).

Número de sistema SAP: Es el número de sistema de instalación que proporciona el administrador del sistema (por ejemplo,

00). (Se quitó en la versión 0.10.0 del complemento).Cliente de SAP: Cliente de SAP que se usará (por ejemplo,

100). (Se quitó en la versión 0.10.0 del complemento).Lenguaje de SAP: Lenguaje de inicio de sesión de SAP (por ejemplo,

EN). (Se quitó en la versión 0.10.0 del complemento).Nombre de usuario de inicio de sesión de SAP: Nombre de usuario de SAP. (Se quitó en la versión 0.10.0 del complemento).

- Recomendación: Si el nombre de usuario de inicio de sesión de SAP cambia de forma periódica, usa una macro.

Contraseña de inicio de sesión de SAP (M): Contraseña de usuario de SAP para la autenticación del usuario.

- Recomendación: Usa macros seguras para valores sensibles, como contraseñas. (Se quitó en la versión 0.10.0 del complemento).

Suspender la replicación de SLT cuando se detenga el trabajo de CDF: Intenta detener el trabajo de replicación de SLT (para las tablas involucradas) cuando se detiene el trabajo de replicación de Cloud Data Fusion. Es posible que falle si el trabajo en Cloud Data Fusion se detiene de forma inesperada.

Replicate Existing Data: Indica si se deben replicar los datos existentes de las tablas de origen. De forma predeterminada, los trabajos replican los datos existentes de las tablas de origen. Si se configura como

false, se ignoran los datos existentes en las tablas de origen y solo se replican los cambios que se producen después de que se inicia el trabajo.Clave de la cuenta de servicio: Es la clave que se usa cuando se interactúa con Cloud Storage. La cuenta de servicio debe tener permiso para escribir en Cloud Storage. Cuando se ejecuta en una VM de Google Cloud , este parámetro debe establecerse en

auto-detectpara usar la cuenta de servicio adjunta a la VM.

Haz clic en Siguiente.

Configura el destino

Para escribir datos en BigQuery, el complemento requiere acceso de escritura a BigQuery y a un bucket de etapa de pruebas. Primero, los eventos de cambio se escriben por lotes desde SLT en Cloud Storage. Luego, se cargan en tablas de etapa intermedia en BigQuery. Los cambios de la tabla de etapa de pruebas se combinan en la tabla de destino final con una consulta de combinación de BigQuery.

La tabla de destino final incluye todas las columnas originales de la tabla de origen, además de una columna _sequence_num adicional. El número de secuencia garantiza que los datos no se dupliquen ni se pierdan en situaciones de falla del replicador.

Para configurar la fuente, ingresa valores en los siguientes campos:

- ID del proyecto: Es el proyecto del conjunto de datos de BigQuery. Cuando se ejecuta en un clúster de Dataproc, se puede dejar en blanco, lo que usará el proyecto del clúster.

- Credenciales: Consulta Credenciales.

- Clave de cuenta de servicio: Es el contenido de la clave de cuenta de servicio que se usará cuando se interactúe con Cloud Storage y BigQuery. Cuando se ejecuta en un clúster de Dataproc, este campo debe dejarse en blanco, lo que usa la cuenta de servicio del clúster.

- Nombre del conjunto de datos: Es el nombre del conjunto de datos que se creará en BigQuery. Es opcional y, de forma predeterminada, el nombre del conjunto de datos es el mismo que el de la base de datos de origen. Un nombre válido solo debe contener letras, números y guiones bajos, y la longitud máxima puede ser de 1,024 caracteres. Los caracteres no válidos se reemplazarán por guiones bajos en el nombre final del conjunto de datos, y los caracteres que superen el límite de longitud se truncarán.

- Nombre de la clave de encriptación: Es la clave de encriptación administrada por el cliente (CMEK) que se usa para proteger los recursos creados por este destino. El nombre de la clave de encriptación debe tener el formato

projects/<project-id>/locations/<key-location>/keyRings/<key-ring-name>/cryptoKeys/<key-name>. - Ubicación: Es la ubicación en la que se crean el conjunto de datos de BigQuery y el bucket de Cloud Storage para la etapa de pruebas. Por ejemplo,

us-east1para los buckets regionales yuspara los buckets multirregionales (consulta Ubicaciones). Este valor se ignora si se especifica un bucket existente, ya que el bucket de transferencia y el conjunto de datos de BigQuery se crean en la misma ubicación que ese bucket. Bucket de etapa de pruebas: Es el bucket en el que se escriben los eventos de cambio antes de que se carguen en las tablas de etapa de pruebas. Los cambios se escriben en un directorio que contiene el nombre y el espacio de nombres del replicador. Es seguro usar el mismo bucket en varios replicadores dentro de la misma instancia. Si los replicadores la comparten en varias instancias, asegúrate de que el espacio de nombres y el nombre sean únicos. De lo contrario, el comportamiento no estará definido. El bucket debe estar en la misma ubicación que el conjunto de datos de BigQuery. Si no se proporciona, se crea un bucket nuevo para cada trabajo con el nombre

df-rbq-<namespace-name>-<job-name>-<deployment-timestamp>.Intervalo de carga (segundos): Es la cantidad de segundos que se espera antes de cargar un lote de datos en BigQuery.

Prefijo de la tabla de etapa de pruebas: Los cambios se escriben primero en una tabla de etapa de pruebas antes de combinarse con la tabla final. Los nombres de las tablas de etapa de pruebas se generan anteponiendo este prefijo al nombre de la tabla de destino.

Require Manual Drop Intervention: Indica si se requiere una acción administrativa manual para descartar tablas y conjuntos de datos cuando se detecta un evento de descarte de tabla o de base de datos. Cuando se establece en verdadero, el replicador no borra una tabla ni un conjunto de datos. En su lugar, falla y vuelve a intentarlo hasta que la tabla o el conjunto de datos no existan. Si el conjunto de datos o la tabla no existen, no se requiere ninguna intervención manual. El evento se omite como de costumbre.

Enable Soft Deletes: Si se establece en verdadero, cuando el destino recibe un evento de eliminación, la columna

_is_deleteddel registro se establece entrue. De lo contrario, el registro se borra de la tabla de BigQuery. Esta configuración no tiene efecto para una fuente que genera eventos fuera de orden y los registros siempre se borran de forma lógica de la tabla de BigQuery.

Haz clic en Siguiente.

Credenciales

Si el complemento se ejecuta en un clúster de Dataproc, la clave de la cuenta de servicio debe configurarse para que se detecte automáticamente. Las credenciales se leen automáticamente del entorno del clúster.

Si el complemento no se ejecuta en un clúster de Dataproc, se debe proporcionar la ruta de acceso a una clave de cuenta de servicio. La clave de la cuenta de servicio se puede encontrar en la página de IAM en la consola de Google Cloud . Asegúrate de que la clave de la cuenta tenga permiso para acceder a BigQuery. El archivo de clave de la cuenta de servicio debe estar disponible en todos los nodos del clúster y todos los usuarios que ejecuten el trabajo deben poder leerlo.

Limitaciones

- Las tablas deben tener una clave primaria para replicarse.

- No se admiten las operaciones de cambio de nombre de la tabla.

- Las modificaciones de tablas se admiten parcialmente.

- Una columna existente que no acepta valores nulos se puede modificar para que acepte valores nulos.

- Se pueden agregar columnas nuevas que acepten valores nulos a una tabla existente.

- Cualquier otro tipo de alteración del esquema de la tabla fallará.

- Los cambios en la clave primaria no fallarán, pero los datos existentes no se volverán a escribir para cumplir con la unicidad en la nueva clave primaria.

Selecciona tablas y transformaciones

En el paso Selecciona tablas y transformaciones, aparece una lista de las tablas seleccionadas para la replicación en el sistema SLT.

- Selecciona las tablas que se replicarán.

- Opcional: Selecciona operaciones de esquema adicionales, como Inserts, Updates o Deletes.

- Para ver el esquema, haz clic en Columnas para replicar en una tabla.

Opcional: Para cambiar el nombre de las columnas en el esquema, sigue estos pasos:

- Mientras ves el esquema, haz clic en Transformar > Cambiar nombre.

- En el campo Cambiar nombre, ingresa un nombre nuevo y haz clic en Aplicar.

- Para guardar el nombre nuevo, haz clic en Actualizar y Guardar.

Haz clic en Siguiente.

Opcional: Configura propiedades avanzadas

Si sabes cuántos datos replicarás en una hora, puedes seleccionar la opción adecuada.

Revisar la evaluación

En el paso Revisar evaluación, se analizan los problemas de esquema, las funciones faltantes o los problemas de conectividad que ocurren durante la replicación.

En la página Revisar la evaluación, haz clic en Ver asignaciones.

Si se produce algún problema, debes resolverlo antes de poder continuar.

Opcional: Si cambiaste el nombre de las columnas cuando seleccionaste las tablas y las transformaciones, verifica que los nombres nuevos sean correctos en este paso.

Haz clic en Siguiente.

Visualiza el resumen y, luego, implementa el trabajo de replicación

En la página Revisa los detalles del trabajo de replicación, revisa la configuración y haz clic en Implementa el trabajo de replicación.

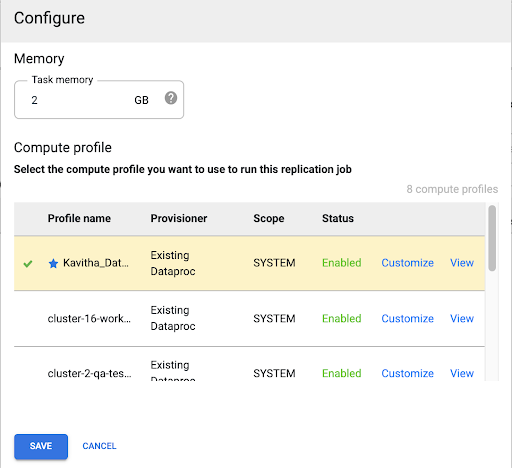

Selecciona un perfil de Compute Engine

Después de implementar el trabajo de replicación, haz clic en Configurar en cualquier página de la interfaz web de Cloud Data Fusion.

Selecciona el perfil de Compute Engine que deseas usar para ejecutar este trabajo de replicación.

Haz clic en Guardar.

Inicia el trabajo de replicación

- Para ejecutar el trabajo de replicación, haz clic en Iniciar.

Opcional: Optimiza el rendimiento

De forma predeterminada, el complemento está configurado para un rendimiento óptimo. Para obtener optimizaciones adicionales, consulta Argumentos de tiempo de ejecución.

El rendimiento de la comunicación entre SLT y Cloud Data Fusion depende de los siguientes factores:

- SLT en el sistema de origen en comparación con un sistema de SLT central dedicado (opción preferida)

- Procesamiento de trabajos en segundo plano en el sistema de SLT

- Procesos de trabajo de diálogo en el sistema SAP de origen

- Cantidad de procesos de trabajos en segundo plano asignados a cada ID de transferencia masiva en la pestaña Administración de LTRC

- Configuración de LTRS

- Hardware (CPU y memoria) del sistema de SLT

- La base de datos que se usa (por ejemplo, HANA, Sybase o DB2)

- El ancho de banda de Internet (conectividad entre el sistema SAP yGoogle Cloud a través de Internet)

- Utilización (carga) preexistente en el sistema

- Es la cantidad de columnas de la tabla. Con más columnas, la replicación se vuelve lenta y la latencia puede aumentar.

Se recomiendan los siguientes tipos de lectura en la configuración de LTRS para las cargas iniciales:

| Sistema de SLT | Sistema de origen | Tipo de tabla | Tipo de lectura recomendado [carga inicial] |

|---|---|---|---|

| SLT 3.0 independiente [DMIS 2018_1_752 SP 2] |

S/4 HANA 1909 | Transparente (pequeña o mediana) Transparente (grande) Tabla agrupada |

1 cálculo de rango 1 cálculo de rango 4 filas de remitentes |

| SLT integrada [S4CORE 104 HANA 1909] |

N/A | Transparente (pequeña o mediana) Transparente (grande) Tabla agrupada |

1 cálculo de rango 1 cálculo de rango 4 filas de remitentes |

| SLT 2.0 independiente [DMIS 2011_1_731 SP 17] |

ECC NW 7.02 | Transparente (pequeña/mediana) Transparente (grande) Tabla agrupada |

5 sender queue 5 sender queue 4 sender Queue |

| SLT integrado [DMIS 2011_1_700 SP 17] |

N/A | Transparente (pequeña o mediana) Transparente (grande) Tabla agrupada |

5 sender queue 5 sender queue 4 sender Queue |

- Para la replicación, usa No Ranges para mejorar el rendimiento:

- Los rangos solo se deben usar cuando se generan registros pendientes en una tabla de registro con latencia alta.

- Usa un cálculo de rango: No se recomienda el tipo de lectura para la carga inicial en el caso de los sistemas SLT 2.0 y Non-HANA.

- Usar un cálculo de rango: El tipo de lectura para la carga inicial podría generar registros duplicados en BigQuery.

- El rendimiento siempre es mejor cuando se usa un sistema de SLT independiente.

- Siempre se recomienda un sistema de SLT independiente si la utilización de recursos del sistema fuente ya es alta.

Argumentos de entorno de ejecución

snapshot.thread.count: Pasa la cantidad de subprocesos que se deben iniciar para realizar la carga de datos deSNAPSHOT/INITIALen paralelo. De forma predeterminada, usa la cantidad de CPU virtuales disponibles en el clúster de Dataproc en el que se ejecuta el trabajo de replicación.Recomendación: Solo establece este parámetro en los casos en los que necesites un control preciso sobre la cantidad de subprocesos paralelos (por ejemplo, para disminuir el uso en el clúster).

poll.file.count: Pasa la cantidad de archivos que se deben sondear desde la ruta de Cloud Storage proporcionada en el campo Ruta de GCS de replicación de datos de la interfaz web. De forma predeterminada, el valor es500por sondeo, pero, según la configuración del clúster, se puede aumentar o disminuir.Recomendación: Solo configura este parámetro si tienes requisitos estrictos para la demora en la replicación. Los valores más bajos podrían reducir la demora. Puedes usarlo para mejorar la capacidad de procesamiento (si no responde, usa valores más altos que el valor predeterminado).

bad.files.base.path: Pasa la ruta de acceso base de Cloud Storage en la que se copian todos los archivos de datos con errores o defectuosos que se encontraron durante la replicación. Esto es útil cuando hay requisitos estrictos para la auditoría de datos y se debe usar una ubicación específica para registrar las transferencias fallidas.De forma predeterminada, todos los archivos defectuosos se copian desde la ruta de Cloud Storage proporcionada en el campo Ruta de Cloud Storage de replicación de datos de la interfaz web.

Patrón de ruta de acceso final de archivos de datos defectuosos:

gs://BASE_FILE_PATH/MASS_TRANSFER_ID/SOURCE_TABLE_NAME/bad_files/REPLICATION_JOB_NAME/REPLICATION_JOB_ID/BAD_FILE_NAME

Ejemplo:

gs://slt_to_cdf_bucket/001/MARA/bad_files/MaraRepl/05f97349-7398-11ec-9443-8 ac0640fc83c/20220205_1901205168830_DATA_INIT.xml

Los criterios para determinar si un archivo es incorrecto son que esté dañado o no sea válido, que falten valores de PK o que haya un problema de discrepancia en el tipo de datos del campo.

Detalles de asistencia

Productos y versiones de SAP compatibles

- Versión SAP_BASIS 702, nivel de SP 0016 y posterior.

- Versión SAP_ABA 702, nivel de SP 0016 y posterior.

- Versión DMIS 2011_1_700, nivel de SP 0017 y versiones posteriores.

Versiones de SLT compatibles

Se admiten las versiones 2 y 3 de SLT.

Modelos de implementación de SAP compatibles

SLT como sistema independiente o incorporado en el sistema de origen

Notas de SAP que se deben implementar antes de comenzar a usar SLT

Si tu paquete de asistencia no incluye correcciones de la clase /UI2/CL_JSON para PL12 o versiones posteriores, implementa la nota de SAP más reciente para las correcciones de la clase /UI2/CL_JSON, por ejemplo, la nota de SAP 2798102 para PL12.

Recomendación: Implementa las notas de SAP recomendadas por el informe CNV_NOTE_ANALYZER_SLT según la condición del sistema central o de origen. Para obtener más información, consulta la Nota de SAP 3016862 (se requiere acceso a SAP).

Si SAP ya está configurado, no se debe implementar ninguna nota adicional. Si tienes errores o problemas específicos, consulta la nota central de SAP para tu versión de SLT.

Límites para el volumen de datos o el ancho del registro

No hay un límite definido para el volumen de datos extraídos ni el ancho del registro.

Capacidad de procesamiento esperada para el complemento de replicación de SAP SLT

Para un entorno configurado de acuerdo con los lineamientos de Optimiza el rendimiento, el complemento puede extraer alrededor de 13 GB por hora para la carga inicial y 3 GB por hora para la replicación (CDC). El rendimiento real puede variar según la carga del sistema SAP y Cloud Data Fusion, o el tráfico de red.

Compatibilidad con la extracción de datos delta (datos modificados) de SAP

Se admite la extracción delta de SAP.

Obligatorio: Peering de inquilinos para instancias de Cloud Data Fusion

El peering de arrendatario es obligatorio cuando la instancia de Cloud Data Fusion se crea con una dirección IP interna. Para obtener más información sobre el peering de inquilinos, consulta Crea una instancia privada.

Solucionar problemas

El trabajo de replicación se reinicia constantemente

Si el trabajo de replicación se reinicia automáticamente de forma continua, aumenta la memoria del clúster del trabajo de replicación y vuelve a ejecutarlo.

Duplicados en el receptor de BigQuery

Si defines la cantidad de trabajos paralelos en la configuración avanzada del complemento de replicación de SAP SLT, cuando tus tablas sean grandes, se producirá un error que generará columnas duplicadas en el receptor de BigQuery.

Para evitar el problema, quita los trabajos paralelos para cargar datos.

Situaciones de error

En la siguiente tabla, se enumeran algunos mensajes de error comunes (el texto entre comillas se reemplazará por los valores reales en el entorno de ejecución):

| ID de mensaje | Mensaje | Acción recomendada |

|---|---|---|

CDF_SAP_SLT_01402 |

Service account type is not defined for

SERVICE_ACCT_NAME_FROM_UI. |

Asegúrate de que la ruta de Cloud Storage proporcionada sea correcta. |

CDF_SAP_SLT_01403 |

Service account key provided is not valid due to error:

ROOT_CAUSE. Please provide a valid service account key for

service account type : SERVICE_ACCT_NAME_FROM_UI. |

Verifica la causa raíz que se muestra en el mensaje y toma las medidas correspondientes. |

CDF_SAP_SLT_01404 |

Mass Transfer ID could not be found. Please ensure that it exists

in given GCS Bucket. |

Verifica que el ID de transferencia masiva proporcionado tenga el formato correcto. |

CDF_SAP_SLT_01502 |

The specified data replication GCS path 'slt_to_cdf_bucket_1' or

Mass Transfer ID '05C' could not be found. Please ensure that it exists in

GCS. |

Asegúrate de que la ruta de Cloud Storage proporcionada sea correcta. |

CDF_SAP_SLT_01400 |

Metadata file not found. The META_INIT.json file is not present or

file is present with invalid format. |

Verifica la causa raíz que se muestra en el mensaje y toma las medidas correspondientes. |

CDF_SAP_SLT_03408 |

Failed to start the event reader. |

Verifica la causa raíz que se muestra en el mensaje y toma las medidas correspondientes. |

CDF_SAP_SLT_03409 |

Error while processing TABLE_NAME file for source table

gs://CLOUD_STORAGE_BUCKET_NAME/MT_ID/TABLE_NAME

/FILE_NAME. Root cause: ROOT_CAUSE. |

Verifica la causa raíz que se muestra en el mensaje y toma las medidas correspondientes. |

CDF_SAP_SLT_03410 |

Failed to replicate data for source table TABLE_NAME

from file: gs://CLOUD_STORAGE_BUCKET_NAME/MT_ID/

TABLE_NAME/FILE_NAME. Root cause:

ROOT_CAUSE. |

Verifica la causa raíz que se muestra en el mensaje y toma las medidas correspondientes. |

CDF_SAP_SLT_03411 |

Failed data replication for source table TABLE_NAME.

Root cause: ROOT_CAUSE. |

Verifica la causa raíz que se muestra en el mensaje y toma las medidas correspondientes. |

CDF_SAP_SLT_03412 |

Failed to create target table for source table

TABLE_NAME. Root cause: ROOT_CAUSE. |

Verifica la causa raíz que se muestra en el mensaje y toma las medidas correspondientes. |

Asignación de tipos de datos

En la siguiente tabla, se muestra la asignación entre los tipos de datos que se usan en las aplicaciones de SAP y Cloud Data Fusion.

| Tipo de datos SAP | Tipo de ABAP | Descripción (SAP) | Tipo de datos de Cloud Data Fusion |

|---|---|---|---|

| Numérico | |||

| INT1 | b | Número entero de 1 byte | int |

| INT2 | s | Número entero de 2 bytes | int |

| INT4 | i | Número entero de 4 bytes | int |

| INT8 | 8 | Número entero de 8 bytes | long |

| DIC | p | Número empaquetado en formato BCD (DEC) | decimal |

| DF16_DEC DF16_RAW |

a | Punto flotante decimal de 8 bytes, IEEE 754r | decimal |

| DF34_DEC DF34_RAW |

e | Punto flotante decimal de 16 bytes, IEEE 754r | decimal |

| FLTP | f | Número de punto flotante binario | double |

| Regla | |||

| CHAR LCHR |

c | Cadena de caracteres | string |

| SSTRING GEOM_EWKB |

cadena | Cadena de caracteres | string |

| STRING GEOM_EWKB |

cadena | CLOB de string de caracteres | bytes |

| NUMC ACCP |

n | Texto numérico | string |

| Byte | |||

| RAW LRAW |

x | Datos binarios | bytes |

| STRING SIN PROCESAR | xstring | BLOB de cadena de bytes | bytes |

| fecha/hora | |||

| DATS | d | Fecha | date |

| Tims | t | Hora | time |

| TIMESTAMP | utcl | ( Utclong ) TimeStamp |

timestamp |

¿Qué sigue?

- Obtén más información sobre Cloud Data Fusion.

- Obtén más información sobre SAP en Google Cloud.