Esta página descreve como ler várias tabelas de uma base de dados do Microsoft SQL Server, usando a origem de várias tabelas. Use a origem de várias tabelas quando quiser que o pipeline leia a partir de várias tabelas. Se quiser que o pipeline leia a partir de uma única tabela, consulte o artigo Ler a partir de uma tabela do SQL Server.

A origem de várias tabelas produz dados com vários esquemas e inclui um campo de nome da tabela que indica a tabela de onde os dados provêm. Quando usar a origem de várias tabelas, use um dos destinos de várias tabelas: várias tabelas do BigQuery ou vários ficheiros do GCS.

Antes de começar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator role

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator role

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Data Fusion, Cloud Storage, BigQuery, and Dataproc APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Crie uma instância do Cloud Data Fusion.

- Certifique-se de que a sua base de dados do SQL Server pode aceitar ligações do Cloud Data Fusion. Para o fazer de forma segura, recomendamos que crie uma instância privada do Cloud Data Fusion.

Na Google Cloud consola, aceda à página do Cloud Data Fusion.

Para abrir a instância no Cloud Data Fusion Studio, clique em Instâncias e, de seguida, em Ver instância.

Veja a sua instância do Cloud Data Fusion

Quando usa o Cloud Data Fusion, usa a Google Cloud consola e a IU do Cloud Data Fusion separada. Na Google Cloud consola, pode criar um Google Cloud projeto e criar e eliminar instâncias do Cloud Data Fusion. Na IU do Cloud Data Fusion, pode usar as várias páginas, como Studio ou Wrangler, para usar as funcionalidades do Cloud Data Fusion.

Armazene a palavra-passe do SQL Server como uma chave segura

Adicione a sua palavra-passe do SQL Server como uma chave segura para encriptar na sua instância do Cloud Data Fusion. Mais tarde, neste guia, vai certificar-se de que a sua palavra-passe é obtida através do Cloud KMS.

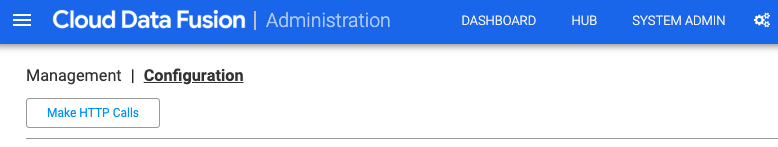

No canto superior direito de qualquer página do Cloud Data Fusion, clique em Administrador do sistema.

Clique no separador Configuração.

Clique em Fazer chamadas HTTP.

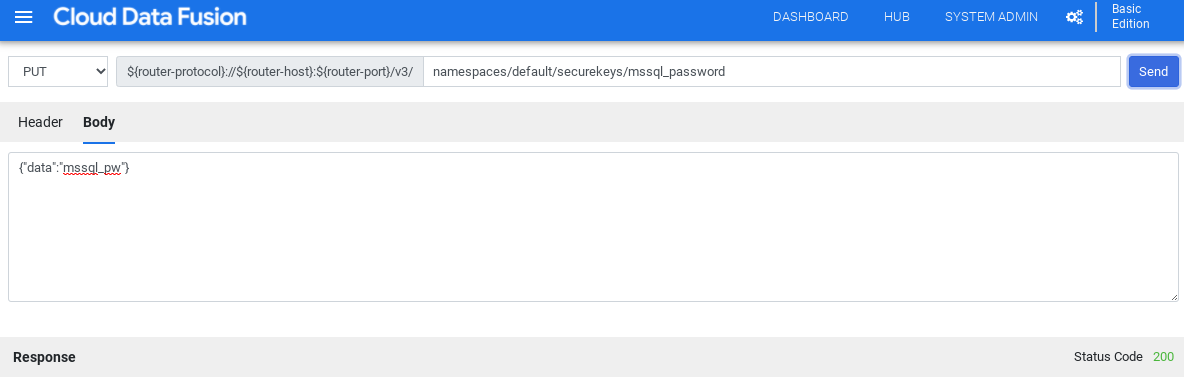

No menu pendente, escolha PUT.

No campo do caminho, introduza

namespaces/NAMESPACE_ID/securekeys/PASSWORD.No campo Corpo, introduza

{"data":"SQL_SERVER_PASSWORD"}.Clique em Enviar.

Certifique-se de que a resposta que recebe tem o código de estado 200.

Obtenha o controlador JDBC para o SQL Server

Usar o Hub

Na IU do Cloud Data Fusion, clique em Hub.

Na barra de pesquisa, introduza

Microsoft SQL Server JDBC Driver.Clique em Controlador JDBC do Microsoft SQL Server.

Clique em Transferir. Siga os passos de transferência apresentados.

Clique em Implementar. Carregue o ficheiro JAR do passo anterior.

Clique em Concluir.

Usar o Studio

Aceda a Microsoft.com.

Escolha a transferência e clique em Transferir.

Na IU do Cloud Data Fusion, clique em Menu e navegue para a página Studio.

Clique em Adicionar.

Em Driver, clique em Carregar.

Carregue o ficheiro JAR transferido no passo 2.

Clicar em Seguinte.

Configure o controlador introduzindo um Nome.

No campo Nome da classe, introduza

com.microsoft.sqlserver.jdbc.SQLServerDriver.Clique em Concluir.

Implemente os plug-ins de várias tabelas

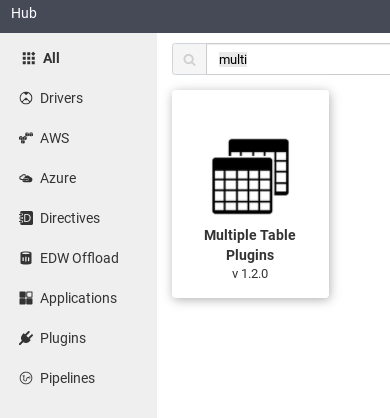

Na IU Web do Cloud Data Fusion, clique em Hub.

Na barra de pesquisa, introduza

Multiple table plugins.Clique em Vários plug-ins de tabelas.

Clique em Implementar.

Clique em Concluir.

Clique em Criar um pipeline.

Estabeleça ligação ao SQL Server

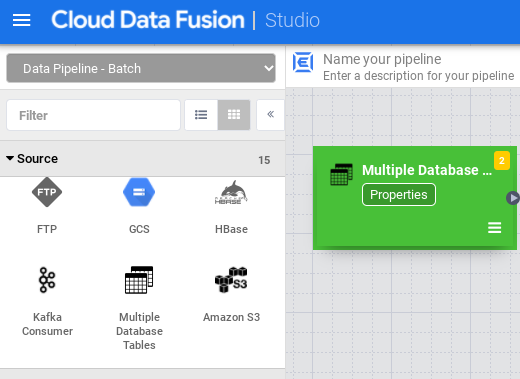

Na IU do Cloud Data Fusion, clique em Menu e navegue para a página Studio.

No Studio, expanda o menu Fonte.

Clique em Várias tabelas de base de dados.

Passe o ponteiro do rato sobre o nó Várias tabelas de base de dados e clique em Propriedades.

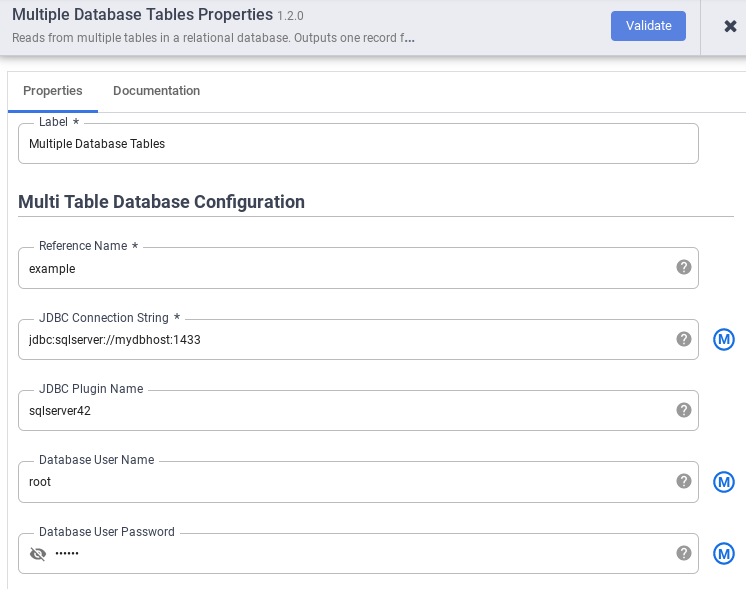

No campo Nome de referência, especifique um nome de referência que vai ser usado para identificar a sua origem do SQL Server.

No campo String de ligação JDBC, introduza a string de ligação JDBC. Por exemplo,

jdbc:sqlserver://mydbhost:1433. Para mais informações, consulte o artigo Crie o URL de ligação.Introduza o Nome do plugin JDBC, o Nome de utilizador da base de dados e a Palavra-passe do utilizador da base de dados.

Clique em Validar.

Clique em Fechar.

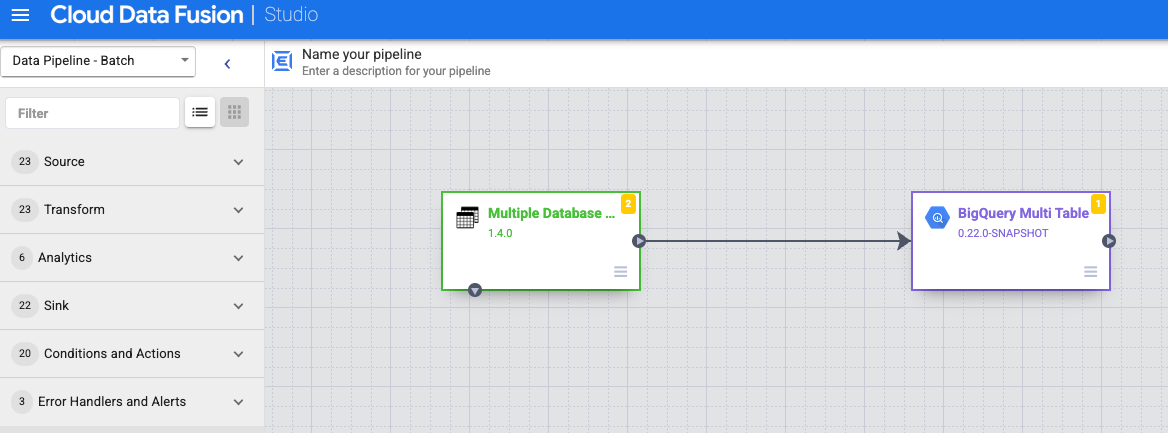

Associar ao BigQuery ou ao Cloud Storage

Na IU do Cloud Data Fusion, clique em Menu e navegue para a página Studio.

Expandir Lavatório.

Clique em BigQuery Multi Table ou GCS Multi File.

Associe o nó Tabelas de várias bases de dados com BigQuery Multi Table ou GCS Multi File.

Passe o ponteiro do rato sobre o nó BigQuery Multi Table ou GCS Multi File, clique em Propriedades e configure o destino.

Para mais informações, consulte os artigos Google BigQuery Multi Table Sink e Google Cloud Storage Multi File Sink.

Clique em Validar.

Clique em Fechar.

Execute uma pré-visualização do pipeline

Na IU do Cloud Data Fusion, clique em Menu e navegue para a página Studio.

Clique em Pré-visualizar.

Clique em Executar. Aguarde a conclusão da pré-visualização com êxito.

Implemente o pipeline

Na IU do Cloud Data Fusion, clique em Menu e navegue para a página Studio.

Clique em Implementar.

Execute o pipeline

Na IU do Cloud Data Fusion, clique em Menu.

Clique em Lista.

Clique no pipeline.

Na página de detalhes do pipeline, clique em Executar.

O que se segue?

- Saiba mais sobre o Cloud Data Fusion.

- Siga um dos tutoriais.