ベクトル検索のインタラクティブなデモで、最先端のベクトル検索テクノロジーの魅力をご体感ください。実際のデータセットを活用したデモで、ベクトル検索の仕組み、セマンティック検索とハイブリッド検索、再ランキングの流れを学ぶことができます。動物、植物、e コマースの商品、その他の項目の簡単な説明を送信すると、ベクトル検索が残りの手順を完了します。

試してみる

デモでさまざまなオプションを試すことで、ベクトル検索をいち早く開始し、ベクトル検索テクノロジーの基本を理解してください。

実行方法:

[クエリ] テキスト フィールドに、クエリするアイテムの説明(

vintage 1970s pinball machineなど)を入力します。または、[クエリを生成] をクリックして、説明を自動生成します。[送信] をクリックします。

デモでできることについて詳しくは、ユーザー インターフェースをご覧ください。

ユーザー インターフェース

このセクションでは、ベクトル検索が返す結果と、そのランク付け方法を制御するために使用できる UI の設定について説明します。

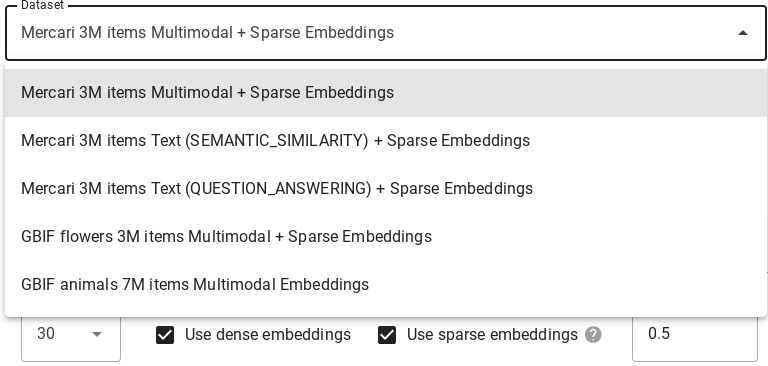

データセット

[データセット] プルダウンを使用して、ベクトル検索がクエリを実行するデータセットを選択します。各データセットの詳細については、データセットをご覧ください。

クエリ

[クエリ] フィールドに、説明または 1 つ以上のキーワードを追加して、ベクトル検索で検索するアイテムを指定します。または、[クエリを生成] をクリックして、説明を自動生成します。

変更

ベクトル検索が返す結果を変更するオプションがいくつかあります。

[行] をクリックし、ベクトル検索で返す検索結果の最大数を選択します。

ベクトル検索で意味的に類似した結果を返す場合は、[Use dense embeddings] を選択します。

ベクトル検索でクエリのテキスト構文に基づいて結果を返す場合は、[Use sparse embeddings] を選択します。使用可能なすべてのデータセットがスパース エンベディング モデルをサポートしているわけではありません。

ベクトル検索でハイブリッド検索を使用する場合は、[Use dense embeddings] と [Use sparse embeddings] の両方を選択します。すべてのデータセットがこのモデルをサポートしているわけではありません。ハイブリッド検索では、高密度エンベディングとスパース エンベディングの両方の要素を組み合わせて、検索結果の品質を高めることができます。詳細については、ハイブリッド検索についてをご覧ください。

[RRF Alpha] フィールドに 0.0~1.0 の値を入力して、RRF ランキング効果を指定します。

検索結果を再ランキングするには、[再ランキング] プルダウンから ranking_api を選択するか、[なし] を選択して再ランキングを無効にします。

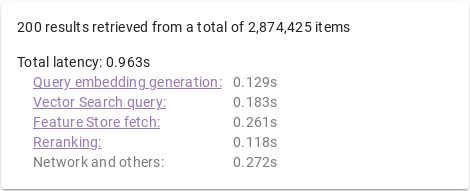

指標

クエリの実行後、検索のさまざまなステージの完了にかかった時間を分類したレイテンシ指標が提供されます。

クエリプロセス

クエリが処理されると、次の処理が行われます。

クエリ エンベディングの生成: 指定されたクエリテキストのエンベディングが生成されます。

ベクトル検索クエリ: クエリがベクトル検索インデックスで実行されます。

Vertex AI Feature Store の取得: ベクター検索が返すアイテム ID のリストを使用して、Vertex AI Feature Store から特徴量(アイテム名、説明、画像 URL など)が読み取られます。

再ランキング: 取得されたアイテムは、ランキング API によって並べ替えられます。ランキング API は、クエリテキスト、アイテム名、アイテムの説明を使用して関連性スコアを計算します。

エンベディング

マルチモーダル: 商品画像のマルチモーダル セマンティック検索。詳しくは、マルチモーダル検索とは何か: 「視覚を持った LLM」でビジネスが変わるをご覧ください。

テキスト(意味的類似性): 意味的類似性に基づいて、アイテム名と説明のテキスト セマンティック検索を行います。詳細については、Vertex AI Embeddings for Text で実現する LLM のグラウンディングをご覧ください。

テキスト(質問応答): 項目名と説明のテキスト セマンティック検索。タスクタイプ QUESTION_ANSWERING で検索品質が向上します。これは、Q&A タイプのアプリケーションに適しています。タスクタイプのエンベディングについては、Vertex AI エンベディングとタスクタイプを使った生成 AI のユースケース強化についてのブログ投稿をご覧ください。

スパース(ハイブリッド検索): TF-IDF アルゴリズムで生成された商品名と説明に対するキーワード(トークンベース)検索。詳細については、ハイブリッド検索についてをご覧ください。

データセット

インタラクティブ デモには、クエリを実行できるデータセットがいくつか含まれています。データセットは、エンベディング モデル、スパース エンベディングのサポート、エンベディング ディメンション、保存されたアイテムの数によって異なります。

| データセット | エンベディング モデル | スパース エンベディング モデル | エンベディング ディメンション | アイテム数 |

|---|---|---|---|---|

| メルカリ マルチモーダル + スパース エンベディング | マルチモーダル エンベディング | TF-IDF (アイテムの名前と説明) |

1408 | ~300 万 |

| メルカリ テキスト(意味的類似性)+ スパース エンベディング | text-embedding-005 (タスクタイプ: SEMANTIC_SIMILARITY) |

TF-IDF (アイテムの名前と説明) |

768 | ~300 万 |

| メルカリ テキスト(質問応答)+ スパース エンベディング | text-embedding-005 (タスクタイプ: QUESTION_ANSWERING) |

TF-IDF (アイテムの名前と説明) |

768 | ~300 万 |

| GBIF Flowers マルチモーダル + スパース エンベディング | マルチモーダル エンベディング | TF-IDF (アイテムの名前と説明) |

1408 | ~330 万 |

| GBIF 動物マルチモーダル エンベディング | マルチモーダル エンベディング | 該当なし | 1408 | ~700 万 |

次のステップ

デモに慣れたら、ベクトル検索の使用方法について詳しく学習しましょう。

クイックスタート: サンプル データセットを使ってインデックスの作成とデプロイを 30 分以内で行います。

始める前に: エンベディングを準備し、インデックスをデプロイするエンドポイントの種類を決定する方法を確認します。