Introdução

Esta página oferece uma breve vista geral conceptual dos métodos de atribuição de funcionalidades disponíveis com o Vertex AI.

A importância das funcionalidades globais (atribuições de funcionalidades do modelo) mostra como cada funcionalidade afeta um modelo. Os valores são uma percentagem para cada funcionalidade: quanto mais elevada for a percentagem, maior é o impacto que a funcionalidade teve no treino do modelo. Para ver a importância global das funcionalidades do seu modelo, examine as métricas de avaliação.

As atribuições de caraterísticas locais para modelos de intervalos temporais indicam a contribuição de cada caraterística nos dados para o resultado previsto. Use estas informações para verificar se o modelo se comporta como esperado, reconhecer a parcialidade nos seus modelos e obter ideias sobre formas de melhorar o modelo e os dados de preparação. Quando pede inferências, recebe valores previstos conforme adequado para o seu modelo. Quando pede explicações, recebe as inferências juntamente com informações de atribuição de funcionalidades.

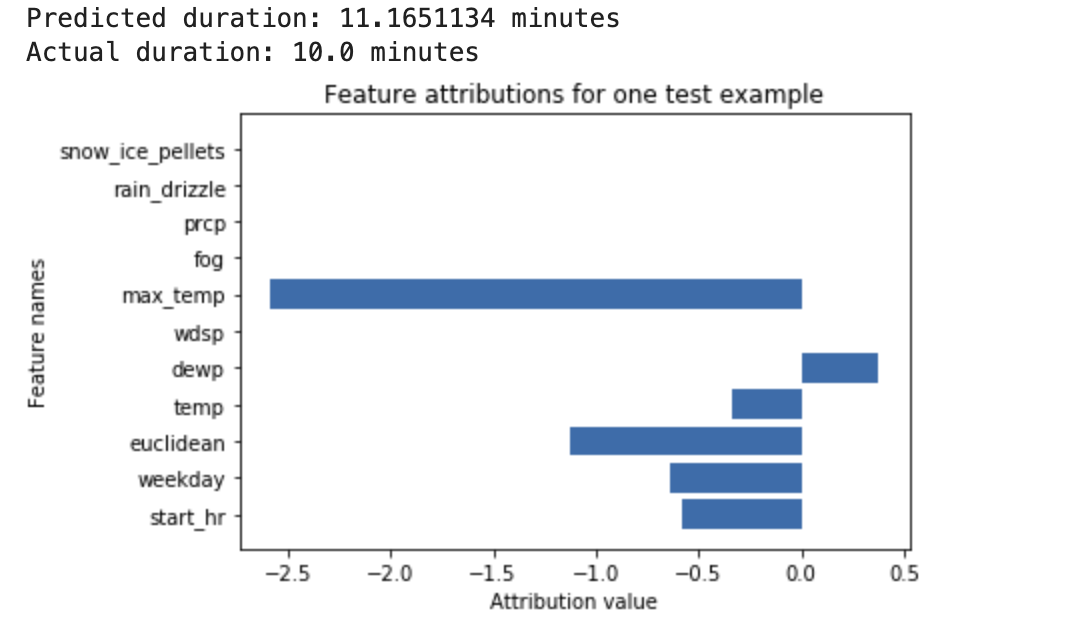

Considere o seguinte exemplo: uma rede neural profunda é preparada para prever a duração de um passeio de bicicleta com base em dados meteorológicos e dados anteriores de partilha de viagens. Se pedir apenas inferências a este modelo, recebe durações previstas de viagens de bicicleta em número de minutos. Se pedir explicações, recebe a duração prevista da viagem de bicicleta, juntamente com uma pontuação de atribuição para cada funcionalidade no seu pedido de explicações. As pontuações de atribuição mostram o quanto a funcionalidade afetou a alteração no valor de inferência, relativamente ao valor de referência que especificar. Escolha uma base significativa que faça sentido para o seu modelo. Neste caso, a duração mediana do passeio de bicicleta.

Pode traçar os resultados da atribuição de funcionalidades para ver que funcionalidades contribuíram mais fortemente para a inferência resultante:

Gere e consulte atribuições de caraterísticas locais quando executar uma tarefa de inferência online ou uma tarefa de inferência em lote.

Vantagens

Se inspecionar instâncias específicas e também agregar atribuições de caraterísticas no conjunto de dados de preparação, pode obter estatísticas mais detalhadas sobre o funcionamento do modelo. Considere as seguintes vantagens:

Depurar modelos: as atribuições de funcionalidades podem ajudar a detetar problemas nos dados que as técnicas de avaliação de modelos padrão normalmente não detetariam.

Otimizar modelos: pode identificar e remover funcionalidades menos importantes, o que pode resultar em modelos mais eficientes.

Limitações conceptuais

Considere as seguintes limitações das atribuições de funcionalidades:

As atribuições de funcionalidades, incluindo a importância das funcionalidades locais para o AutoML, são específicas das inferências individuais. A inspeção das atribuições de caraterísticas para uma inferência individual pode fornecer boas estatísticas, mas as estatísticas podem não ser generalizáveis a toda a classe para essa instância individual ou a todo o modelo.

Para obter estatísticas mais generalizáveis para os modelos do AutoML, consulte a importância das caraterísticas do modelo. Para obter estatísticas mais generalizáveis para outros modelos, agregue atribuições em subconjuntos do seu conjunto de dados ou no conjunto de dados completo.

Cada atribuição mostra apenas o quanto a funcionalidade afetou a inferência para esse exemplo específico. Uma única atribuição pode não refletir o comportamento geral do modelo. Para compreender o comportamento aproximado do modelo num conjunto de dados completo, agregue as atribuições no conjunto de dados completo.

Embora as atribuições de funcionalidades possam ajudar na depuração de modelos, nem sempre indicam claramente se um problema surge do modelo ou dos dados com os quais o modelo é preparado. Use o bom senso e diagnostique problemas de dados comuns para restringir o espaço de potenciais causas.

As atribuições dependem inteiramente do modelo e dos dados usados para preparar o modelo. Só podem revelar os padrões que o modelo encontrou nos dados e não conseguem detetar relações fundamentais nos dados. A presença ou a ausência de uma atribuição forte a uma determinada funcionalidade não significa que exista ou não uma relação entre essa funcionalidade e o alvo. A atribuição apenas mostra se o modelo está ou não a usar a funcionalidade nas respetivas inferências.

As atribuições por si só não conseguem determinar se o seu modelo é justo, imparcial ou de boa qualidade. Avalie cuidadosamente os dados de preparação e as métricas de avaliação, além das atribuições.

Para mais informações sobre as limitações, consulte o [Livro branco sobre as explicações de IA].

Melhorar as atribuições de funcionalidades

Os seguintes fatores têm o maior impacto nas atribuições de funcionalidades:

- Os métodos de atribuição aproximam-se do valor de Shapley. Pode aumentar a precisão da aproximação aumentando o número de caminhos para o método de Shapley com amostragem. Consequentemente, as atribuições podem mudar drasticamente.

- As atribuições apenas expressam o quanto a funcionalidade afetou a alteração no valor de inferência, em relação ao valor de base. Certifique-se de que escolhe uma base significativa e relevante para a pergunta que está a fazer ao modelo. Os valores de atribuição e a respetiva interpretação podem mudar significativamente quando altera as bases de referência.

Algoritmo

O Vertex AI fornece atribuições de caraterísticas através dos valores de Shapley, um algoritmo de teoria dos jogos cooperativos que atribui crédito a cada jogador num jogo por um resultado específico. Aplicado aos modelos de aprendizagem automática, isto significa que cada funcionalidade do modelo é tratada como um "jogador" no jogo e o crédito é atribuído proporcionalmente ao resultado de uma inferência específica. Para modelos de dados estruturados, o Vertex AI usa uma aproximação de amostragem dos valores de Shapley exatos denominada Shapley com amostragem.

Para informações detalhadas sobre o funcionamento do método de Shapley com amostragem, leia o artigo Bounding the Estimation Error of Sampling-based Shapley Value Approximation.

O que se segue?

Os seguintes recursos oferecem mais material educativo útil: