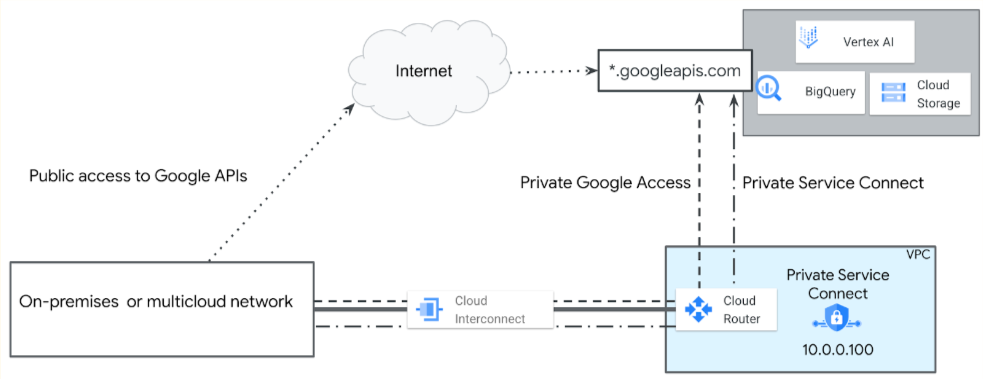

Ihre Anwendungen können aus Google Cloud oder aus Hybridnetzwerken (lokal und Multicloud) heraus eine Verbindung zu APIs in der Produktionsumgebung von Google herstellen.Google Cloud bietet die folgenden öffentlichen und privaten Zugriffsoptionen, die globale Erreichbarkeit und SSL/TLS-Sicherheit bieten:

- Öffentlicher Internetzugriff: Senden Sie Traffic an

REGION-aiplatform.googleapis.com. - Private Service Connect-Endpunkte für Google APIs: Verwenden Sie eine benutzerdefinierte interne IP-Adresse wie

10.0.0.100, um aufREGION-aiplatform.googleapis.comoder einen zugewiesenen DNS-Namen wieaiplatform-genai1.p.googleapis.comzuzugreifen.

Das folgende Diagramm veranschaulicht diese Zugriffsoptionen.

Bei einigen Vertex AI-Diensterstellern müssen Sie über Private Service Connect-Endpunkte oder Private Service Connect-Schnittstellen eine Verbindung zu ihren Diensten herstellen. Diese Dienste sind in der Tabelle Optionen für den privaten Zugriff auf Vertex AI aufgeführt.

Zwischen regionalen und globalen Vertex AI-Endpunkten wählen

Der regionale Vertex AI-Endpunkt (REGION-aiplatform.googleapis.com) ist die Standardmethode für den Zugriff auf Google APIs. Für Anwendungen, die in mehreren Google Cloud-Regionen bereitgestellt werden, sollten Sie den globalen Endpunkt (aiplatform.googleapis.com) für einen konsistenten API-Aufruf und ein robusteres Design verwenden, es sei denn, das gewünschte Modell oder die gewünschte Funktion ist nur regional verfügbar. Die Verwendung des globalen Endpunkts bietet unter anderem folgende Vorteile:

- Verfügbarkeit von Modellen und Funktionen: Einige der neuesten, spezialisierten oder regionsspezifischen Modelle und Funktionen in Vertex AI werden anfangs oder dauerhaft nur über einen regionalen Endpunkt (z. B.

us-central1-aiplatform.googleapis.com) angeboten. Wenn Ihre Anwendung von einer dieser spezifischen Ressourcen abhängt, müssen Sie den regionalen Endpunkt verwenden, der dem Standort der Ressource entspricht. Dies ist die primäre Einschränkung bei der Festlegung Ihrer Endpunktstrategie. - Vereinfachung des multiregionalen Designs: Wenn ein Modell den globalen Endpunkt unterstützt, müssen Sie den API-Endpunkt in Ihrer Anwendung nicht dynamisch auf Grundlage der aktuellen Bereitstellungsregion wechseln. Eine einzelne, statische Konfiguration funktioniert für alle Regionen und vereinfacht so die Bereitstellung, das Testen und den Betrieb erheblich.

- Begrenzung der Ratenbegrenzung (Vermeidung von

429-Fehlern): Bei unterstützten Modellen wird der Traffic durch das Weiterleiten von Anfragen über den globalen Endpunkt intern über das Netzwerk von Google an den nächstgelegenen verfügbaren regionalen Dienst verteilt. Diese Verteilung kann oft dazu beitragen, lokale Dienstüberlastungen oder regionale Ratenbegrenzungen (429) zu verringern, indem das Google-Backbone für das interne Load-Balancing genutzt wird.

Die globale Verfügbarkeit von Partnermodellen finden Sie in der Tabelle mit den Google Cloud Modellendpunkt-Standorten auf dem Tab „Global“. Dort sind auch die regionalen Standorte aufgeführt.

Besonderheiten bei gemeinsam genutzten VPCs für Vertex AI

Die Verwendung einer freigegebenen VPC ist eine Google Cloud Best Practice für die Einrichtung einer starken Netzwerk- und Organisationsverwaltung. In diesem Modell werden die Zuständigkeiten getrennt, indem ein zentrales Hostprojekt, das von Netzwerk- und Sicherheitsadministratoren verwaltet wird, und mehrere Dienstprojekte, die von Anwendungsteams genutzt werden, festgelegt werden.

Durch diese Trennung können Netzwerkadministratoren die Netzwerksicherheit (einschließlich Firewallregeln, Subnetze und Routen) zentral verwalten und erzwingen, während sie das Erstellen und Verwalten von Ressourcen (z. B. VMs, GKE-Cluster und Abrechnung) an die Dienstprojekte delegieren.

Eine freigegebene VPC ermöglicht einen mehrschichtigen Ansatz für die Segmentierung, indem Folgendes ermöglicht wird:

- Administrative und abrechnungstechnische Segmentierung: Jedes Dienstprojekt (z. B. „Finance-AI-Project“ oder „Marketing-AI-Project“) hat eine eigene Abrechnung, eigene Kontingente und eigene Ressourcen. So wird verhindert, dass ein einzelnes Team das gesamte Kontingent der Organisation verbraucht, und die Kosten lassen sich klar zuordnen.

- IAM- und Zugriffssegmentierung: Sie können detaillierte IAM-Berechtigungen (Identity and Access Management) auf Projektebene anwenden, z. B.:

- Der Google-Gruppe „Finance Users“ wird die Rolle „roles/aiplatform.user“ nur im Projekt „Finance-AI-Project“ gewährt.

- Die Google-Gruppe „Marketing Users“ hat dieselbe Rolle nur im Projekt „Marketing-AI-Project“.

- Diese Konfiguration sorgt dafür, dass Nutzer in der Finanzgruppe nur auf die Vertex AI-Endpunkte, -Modelle und -Ressourcen zugreifen können, die mit ihrem eigenen Projekt verknüpft sind. Sie sind vollständig von den KI-Arbeitslasten des Marketingteams isoliert.

Durchsetzung auf API-Ebene: Der Vertex AI API-Endpunkt selbst ist so konzipiert, dass diese projektbasierte Segmentierung erzwungen wird. Wie in der Struktur des API-Aufrufs zu sehen ist, ist die Projekt-ID ein erforderlicher Teil des URI:

https://aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/global/publishers/google/models/${MODEL_ID}:streamGenerateContent

Wenn ein Nutzer diesen Aufruf ausführt, prüft das System, ob die authentifizierte Identität die erforderlichen IAM-Berechtigungen für die spezifische ${PROJECT_ID} in der URL hat. Wenn der Nutzer nur Berechtigungen für „Finance-AI-Project“ hat, aber versucht, die API mit der ID „Marketing-AI-Project“ aufzurufen, wird die Anfrage abgelehnt. Dieser Ansatz bietet ein robustes und skalierbares Framework, das dafür sorgt, dass Sie bei der Einführung von KI in Ihrem Unternehmen eine klare Trennung von Aufgaben, Kosten und Sicherheitsgrenzen beibehalten.

Öffentlicher Internetzugriff auf die Vertex AI API

Wenn Ihre Anwendung einen Google-Dienst verwendet, der in der Tabelle der unterstützten Zugriffsmethoden für Vertex AI als öffentliches Internet aufgeführt ist, kann Ihre Anwendung auf die API zugreifen, indem Sie einen DNS-Lookup gegen den Dienstendpunkt (REGION-aiplatform.googleapis.com oder aiplatform.googleapis.com) durchführen, der öffentlich routingfähige virtuelle IP-Adressen zurückgibt. Sie können die API von jedem Ort der Welt aus verwenden, sofern Sie eine Internetverbindung haben.

Traffic, der von Google Cloud -Ressourcen an diese IP-Adressen gesendet wird, verbleibt jedoch im Google-Netzwerk. Um den öffentlichen Zugriff auf die Vertex AI API einzuschränken, sind VPC Service Controls erforderlich.

Private Service Connect-Endpunkte für die Vertex AI API

Mit Private Service Connect können Sie private Endpunkte mit globalen internen IP-Adressen innerhalb Ihres VPC-Netzwerks erstellen.

Sie können diesen internen IP-Adressen DNS-Namen mit aussagekräftigen Namen wie aiplatform-genai1.p.googleapis.com und bigtable-adsteam.p.googleapis.com zuweisen. Diese Namen und IP-Adressen sind intern in Ihrem VPC-Netzwerk und allen lokalen Netzwerken vergeben, die über Hybrid-Netzwerkdienste damit verbunden sind.

Sie können steuern, welcher Traffic an welchen Endpunkt geleitet wird, und ob der Traffic innerhalb von Google Cloudbleiben soll.

- Sie können eine nutzerdefinierte globale IP-Adresse für den Private Service Connect-Endpunkt (/32) erstellen. Weitere Informationen finden Sie unter Anforderungen an IP-Adressen.

- Sie erstellen den Private Service Connect-Endpunkt im selben VPC-Netzwerk wie den Cloud Router.

- Sie können diesen internen IP-Adressen DNS-Namen mit aussagekräftigen Namen wie

aiplatform-prodpsc.p.googleapis.comzuweisen. Weitere Informationen finden Sie unter Zugriff auf Google APIs über Endpunkte. - Stellen Sie in einer freigegebene VPC den Private Service Connect-Endpunkt im Hostprojekt bereit.

Überlegungen zur Bereitstellung

Im Folgenden finden Sie einige wichtige Aspekte, die sich auf die Verwendung des privater Google-Zugriff und von Private Service Connect für den Zugriff auf die Vertex AI API auswirken.

Privater Google-Zugriff

Als Best Practice sollten Sie privaten Google-Zugriff für VPC-Subnetze aktivieren, damit Rechenressourcen (z. B. Compute Engine- und GKE-VM-Instanzen) ohne externe IP-Adressen auf Google Cloud APIs und -Dienste (z. B. Vertex AI, Cloud Storage und BigQuery) zugreifen können.

IP-Anzeigen

Sie müssen den Subnetzbereich für den privater Google-Zugriff oder die IP-Adresse des Private Service Connect-Endpunkts vom Cloud Router aus als benutzerdefinierte beworbene Route für lokale und Multicloud-Umgebungen bewerben. Weitere Informationen finden Sie unter Benutzerdefinierte IP-Bereiche bewerben.

Firewallregeln

Sie müssen dafür sorgen, dass die Firewallkonfiguration lokaler Umgebungen und Multicloud-Umgebungen ausgehenden Traffic von den IP-Adressen der Subnetze für privater Google-Zugriff oder Private Service Connect zulässt.

DNS-Konfiguration

- In Ihrem lokalen Netzwerk müssen DNS-Zonen und -Einträge konfiguriert sein, damit eine Anfrage an

REGION-aiplatform.googleapis.comoderaiplatform.googleapis.comin das Subnetz für privaten Google-Zugriff oder die IP-Adresse des Private Service Connect-Endpunkts aufgelöst wird. - Sie können von Cloud DNS verwaltete private Zonen erstellen und eine Cloud DNS-Richtlinie für eingehenden Server verwenden oder lokale Nameserver konfigurieren. Beispielsweise können Sie BIND oder Microsoft Active Directory DNS verwenden.

- Wenn Ihr lokales Netzwerk mit einem VPC-Netzwerk verbunden ist, können Sie mit Private Service Connect von lokalen Hosts aus über die interne IP-Adresse des Endpunkts auf Google APIs und Google-Dienste zugreifen. Weitere Informationen finden Sie unter Über lokale Hosts auf den Endpunkt zugreifen.