Métrique de qualité de la traduction BLEU

BLEU (Bilingual Evaluation Understudy) est une métrique permettant d'évaluer un texte traduit automatiquement. Le score BLEU est un nombre compris entre zéro et un qui mesure la similitude entre un texte traduit automatiquement et un ensemble de traductions de référence de haute qualité :

- Un score de 0 signifie que la traduction automatique ne correspond en rien à la traduction de référence, ce qui indique une mauvaise qualité de traduction.

- Un score de 1 indique une correspondance parfaite avec les traductions de référence, ce qui signifie que la qualité de la traduction est élevée.

Limites de BLEU

BLEU est une métrique basée sur un corpus. La métrique BLEU ne permet pas d'évaluer efficacement des phrases individuelles. Les phrases uniques peuvent obtenir des scores BLEU très bas, même lorsqu'elles restituent en grande partie le sens d'origine. Comme les statistiques relatives aux n-grammes s'avèrent moins pertinentes pour les phrases individuelles, la métrique BLEU est, par nature, une métrique basée sur un corpus. En d'autres termes, les statistiques sont obtenues à partir d'un corpus entier lors du calcul du score. La métrique BLEU ne peut pas être factorisée pour des phrases individuelles.

BLEU ne fait pas la distinction entre le contenu et les mots-outils. La métrique BLEU ne fait pas la distinction entre le contenu et les mots-outils. La pénalité liée à l'omission d'un mot-outil tel que un est identique à la pénalité appliquée en cas de remplacement du terme NASA par ESA.

La métrique BLEU restitue mal le sens et la grammaticalité d'une phrase. L'omission d'un seul terme tel que non peut inverser le sens d'une phrase. De même, en ne prenant en compte que les n-grammes où n ≤ 4, la métrique BLEU ignore les longues dépendances. Elle n'impose donc souvent qu'une faible pénalité aux phrases non grammaticales.

BLEU repose sur la normalisation et la tokenisation. Avant le calcul du score BLEU, les traductions de référence et les traductions automatiques sont normalisées et tokenisées. Le choix des étapes de ces processus affecte considérablement le score BLEU final.

Interpréter les scores BLEU

Voici une interprétation approximative des scores BLEU exprimés en pourcentages et non en décimales :

| Score BLEU (%) | Interprétation |

|---|---|

| < 10 | Traductions presque inutiles |

| 10 à 19 | L'idée générale est difficilement compréhensible |

| 20 à 29 | L'idée générale apparaît clairement, mais le texte comporte de nombreuses erreurs grammaticales |

| 30 à 40 | Résultats compréhensibles à traductions correctes |

| 40 à 50 | Traductions de haute qualité |

| 50 à 60 | Traductions de très haute qualité, adéquates et fluides |

| > 60 | Qualité souvent meilleure que celle d'une traduction humaine |

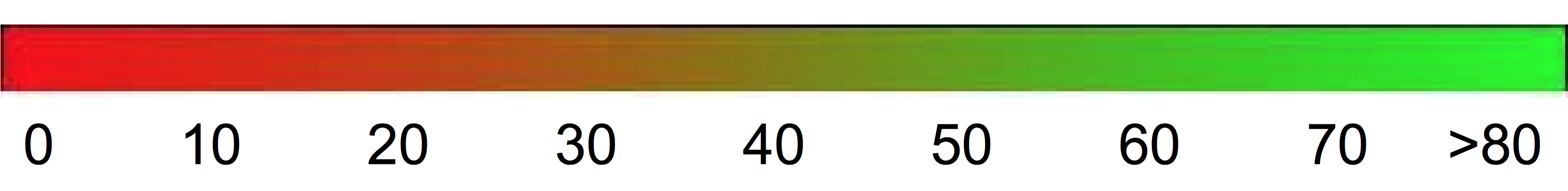

Le dégradé de couleur suivant peut vous servir à interpréter le score BLEU de manière générale :

Détails mathématiques

Mathématiquement, le score BLEU est défini de la manière suivante :

avec

\[ precision_i = \dfrac{\sum_{\text{snt}\in\text{Cand-Corpus}}\sum_{i\in\text{snt}}\min(m^i_{cand}, m^i_{ref})} {w_t^i = \sum_{\text{snt'}\in\text{Cand-Corpus}}\sum_{i'\in\text{snt'}} m^{i'}_{cand}} \]

Où :

- \(m_{cand}^i\hphantom{xi}\) est le nombre d'i-grammes dans la traduction automatique qui correspondent à la traduction de référence.

- \(m_{ref}^i\hphantom{xxx}\) est le nombre d'i-grammes dans la traduction de référence.

- \(w_t^i\hphantom{m_{max}}\) est le nombre total d'i-grammes dans la traduction automatique.

La formule se compose de deux parties : la pénalité de concision et la correspondance de n-grammes.

Pénalité de concision : La pénalité de concision pénalise les traductions générées qui sont trop courtes par rapport à la longueur de référence la plus proche, avec une décroissance exponentielle. Cette pénalité compense le fait que le score BLEU ne dispose pas de terme de rappel.

Chevauchement de n-grammes : La correspondance de n-grammes compte le nombre d'unigrammes, de bigrammes, de trigrammes et de quadrigrammes (i=1,…,4) qui correspondent à leur équivalent de n-grammes au sein des traductions de référence. Ce terme agit comme une métrique de précision. Les unigrammes rendent compte de l'adéquation de la traduction, tandis que les n-grammes plus longs rendent compte de sa fluidité. Pour éviter tout surdénombrement, le nombre de n-grammes est réduit au nombre maximal de n-grammes présents dans la référence (\(m_{ref}^n\)).

Exemple : Calculer \(precision_1\)

Prenons cette phrase de référence ainsi que cette traduction automatique :

Référence : the cat is on the mat

Traduction automatique : the the the cat mat

La première étape consiste à compter le nombre d'occurrences de chaque unigramme dans la référence et dans la traduction automatique. Notez que la métrique BLEU est sensible à la casse.

| Unigramme | \(m_{cand}^i\hphantom{xi}\) | \(m_{ref}^i\hphantom{xxx}\) | \(\min(m^i_{cand}, m^i_{ref})\) |

|---|---|---|---|

the |

3 | 2 | 2 |

cat |

1 | 1 | 1 |

is |

0 | 1 | 0 |

on |

0 | 1 | 0 |

mat |

1 | 1 | 1 |

Le nombre total d'unigrammes dans la traduction automatique (\(w_t^1\)) est de 5, donc \(precision_1\) = (2 + 1 + 1)/5 = 0,8.

Exemple : Calculer le score BLEU

Référence :

The NASA Opportunity rover is battling a massive dust storm on Mars.

Traduction automatique 1 :

The Opportunity rover is combating a big sandstorm on Mars.

Traduction automatique 2 :

A NASA rover is fighting a massive storm on Mars.

L'exemple précédent comprend une référence et deux traductions candidates. Avant que le score BLEU soit calculé, les phrases sont tokenisées. Par exemple, le point final est comptabilisé comme un jeton distinct.

Afin de calculer le score BLEU de chaque traduction, nous calculons les statistiques suivantes :

- Précision des n-grammes Le tableau suivant indique la précision des n-grammes pour les deux traductions automatiques.

- Pénalité de concision : La pénalité de concision est la même pour les traductions automatiques 1 et 2, car les deux phrases se composent de 11 jetons.

- Score BLEU Pour obtenir un score BLEU supérieur à 0, les textes doivent posséder au moins un quadrigramme correspondant. Comme aucun quadrigramme ne correspond dans la traduction automatique 1, son score BLEU est de 0.

| Métrique | Traduction automatique 1 | Traduction automatique 2 |

|---|---|---|

| \(precision_1\) (unigramme) | 8/11 | 9/11 |

| \(precision_2\) (bigramme) | 4/10 | 5/10 |

| \(precision_3\) (trigramme) | 2/9 | 2/9 |

| \(precision_4\) (quadrigramme) | 0/8 | 1/8 |

| Pénalité de concision | 0,83 | 0,83 |

| Score BLEU | 0,0 | 0,27 |