Guide de démarrage rapide : effectuer une tâche d'examen

Chaque processeur crée une "tâche HITL" qui est attribuée à un pool d'étiqueteurs humains (appelé "pool d'étiqueteurs") qui examinent les documents traités par le processeur. Une fois traités, ces documents sont mis en file d'attente dans la tâche pour examen HITL par le pool d'étiqueteurs attribué.

Avant de commencer

Avant de continuer, suivez le guide de démarrage rapide : configurer l'examen manuel.Ajouter des annotateurs

- Après avoir configuré l'examen manuel, vous devriez recevoir un e-mail semblable à celui-ci :

From: AI Platform <noreply-aiplatform@google.com>\

Subject: Added to AI Platform SpecialistPool Test Labeler Group

Hello AI Platform Customer,

You are added as a manager to specialist pool

cloudml_data_specialists_us_central1_785484070008756xxxx.

To view details, visit Manager console

https://datacompute.google.com/cm/

Sincerely,

The Google Cloud AI Team

Cliquez sur le lien figurant dans l'e-mail (ou copiez-le et collez-le dans votre navigateur) pour accéder à la page "Responsable" :

La tâche créée par le nouveau processeur porte le même nom que le processeur (par exemple, "Factures du service A") et figure dans l'onglet "Tâches".

Cliquez sur l'onglet "Annotateurs".

Cliquez sur "Ajouter un annotateur" et ajoutez au moins un annotateur (adresse e-mail). Un administrateur peut être un annotateur. Vous pouvez donc vous ajouter vous-même.

Pour un pool de labellisation nouvellement créé, la tâche doit être attribuée explicitement au labellisateur individuel dans l'onglet "Attributions". En d'autres termes, l'ajout du pool de personnes chargées de l'étiquetage n'attribue pas automatiquement la tâche à ces nouvelles personnes. Si le pool d'étiqueteurs a déjà provisionné des étiqueteurs, il est automatiquement attribué à la tâche.

Publier un document initial à examiner

Envoyez un document à extraire via le processeur créé. Si nécessaire, consultez les guides pratiques. Les appels en ligne (synchrones) et par lot (asynchrones) sont actuellement compatibles avec le routage de l'examen manuel pour les processeurs compatibles.

À des fins de test, vous pouvez utiliser une extraction de mauvaise qualité connue pour déclencher l'examen humain lorsque le score de confiance est inférieur au seuil, ou vous pouvez définir le seuil sur 100 %. Les documents sont généralement limités à cinq pages et à 20 Mo, mais vérifiez les limites spécifiques du processeur.

Une API permet de suivre chaque document envoyé pour examen manuel. La réponse des processeurs contient une chaîne

humanReviewOperationqui correspond à l'ID d'opération (nom de la tâche) du document dans la révision humaine. Vous pouvez interroger l'état de cette opération de longue durée (également appelée LRO).Vous pouvez interroger l'état d'un document envoyé pour examen manuel avec la méthode

projects.locations.operations.get.Vous pouvez forcer l'examen humain d'un document avec la méthode

reviewDocument(notez qu'elle est spécifique au processeur) :Pour utiliser la méthode

reviewDocument, vous devez cocher la case RÉVISION HUMAINE ACTIVÉE. L'utilisation de cette API ne remplacera pas les paramètres de configuration.Pour utiliser cette méthode, vous pouvez suivre le guide Demander un examen manuel.

Consulter le document

Si le document déclenche le processus d'examen manuel, mais qu'il n'y a pas d'étiqueteurs dans le pool, le responsable recevra un e-mail.

> Hello AI Platform Customer, > > There is a running task for Project with Job ID 404298342016955xxxx,\ > Labeling Task ID cloudml_data_us_central1_prod_11b273b4dabdxxxx,\ > Display name \ > datalabeling-job-8005676103232389120-for-hitl-340697311810578xxxx,\ > replication count 1\ > Please see attachment for instruction.\ > Please add labelers and have them finish the task at Labeler console \ > [https://datacompute.google.com/w/cloudml_data_specialists_us_central1_7854840700087566336](https://datacompute.google.com/w/cloudml_data_specialists_us_central1_7854840700087566336){: target="external" class="external" track-type="quickstart" track-name="externalLink" track-metadata-position="body" }.\ > To view details, visit Manager console \ > [https://datacompute.google.com/cm/cloudml_data_specialists_us_central1_7854840700087566336/tasks](https://datacompute.google.com/cm/cloudml_data_specialists_us_central1_7854840700087566336/tasks){: target="external" class="external" track-type="quickstart" track-name="externalLink" track-metadata-position="body" }. > > Sincerely,\ The Google Cloud AI Team

Ces liens permettent au responsable du libellé d'allouer le travail de libellé.

Si les annotateurs ne sont pas inscrits au groupe d'annotation et qu'ils viennent d'être ajoutés, le responsable de l'annotation doit leur envoyer un e-mail similaire contenant des instructions.

Étapes de l'étiqueteur

Procédure de l'étiqueteur

Adresse e-mail de l'étiqueteur

Si un annotateur est déjà inscrit à un groupe d'annotation à l'étape 2e, le système l'attribuera automatiquement et il recevra un e-mail comme celui-ci :

Le lien figurant dans cet e-mail permet à l'étiqueteur sélectionné d'étiqueter le document.

Actions d'étiquetage :

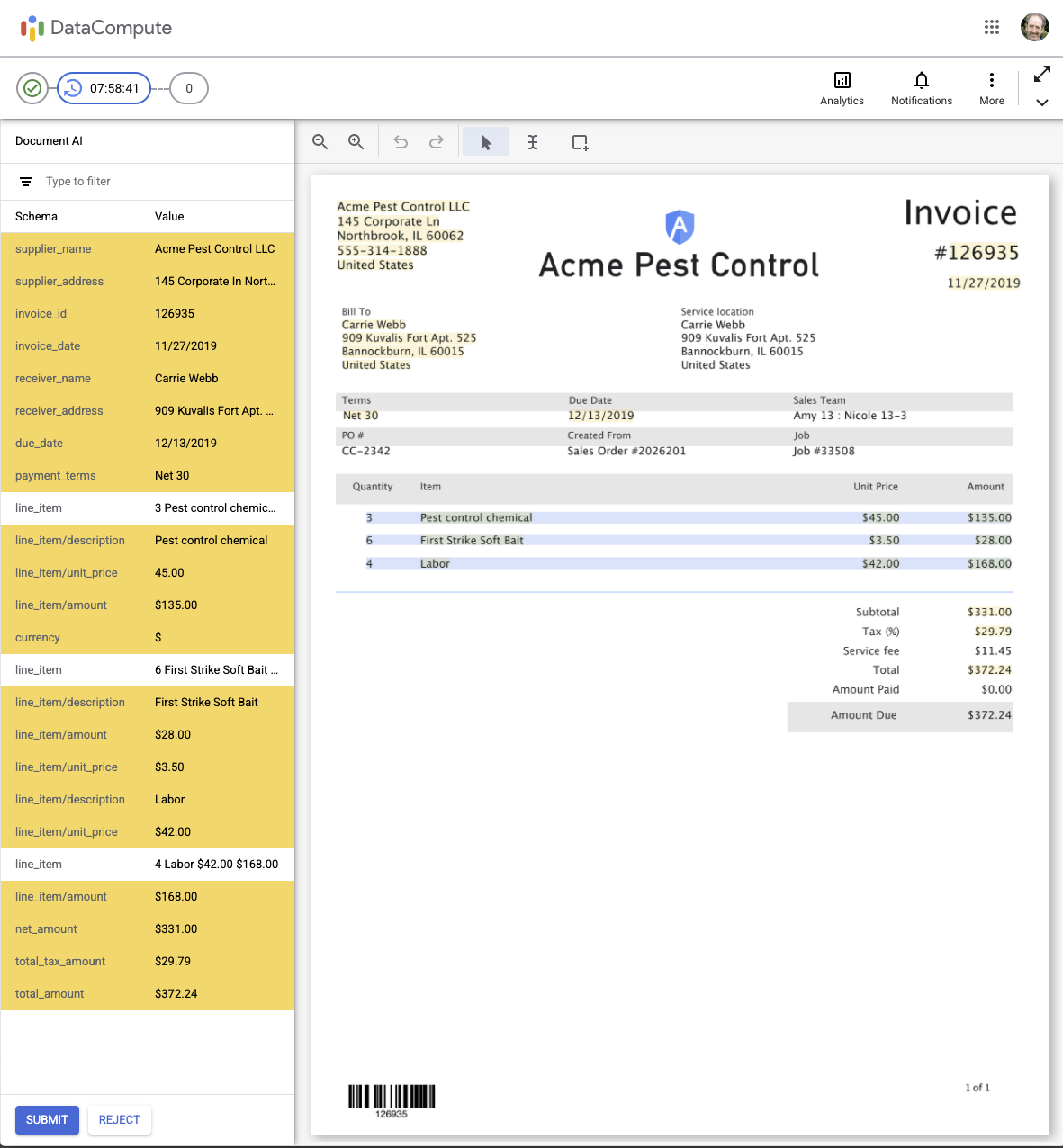

Lorsqu'un étiqueteur clique sur le lien pour effectuer l'étiquetage, l'interface utilisateur d'examen humain interactif par IA ci-dessous s'affiche. Les lignes mises en surbrillance (en jaune) indiquent celles qui ne sont pas validées (c'est-à-dire celles dont le score de confiance est inférieur au seuil configuré) et qui doivent être examinées.

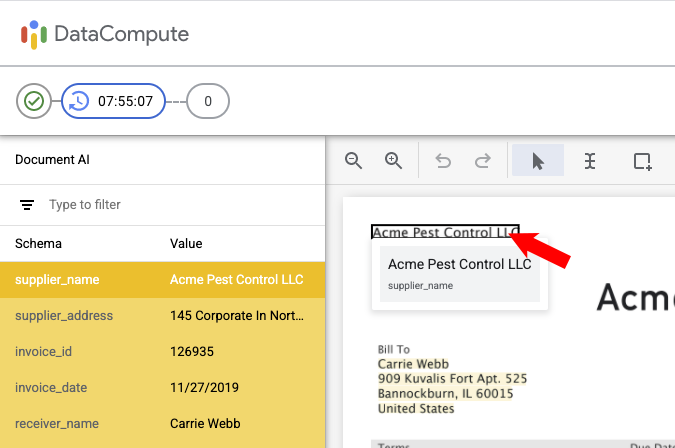

Examen Lorsque vous pointez sur un champ de texte reconnu, le texte reconnu et (en plus petit en dessous) le nom du champ (schéma) s'affichent. La ligne est également mise en surbrillance dans le panneau de gauche.

L'utilisateur peut faire un zoom avant ou arrière à l'aide des icônes en forme de loupe en haut à gauche de la barre d'outils.

Modifier un champ

Vous pouvez modifier un champ en cliquant dessus avec le bouton gauche de la souris :

Vous pouvez modifier la valeur ou le libellé dans le panneau de gauche. Cliquez ensuite sur Appliquer.

Vous pouvez également redimensionner le cadre de délimitation autour du texte du document en cliquant sur l'une des icônes de redimensionnement dans les coins de l'image du document :

Comme indiqué, si un texte différent est sélectionné, il remplacera le texte de la valeur du champ dans le panneau de gauche. Vous pouvez ensuite modifier ce texte si nécessaire. Cliquez ensuite sur Appliquer.

Veillez à consulter toutes les pages à l'aide du sélecteur de page en haut à droite.

Une fois toutes les modifications de libellés nécessaires effectuées, cliquez sur ENVOYER (en bas à gauche). Le fichier JSON des résultats sera enregistré dans le dossier "Emplacement des résultats".

Si vous ne parvenez pas à étiqueter le document de manière satisfaisante, vous pouvez cliquer sur REFUSER (en bas à gauche), puis sélectionner un motif de refus : - Sélectionnez un motif, puis cliquez sur Refuser le document.

Les annotateurs peuvent également cliquer sur les icônes suivantes en haut à droite :

- Données analytiques : pour afficher le nombre de documents qu'ils ont examinés (réponses) et leur durée totale.

- Notifications : pour afficher les notifications reçues.

- Plus (trois points) : pour ignorer le document, trouver des réponses ou envoyer des commentaires (si cette option est activée).

- Activer/Désactiver la barre de titre (flèches diagonales) : cette option permet de masquer (ou d'afficher) la barre de titre DataCompute pour gagner de la place.

Responsable de l'étiquetage

Examiner un document depuis Cloud Storage

Si vous souhaitez consulter le document, deux options s'offrent à vous :

Option 1 :

- Localisez l'emplacement Cloud Storage configuré précédemment.

- Récupérer et télécharger les documents

Option 2 :

- Mémorisez l'URI pour récupérer le document à partir de la réponse de prédiction.

- URI d'appel pour récupérer le document examiné

Étapes suivantes

- Gérez les tâches d'étiquetage à l'aide de la console du gestionnaire d'étiquetage.

- Consultez la liste et la description des processeurs actuellement disponibles.