Questa guida spiega come eseguire deployment blu/verde senza tempi di inattività sui gruppi di istanze gestite (MIG) di Compute Engine utilizzando Cloud Build e Terraform.

Cloud Build ti consente di automatizzare una serie di processi per sviluppatori, tra cui la creazione e il deployment di applicazioni in vari Google Cloud runtime come Compute Engine, Google Kubernetes Engine, GKE Enterprise e funzioni Cloud Run.

I MIG di Compute Engine ti consentono di utilizzare le applicazioni su più macchine virtuali (VM) identiche. Puoi rendere i tuoi workload scalabili e ad alta affidabilità sfruttando i servizi MIG automatizzati, tra cui: scalabilità automatica, riparazione automatica, deployment regionale (più zone) e aggiornamento automatico. Utilizzando il modello di deployment continuo blu/verde, imparerai a trasferire gradualmente il traffico utente da un MIG (blu) a un altro MIG (verde), entrambi in esecuzione in produzione.

Prima di iniziare

-

Enable the Cloud Build, Cloud Run, Artifact Registry, and Resource Manager APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.

Prepara il codice sorgente dell'applicazione. Il codice sorgente deve essere archiviato in un repository come GitHub o Bitbucket.

Per eseguire i comandi

gcloudin questa pagina, installa Google Cloud CLI.

Autorizzazioni Identity and Access Management richieste

-

Nella console Google Cloud , vai alla pagina settings Autorizzazioni di Cloud Build:

Per il service account Cloud Build specificato o il service account Cloud Build predefinito, imposta lo stato dei seguenti ruoli su Abilitato:

- Amministratore istanze Compute v1 (

roles/compute.instanceAdmin) | Consente a Cloud Build di eseguire il deployment di nuove istanze in Compute Engine.- Nel riquadro Assegna ruolo Service Account User, scegli un account di servizio da rappresentare e poi fai clic su Concedi autorizzazione.

- Amministratore Storage (

roles/storage.admin) | Consente la lettura e la scrittura da Cloud Storage. - Artifact Registry Writer (

roles/artifactregistry.writer) | Consente di eseguire il pull delle immagini da Artifact Registry e di scrivervi. - Scrittore log (

roles/logging.logWriter) | Consente di scrivere voci di log in Cloud Logging. - Editor Cloud Build (

roles/cloudbuild.builds.editor): consente al account di servizio di eseguire le build.

- Amministratore istanze Compute v1 (

Panoramica della progettazione

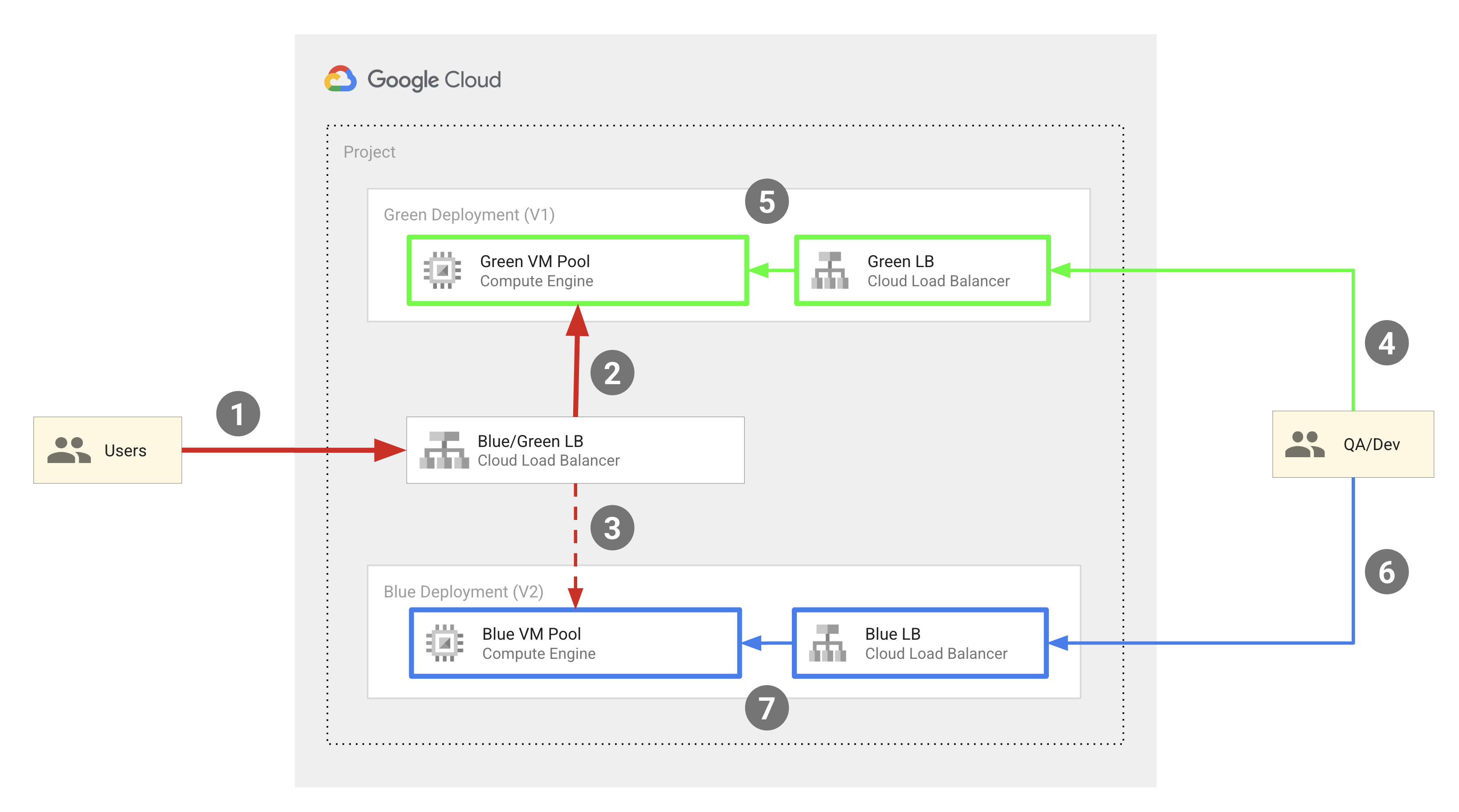

Il seguente diagramma mostra il modello di deployment blu/verde utilizzato dall'esempio di codice descritto in questo documento:

In linea generale, questo modello include i seguenti componenti:

- Due pool di VM Compute Engine: blu e verde.

- Tre bilanciatori del carico HTTP(S) esterni:

- Un bilanciatore del carico blu/verde, che indirizza il traffico degli utenti finali al pool blu o verde di istanze VM.

- Un bilanciatore del carico blu che instrada il traffico degli ingegneri QA e degli sviluppatori al pool di istanze VM blu.

- Un bilanciatore del carico verde che instrada il traffico degli ingegneri QA e degli sviluppatori al pool di istanze verde.

- Due gruppi di utenti:

- Gli utenti finali che hanno accesso al bilanciatore del carico blu/verde, che li indirizza al pool di istanze blu o verde.

- Ingegneri e sviluppatori del controllo qualità che richiedono l'accesso a entrambi i set di pool per scopi di sviluppo e test. Possono accedere sia ai bilanciatori del carico blu che a quelli verdi, che li indirizzano rispettivamente al pool di istanze blu e al pool di istanze verdi.

I pool di VM blu e verdi sono implementati come MIG Compute Engine e gli indirizzi IP esterni vengono instradati nelle VM nel MIG utilizzando bilanciatori del carico HTTP(S) esterni. L'esempio di codice descritto in questo documento utilizza Terraform per configurare questa infrastruttura.

Il seguente diagramma illustra le operazioni dello sviluppatore che si verificano nel deployment:

Nel diagramma precedente, le frecce rosse rappresentano il flusso di bootstrapping che si verifica quando configuri l'infrastruttura di deployment per la prima volta, mentre le frecce blu rappresentano il flusso GitOps che si verifica durante ogni deployment.

Per configurare questa infrastruttura, esegui uno script di configurazione che avvia il processo di bootstrap e configura i componenti per il flusso GitOps.

Lo script di configurazione esegue una pipeline Cloud Build che esegue le seguenti operazioni:

- Crea un repository in Cloud Source Repositories

denominato

copy-of-gcp-mig-simplee copia il codice sorgente dal repository di esempio GitHub al repository in Cloud Source Repositories. - Crea due trigger di Cloud Build denominati

applyedestroy.

Il trigger apply è collegato a un file Terraform denominato main.tfvars in

Cloud Source Repositories. Questo file contiene le variabili Terraform che rappresentano

i bilanciatori del carico blu e verde.

Per configurare il deployment, aggiorna le variabili nel file main.tfvars.

Il trigger apply esegue una pipeline Cloud Build che esegue

tf_apply ed esegue le seguenti operazioni:

- Crea due MIG di Compute Engine (uno per il verde e uno per il blu), quattro istanze VM di Compute Engine (due per il MIG verde e due per il MIG blu), i tre bilanciatori del carico (blu, verde e lo splitter) e tre indirizzi IP pubblici.

- Stampa gli indirizzi IP che puoi utilizzare per visualizzare le applicazioni di cui è stato eseguito il deployment nelle istanze blu e verdi.

Il trigger destroy viene attivato manualmente per eliminare tutte le risorse create dal trigger apply.

Obiettivi

Utilizza Cloud Build e Terraform per configurare bilanciatori del carico HTTP(S) esterni con backend di gruppi di istanze VM di Compute Engine.

Esegui i deployment blu/verde sulle istanze VM.

Costi

In questo documento vengono utilizzati i seguenti componenti fatturabili di Google Cloud:

Per generare una stima dei costi in base all'utilizzo previsto,

utilizza il Calcolatore prezzi.

Al termine delle attività descritte in questo documento, puoi evitare l'addebito di ulteriori costi eliminando le risorse che hai creato. Per saperne di più, consulta Esegui la pulizia.

Prima di iniziare

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

Install the Google Cloud CLI.

-

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

-

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init -

Create or select a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator role

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Create a Google Cloud project:

gcloud projects create PROJECT_ID

Replace

PROJECT_IDwith a name for the Google Cloud project you are creating. -

Select the Google Cloud project that you created:

gcloud config set project PROJECT_ID

Replace

PROJECT_IDwith your Google Cloud project name.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Build, Cloud Run, Artifact Registry, and Resource Manager APIs:

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.gcloud services enable cloudbuild.googleapis.com

run.googleapis.com artifactregistry.googleapis.com cloudresourcemanager.googleapis.com -

Install the Google Cloud CLI.

-

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

-

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init -

Create or select a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator role

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Create a Google Cloud project:

gcloud projects create PROJECT_ID

Replace

PROJECT_IDwith a name for the Google Cloud project you are creating. -

Select the Google Cloud project that you created:

gcloud config set project PROJECT_ID

Replace

PROJECT_IDwith your Google Cloud project name.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Build, Cloud Run, Artifact Registry, and Resource Manager APIs:

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.gcloud services enable cloudbuild.googleapis.com

run.googleapis.com artifactregistry.googleapis.com cloudresourcemanager.googleapis.com Esegui lo script di configurazione dal repository di esempio di codice di Google:

bash <(curl https://raw.githubusercontent.com/GoogleCloudPlatform/cloud-build-samples/main/mig-blue-green/setup.sh)Quando lo script di configurazione chiede il consenso dell'utente, inserisci yes.

L'esecuzione dello script termina in pochi secondi.

Nella console Google Cloud , apri la pagina Cronologia build di Cloud Build:

Fai clic sull'ultima build.

Viene visualizzata la pagina Dettagli build, che mostra una pipeline Cloud Build con tre passaggi di build: il primo passaggio crea un repository in Cloud Source Repositories, il secondo clona i contenuti del repository di esempio in GitHub in Cloud Source Repositories e il terzo aggiunge due trigger di build.

Apri Cloud Source Repositories:

Nell'elenco dei repository, fai clic su

copy-of-gcp-mig-simple.Nella scheda Cronologia nella parte inferiore della pagina, vedrai un commit con la descrizione

A copy of https://github.com/GoogleCloudPlatform/cloud-build-samples.gitcreato da Cloud Build per creare un repository denominatocopy-of-gcp-mig-simple.Apri la pagina Trigger di Cloud Build:

Per avviare la procedura di deployment, aggiorna il file

infra/main.tfvars:Nella finestra del terminale, crea una cartella denominata

deploy-compute-enginee accedi al suo interno:mkdir ~/deploy-compute-engine cd ~/deploy-compute-engineClona il repository

copy-of-gcp-mig-simple:gcloud source repos clone copy-of-mig-blue-greenVai alla directory clonata:

cd ./copy-of-mig-blue-greenAggiorna

infra/main.tfvarsper sostituire il blu con il verde:sed -i'' -e 's/blue/green/g' infra/main.tfvarsAggiungi il file aggiornato:

git add .Esegui il commit del file:

git commit -m "Promote green"Esegui il push del file:

git pushL'apporto di modifiche a

infra/main.tfvarsattiva l'esecuzione del triggerapply, che avvia il deployment.

Apri Cloud Source Repositories:

Nell'elenco dei repository, fai clic su

copy-of-gcp-mig-simple.Vedrai il commit con la descrizione

Promote greennella scheda Cronologia nella parte inferiore della pagina.Per visualizzare l'esecuzione del trigger

apply, apri la pagina Cronologia build nella console Google Cloud :Apri la pagina Dettagli build facendo clic sulla prima build.

Vedrai la pipeline di trigger

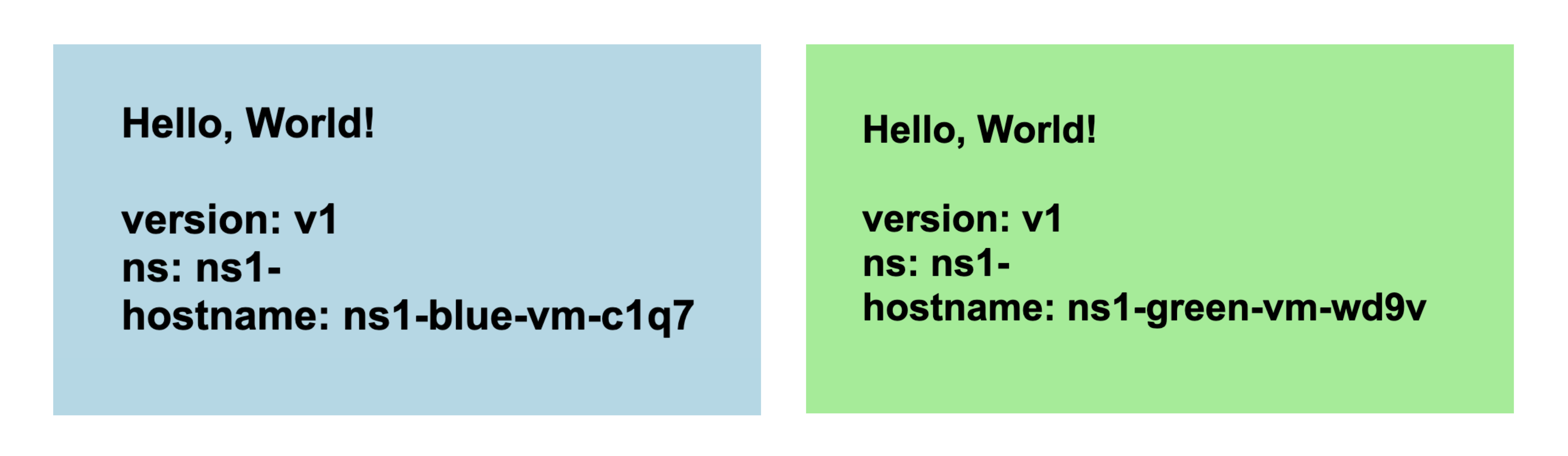

applycon due passaggi di build. Il primo passaggio di build esegue Terraform apply per creare le risorse Compute Engine e di bilanciamento del carico per il deployment. Il secondo passaggio di compilazione stampa l'indirizzo IP in cui puoi vedere l'applicazione in esecuzione.Apri l'indirizzo IP corrispondente al MIG verde in un browser. Vedrai uno screenshot simile al seguente che mostra il deployment:

Vai alla pagina Gruppo di istanze di Compute Engine per visualizzare i gruppi di istanze blu e verdi:

Apri la pagina Istanze VM per visualizzare le quattro istanze VM:

Apri la pagina Indirizzi IP esterni per visualizzare i tre bilanciatori del carico:

- Codice sorgente relativo allo script di configurazione.

- Codice sorgente correlato alle pipeline Cloud Build.

- Codice sorgente correlato ai modelli Terraform.

- Abilita le API Cloud Build, Resource Manager, Compute Engine e Cloud Source Repositories.

- Concede il ruolo IAM

roles/editoral account di servizio Cloud Build nel tuo progetto. Questo ruolo è necessario per consentire a Cloud Build di creare e configurare i componenti GitOps necessari per il deployment. - Concede il ruolo IAM

roles/source.adminal account di servizio Cloud Build nel tuo progetto. Questo ruolo è necessario per consentire al account di servizio Cloud Build di creare Cloud Source Repositories nel tuo progetto e clonare i contenuti del repository GitHub di esempio in Cloud Source Repositories. Genera una pipeline Cloud Build denominata

bootstrap.cloudbuild.yamlinline, che:- Crea un nuovo repository in Cloud Source Repositories.

- Copia il codice sorgente dal repository GitHub di esempio nel nuovo repository in Cloud Source Repositories.

- Crea i trigger di build apply e destroy.

- Passaggio di build

tf_apply buildche chiama la funzionetf_install_in_cloud_build_step, che installa Terraform.tf_applyche crea le risorse utilizzate nel flusso GitOps. Le funzionitf_install_in_cloud_build_stepetf_applysono definite inbash_utils.she il passaggio di build utilizza il comandosourceper chiamarle. - Passaggio di compilazione

describe_deploymentche chiama la funzionedescribe_deploymentche stampa gli indirizzi IP dei bilanciatori del carico. main.tf: questo è il file di configurazione Terraformmain.tfvars: questo file definisce le variabili Terraform.mig/esplitter/: queste cartelle contengono i moduli che definiscono i bilanciatori del carico. La cartellamig/contiene il file di configurazione Terraform che definisce il MIG per i bilanciatori del carico blu e verde. I MIG blu e verdi sono identici, pertanto vengono definiti una sola volta e istanziati per gli oggetti blu e verdi. Il file di configurazione Terraform per il bilanciatore del carico splitter si trova nella cartellasplitter/.- È definita una variabile per il progetto Google Cloud .

- Google è impostato come provider Terraform.

- Una variabile è definita per lo spazio dei nomi. Tutti gli oggetti creati da Terraform sono preceduti da questa variabile, in modo che più versioni dell'applicazione possano essere implementate nello stesso progetto e i nomi degli oggetti non entrino in conflitto tra loro.

- Le variabili

MIG_VER_BLUE,MIG_VER_BLUEeMIG_ACTIVE_COLORsono i binding per le variabili nel fileinfra/main.tfvars. Elimina le risorse Compute Engine create dal trigger di applicazione:

Apri la pagina Trigger di Cloud Build:

Nella tabella Trigger, individua la riga corrispondente al trigger destroy e fai clic su Esegui. Al termine dell'esecuzione del trigger, le risorse create dal trigger apply vengono eliminate.

Elimina le risorse create durante il bootstrapping eseguendo questo comando nella finestra del terminale:

bash <(curl https://raw.githubusercontent.com/GoogleCloudPlatform/cloud-build-samples/main/mig-blue-green/teardown.sh)- Scopri di più sui trigger di build.

- Scopri come visualizzare la provenienza della build.

Prova

Vedrai due trigger di build denominati apply e destroy. Il trigger apply

è collegato al file infra/main.tfvars nel ramo main. Questo trigger

viene eseguito ogni volta che il file viene aggiornato. Il trigger destroy è un trigger manuale.

Nozioni di base sul codice

Il codice sorgente di questo esempio di codice include:

Script di configurazione

setup.sh è lo script di configurazione che esegue il processo di bootstrap e crea i

componenti per il deployment blu/verde. Lo script esegue le seguenti operazioni:

Pipeline di Cloud Build

apply.cloudbuild.yaml e destroy.cloudbuild.yaml sono i

file di configurazione di Cloud Build che lo script di configurazione utilizza per configurare le

risorse per il flusso GitOps. apply.cloudbuild.yaml contiene due passaggi di compilazione:

destroy.cloudbuild.yaml chiama tf_destroy che elimina tutte le risorse

create da tf_apply.

Le funzioni tf_install_in_cloud_build_step, tf_apply,

describe_deployment e tf_destroy sono definite nel file bash_utils.sh.

I file di configurazione della build utilizzano il comando source per chiamare le funzioni.

Il codice seguente mostra la funzione tf_install_in_cloud_build_step definita in bash_utils.sh. I file di configurazione di compilazione chiamano questa funzione per

installare Terraform al volo. Crea un bucket Cloud Storage per

registrare lo stato di Terraform.

Il seguente snippet di codice mostra la funzione tf_apply definita in

bash_utils.sh. Chiama prima terraform init, che carica tutti i moduli e le librerie personalizzate, quindi esegue terraform apply per caricare le variabili dal file main.tfvars.

Il seguente snippet di codice mostra la funzione describe_deployment definita in bash_utils.sh. Utilizza gcloud compute addresses describe per recuperare gli indirizzi IP dei bilanciatori del carico utilizzando il nome e li stampa.

Il seguente snippet di codice mostra la funzione tf_destroy definita in

bash_utils.sh. Chiama terraform init che carica tutti i moduli e le librerie personalizzate e poi esegue terraform destroy che scarica le variabili Terraform.

Modelli Terraform

Troverai tutti i file di configurazione e le variabili di Terraform nella cartella

copy-of-gcp-mig-simple/infra/.

Il seguente snippet di codice mostra i contenuti di infra/main.tfvars. Contiene tre variabili: due che determinano la versione dell'applicazione da distribuire ai pool blu e verde e una variabile per il colore attivo: blu o verde. Le modifiche a questo file attivano il deployment.

Di seguito è riportato uno snippet di codice di infra/main.tf. In questo snippet:

Il seguente snippet di codice di infra/main.tf mostra l'istanza del modulo di separazione. Questo modulo accetta il colore attivo in modo che il bilanciatore del carico dello splitter sappia su quale MIG eseguire il deployment dell'applicazione.

Lo snippet di codice seguente di infra/main.tf definisce due moduli identici

per i MIG blu e verdi. Prende il colore, la rete e la subnet

definiti nel modulo splitter.

Il file splitter/main.tf definisce gli oggetti creati per il

MIG splitter. Di seguito è riportato un snippet di codice di splitter/main.tf che

contiene la logica per passare dal MIG verde a quello blu. È supportato dal servizio google_compute_region_backend_service, che può instradare il traffico verso due regioni di backend: var.instance_group_blue o var.instance_group_green.

capacity_scaler definisce la quantità di traffico da instradare.

Il seguente codice indirizza il 100% del traffico al colore specificato, ma puoi aggiornarlo per il deployment canary in modo da indirizzare il traffico a un sottoinsieme di utenti.

Il file mig/main.tf definisce gli oggetti relativi ai MIG blu e verdi. Il seguente snippet di codice di questo file definisce il modello di istanza di Compute Engine utilizzato per creare i pool di VM. Tieni presente che questo modello di istanza ha la proprietà del ciclo di vita di Terraform impostata su create_before_destroy.

Questo perché, quando aggiorni la versione del pool, non puoi utilizzare il

template per creare la nuova versione dei pool mentre è ancora in uso

nella versione precedente del pool. Tuttavia, se la versione precedente del pool viene

eliminata prima della creazione del nuovo modello, ci sarà un periodo di tempo in cui

i pool non saranno disponibili. Per evitare questo scenario, impostiamo il ciclo di vita di Terraform su

create_before_destroy in modo che la versione più recente di un pool di VM venga creata prima

che la versione precedente venga eliminata.

Esegui la pulizia

Per evitare che al tuo account Google Cloud vengano addebitati costi relativi alle risorse utilizzate in questo tutorial, elimina il progetto che contiene le risorse oppure mantieni il progetto ed elimina le singole risorse.

Elimina singole risorse

Elimina il progetto

Delete a Google Cloud project:

gcloud projects delete PROJECT_ID