Vertex AI Vision ist eine KI-gestützte Plattform, mit der Sie Videodaten aufnehmen, analysieren und speichern können. Mit Vertex AI Vision können Sie KI-Anwendungen erstellen und bereitstellen. Sie können umfassende Vertex AI Vision-Lösungen erstellen, indem Sie die Integration von Vertex AI Vision in andere Produktkomponenten nutzen.

Bevor Sie mit der Implementierung von Lösungen mit der Vertex AI Vision-Plattform beginnen, sollten Sie sich mit den folgenden Konzepten und Komponenten von Vertex AI Vision vertraut machen:

Streams: Stellen eine Videostreaming-Ebene Ihrer Lösung dar. Die Streamquelle kann ein Live-Video (z. B. eine IP-Kamera) oder eine Videodatei (z. B. eine MP4-Datei) sein.

Anwendungen: Ermöglichen die Verbindung zwischen einem Stream und einem KI-Prozessor, um einen Machine-Learning-Vorgang für das Video auszuführen. Sie können beispielsweise einen Kamerastream mit einem KI-Modell verbinden, das Personen zählt, die vor der Kamera vorbeigehen.

Media Warehouses: Hier werden die von Streams aufgenommenen Videos inGoogle Cloud gespeichert. Wenn Sie Daten in diesem Ziel speichern, können Sie Analyseergebnisse und Metadaten der KI-Prozessoren abfragen, die für Daten aus den aufgenommenen Streams verwendet werden.

Ziele

In dieser Anleitung wird Folgendes beschrieben:

- App zur Ermittlung der Belegung erstellen

- Stellen Sie Ihre Anwendung zur Verwendung bereit.

- Remote-Computer für das Streamen von Videos einrichten

- Nehmen Sie das Streamingvideo in einen Streamknoten in Ihrer App auf.

- Suchen Sie nach Videos in Ihrem Speicher in Media Warehouse von Vertex AI Vision.

Kosten

In diesem Dokument verwenden Sie die folgenden kostenpflichtigen Komponenten von Google Cloud:

- Vertex AI Vision (Streams - Data ingested, Streams - Data consumed, Models - Occupancy analytics suite, Warehouse - Video storage)

- Compute Engine

Mit dem Preisrechner können Sie eine Kostenschätzung für Ihre voraussichtliche Nutzung vornehmen.

Nach Abschluss der in diesem Dokument beschriebenen Aufgaben können Sie weitere Kosten vermeiden, indem Sie die erstellten Ressourcen löschen. Weitere Informationen finden Sie unter Bereinigen.

Hinweise

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator role

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Compute Engine and Vision AI APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Create a service account:

-

Ensure that you have the Create Service Accounts IAM role

(

roles/iam.serviceAccountCreator) and the Project IAM Admin role (roles/resourcemanager.projectIamAdmin). Learn how to grant roles. -

In the Google Cloud console, go to the Create service account page.

Go to Create service account - Select your project.

-

In the Service account name field, enter a name. The Google Cloud console fills in the Service account ID field based on this name.

In the Service account description field, enter a description. For example,

Service account for quickstart. - Click Create and continue.

-

Grant the following roles to the service account: Vision AI > Vision AI Editor, Compute Engine > Compute Instance Admin (beta), Storage > Storage Object Viewer†.

To grant a role, find the Select a role list, then select the role.

To grant additional roles, click Add another role and add each additional role.

- Click Continue.

-

Click Done to finish creating the service account.

Do not close your browser window. You will use it in the next step.

-

Ensure that you have the Create Service Accounts IAM role

(

-

Create a service account key:

- In the Google Cloud console, click the email address for the service account that you created.

- Click Keys.

- Click Add key, and then click Create new key.

- Click Create. A JSON key file is downloaded to your computer.

- Click Close.

-

Install the Google Cloud CLI.

-

Wenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

-

Führen Sie den folgenden Befehl aus, um die gcloud CLI zu initialisieren:

gcloud init -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator role

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Compute Engine and Vision AI APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Create a service account:

-

Ensure that you have the Create Service Accounts IAM role

(

roles/iam.serviceAccountCreator) and the Project IAM Admin role (roles/resourcemanager.projectIamAdmin). Learn how to grant roles. -

In the Google Cloud console, go to the Create service account page.

Go to Create service account - Select your project.

-

In the Service account name field, enter a name. The Google Cloud console fills in the Service account ID field based on this name.

In the Service account description field, enter a description. For example,

Service account for quickstart. - Click Create and continue.

-

Grant the following roles to the service account: Vision AI > Vision AI Editor, Compute Engine > Compute Instance Admin (beta), Storage > Storage Object Viewer†.

To grant a role, find the Select a role list, then select the role.

To grant additional roles, click Add another role and add each additional role.

- Click Continue.

-

Click Done to finish creating the service account.

Do not close your browser window. You will use it in the next step.

-

Ensure that you have the Create Service Accounts IAM role

(

-

Create a service account key:

- In the Google Cloud console, click the email address for the service account that you created.

- Click Keys.

- Click Add key, and then click Create new key.

- Click Create. A JSON key file is downloaded to your computer.

- Click Close.

-

Install the Google Cloud CLI.

-

Wenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

-

Führen Sie den folgenden Befehl aus, um die gcloud CLI zu initialisieren:

gcloud init - Datenaufnahme: Ein Videofeed wird in einen Stream aufgenommen.

- Datenanalyse: Nach der Aufnahme kann ein KI-Modell hinzugefügt werden. Alle Computer-Vision-Vorgänge können für die aufgenommenen Videoinformationen ausgeführt werden.

- Datenspeicher: Die beiden Versionen des Videofeeds (der Originalstream und der vom KI-Modell verarbeitete Stream) können in einem Media Warehouse gespeichert werden.

Öffnen Sie den Tab Anwendungen des Vertex AI Vision-Dashboards.

Klicken Sie auf die Schaltfläche Erstellen.

Geben Sie

occupancy-count-appals App-Namen ein und wählen Sie Ihre Region aus.Klicken Sie auf Erstellen.

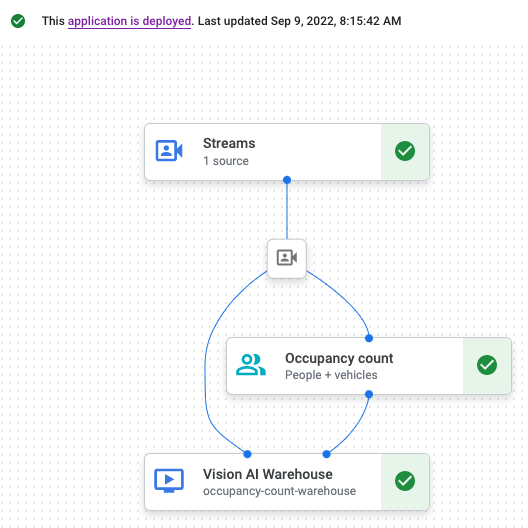

- Aufnahmeknoten: Die Streamressource, in die Daten aufgenommen werden, die von einer von Ihnen erstellten Compute Engine-VM-Instanz gesendet werden.

- Verarbeitungsknoten: Das Modell für die Analyse der Belegung, das auf die aufgenommenen Daten angewendet wird.

- Speicherknoten: Das Media Warehouse, in dem verarbeitete Videos gespeichert werden und das auch als Metadatenspeicher dient. Im Data Warehouse können Analysedaten zu aufgenommenen Videodaten generiert werden. Außerdem werden dort Informationen gespeichert, die KI-Modelle aus den Daten ableiten.

Öffnen Sie den Tab Anwendungen des Vertex AI Vision-Dashboards.

Wählen Sie in der

occupancy-count-app-Zeile Diagramm ansehen aus. Dadurch gelangen Sie zur grafischen Darstellung der Verarbeitungspipeline.Wenn Sie einen Knoten für den Eingabestream hinzufügen möchten, wählen Sie im seitlichen Menü im Abschnitt Connectors die Option Streams aus.

Wählen Sie im Abschnitt Quelle des sich öffnenden Menüs Stream die Option Streams hinzufügen aus.

Wählen Sie im Menü Streams hinzufügen die Option Neue Streams registrieren aus und fügen Sie

occupancy-count-streamals Streamname hinzu.Klicken Sie auf Streams hinzufügen, um den Stream dem App-Diagramm hinzuzufügen.

Wenn Sie den Knoten für das Modell zur Berechnung der Belegung hinzufügen möchten, wählen Sie im seitlichen Menü im Abschnitt Spezialisierte Modelle die Option occupancy analytics (Belegungsanalyse) aus.

Lassen Sie die Standardauswahl Personen und Fahrzeuge unverändert.

Wählen Sie im Abschnitt Connectors des seitlichen Menüs die Option Media Warehouse von Vertex AI Vision aus, um den Knoten für den Ausgabespeicherort (Speicher) hinzuzufügen.

Klicken Sie im Menü Media Warehouse von Vertex AI Vision auf Warehouse verbinden.

Wählen Sie im Menü Warehouse verbinden die Option Neues Warehouse erstellen aus. Geben Sie dem Warehouse den Namen

occupancy-count-warehouseund belassen Sie die TTL-Dauer bei 14 Tagen.Klicken Sie auf die Schaltfläche Erstellen, um das Warehouse hinzuzufügen.

Öffnen Sie den Tab Anwendungen des Vertex AI Vision-Dashboards.

Wählen Sie in der Liste neben der

occupancy-count-appApp Grafik ansehen aus.Klicken Sie auf der Seite „Anwendungsdiagramm erstellen“ auf die Schaltfläche Bereitstellen.

Wählen Sie im folgenden Bestätigungsdialogfeld Bereitstellen aus.

Die Bereitstellung kann mehrere Minuten dauern. Nach Abschluss der Bereitstellung werden neben den Knoten grüne Häkchen angezeigt.

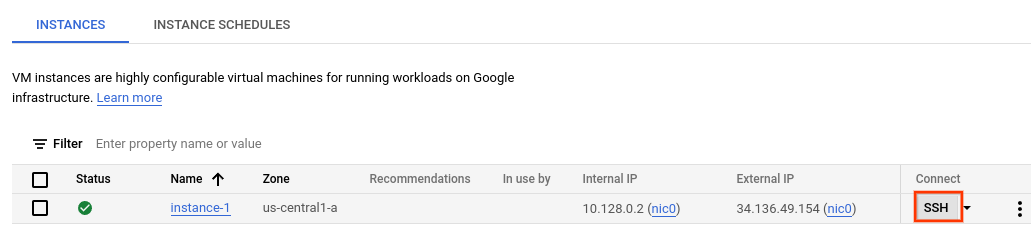

Rufen Sie in der Console die Seite VM-Instanzen auf.

Wählen Sie Ihr Projekt aus und klicken Sie auf Weiter.

Klicken Sie auf Instanz erstellen.

Geben Sie einen Namen für Ihre VM an. Weitere Informationen finden Sie unter Namenskonvention für Ressourcen.

Ändern Sie optional die Zone für diese VM. In Compute Engine wird die Liste der Zonen in jeder Region zufällig angeordnet, um die Verwendung in mehreren Zonen zu fördern.

Übernehmen Sie die verbleibenden Standardoptionen. Weitere Informationen zu diesen Optionen finden Sie unter VM erstellen und starten.

Klicken Sie zum Erstellen und Starten der VM auf Erstellen.

Rufen Sie in der Console die Seite VM-Instanzen auf.

Klicken Sie im Abschnitt Verbinden der von Ihnen erstellten Instanzzeile auf SSH. Dadurch wird in einem neuen Browserfenster eine SSH-Verbindung geöffnet.

Laden Sie im Fenster SSH im Browser das Befehlszeilentool für Vertex AI Vision (

vaictl) mit dem folgenden Befehl herunter:wget https://github.com/google/visionai/releases/download/v0.0.5/visionai_0.0-5_amd64.debInstallieren Sie das Befehlszeilentool mit dem folgenden Befehl:

sudo apt install ./visionai_0.0-5_amd64.debSie können die Installation mit dem folgenden Befehl testen:

vaictl --help- Kopieren Sie im Fenster SSH im Browser für Ihre VM ein Beispielvideo mit dem folgenden

gcloud storage cp-Befehl. Ersetzen Sie die folgende Variable:- SOURCE: Der Speicherort einer Videodatei, die verwendet werden soll. Sie können Ihre eigene Videoquelldatei verwenden (z. B.

gs://BUCKET_NAME/FILENAME.mp4) oder eines der Beispielvideos:

gcloud storage cp SOURCE .

- SOURCE: Der Speicherort einer Videodatei, die verwendet werden soll. Sie können Ihre eigene Videoquelldatei verwenden (z. B.

- Verwenden Sie den folgenden Befehl, um diese lokale Videodatei an den Eingabestream der App zu senden. Sie müssen die folgenden Variablen ersetzen:

- PROJECT_ID: Ihre Google Cloud Projekt-ID

- LOCATION_ID: Ihre Standort-ID. Beispiel:

us-central1. Weitere Informationen finden Sie unter Cloud-Standorte. - LOCAL_FILE.EXT: Der Dateiname einer lokalen Videodatei.

Beispiel:

my-video.mp4. - Flag

--loop: Optional. Wiederholt Dateidaten, um Streaming zu simulieren.

Mit diesem Befehl wird eine Videodatei in einen Stream übertragen. Wenn Sie das Flag

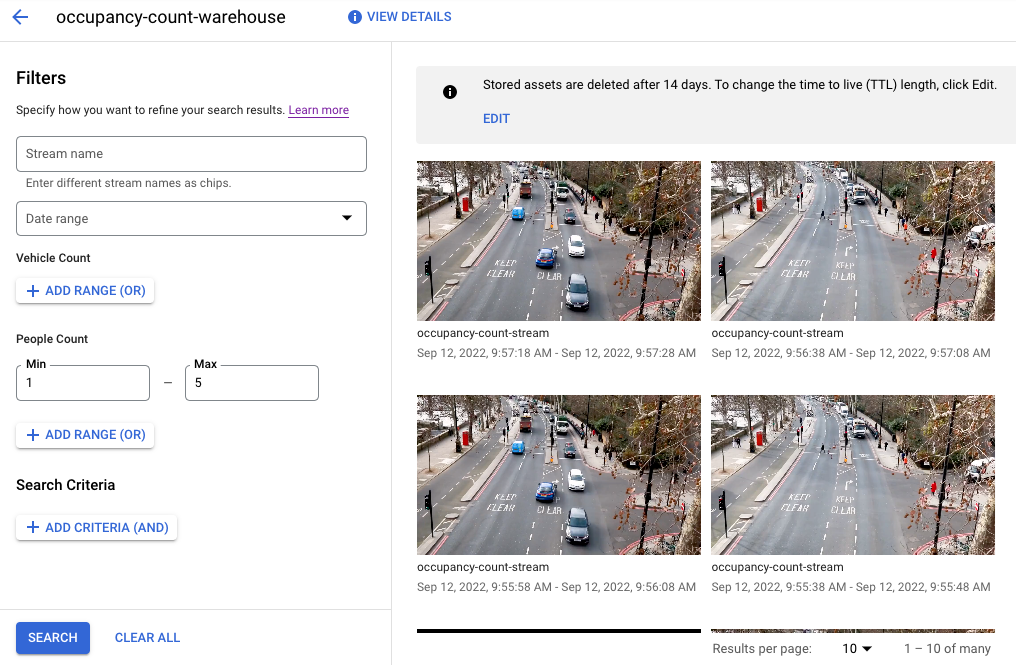

--loopverwenden, wird das Video so lange in den Stream eingebunden, bis Sie den Befehl beenden:vaictl -p PROJECT_ID \ -l LOCATION_ID \ -c application-cluster-0 \ --service-endpoint visionai.googleapis.com \ send video-file to streams 'occupancy-count-stream' --file-path LOCAL_FILE.EXT --loop Öffnen Sie den Tab Warehouses (Data Warehouses) des Vertex AI Vision-Dashboards.

Suchen Sie in der Liste nach dem

occupancy-count-warehouse-Lager und klicken Sie auf Assets ansehen.Legen Sie im Abschnitt Anzahl der Personen oder Anzahl der Fahrzeuge den Wert Min. auf

1und den Wert Max. auf5fest.Wenn Sie verarbeitete Videodaten filtern möchten, die im Media Warehouse von Vertex AI Vision gespeichert sind, klicken Sie auf Suchen.

Eine Ansicht der gespeicherten Videodaten, die den Suchkriterien entsprechen, Google Cloud in der Konsole. Videoquelle: Elizabeth Mavor auf Pixabay (angewendete Suchkriterien). - In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

- In the Google Cloud console, go to the VM instances page.

- Select the checkbox for the instance that you want to delete.

- To delete the instance, click More actions, click Delete, and then follow the instructions.

- In the Google Cloud console, go to the Warehouses page.

-

Locate

your

occupancy-count-warehousewarehouse. - To delete the warehouse, click Actions, click Delete warehouse, and then follow the instructions.

- In the Google Cloud console, go to the Streams page.

-

Locate

your

occupancy-count-streamstream. - To delete the stream, click Actions, click Delete stream, and then follow the instructions.

- In the Google Cloud console, go to the Applications page.

-

Locate

your

occupancy-count-appapp. - To delete the app, click Actions, click Delete application, and then follow the instructions.

- Weitere Informationen zu Verantwortungsbewusste KI-Praktiken.

- Weitere Informationen zu anderen Komponenten, die Sie einer App hinzufügen können

- Weitere Informationen zu anderen Ausgabespeicher- und Verarbeitungsoptionen finden Sie unter Anwendungsausgabe mit einem Datenziel verbinden.

- Informationen zum Suchen in Warehouse-Daten in der Konsole

- Referenzarchitekturen, Diagramme und Best Practices zu Google Cloud kennenlernen. Weitere Informationen zu Cloud Architecture Center

† Rolle ist nur erforderlich, wenn Sie eine Beispielvideodatei aus einem Cloud Storage-Bucket kopieren.

Anwendung zur Ermittlung der Belegung erstellen

Nachdem Sie Ihre Umgebung eingerichtet haben, müssen Sie zuerst die App erstellen, mit der Ihre Daten verarbeitet werden. Eine App kann als automatisierte Pipeline betrachtet werden, die Folgendes verbindet:

In der Google Cloud Console wird eine App als Diagramm dargestellt. Außerdem muss ein App-Diagramm in Vertex AI Vision mindestens zwei Knoten haben: einen Videobronnenknoten (Stream) und mindestens einen weiteren Knoten (ein Verarbeitungsmodell oder ein Ausgabeziel).

Leere Anwendung erstellen

Bevor Sie den App-Graphen mit Daten füllen können, müssen Sie zuerst eine leere App erstellen.

Console

Erstellen Sie eine App in der Google Cloud Console.

Knoten für Anwendungskomponenten hinzufügen

Nachdem Sie die leere Anwendung erstellt haben, können Sie dem App-Diagramm die drei Knoten hinzufügen:

Console

Fügen Sie Ihrer App in der Konsole Knoten für Komponenten hinzu.

Knoten für die Datenaufnahme hinzufügen

Knoten zur Datenverarbeitung hinzufügen

Datenspeicherknoten hinzufügen

Anwendung zur Verwendung bereitstellen

Nachdem Sie Ihre End-to-End-App mit allen erforderlichen Komponenten erstellt haben, müssen Sie sie nur noch bereitstellen.Console

Remote-Computer für das Streamen von Videos einrichten

Nachdem Sie eine bereitgestellte App zum Zählen der Belegung haben, die Streamingdaten empfangen, verarbeiten und speichern kann, müssen Sie Videodaten in die App streamen.

In diesem Tutorial erstellen Sie eine Compute Engine-VM-Instanz, auf der ein Video gehostet wird, und senden die Streaming-Videodaten von der VM.

Linux-VM erstellen

Der erste Schritt beim Senden von Videos von einer Compute Engine-VM-Instanz ist das Erstellen der VM-Instanz.

Console

VM-Umgebung einrichten

Nachdem die VM gestartet wurde, können Sie über die Console eine SSH-Verbindung in Ihrem Browser herstellen. Nachdem Sie diese Verbindung hergestellt haben, können Sie das vaictl-Befehlszeilentool herunterladen, um Videos in Ihre App aufzunehmen.

Console

SSH-Verbindung zu Ihrer VM herstellen

vaictl-Befehlszeilentool herunterladen

Videodatei in Ihre App aufnehmen

Nachdem Sie Ihre VM-Umgebung eingerichtet haben, können Sie eine Beispielvideodatei kopieren und dann vaictl verwenden, um die Videodaten in Ihre App zur Erfassung der Belegung zu streamen.

SSH im Browser

Beispielvideo auf Ihre VM kopieren

Video von der VM streamen und Daten in Ihre App aufnehmen

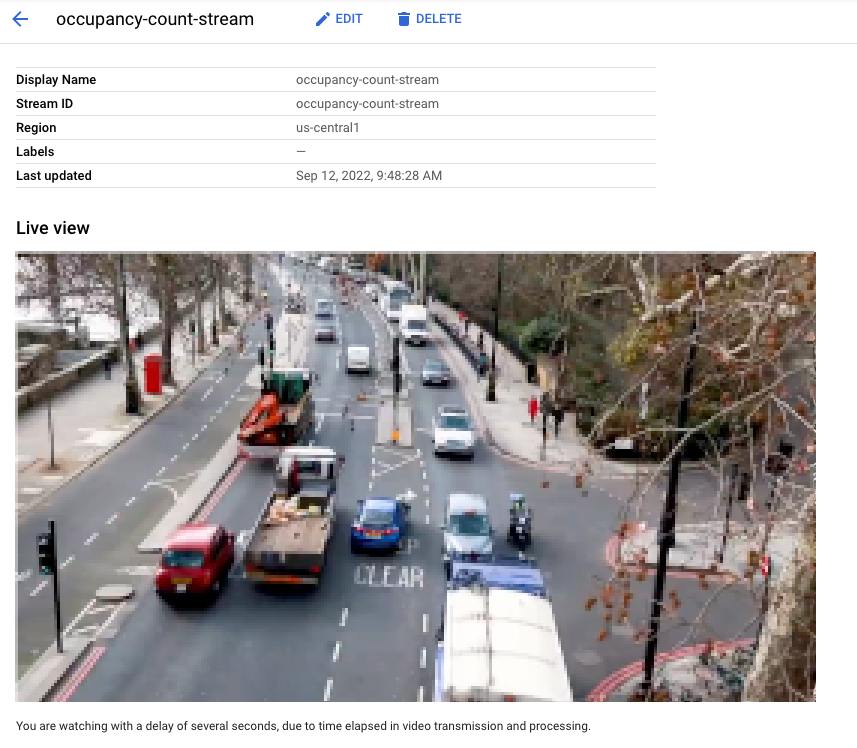

Es kann etwa 100 Sekunden dauern, bis das Video nach dem Starten des vaictl-Aufnahmevorgangs im Dashboard angezeigt wird.

Nachdem die Streamaufnahme verfügbar ist, können Sie den Videofeed auf dem Tab Streams des Vertex AI Vision-Dashboards sehen, indem Sie den occupancy-count-stream-Stream auswählen.

Videocontent im Speicher-Warehouse suchen

Nachdem Sie Videodaten in Ihre Verarbeitungs-App aufgenommen haben, können Sie analysierte Videodaten ansehen und die Daten anhand von Informationen aus der Belegungsanalyse durchsuchen.

Console

Bereinigen

Damit Ihrem Google Cloud-Konto die in dieser Anleitung verwendeten Ressourcen nicht in Rechnung gestellt werden, löschen Sie entweder das Projekt, das die Ressourcen enthält, oder Sie behalten das Projekt und löschen die einzelnen Ressourcen.