Cette page décrit les étapes de dépannage qui vous aideront si vous rencontrez des problèmes lors de l'utilisation de Vertex AI.

Les étapes de dépannage pour certains composants Vertex AI sont listées séparément. Consultez les références suivantes :

Cliquez sur l'une des catégories ci-après pour filtrer le contenu de cette page :

Résoudre les problèmes avec les investigations Cloud Assist

Lorsque vous connectez Vertex AI à d'autres produits Google Cloud , les investigations Cloud Assist peuvent vous aider à résoudre les problèmes d'intégration complexes.

- Activez et configurez l'API Cloud Assist Investigations.

- Déterminez quels produits dont dépend le nom de votre charge de travail figurent dans la liste des produits compatibles.

- Créez une investigation et décrivez les symptômes en détail. Veillez à mentionner toutes les ressources dont dépend le pipeline.

- À mesure que vous saisissez du texte, la boîte de dialogue vous suggère des ressources à ajouter à l'enquête. Examinez cette liste et ajoutez les ressources pertinentes avant d'exécuter l'enquête.

Modèles AutoML

Cette section décrit les étapes de dépannage qui vous seront utiles en cas de problèmes avec AutoML.

Étiquettes manquantes dans l'ensemble de test, de validation ou d'entraînement

Problème

Lorsque vous utilisez la division par défaut des données lors de l'entraînement d'un modèle de classification AutoML, Vertex AI peut affecter trop peu d'instances d'une classe à un ensemble particulier (test, validation ou entraînement), ce qui entraîne une erreur pendant l'entraînement. Ce problème se produit plus fréquemment si vous avez des classes déséquilibrées ou une petite quantité de données d'entraînement.

Solution

Pour résoudre ce problème, ajoutez des données d'entraînement, répartissez manuellement vos données pour attribuer suffisamment de classes à chaque ensemble, ou supprimez les étiquettes les moins fréquentes de votre ensemble de données. Pour en savoir plus, consultez la page À propos des divisions de données pour les modèles AutoML.

Vertex AI Studio

Lorsque vous utilisez Vertex AI Studio, les erreurs suivantes peuvent s'afficher :

Toute tentative de réglage d'un modèle renvoie Internal error encountered.

Problème

Vous rencontrez une erreur Internal error encountered lorsque vous essayez d'ajuster un modèle.

Solution

Exécutez la commande curl suivante pour créer un ensemble de données Vertex AI vide. Assurez-vous de configurer votre ID de projet dans la commande.

PROJECT_ID=PROJECT_ID

curl \

-X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://europe-west4-aiplatform.googleapis.com/ui/projects/$PROJECT_ID/locations/europe-west4/datasets \

-d '{

"display_name": "test-name1",

"metadata_schema_uri": "gs://google-cloud-aiplatform/schema/dataset/metadata/image_1.0.0.yaml",

"saved_queries": [{"display_name": "saved_query_name", "problem_type": "IMAGE_CLASSIFICATION_MULTI_LABEL"}]

}'

Une fois la commande terminée, attendez cinq minutes et relancez le réglage du modèle.

Code d'erreur : 429

Problème

Vous rencontrez l'erreur suivante :

429: The online prediction request quota is exceeded for PUBLIC_BASE_MODEL_NAME.

Solution

Réessayez plus tard avec un intervalle entre les tentatives. Si vous rencontrez encore des erreurs, contactez l'assistance Vertex AI.

Code d'erreur : 410

Problème

Vous rencontrez l'erreur suivante :

410: The request is missing the required authentication credential. Expected OAuth 2.0 access token, login cookie, or other valid authentication credential.

Solution

Pour en savoir plus, consultez la page Présentation de l'authentification.

Code d'erreur : 403

Problème

Vous rencontrez l'erreur suivante :

403: Permission denied.

Solution

Assurez-vous que le compte qui accède à l'API dispose des autorisations appropriées.

Vertex AI Pipelines

Cette section décrit les étapes de dépannage qui vous seront utiles en cas de problèmes avec Vertex AI Pipelines.

Vous n'êtes pas autorisé à agir en tant que compte de service

Problème

Lorsque vous exécutez votre workflow Vertex AI Pipelines, le message d'erreur suivant peut s'afficher :

You do not have permission to act as service account: SERVICE_ACCOUNT. (or it may not exist).

Solution

Cette erreur signifie que le compte de service qui exécute votre workflow n'a pas accès aux ressources qu'il doit utiliser.

Pour résoudre ce problème, accordez à l'utilisateur l'autorisation iam.serviceAccounts.actAs sur le compte de service.

Erreur : les hachages des packages Python ne correspondent pas dans le composant Vertex AI Pipelines

Problème

Lorsque vous exécutez votre workflow Vertex AI Pipelines, l'erreur suivante peut s'afficher :

ERROR: THESE PACKAGES DO NOT MATCH THE HASHES FROM THE REQUIREMENTS FILE. If you have updated the package versions, please update the hashes. Otherwise, examine the package contents carefully; someone may have tampered with them.

Cela est dû à des conflits de version entre les bibliothèques Python de l'image de base du composant Vertex AI Pipelines et celles que le pipeline tente d'installer.

Solution

Intégrez toutes les dépendances listées avec ce message dans l'image utilisée par le composant Vertex AI Pipelines.

Erreur Internal error happened

Problème

Si votre pipeline échoue et affiche un message Internal error happened, consultez l'explorateur de journaux et recherchez le nom du pipeline. Un message d'erreur semblable à celui-ci pourrait apparaître :

java.lang.IllegalStateException: Failed to validate vpc network projects/PROJECT_ID/global/networks/VPC_NETWORK.APPLICATION_ERROR;google.cloud.servicenetworking.v1/ServicePeeringManagerV1.GetConsumerConfig;Reserved range: 'RANGE_NAME' not found for consumer project: 'PROJECT_ID' network: 'VPC_NETWORK'. com.google.api.tenant.error.TenantManagerException: Reserved range: 'RANGE_NAME' not found for consumer project

Cela signifie que l'appairage de réseaux VPC pour Vertex AI inclut une plage d'adresses IP qui a été supprimée.

Solution

Pour résoudre ce problème, mettez à jour l'appairage de VPC à l'aide de la commande update et incluez des plages d'adresses IP valides.

Audience de jeton d'ID ou habilitation OAuth fournie non valide

Problème

Lorsque vous exécutez votre workflow Vertex AI Pipelines, le message d'erreur suivant s'affiche :

google.auth.exceptions.RefreshError: ('invalid_scope: Invalid OAuth scope

or ID token audience provided.', {'error': 'invalid_scope',

'error_description': 'Invalid OAuth scope or ID token audience provided.'})

Solution

Cela signifie que vous n'avez pas fourni d'identifiants dans l'un des composants du pipeline ou que vous n'avez pas utilisé ai_platform.init() pour définir des identifiants.

Pour résoudre ce problème, définissez les identifiants du composant de pipeline concerné ou définissez les identifiants d'environnement et utilisez ai_platform.init() au début de votre code.

os.environ['GOOGLE_APPLICATION_CREDENTIALS'] = PATH_TO_JSON_KEY

Les composants Vertex AI Pipelines nécessitent plus d'espace disque que 100 Go

Problème

L'espace disque par défaut alloué aux composants Vertex AI Pipelines est de 100 Go et il n'est pas possible d'augmenter l'espace disque. Consultez l'outil public de suivi des problèmes pour ce problème.

Solution

Pour qu'un composant utilise plus de 100 Go d'espace disque, convertissez-le en tâche personnalisée à l'aide de la méthode des composants. Cet opérateur vous permet d'attribuer le type de machine et la taille de disque utilisés par le composant.

Pour obtenir un exemple d'utilisation de cet opérateur, consultez la section Vertex AI Pipelines : entraînement personnalisé avec des composants de pipeline Google Cloud prédéfinis, dans la section Convertir le composant en Section "Tâche personnalisée Vertex AI".

Problèmes de mise en réseau avec Vertex AI

Cette section décrit les étapes de dépannage qui vous seront utiles en cas de problèmes de mise en réseau pour Vertex AI.

gcloud services vpc-peerings get-vpc-service-controls \

--network YOUR_NETWORK

Les charges de travail ne peuvent pas accéder aux points de terminaison de votre réseau VPC lorsque vous utilisez des plages d'adresses IP publiques utilisées en mode privé pour Vertex AI

Problème

Par défaut, les plages d'adresses IP publiques utilisées en mode privé ne sont pas importées.

Solution

Pour utiliser des plages d'adresses IP publiques utilisées en mode privé, vous devez activer l'importation de ces plages.

com.google.api.tenant.error.TenantManagerException: Reserved range: nnn not found for consumer project

Problème

Vous recevez des erreurs de type com.google.api.tenant.error.TenantManagerException:

Reserved range: nnn not found for consumer project lorsque vous exécutez des charges de travail ou déployez des points de terminaison.

Cela se produit lorsque vous modifiez les réservations d'accès aux services privés pour vos charges de travail. Il est possible que les plages supprimées n'aient pas été enregistrées auprès de l'API Vertex AI.

Solution

Exécutez gcloud services vpc-peerings update pour servicenetworking après avoir mis à jour les allocations d'accès aux services privés.

Le pipeline ou la tâche ne peut pas accéder aux points de terminaison de votre réseau VPC appairé

Problème

Votre pipeline Vertex AI expire lorsqu'il tente de se connecter aux ressources de votre réseau VPC.

Solution

Pour résoudre le problème, essayez la procédure suivante :

- Assurez-vous d'avoir terminé toutes les étapes de la page Configurer l'appairage de réseaux VPC.

Vérifiez la configuration de votre réseau VPC appairé. Assurez-vous que votre réseau importe les routes depuis la plage de mise en réseau des services appropriée pendant l'exécution de votre tâche.

Assurez-vous que vous disposez d'une règle de pare-feu qui autorise les connexions de cette plage à la cible de votre réseau.

Si la connexion d'appairage n'importe aucune route pendant l'exécution de votre tâche, cela signifie que la configuration de mise en réseau du service n'est pas utilisée. Ceci est probablement dû au fait que vous avez terminé la configuration d'appairage avec un réseau autre que le réseau par défaut. Dans ce cas, veillez à spécifier votre réseau lorsque vous lancez une tâche. Utilisez le nom de réseau complet au format suivant :

projects/$PROJECT_ID/global/networks/$NETWORK_NAME.Pour en savoir plus, consultez la page Présentation des routes.

Le pipeline ou la tâche ne peuvent pas accéder aux points de terminaison sur d'autres réseaux que votre réseau

Problème

Votre pipeline ou votre job ne peuvent pas accéder aux points de terminaison des réseaux autres que le vôtre.

Solution

Par défaut, votre configuration d'appairage n'exporte que les routes vers les sous-réseaux locaux de votre VPC.

En outre, l'appairage transitif n'est pas compatible, et seuls les réseaux directement appairés peuvent communiquer.

- Pour autoriser Vertex AI à se connecter via votre réseau et atteindre les points de terminaison d'autres réseaux, vous devez exporter vos routes réseau vers votre connexion d'appairage. Modifiez la configuration de votre réseau VPC appairé et activez

Export custom routes.

Accéder à la page "Appairage de réseaux VPC"

Comme l'appairage transitif n'est pas disponible, l'IA Vertex n'apprend pas les routes vers d'autres réseaux et services appairés, même si Export Custom Routes est activé. Pour en savoir plus sur les solutions de contournement, consultez l'article Étendre la joignabilité du réseau de Vertex AI Pipelines.

No route to host sans conflit de route évident dans la console Google Cloud

Problème

Les seules routes que vous pouvez voir dans la console Google Cloud sont celles connues de votre propre VPC, ainsi que les plages réservées lorsque vous effectuez la configuration de l'appairage de réseaux VPC.

Dans de rares cas, un job Vertex AI peut déclencher une réclamation no route to host lorsqu'elle tente d'atteindre une adresse IP que votre VPC exporte vers le réseau Vertex AI.

Cela peut être dû au fait que les jobs Vertex AI s'exécutent dans un espace de noms de mise en réseau dans un cluster GKE géré dont la plage d'adresses IP est en conflit avec l'adresse IP cible. Pour en savoir plus, consultez Principes de base de la mise en réseau GKE.

Dans ces conditions, la charge de travail tente de se connecter à l'adresse IP dans son propre espace de noms réseau et génère l'erreur si elle ne parvient pas à l'atteindre.

Solution

Concevez votre charge de travail de manière à renvoyer ses adresses IP d'espace de noms local et à vérifier que cela n'entre pas en conflit avec les routes que vous exportez via la connexion d'appairage.

En cas de conflit, transmettez une liste de reservedIpRanges[] dans les paramètres du job qui ne chevauchent aucune plage de votre réseau VPC.

Le job utilise ces plages pour les adresses IP internes de la charge de travail.

RANGES_EXHAUSTED, RANGES_NOT_RESERVED

Problème

Les erreurs de type RANGES_EXHAUSTED, RANGES_NOT_RESERVED et RANGES_DELETED_LATER indiquent un problème lié à la configuration de l'appairage de réseaux VPC sous-jacente. Il s'agit d'erreurs de mise en réseau et non d'erreurs du service Vertex AI lui-même.

Solution

Face à une erreur RANGES_EXHAUSTED, vous devez d'abord déterminer si la réclamation est valide.

Accédez à l'Analyseur de réseau dans la console Cloud et recherchez les insights de type "Récapitulatif de l'attribution d'adresses IP" dans le réseau VPC. Si ces valeurs indiquent que l'allocation est à 100 % ou presque, vous pouvez effectuer l'une des opérations suivantes :

- Ajoutez une plage à la réservation ou prolongez celle existante. N'oubliez pas que toutes les plages doivent être contiguës.

- Si vous disposez de plages d'adresses IP non contiguës qui sont allouées, mais non utilisées, lancez de nouvelles charges de travail Vertex AI dans une autre région.

Tenez également compte du nombre maximal de tâches parallèles pouvant être exécutées avec une réservation d'une taille donnée.

Pour en savoir plus, consultez la section Erreurs de validation de Service Infrastructure

Si l'erreur persiste, contactez l'assistance.

Router status is temporarily unavailable

Problème

Lorsque vous lancez Vertex AI Pipelines, un message d'erreur semblable à celui-ci s'affiche :

Router status is temporarily unavailable. Please try again later

Solution

Le message d'erreur indique qu'il s'agit d'une condition temporaire. Essayez de lancer Vertex AI Pipelines à nouveau.

Si l'erreur persiste, contactez l'assistance.

Les charges de travail ne parviennent pas à résoudre les noms d'hôte des domaines DNS de votre VPC.

Problème

Les charges de travail Vertex AI ne parviennent pas à se connecter aux noms d'hôte configurés dans votre VPC. Vous avez déjà confirmé que ces noms d'hôte sont accessibles depuis les clients de votre VPC.

En effet, les charges de travail s'exécutent dans un projet géré par Google. Le VPC de cet environnement géré doit être appairé au vôtre pour pouvoir utiliser vos ressources réseau. De plus, toutes les zones DNS auxquelles ces charges de travail doivent accéder doivent être spécifiquement partagées avec le VPC géré par Google.

Solution

- Assurez-vous d'avoir configuré l'appairage de réseaux VPC pour Vertex AI dans votre réseau VPC.

Suivez les étapes pour partager votre zone DNS privée avec le réseau de producteurs Vertex AI. Notez que la procédure à suivre dépend de votre cas d'utilisation :

Assurez-vous que vos charges de travail Vertex AI sont lancées avec le flag

--networkspécifiant votre réseau VPC. Cela leur permet de s'exécuter sur le réseau géré par Google et d'accéder aux zones DNS que vous avez partagées.Activez la journalisation DNS dans votre règle de serveur DNS, reproduisez le problème, puis exécutez un autre test. Si la réponse DNS de la charge de travail est correcte, un filtre Cloud Logging pour

resource.type="dns_query"affichera des entrées de ce type :"resource": { "type": "dns_query", "labels": { "location": REGION, "project_id": PROJECT_ID, "source_type": "peering-zone", "target_name": "QUERY_TARGET, "target_type": "forwarding-zone" } }Vérifiez qu'une requête DNS provenant d'une instance du même sous-réseau peut résoudre les noms d'hôte à l'aide de votre serveur DNS.

Si le serveur DNS ne se trouve pas dans Google Cloud, assurez-vous que les règles de pare-feu à distance autorisent les connexions depuis

35.199.192.0/19.Exécutez un test de connectivité depuis l'instance de test vers le port

53/UDPsur l'adresse IP du serveur DNS. Par exemple, si le chemin d'accès mène à une règle de transfert, assurez-vous des points suivants :- S'il s'agit d'une règle de transfert régionale, elle doit se trouver dans la même région que le client.

- Il accepte les connexions sur

53/UDPet les transfère au serveur DNS approprié.

Problèmes de connectivité causés par des comportements côté client

Si vous rencontrez des problèmes de connectivité lorsque vous essayez d'utiliser les API Google Cloud, la cause première peut se trouver côté client. Cette section suggère des solutions côté client qui pourraient améliorer votre expérience.

Réinitialisation des connexions et perte de paquets

Problème

Lorsque vous tentez d'utiliser les API Google Cloud , vous rencontrez des réinitialisations de connexion et des pertes de paquets.

Solution

Pour résoudre ce problème, envisagez les solutions suivantes :

- Pour le trafic de transactions à volume élevé qui nécessitent une faible latence, vérifiez si des problèmes connus avec les cartes de ligne des clients sur site peuvent entraîner la réinitialisation des connexions TCP ou la perte de paquets.

- Déterminez si des services côté client dans le chemin de requête utilisent iptables. Il peut s'agir de clusters Kubernetes ou de certains pare-feu avec état et périphériques NAT. Par défaut, le sous-système de suivi des connexions (conntrack) Linux suit strictement les spécifications du protocole TCP et, par exemple, supprime les paquets TCP hors séquence. Pour désactiver ce comportement, activez le paramètre du noyau Linux

net.netfilter.nf_conntrack_tcp_be_liberalou son équivalent.

Connexions incomplètes

Problème

Lorsque vous essayez d'utiliser les API Google Cloud , vous rencontrez des problèmes de connexion incomplète.

Solution

Pour résoudre ce problème, envisagez les solutions suivantes :

- Lorsque le chemin de transfert comporte plusieurs routes vers le client, assurez-vous de bien comprendre le concept de transfert de chemin inverse. Désactivez ce comportement si vous pensez qu'il bloque les connexions.

- Pour les connexions à équilibrage de charge, vérifiez si vos règles de pare-feu entrantes autorisent les paquets de réponse pour les deux équilibreurs de charge.

Autres problèmes de connexion non liés à l'API

Pour résoudre les problèmes de connexion non liés à l'API, tenez compte des éléments suivants :

- Si des proxys se trouvent dans le chemin de la requête, déterminez s'ils peuvent être à l'origine des problèmes que vous rencontrez. Consultez la documentation et assurez-vous de résoudre les problèmes liés au proxy lorsque vous rencontrez des problèmes tels qu'une latence inexpliquée, des connexions interrompues, des remplacements DNS, des blocages cross-origin et d'autres problèmes similaires.

- En particulier lors de la gestion des réponses

429des API Google Cloud , la logique côté client qui relance immédiatement la connexion peut aggraver le problème. Assurez-vous de comprendre et d'implémenter un intervalle exponentiel entre les tentatives lorsque vous implémentez des nouvelles tentatives.

Inférence Vertex AI

Cette section décrit les étapes de dépannage qui vous seront utiles en cas de problèmes avec l'inférence Vertex AI.

Erreur de dépassement du quota de lot

Problème

Si vous obtenez une erreur telle que la suivante lors de l'exécution de tâches d'inférence par lot,

Quota exhausted. Please reach out to ai-platform-unified-feedback@google.com for

batch prediction quota increase.

Un job de prédiction par lot Vertex AI consomme le quota du projet locataire de prédiction par lot. Pour en savoir plus sur la demande d'augmentation de quota, consultez Quotas et limites de Vertex AI.

Erreur liée au dépassement du nombre de nouvelles tentatives

Problème

Si vous obtenez une erreur telle que la suivante lors de l'exécution de tâches d'inférence par lot, la machine exécutant le modèle personnalisé risque de ne pas pouvoir effectuer les inférences dans le délai imparti.

('Post request fails. Cannot get predictions. Error: Exceeded retries: Non-OK

result 504 (upstream request timeout) from server, retry=3, elapsed=600.04s.', 16)

Cela peut se produire lorsque le service d'inférence Vertex AI s'enregistre auprès du service Google Front End, qui proxy les connexions du client à l'API Vertex AI Inference.

Le service Google Front End met fin à la connexion et renvoie un code de réponse HTTP 500 au client s'il ne reçoit pas de réponse de l'API dans les 10 minutes.

Solution

Pour résoudre ce problème, essayez l'une des solutions suivantes :

- Augmentez le nombre de nœuds de calcul ou modifiez le type de machine.

- Créez votre conteneur d'inférence pour envoyer périodiquement des codes de réponse HTTP 102. Le compte à rebours de 10 minutes du service Google Front End est alors réinitialisé.

Projet déjà associé à un VPC

Problème

Lorsque vous déployez un point de terminaison, un message d'erreur tel que celui-ci peut s'afficher. Celui-ci indique que vos points de terminaison Vertex AI ont déjà utilisé un réseau cloud privé virtuel et que les ressources n'ont pas été nettoyées correctement.

Currently only one VPC network per user project is supported. Your project is

already linked to "projects/YOUR_SHARED_VPC_HOST_PROJECT/global/networks/YOUR_SHARED_VPC_NETWORK".

To change the VPC network, please undeploy all Vertex AI deployment resources,

delete all endpoint resources, and then retry creating resources in 30 mins.

Solution

Pour résoudre ce problème, essayez d'exécuter cette commande dans Cloud Shell.

gcloud services vpc-peerings delete \

--service=servicenetworking.googleapis.com \

--network=YOUR_SHARED_VPC_NETWORK \

--project=YOUR_SHARED_VPC_HOST_PROJECT

Cette opération déconnecte manuellement votre ancien réseau VPC du VPC Service Networking.

Échec inattendu du déploiement ou suppression du point de terminaison

Problème

Le déploiement d'un modèle échoue de manière inattendue, un point de terminaison est supprimé ou un modèle précédemment déployé est annulé.

Il est possible que votre compte de facturation ne soit pas valide. Si votre compte reste désactivé pendant une période prolongée, certaines ressources peuvent être supprimées des projets associés à ce compte. Par exemple, vos points de terminaison et vos modèles peuvent être supprimés. Les ressources supprimées ne peuvent pas être récupérées.

Solution

Pour résoudre ce problème, vous pouvez essayer les solutions suivantes :

- Vérifiez l'état de facturation de vos projets.

- Contactez l'assistance Cloud Billing pour obtenir de l'aide sur les questions de facturation.

Pour en savoir plus, consultez Questions sur la facturation.

Problèmes liés aux comptes de service personnalisés Vertex AI

Cette section décrit les étapes de dépannage qui vous seront utiles en cas de problèmes avec les comptes de service.

Le déploiement du modèle échoue avec une erreur serviceAccountAdmin liée au compte de service.

Problème

Le déploiement de votre modèle échoue avec une erreur telle que :

Failed to deploy model MODEL_NAME to

endpoint ENDPOINT_NAME due to the error: Failed to add IAM policy binding.

Please grant SERVICE_ACC_NAME@gcp-sa-aiplatform.iam.gserviceaccount.com the

iam.serviceAccountAdmin role on service account

vertex-prediction-role@PROJECT_INFO.iam.gserviceaccount.com

Solution

Cette erreur signifie que votre compte de service personnalisé n'a peut-être pas été configuré correctement. Pour créer un compte de service personnalisé avec les autorisations IAM appropriées, consultez la page Utiliser un compte de service personnalisé.

Impossible de récupérer le jeton d'identité lors de l'utilisation d'un compte de service personnalisé

Problème

Lorsque vous utilisez un compte de service personnalisé, les tâches d'entraînement exécutées sur une seule instance dupliquée ne peuvent pas atteindre le service de métadonnées Compute Engine requis pour récupérer un jeton.

Une erreur semblable à celle-ci s'affichera :

Failed to refresh jwt, retry number 0: ("Failed to retrieve http://metadata.google.internal/computeMetadata/v1/instance/service-accounts/default/identity?audience=...&format=full

from the Google Compute Engine Metadata service. Status: 404 Response:

\nb'Not Found\n'", <google.auth.transport.requests._Response object at

0x7fb19f058c50>)

Solution

Pour récupérer le jeton d'identité avec un compte de service personnalisé, vous devez utiliser iamcredentials.googleapis.com.

Modèles entraînés personnalisés

Cette section décrit les étapes de dépannage qui vous seront utiles en cas de problèmes avec les modèles personnalisés.

Problèmes d'entraînement personnalisé

Les problèmes suivants peuvent survenir lors de l'entraînement personnalisé. Ces problèmes s'appliquent aux ressources CustomJob et HyperparameterTuningJob, y compris celles créées par les ressources TrainingPipeline.

Code d'erreur : 400

Problème

Vous rencontrez l'erreur suivante :

400 Machine type MACHINE_TYPE is not supported.

Ce message d'erreur peut s'afficher si le type de machine sélectionné n'est pas compatible avec l'entraînement Vertex AI ou si une ressource spécifique n'est pas disponible dans la région sélectionnée.

Solution

N'utilisez que les types de machines disponibles dans les régions appropriées.

Instance dupliquée arrêtée avec un code d'état différent de zéro

Problème

Lors d'un entraînement distribué, toute erreur sur un nœud de calcul quelconque entraîne l'échec de l'entraînement.

Solution

Pour vérifier la trace de la pile du nœud de calcul, affichez vos journaux d'entraînement personnalisés dans la consoleGoogle Cloud .

Consultez les autres sujets de dépannage pour corriger les erreurs courantes puis créez une ressource CustomJob, HyperparameterTuningJob ou TrainingPipeline. Dans de nombreux cas, les codes d'erreur sont provoqués par des problèmes dans votre code d'entraînement et non par le service Vertex AI. Pour déterminer si tel est le cas, vous pouvez exécuter votre code d'entraînement sur votre ordinateur local ou sur Compute Engine.

Instance dupliquée à court de mémoire

Problème

Une erreur peut se produire si une instance de machine virtuelle (VM) d'entraînement manque de mémoire pendant l'entraînement.

Solution

Vous pouvez consulter l'utilisation de mémoire de vos VM d'entraînement dans la console Google Cloud .

Même lorsque cette erreur survient, il est possible que la VM n'affiche 100 % d'utilisation de ses ressources de mémoire car des services autres que votre application d'entraînement exécutés sur la VM consomment également des ressources. Pour les types de machines disposant de moins de mémoire, les autres services peuvent utiliser un pourcentage relativement élevé de la mémoire.

Par exemple, sur une VM n1-standard-4, ces services peuvent consommer jusqu'à 40 % de la mémoire.

Vous pouvez optimiser la consommation de mémoire de votre application d'entraînement ou choisir un type de machine avec plus de mémoire.

Ressources insuffisantes dans une région

Problème

Vous rencontrez un problème de rupture de stock dans une région.

Solution

Vertex AI entraîne vos modèles à l'aide des ressources Compute Engine. Vertex AI ne peut pas planifier votre charge de travail si la capacité de Compute Engine est insuffisante pour un certain processeur ou GPU dans une région. Ce problème n'est pas lié au quota de votre projet.

Lorsque vous atteignez la capacité Compute Engine, Vertex AI tente automatiquement d'effectuer CustomJob ou HyperparameterTuningJob jusqu'à trois fois. La tâche échoue si toutes les nouvelles tentatives échouent.

En général, les ruptures de stock surviennent lorsque vous utilisez des GPU. Si cette erreur se produit lorsque vous utilisez des GPU, essayez un autre type de GPU. Si vous pouvez vous le permettre, essayez d'effectuer l'entraînement dans une autre région.

Erreur d'autorisation lors de l'accès à un autre service Google Cloud

Si vous rencontrez une erreur d'autorisation lors de l'accès à un autre service Google Cloudà partir de votre code d'entraînement (par exemple : google.api_core.exceptions.PermissionDenied: 403), vous pouvez rencontrer l'un des problèmes suivants :

-

Problème

L'agent de service ou le compte de service qui exécute votre code (l'agent de service de code personnalisé Vertex AI pour votre projet ou un compte de service personnalisé) ne dispose pas des autorisations requises.

Solution

Découvrez comment accorder les autorisations de l'agent de service de code personnalisé Vertex AI ou configurer un compte de service personnalisé avec les autorisations nécessaires.

-

Problème

L'agent de service ou le compte de service qui exécute votre code dispose de l'autorisation requise, mais votre code tente d'accéder à une ressource du mauvais projet. Ce problème est particulièrement probable si le message d'erreur fait référence à un ID de projet se terminant par

-tp.Solution

En raison de la manière dont Vertex AI exécute votre code d'entraînement, ce problème peut survenir par inadvertance si vous ne spécifiez pas explicitement un ID de projet ou un numéro de projet dans votre code.

Découvrez comment résoudre ce problème en spécifiant un ID de projet ou un numéro de projet.

-

Problème

Votre job Vertex AI Training s'exécute correctement avec des données locales, mais pas avec des données provenant de Cloud Storage.

Solution

Ajoutez l'autorisation

storage.buckets.createà votre rôle d'agent de service de code personnalisé Vertex AI pour le projet.Découvrez comment résoudre ce problème en ajoutant des rôles spécifiques aux agents de service de Vertex AI.

Problèmes de performances lors de l'utilisation de Cloud Storage FUSE

Problème

Les jobs Cloud Storage FUSE s'exécutent lentement.

Solution

Consultez les "Consignes d'optimisation des performances" dans Utiliser Cloud Storage comme système de fichiers installé.

pip install échoue lors de l'utilisation de KFP avec VPC Service Controls

Problème

L'erreur suivante s'affiche :

ModuleNotFoundError: No module named MODULE_NAME. WARNING: Retrying (Retry(total=0, connect=None, read=None, redirect=None, status=None)) after connection broken by 'ConnectTimeoutError(<pip._vendor.urllib3.connection.HTTPSConnection object at 0x7f70250bac10>, 'Connection to pypi.org timed out. (connect timeout=15)')': /simple/nltk/

Solution

Le périmètre de service VPC Service Controls bloque l'accès de Vertex AI aux API et services tiers sur Internet. Pour installer les packages, utilisez packageUris afin d'installer les dépendances à partir des buckets Cloud Storage. Pour une discussion générale sur l'utilisation de cette technique, consultez "Utiliser des conteneurs personnalisés" dans VPC Service Controls avec Vertex AI.

Erreur interne

Problème

Échec de l'entraînement en raison d'une erreur système.

Solution

Le problème peut être temporaire. Essayez d'envoyer à nouveau le CustomJob, HyperparameterTuningJob ou TrainingPipeline. Si l'erreur persiste, contactez l'assistance.

Code d'erreur 500 lors de l'utilisation d'une image de conteneur personnalisée

Problème

Une erreur 500 s'affiche dans vos journaux.

Solution

Ce type d'erreur est probablement lié à un problème avec votre image de conteneur personnalisé et non à une erreur Vertex AI.

Le compte de service ne peut pas accéder au bucket Cloud Storage lors du déploiement sur un point de terminaison

Problème

Lorsque vous essayez de déployer un modèle sur un point de terminaison et que votre compte de service ne dispose pas de l'accès storage.objects.list au bucket Cloud Storage associé, le message d'erreur suivant peut s'afficher :

custom-online-prediction@TENANT_PROJECT_ID.iam.gserviceaccount.com

does not have storage.objects.list access to the Cloud Storage bucket.

Par défaut, le conteneur personnalisé qui déploie votre modèle utilise un compte de service qui n'a pas accès à votre bucket Cloud Storage.

Solution

Pour résoudre ce problème, essayez l'une des solutions suivantes :

Copiez le fichier auquel vous essayez d'accéder depuis le conteneur dans les artefacts de modèle lorsque vous importez le modèle. Vertex AI le copie dans un emplacement auquel le compte de service par défaut a accès, comme pour tous les autres artefacts de modèle.

Copiez le fichier dans le conteneur en l'intégrant au processus de création du conteneur.

Spécifiez un compte de service personnalisé.

NAS (Neural Architecture Search)

Problèmes connus

- Après l'annulation du job NAS, le job principal (le parent) s'arrête, mais certains essais enfants continuent d'afficher l'état En cours d'exécution. Ignorez l'état de l'essai enfant qui affiche En cours d'exécution dans ce cas. Les essais ont été arrêtés, mais l'UI continue d'afficher l'état En cours d'exécution. Tant que le job principal est arrêté, aucuns frais supplémentaires ne vous sont facturés.

- Après avoir signalé des récompenses dans l'application d'entraînement, vous devez attendre (en veille) pendant 10 minutes avant la fin des jobs d'essai.

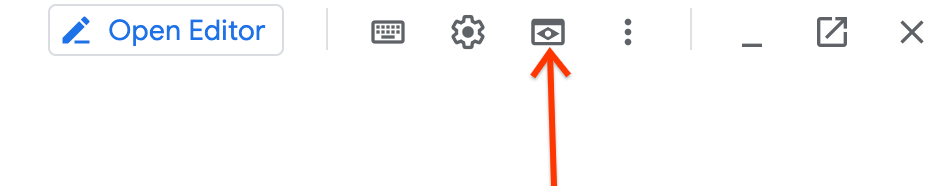

Lorsque vous exécutez Cloud Shell pour exécuter

TensorBoard, le lien de sortie généré peut ne pas fonctionner. Dans ce cas, notez le numéro de port, utilisez l'outil Aperçu sur le Web et sélectionnez le numéro de port approprié pour afficher les graphiques.Accédez à l'outil

Web Preview:

Si des messages d'erreur semblables à ce qui suit s'affichent dans les journaux de l'application d'entraînement, procédez comme suit :

gcsfuse errors: fuse: writeMessage: no such file or directory [16 0 0 0 218 255 255 255 242 25 111 1 0 0 0 0]Utilisez une machine avec davantage de mémoire RAM, car une condition OOM entraîne cette erreur.

Si votre application d'entraînement personnalisée ne parvient pas à trouver l'option

job-dirdu répertoire de job, importezjob_diravec un trait de soulignement plutôt qu'un trait d'union. Cette remarque est expliquée dans le tutoriel 1.Erreur NaN pendant l'entraînement Des erreurs NaN peuvent se produire dans le job d'entraînement, comme

NaN : Tensor had NaN values. Le taux d'apprentissage peut être trop élevé pour l'architecture suggérée. Pour en savoir plus, consultez la section Erreurs liées à la mémoire insuffisante et au taux d'apprentissage.Erreur OOM pendant l'entraînement Des erreurs OOM (mémoire insuffisante) peuvent se produire dans le job d'entraînement. La taille de lot peut être trop importante pour la mémoire de l'accélérateur. Pour en savoir plus, consultez la section Erreurs liées à la mémoire insuffisante et au taux d'apprentissage.

La tâche du contrôleur de sélection de modèle de tâche de proxy cesse de fonctionner Dans les rares cas où la tâche du contrôleur de sélection de modèle de tâche de proxy cesse de fonctionner, vous pouvez la reprendre en procédant comme suit :.

Expiration de la tâche du contrôleur de recherche de tâche de proxy Dans les rares cas où la tâche du contrôleur de recherche de tâche de proxy cesse de fonctionner, vous pouvez reprendre la tâche en suivant ces étapes.

Le compte de service n'est pas autorisé à accéder au bucket ou à Artifact Registry. Si vous obtenez une erreur comme

Vertex AI Service Agent service-123456789@gcp-sa-aiplatform-cc.iam.gserviceaccount.com does not have permission to access Artifact Registry repository projects/my-project/locations/my-region/repositories/nasou similaire pour l'accès au bucket, attribuez à ce compte de service un rôle d'éditeur de stockage dans votre projet.

Vertex AI Feature Store

Cette section décrit les étapes de dépannage qui vous seront utiles en cas problèmes avec Vertex AI Feature Store.

Erreur Resource not found lors de l'envoi d'une requête d'ingestion en flux continu ou de diffusion en ligne

Problème

Une fois que vous avez configuré un magasin de caractéristiques, un type d'entité ou des ressources de caractéristiques, un délai est nécessaire avant que ces ressources ne soient propagées au service FeaturestoreOnlineServingService. Cette propagation retardée peut parfois entraîner une erreur resource not found lorsque vous envoyez une requête d'ingestion en flux continu ou de diffusion en ligne immédiatement après la création d'une ressource.

Solution

Si vous obtenez cette erreur, attendez quelques minutes puis relancez votre requête.

L'ingestion par lots a réussi pour les nouvelles fonctionnalités, mais la requête de diffusion en ligne renvoie des valeurs vides

Problème

Pour les nouvelles fonctionnalités uniquement, il existe un délai avant que les fonctionnalités ne soient propagées au service FeaturestoreOnlineServingService. Les fonctionnalités et les valeurs existent, mais leur propagation peut prendre du temps. Cela peut entraîner le renvoi de valeurs vides par votre requête de diffusion en ligne.

Solution

Si vous constatez cette incohérence, attendez quelques minutes puis relancez votre requête de diffusion en ligne.

L'utilisation du processeur est élevée pour un nœud de diffusion en ligne

Problème

L'utilisation du processeur pour un nœud de diffusion en ligne est élevée.

Solution

Pour limiter ce problème, vous pouvez augmenter le nombre de nœuds de diffusion en ligne soit en augmentant manuellement le nombre de nœud soit en activant l'autoscaling. Notez que même si l'autoscaling est activé, Vertex AI Feature Store a besoin de temps pour rééquilibrer les données lorsque des nœuds sont ajoutés ou supprimés. Pour savoir comment afficher les métriques de distribution des valeurs de caractéristiques au fil du temps, consultez la page Afficher les métriques de valeur de caractéristique.

L'utilisation du processeur est élevée pour le nœud de diffusion en ligne le plus sollicité

Problème

Si l'utilisation du processeur est élevée pour le nœud le plus sollicité, vous pouvez augmenter le nombre de nœuds de diffusion ou modifier le modèle d'accès à l'entité en pseudo-aléatoire.

Solution

La définition du modèle d'accès des entités en pseudo-aléatoire atténue l'utilisation élevée du processeur résultant de l'accès fréquent d'entités proches les unes des autres dans le magasin de caractéristiques. Si aucune solution n'est efficace, implémentez un cache côté client pour éviter d'accéder plusieurs fois aux mêmes entités.

La latence de diffusion en ligne est élevée lorsque le nombre de requêtes par seconde est faible

Problème

La période d'inactivité ou de faible activité à un faible nombre de requêtes par seconde peut entraîner l'expiration de certains caches côté serveur. Cela peut entraîner une latence élevée lorsque le trafic vers les nœuds de diffusion en ligne reprend à un nombre de RPS standard ou supérieur.

Solution

Pour limiter ce problème, vous devez maintenir la connexion active en envoyant du trafic artificiel d'au moins 5 RPS au magasin de caractéristiques.

Le job d'ingestion par lots échoue au bout de six heures

Problème

Le job d'ingestion par lots peut échouer, car la session de lecture expire au bout de six heures.

Solution

Pour éviter le délai avant expiration, augmentez le nombre de nœuds de calcul pour effectuer le job d'ingestion dans le délai de six heures.

Erreur Resource exceeded lors de l'exportation des valeurs de caractéristiques

Problème

L'exportation d'un volume élevé de données peut échouer avec une erreur de dépassement de ressource si la tâche d'exportation dépasse le quota interne.

Solution

Pour éviter cette erreur, vous pouvez configurer les paramètres de période, start_time et end_time, afin de traiter de plus petites quantités de données à la fois. Pour en savoir plus sur l'exportation complète, consultez la page Exportation complète.

Vertex AI Vizier

Lorsque vous utilisez Vertex AI Vizier, vous pouvez rencontrer les problèmes suivants.

Erreur interne

Problème

L'erreur interne se produit en cas d'erreur système.

Solution

Elle peut être temporaire. Essayez de renvoyer la requête. Si l'erreur persiste, contactez l'assistance.

Erreurs d'autorisation lors de l'utilisation de rôles de compte de service avec Vertex AI

Problème

Des erreurs d'autorisation générales s'affichent lorsque vous utilisez des rôles de compte de service avec Vertex AI.

Ces erreurs peuvent s'afficher dans Cloud Logging, dans les journaux des composants du produit ou dans les journaux d'audit. Elles peuvent également apparaître dans n'importe quelle combinaison des projets concernés.

Ces problèmes peuvent être dus à l'une des raisons suivantes ou aux deux :

Utilisation du rôle

Service Account Token Creatorau lieu du rôleService Account User, ou inversement. Ces rôles accordent différentes autorisations sur un compte de service et ne sont pas interchangeables. Pour en savoir plus sur les différences entre les rôlesService Account Token CreatoretService Account User, consultez Rôles des comptes de service.Vous avez accordé des autorisations à un compte de service dans plusieurs projets, ce qui n'est pas autorisé par défaut.

Solution

Pour résoudre le problème, essayez une ou plusieurs des solutions suivantes :

Déterminez si le rôle

Service Account Token CreatorouService Account Userest nécessaire. Pour en savoir plus, consultez la documentation IAM pour les services Vertex AI que vous utilisez, ainsi que pour toute autre intégration de produit que vous utilisez.Si vous avez accordé des autorisations à un compte de service dans plusieurs projets, activez l'association des comptes de service à plusieurs projets en vous assurant que

iam.disableCrossProjectServiceAccountUsage. n'est pas appliquée. Pour vous assurer queiam.disableCrossProjectServiceAccountUsagen'est pas appliqué, exécutez la commande suivante :gcloud resource-manager org-policies disable-enforce \ iam.disableCrossProjectServiceAccountUsage \ --project=PROJECT_ID