In diesem Dokument erfahren Sie, wie Sie die Datenherkunft für Dataproc Hive-Jobs aktivieren und verwenden.

Sie aktivieren die Datenherkunft für Dataproc Hive-Jobs mit einer Initialisierungsaktion wenn Sie einen Cluster erstellen.

Wenn Sie die Hive-Datenherkunft in einem Cluster aktivieren, werden bei Hive-Jobs, die Sie an den Cluster senden, Datenherkunftsereereignisse erfasst und in Dataplex Universal Catalog veröffentlicht.

Herkunftsinformationen visualisieren

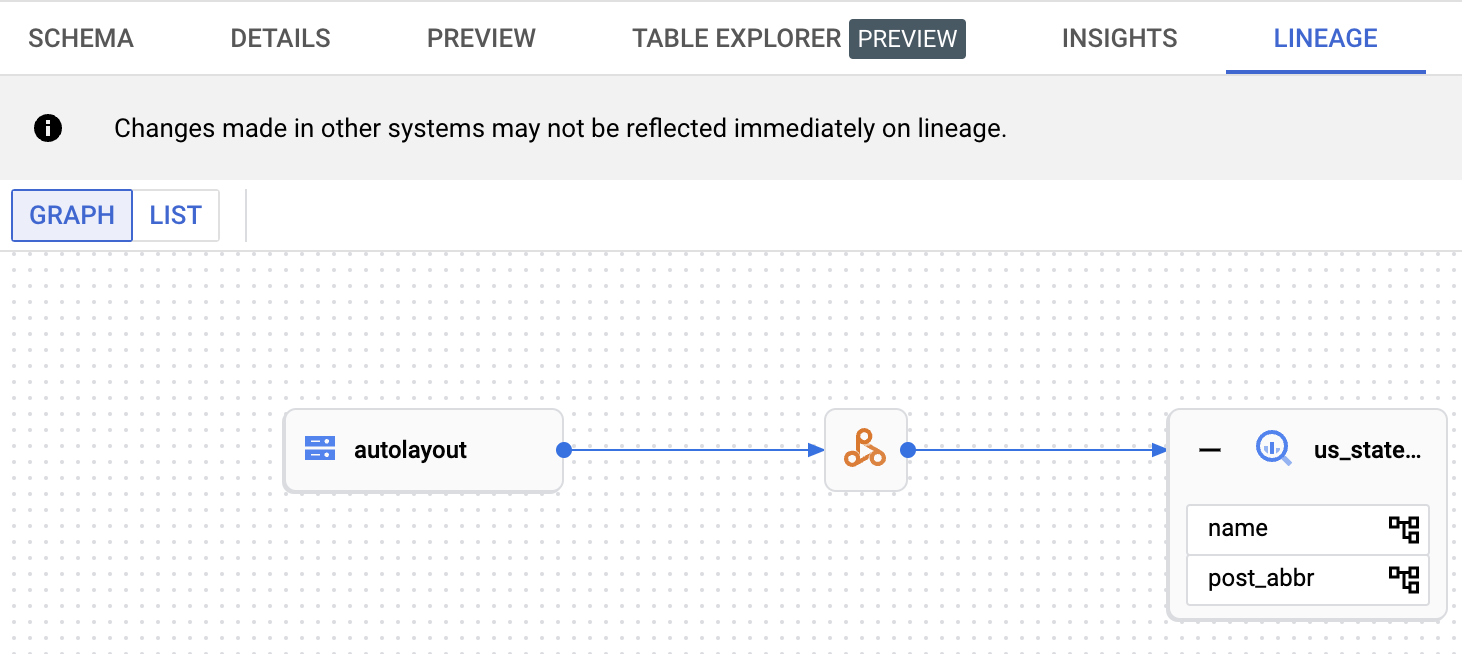

Ein Datenherkunftsdiagramm zeigt Beziehungen zwischen Ihren Projekt ressourcen und den Prozessen, mit denen sie erstellt wurden. Sie können in der Google Cloud Console über Dataplex Universal Catalog, BigQuery Studio und Vertex AI auf Herkunftsdiagramme zugreifen.

Preise

Die Dataproc Hive-Datenherkunft wird während der Vorschauphase ohne zusätzliche Kosten angeboten. Es gelten die Standard Preise für Dataproc.

Hinweis

Wählen Sie in der Google Cloud Console auf der Projektauswahlseite das Projekt aus, das den Dataproc-Cluster enthält, dessen Herkunft Sie verfolgen möchten.

Aktivieren Sie die Data Lineage API und die Dataplex API.

Erforderliche Rollen

Bitten Sie Ihren Administrator, Ihnen die folgenden IAM-Rollen für das Dienstkonto der Dataproc-Cluster-VM zuzuweisen, um die Berechtigungen zu erhalten, die Sie zum Verwenden der Datenherkunft in Dataproc benötigen:

-

Datenherkunft in Dataplex Universal Catalog ansehen oder die Data Lineage API verwenden:

Data Lineage-Betrachter (

roles/datalineage.viewer) -

Datenherkunft manuell mit der API erstellen:

Ersteller von Data Lineage-Ereignissen (

roles/datalineage.producer) -

Datenherkunft mit der API bearbeiten:

Data Lineage-Bearbeiter (

roles/datalineage.editor) -

Alle Vorgänge für die Datenherkunft ausführen:

Data Lineage-Administrator (

roles/datalineage.admin)

Weitere Informationen zum Zuweisen von Rollen finden Sie unter Zugriff auf Projekte, Ordner und Organisationen verwalten.

Sie können die erforderlichen Berechtigungen auch über benutzerdefinierte Rollen oder andere vordefinierte Rollen erhalten.

Hive-Datenherkunft aktivieren

Wenn Sie die Hive-Datenherkunft in einem Cluster aktivieren möchten, geben Sie die hive-lineage.sh

Initialisierungsaktion an, wenn

Sie einen Dataproc-Cluster erstellen.

Diese Initialisierungsaktion wird in regionalen Buckets in Cloud Storage gespeichert.

Beispiel für die Clustererstellung mit der gcloud CLI :

gcloud dataproc clusters create CLUSTER_NAME \

--project PROJECT_ID \

--region REGION \

--image-version IMAGE_VERSION \

--initialization-actions gs://goog-dataproc-initialization-actions-REGION/hive-lineage/hive-lineage.shErsetzen Sie Folgendes:

- CLUSTER_NAME: Der Name des Clusters.

- PROJECT_ID: Ihre Google Cloud Projekt-ID Projekt-IDs werden im Abschnitt Projektinformationen im Dashboard Google Cloud der Console aufgeführt.

- REGION: Die Compute Engine-Region , in der sich der Cluster befinden soll.

- IMAGE_VERSION Die gewünschte Image-Version für den Cluster.

--initialization-actions: Gibt eine Installationsaktion an, die sich an einem regionalen Cloud Storage -Standort befindet und die Hive-Datenherkunft aktiviert.- Optional können Sie die Initialisierungsaktion Hive-BigQuery-Connector hinzufügen. Wenn Sie BigQuery-Tabellen in Hive-Arbeitslasten einbinden möchten, müssen Sie den Hive-BigQuery-Connector im Cluster installieren. Im Beispiel Hive-Datenherkunft mit BigQuery, wird eine Initialisierungsaktion für den Connector ausgeführt, um den Hive-BigQuery-Connector im Cluster zu installieren.

Hive-Job senden

Wenn Sie einen Hive-Job senden an einen Dataproc-Cluster, der mit aktivierter Hive-Datenherkunft erstellt wurde, erfasst Dataproc die Datenherkunftsinformationen und meldet sie an Dataplex Universal Catalog.

Beispiel für das Senden eines Hive-Jobs mit der gcloud CLI

gcloud dataproc jobs submit hive \

--cluster=CLUSTER_NAME \

--project PROJECT_ID \

--region REGION \

--properties=hive.openlineage.namespace=CUSTOM_NAMESPACE \

--execute HIVE_QUERYErsetzen Sie Folgendes:

- CLUSTER_NAME: Der Name des Clusters.

- PROJECT_ID: Ihre Google Cloud Projekt-ID Projekt-IDs werden im Abschnitt Projektinformationen im Dashboard Google Cloud der Console aufgeführt.

- REGION: Die Compute Engine-Region , in der sich der Cluster befindet.

- CUSTOM_NAMESPACE: Ein optionaler benutzerdefinierter Hive-Namespace, den Sie zur Identifizierung des Hive-Jobs angeben können.

- HIVE_QUERY: Die Hive-Abfrage, die an den Cluster gesendet werden soll.

Anstatt eine Abfrage anzugeben, können Sie das

--execute HIVE_QUERYFlag durch ein--file SQL_FILEFlag ersetzen, um den Speicherort einer Datei anzugeben, die die Abfrage enthält.

Herkunft in Dataplex Universal Catalog ansehen

Ein Herkunftsdiagramm zeigt Beziehungen zwischen Ihren Projekt Ressourcen und den Prozessen, mit denen sie erstellt wurden. Sie können Datenherkunftsinformationen in der Google Cloud Console ansehen oder sie mit der Data Lineage API in Form von JSON-Daten abrufen.

Beispiel für die Hive-Datenherkunft mit BigQuery

Das Beispiel in diesem Abschnitt besteht aus den folgenden Schritten:

- Erstellen Sie einen Dataproc-Cluster, in dem die Hive-Datenherkunft aktiviert und der Hive-BigQuery-Connector auf dem Cluster installiert ist.

- Führen Sie eine Hive-Abfrage im Cluster aus, um Daten zwischen Hive-Tabellen zu kopieren.

- Sehen Sie sich das generierte Datenherkunftsdiagramm in BigQuery Studio an.

Dataproc-Cluster erstellen

Führen Sie den folgenden Befehl in einem lokalen Terminalfenster oder in Cloud Shell aus, um einen Dataproc-Cluster zu erstellen.

gcloud dataproc clusters create CLUSTER_NAME \ --project PROJECT_ID \ --region REGION \ --image-version IMAGE_VERSION \ --initialization-actions gs://goog-dataproc-initialization-actions-REGION/connectors/connectors.sh, gs://goog-dataproc-initialization-actions-REGION/hive-lineage/hive-lineage.sh \ --metadata hive-bigquery-connector-version=HIVE_BQ_VERSION

Hinweise:

- CLUSTER_NAME: Der Name des Clusters.

- PROJECT_ID: Ihre Google Cloud Projekt-ID Projekt-IDs werden im Abschnitt Projektinformationen im Dashboard Google Cloud der Console aufgeführt.

- REGION: Die Compute Engine-Region , in der sich der Cluster befinden soll.

- IMAGE_VERSION Die gewünschte Image-Version für den Cluster.

--initialization-actions: Diese Installationsaktionen in Cloud Storage installieren den Hive-BigQuery-Connector und aktivieren die Hive-Datenherkunft.- HIVE_BQ_VERSION: Gibt die

Version des Hive-BigQuery-Connectors an.

Das Flag

--metadataübergibt die Version an dieconnectors.shInitialisierungsaktion zur Installation des Hive-BigQuery-Connectors im Cluster.

Hive-Abfrage ausführen

Führen Sie eine Hive-Abfrage aus, um die folgenden Aktionen auszuführen:

- Erstellen Sie eine

us_statesexterne Tabelle mit Beispieldaten ausgs://cloud-samples-data/bigquery/hive-partitioning-samples/autolayout. - Erstellen Sie eine

us_states_copyverwaltete Tabelle im angegebenen BigQuery-Dataset. - Kopieren Sie alle Daten von

us_statesnachus_states_copy.

So führen Sie die Abfrage aus:

- Kopieren Sie in einem lokalen Terminalfenster oder in Cloud Shell mit einem Texteditor wie

viodernanodie folgende Hive-Abfrageanweisung in eine Dateihive-example.sqlund speichern Sie die Datei im aktuellen Verzeichnis. - Senden Sie die Datei

hive-example.sqlan den Dataproc-Cluster der zuvor erstellt wurde und ersetzen Sie das Flag--execute HIVE_QUERYdurch ein Flag--file SQL_FILE, um den Speicherort der gespeicherten Dateihive-example.sqlanzugeben. Beachten Sie, dass die PROJECT und BQ_DATASET Variablen ausgefüllt sein müssen.

Hive BigQueryStorageHandler

CREATE EXTERNAL TABLE us_states ( name STRING, post_abbr STRING ) STORED AS PARQUET LOCATION 'gs://cloud-samples-data/bigquery/hive-partitioning-samples/autolayout'; CREATE TABLE us_states_copy ( name STRING, post_abbr STRING ) STORED BY 'com.google.cloud.hive.bigquery.connector.BigQueryStorageHandler' TBLPROPERTIES ( 'bq.table'='PROJECT.BQ_DATASET.us_states_copy' ); INSERT INTO us_states_copy SELECT * FROM us_states;

Datenherkunftsdiagramm ansehen

Nachdem der Hive-Job erfolgreich abgeschlossen wurde, können Sie die Datenherkunft in BigQuery Studio in der Google Cloud Console ansehen:

Informationen zum Anzeigen von Diagrammen in BigQuery Studio finden Sie unter Herkunft in BigQuery ansehen. Informationen zum Interpretieren von Diagrammen finden Sie unter Datenherkunftsmodell.

Nächste Schritte

- Weitere Informationen zur Datenherkunft.