Das Dataproc Ranger Cloud Storage-Plug-in, das mit den Dataproc-Image-Versionen 1.5 und 2.0 verfügbar ist, aktiviert einen Autorisierungsdienst auf jeder Dataproc-Cluster-VM. Der Autorisierungsdienst wertet Anfragen vom Cloud Storage-Connector anhand von Ranger-Richtlinien aus und gibt, wenn die Anfrage zulässig ist, ein Zugriffstoken für das Cluster VM-Dienstkonto zurück.

Das Ranger Cloud Storage-Plug-in verwendet Kerberos zur Authentifizierung und ist in die Unterstützung des Cloud Storage-Connectors für Delegierungstokens integriert. Delegierungstokens werden in einer MySQL Datenbank auf dem Masterknoten des Clusters gespeichert. Das Root-Passwort für die Datenbank wird beim Erstellen des Dataproc-Clusters über Clustereigenschaften angegeben .

Hinweis

Weisen Sie dem Dienstkonto der Dataproc-VM in Ihrem Projekt die Rolle „ Ersteller von Dienstkonto-Tokens “ und die Rolle „IAM-Rollenadministrator“ zu.

Ranger Cloud Storage-Plug-in installieren

Führen Sie die folgenden Befehle in einem lokalen Terminalfenster oder in Cloud Shell aus, um das Ranger Cloud Storage-Plug-in beim Erstellen eines Dataproc-Clusters zu installieren.

Umgebungsvariablen festlegen

export CLUSTER_NAME=new-cluster-name \ export REGION=region \ export KERBEROS_KMS_KEY_URI=Kerberos-KMS-key-URI \ export KERBEROS_PASSWORD_URI=Kerberos-password-URI \ export RANGER_ADMIN_PASSWORD_KMS_KEY_URI=Ranger-admin-password-KMS-key-URI \ export RANGER_ADMIN_PASSWORD_GCS_URI=Ranger-admin-password-GCS-URI \ export RANGER_GCS_PLUGIN_MYSQL_KMS_KEY_URI=MySQL-root-password-KMS-key-URI \ export RANGER_GCS_PLUGIN_MYSQL_PASSWORD_URI=MySQL-root-password-GCS-URI

Hinweise:

- CLUSTER_NAME: Der Name des neuen Clusters.

- REGION: Die Region, in der der

Cluster erstellt wird, z. B.

us-west1. - KERBEROS_KMS_KEY_URI und KERBEROS_PASSWORD_URI: Weitere Informationen finden Sie unter Kerberos-Root-Hauptkonto-Passwort einrichten.

- RANGER_ADMIN_PASSWORD_KMS_KEY_URI und RANGER_ADMIN_PASSWORD_GCS_URI: Weitere Informationen finden Sie unter Ranger-Administratorpasswort einrichten.

- RANGER_GCS_PLUGIN_MYSQL_KMS_KEY_URI und RANGER_GCS_PLUGIN_MYSQL_PASSWORD_URI: Richten Sie ein MySQL-Passwort nach derselben Vorgehensweise ein, die Sie unter Ranger-Administratorpasswort einrichtenverwendet haben.

Dataproc-Cluster erstellen

Führen Sie den folgenden Befehl aus, um einen Dataproc-Cluster zu erstellen und das Ranger Cloud Storage-Plug-in auf dem Cluster zu installieren.

gcloud dataproc clusters create ${CLUSTER_NAME} \

--region=${REGION} \

--scopes cloud-platform \

--enable-component-gateway \

--optional-components=SOLR,RANGER \

--kerberos-kms-key=${KERBEROS_KMS_KEY_URI} \

--kerberos-root-principal-password-uri=${KERBEROS_PASSWORD_URI} \

--properties="dataproc:ranger.gcs.plugin.enable=true, \

dataproc:ranger.kms.key.uri=${RANGER_ADMIN_PASSWORD_KMS_KEY_URI}, \

dataproc:ranger.admin.password.uri=${RANGER_ADMIN_PASSWORD_GCS_URI}, \

dataproc:ranger.gcs.plugin.mysql.kms.key.uri=${RANGER_GCS_PLUGIN_MYSQL_KMS_KEY_URI}, \

dataproc:ranger.gcs.plugin.mysql.password.uri=${RANGER_GCS_PLUGIN_MYSQL_PASSWORD_URI}"

Hinweise:

- Image-Version 1.5: Wenn Sie einen Cluster mit der Image-Version 1.5 erstellen (siehe

Versionen auswählen),

fügen Sie das Flag

--metadata=GCS_CONNECTOR_VERSION="2.2.6" or higherhinzu, um die erforderliche Connector-Version zu installieren.

Installation des Ranger Cloud Storage-Plug-ins prüfen

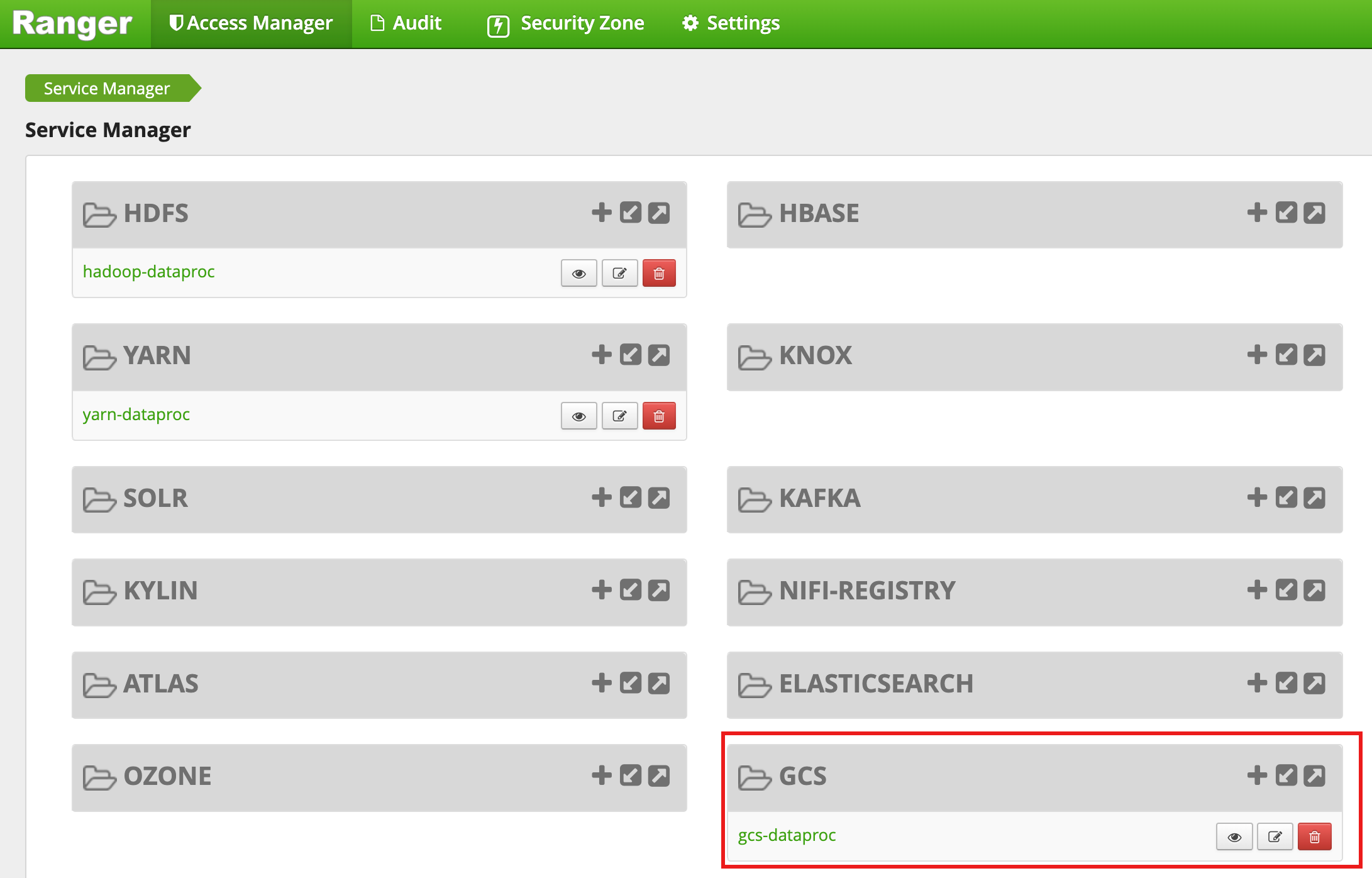

Nachdem der Cluster erstellt wurde, wird in der Ranger-Admin-Weboberfläche ein GCS Diensttyp mit dem Namengcs-dataproc,

angezeigt.

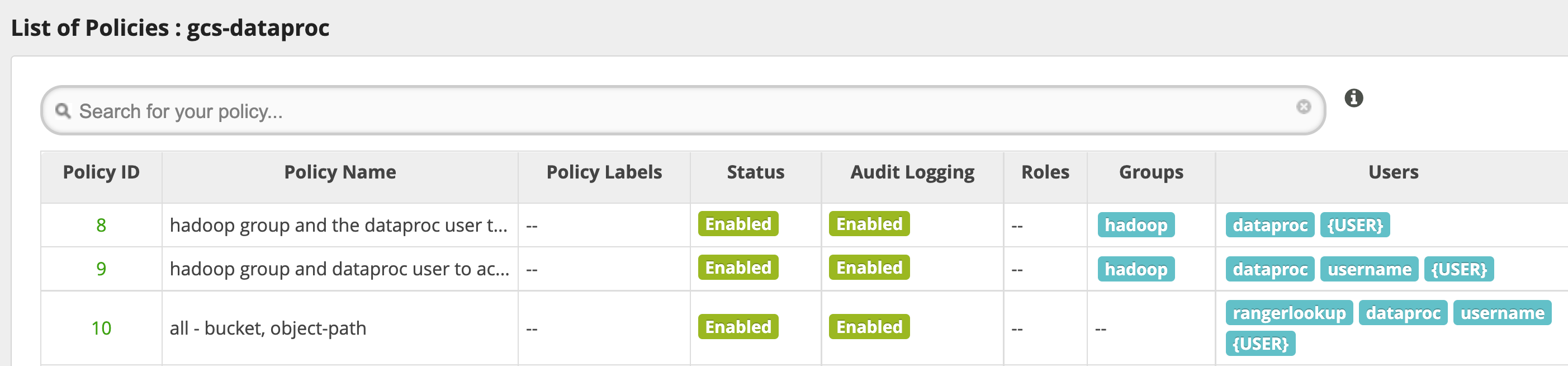

Standardrichtlinien für das Ranger Cloud Storage-Plug-in

Der Standarddienst gcs-dataproc hat die folgenden Richtlinien:

Richtlinien zum Lesen aus und Schreiben in die Staging- und temporären Buckets des Dataproc Clusters

Eine

all - bucket, object-path-Richtlinie, mit der alle Nutzer auf Metadaten für alle Objekte zugreifen können. Dieser Zugriff ist erforderlich, damit der Cloud Storage-Connector HCFS (Hadoop Compatible Filesystem) Vorgänge ausführen kann.

Tipps zur Nutzung

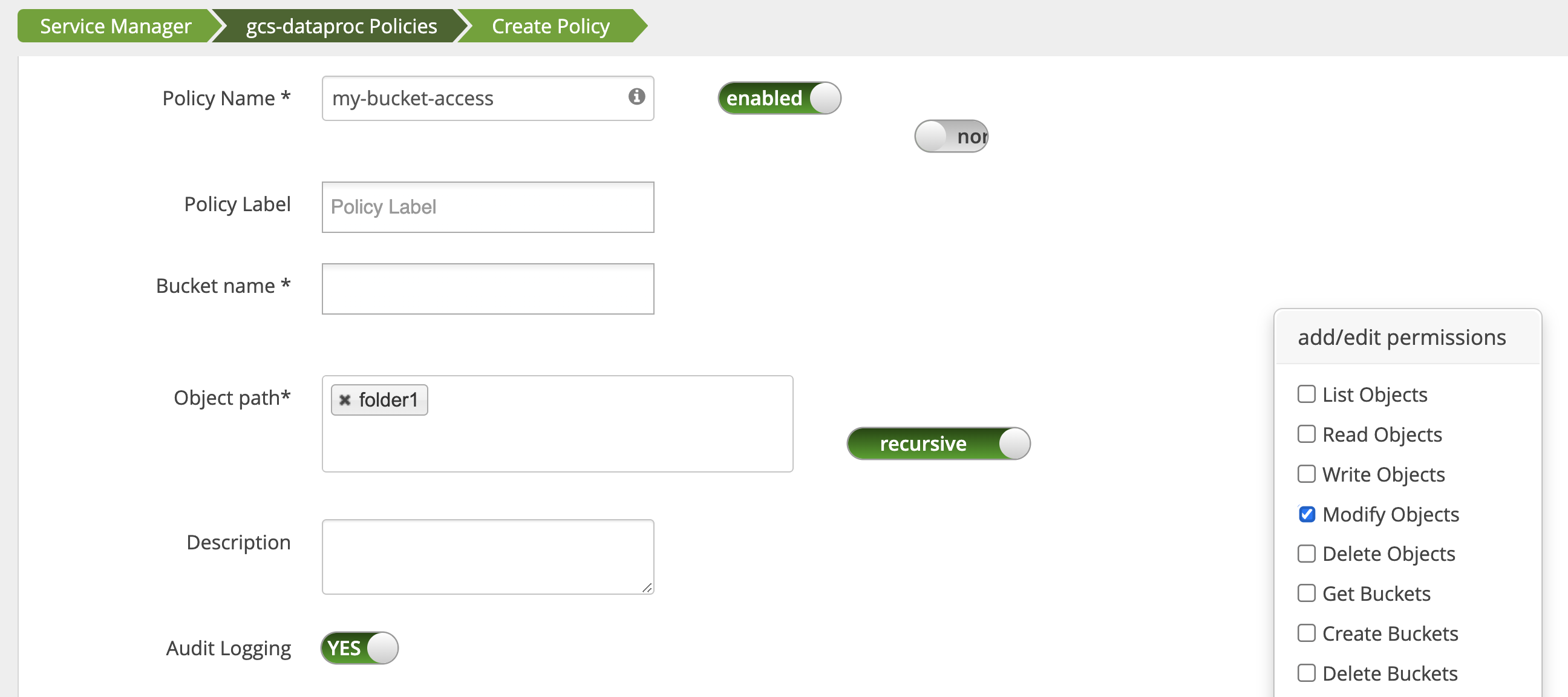

App-Zugriff auf Bucket-Ordner

Für Apps, die temporäre Dateien in einem Cloud Storage-Bucket erstellen, können Sie die Berechtigungen Modify Objects, List Objects und Delete Objects

für den Cloud Storage-Bucket-Pfad gewähren und dann den Modus

recursive auswählen, um die Berechtigungen auf Unterpfade im angegebenen Pfad zu erweitern.

Schutzmaßnahmen

So verhindern Sie die Umgehung des Plug-ins:

Gewähren Sie dem Dienstkonto der VM Zugriff auf die Ressourcen in Ihren Cloud Storage Buckets, damit es mit eingeschränkten Zugriffstokens Zugriff auf diese Ressourcen gewähren kann (siehe IAM-Berechtigungen für Cloud Storage). Entfernen Sie außerdem den Zugriff von Nutzern auf Bucket-Ressourcen, um den direkten Bucket-Zugriff durch Nutzer zu vermeiden.

Deaktivieren Sie

sudound andere Möglichkeiten für den Root-Zugriff auf Cluster-VMs, einschließlich der Aktualisierung dersudoerDatei, um Identitätswechsel oder Änderungen an den Authentifizierungs und Autorisierungseinstellungen zu verhindern. Weitere Informationen finden Sie in der Linux-Anleitung zum Hinzufügen oder Entfernen vonsudoNutzerberechtigungen.Verwenden Sie

iptable, um direkte Zugriffsanfragen von Cluster-VMs an Cloud Storage zu blockieren. Sie können beispielsweise den Zugriff auf den VM-Metadatenserver blockieren, um den Zugriff auf die Anmeldedaten oder das Zugriffstoken des VM-Dienstkontos zu verhindern, die zur Authentifizierung und Autorisierung des Zugriffs auf Cloud Storage verwendet werden (sieheblock_vm_metadata_server.sh, ein Initialisierungsskript dasiptableRegeln verwendet, um den Zugriff auf den VM-Metadatenserver zu blockieren).

Spark-, Hive-on-MapReduce- und Hive-on-Tez-Jobs

Um sensible Details zur Nutzerauthentifizierung zu schützen und die Last auf das Key Distribution Center (KDC) zu reduzieren, verteilt der Spark-Treiber keine Kerberos Anmeldedaten an die Executors. Stattdessen ruft der Spark-Treiber ein Delegierung token vom Ranger Cloud Storage-Plug-in ab und verteilt es dann an die Executors. Die Executors verwenden das Delegierungstoken zur Authentifizierung beim Ranger Cloud Storage-Plug-in und tauschen es gegen ein Google-Zugriffstoken ein, das den Zugriff auf Cloud Storage ermöglicht.

Hive-on-MapReduce- und Hive-on-Tez-Jobs verwenden ebenfalls Tokens für den Zugriff auf Cloud Storage. Verwenden Sie die folgenden Eigenschaften, um Tokens für den Zugriff auf bestimmte Cloud Storage-Buckets abzurufen, wenn Sie die folgenden Jobtypen senden:

Spark-Jobs:

--conf spark.yarn.access.hadoopFileSystems=gs://bucket-name,gs://bucket-name,...

Hive-on-MapReduce-Jobs:

--hiveconf "mapreduce.job.hdfs-servers=gs://bucket-name,gs://bucket-name,..."

Hive-on-Tez-Jobs:

--hiveconf "tez.job.fs-servers=gs://bucket-name,gs://bucket-name,..."

Spark-Job-Szenario

Ein Spark-Wordcount-Job schlägt fehl, wenn er über ein Terminalfenster auf einer Dataproc-Cluster-VM ausgeführt wird, auf der das Ranger Cloud Storage-Plug-in installiert ist.

spark-submit \

--conf spark.yarn.access.hadoopFileSystems=gs://${FILE_BUCKET} \

--class org.apache.spark.examples.JavaWordCount \

/usr/lib/spark/examples/jars/spark-examples.jar \

gs://bucket-name/wordcount.txt

Hinweise:

- FILE_BUCKET: Cloud Storage-Bucket für den Spark-Zugriff.

Fehlerausgabe:

Caused by: com.google.gcs.ranger.client.shaded.io.grpc.StatusRuntimeException: PERMISSION_DENIED: Access denied by Ranger policy: User: '<USER>', Bucket: '<dataproc_temp_bucket>', Object Path: 'a97127cf-f543-40c3-9851-32f172acc53b/spark-job-history/', Action: 'LIST_OBJECTS'

Hinweise:

spark.yarn.access.hadoopFileSystems=gs://${FILE_BUCKET}ist in einer Kerberos fähigen Umgebung erforderlich.

Fehlerausgabe:

Caused by: java.lang.RuntimeException: Failed creating a SPNEGO token. Make sure that you have run `kinit` and that your Kerberos configuration is correct. See the full Kerberos error message: No valid credentials provided (Mechanism level: No valid credentials provided)

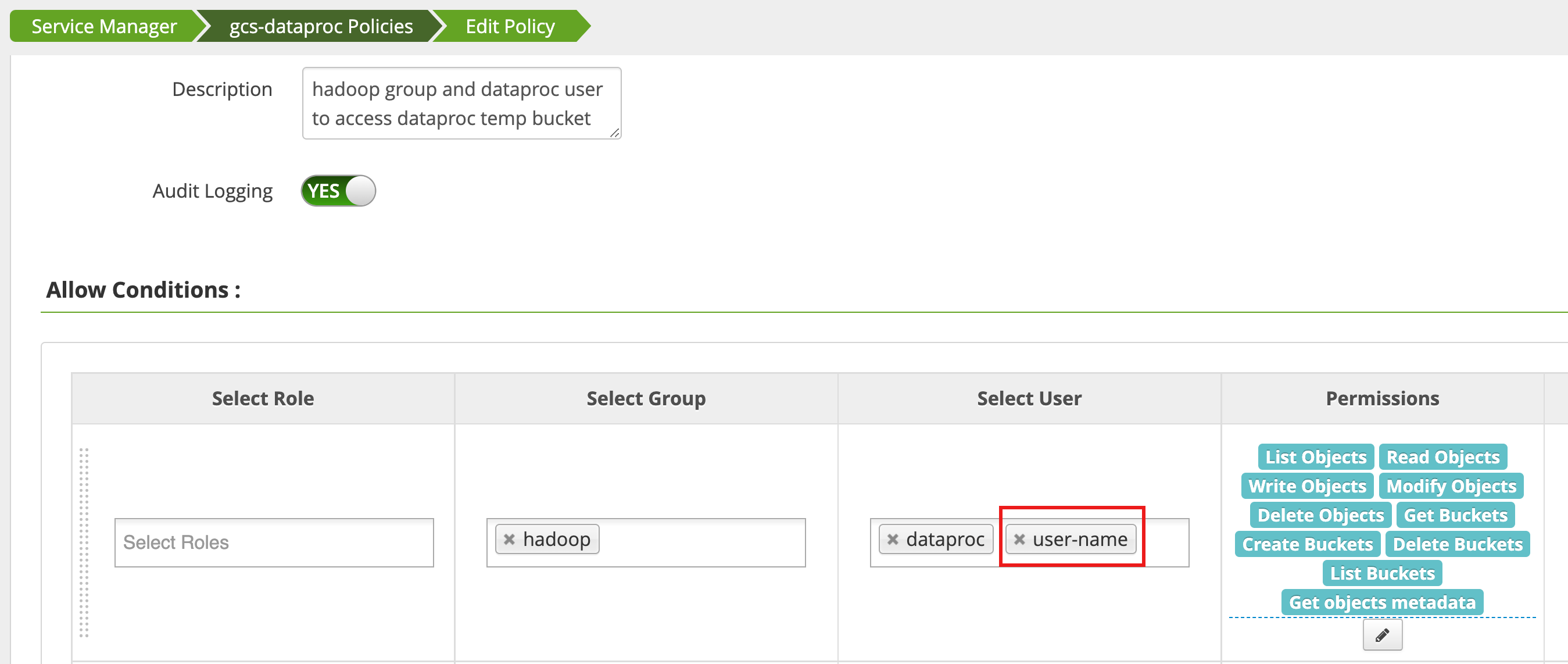

Eine Richtlinie wird mit dem Access Manager in der Ranger-Admin-Weboberfläche

bearbeitet, um username der Liste der Nutzer hinzuzufügen, die List Objects und andere Berechtigungen für den temp-Bucket

haben.

Beim Ausführen des Jobs wird ein neuer Fehler generiert.

Fehlerausgabe:

com.google.gcs.ranger.client.shaded.io.grpc.StatusRuntimeException: PERMISSION_DENIED: Access denied by Ranger policy: User: <USER>, Bucket: '<file-bucket>', Object Path: 'wordcount.txt', Action: 'READ_OBJECTS'

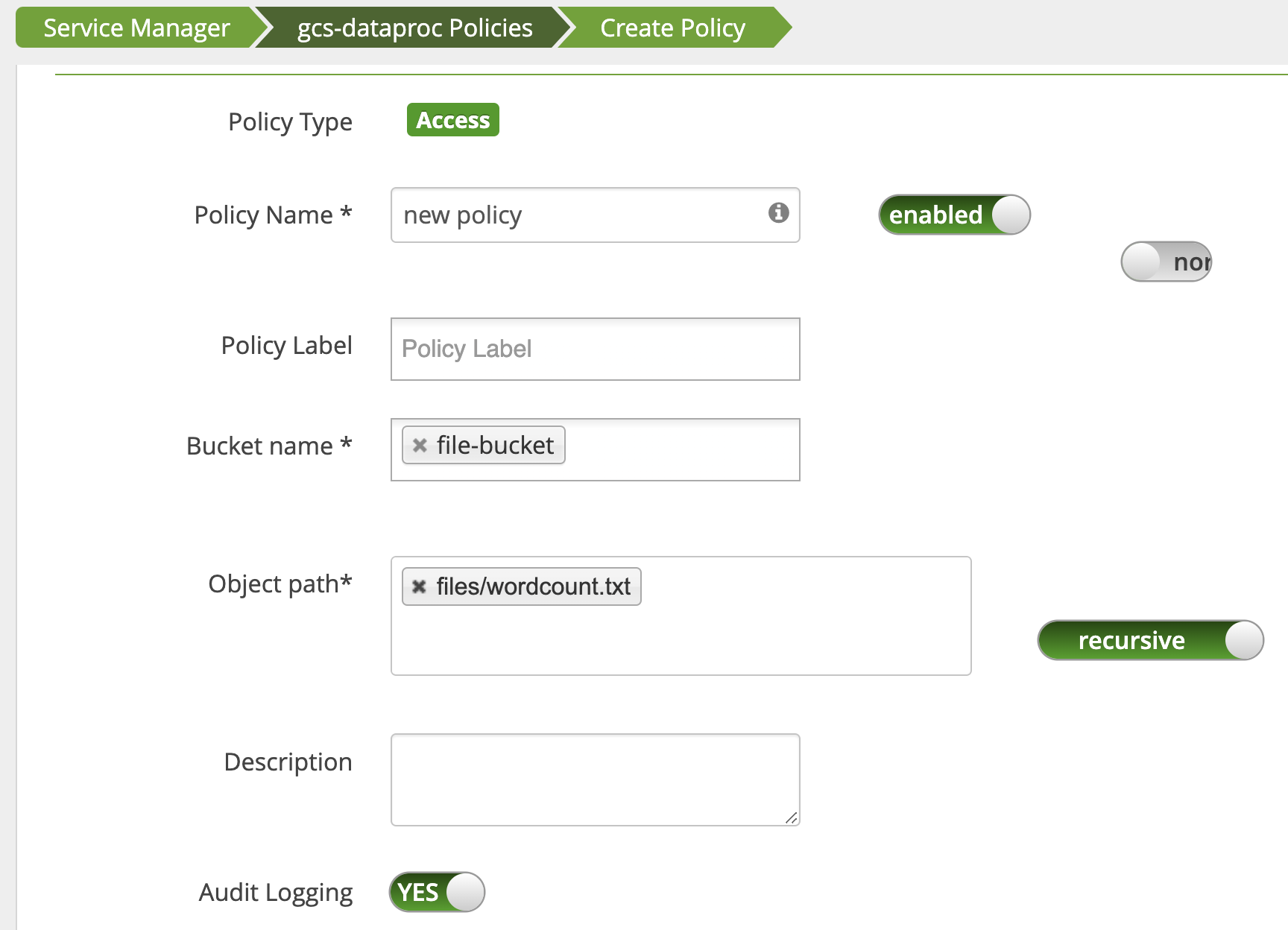

Eine Richtlinie wird hinzugefügt, um dem Nutzer Lesezugriff auf den wordcount.text

Cloud Storage-Pfad zu gewähren.

Der Job wird ausgeführt und abgeschlossen.

INFO com.google.cloud.hadoop.fs.gcs.auth.GcsDelegationTokens: Using delegation token RangerGCSAuthorizationServerSessionToken owner=<USER>, renewer=yarn, realUser=, issueDate=1654116824281, maxDate=0, sequenceNumber=0, masterKeyId=0 this: 1 is: 1 a: 1 text: 1 file: 1 22/06/01 20:54:13 INFO org.sparkproject.jetty.server.AbstractConnector: Stopped