La métrica de calidad de traducción BLEU

BLEU (Bilingual Evaluation Understudy) es una métrica para evaluar el texto traducido por una máquina. La puntuación BLEU es un número entre cero y uno que mide la similitud del texto traducido automáticamente con un conjunto de traducciones de referencia de alta calidad:

- Una puntuación de 0 significa que el resultado de la traducción automática no se solapa con la traducción de referencia, lo que indica una baja calidad de la traducción.

- Una puntuación de 1 significa que hay una superposición perfecta con las traducciones de referencia, lo que indica una alta calidad de traducción.

Limitaciones de BLEU

BLEU es una métrica basada en corpus. La métrica BLEU no funciona bien cuando se usa para evaluar frases concretas. Las frases sueltas pueden obtener puntuaciones BLEU muy bajas, aunque capturen la mayor parte del significado. Como las estadísticas de n-gramas de frases individuales son menos significativas, BLEU es, por diseño, una métrica basada en corpus, donde las estadísticas se acumulan en todo un corpus al calcular la puntuación. La métrica BLEU no se puede factorizar para frases concretas.

BLEU no distingue entre palabras de contenido y palabras funcionales. La métrica BLEU no distingue el contenido de las palabras funcionales. Una palabra de función omitida, como a, recibe la misma penalización que si el nombre NASA se sustituyera erróneamente por ESA.

BLEU no es una buena métrica para captar el significado y la gramática de las frases. Si se elimina una sola palabra, como no, se puede cambiar la polaridad de una frase. Además, si solo se tienen en cuenta los n-gramas con n≤4, se ignoran las dependencias de largo alcance, por lo que BLEU a menudo solo impone una pequeña penalización por las frases que no son gramaticales.

BLEU se basa en la normalización y la tokenización. Antes de calcular la puntuación BLEU, las traducciones de referencia y candidatas se normalizan y se tokenizan. La elección de los pasos de esos procesos afecta significativamente a la puntuación BLEU final.

Cómo interpretar las puntuaciones BLEU

A continuación, se ofrecen directrices generales sobre cómo interpretar las puntuaciones BLEU que se expresan como porcentajes, no como decimales:

| Puntuación BLEU (%) | Interpretación |

|---|---|

| < 10 | Casi inútil |

| 10-19 | Es difícil entender la idea principal |

| 20 - 29 | La idea principal es clara, pero contiene errores gramaticales importantes |

| 30 - 40 | Traducciones comprensibles y de buena calidad |

| Entre 40 y 50 | Traducciones de alta calidad |

| 50 - 60 | Traducciones de muy alta calidad, adecuadas y fluidas |

| > 60 | Calidad a menudo mejor que la humana |

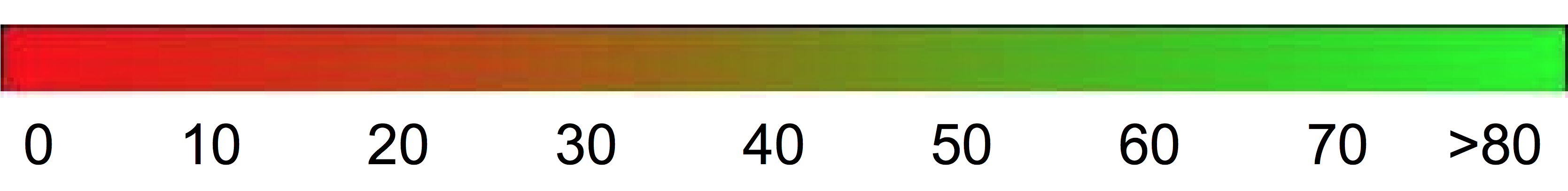

El siguiente gradiente de color se puede usar como una escala general de la interpretación de la puntuación BLEU:

Detalles matemáticos

Matemáticamente, la puntuación BLEU se define de la siguiente manera:

con

\[ precision_i = \dfrac{\sum_{\text{snt}\in\text{Cand-Corpus}}\sum_{i\in\text{snt}}\min(m^i_{cand}, m^i_{ref})} {w_t^i = \sum_{\text{snt'}\in\text{Cand-Corpus}}\sum_{i'\in\text{snt'}} m^{i'}_{cand}} \]

donde

- \(m_{cand}^i\hphantom{xi}\) es el número de i-gramas de la traducción candidata que coinciden con la traducción de referencia.

- \(m_{ref}^i\hphantom{xxx}\) es el recuento de i-gramas en la traducción de referencia.

- \(w_t^i\hphantom{m_{max}}\) es el número total de i-gramas de la traducción candidata.

La fórmula consta de dos partes: la penalización por brevedad y la superposición de n-gramas.

Penalización por brevedad. La penalización por brevedad penaliza las traducciones generadas que son demasiado cortas en comparación con la longitud de referencia más cercana con una reducción exponencial. La penalización por brevedad compensa el hecho de que la puntuación BLEU no tiene ningún término de recuerdo.

Superposición de n-gramas. La superposición de n-gramas cuenta cuántos unigramas, bigramas, trigramas y tetragramas (i=1,...,4) coinciden con su n-grama correspondiente en las traducciones de referencia. Este término actúa como una métrica de precisión. Los unigramas tienen en cuenta la adecuación, mientras que los n-gramas más largos tienen en cuenta la fluidez de la traducción. Para evitar que se cuenten de más, los recuentos de n-gramas se limitan al recuento máximo de n-gramas que se produce en la referencia (\(m_{ref}^n\)).

Ejemplo: cálculo de \(precision_1\)

Echa un vistazo a esta oración de referencia y a la traducción candidata:

Referencia: the cat is on the mat

Candidato: the the the cat mat

El primer paso es contar las apariciones de cada unigrama en la referencia y en la candidata. Ten en cuenta que la métrica BLEU distingue entre mayúsculas y minúsculas.

| Unigrama | \(m_{cand}^i\hphantom{xi}\) | \(m_{ref}^i\hphantom{xxx}\) | \(\min(m^i_{cand}, m^i_{ref})\) |

|---|---|---|---|

the |

3 | 2 | 2 |

cat |

1 | 1 | 1 |

is |

0 | 1 | 0 |

on |

0 | 1 | 0 |

mat |

1 | 1 | 1 |

El número total de unigramas de la candidata (\(w_t^1\)) es 5, por lo que \(precision_1\) = (2 + 1 + 1)/5 = 0,8.

Ejemplo: cálculo de la puntuación BLEU

Referencia:

The NASA Opportunity rover is battling a massive dust storm on Mars.

Candidato 1:

The Opportunity rover is combating a big sandstorm on Mars.

Candidato 2:

A NASA rover is fighting a massive storm on Mars.

El ejemplo anterior consta de una sola referencia y dos traducciones candidatas. Las frases se tokenizan antes de calcular la puntuación BLEU. Por ejemplo, el punto final se cuenta como un token independiente.

Para calcular la puntuación BLEU de cada traducción, calculamos las siguientes estadísticas.

- Precisión de n-gramas. En la siguiente tabla se muestran las precisiones de n-gramas de ambas candidatas.

- Brevity-Penalty. La penalización por brevedad es la misma para la candidata 1 y la candidata 2, ya que ambas frases constan de 11 tokens.

- Puntuación BLEU. Se necesita al menos un 4-grama coincidente para obtener una puntuación BLEU > 0. Como la traducción candidata 1 no tiene ningún 4-grama coincidente, su puntuación BLEU es 0.

| Métrica | Candidato 1 | Candidato 2 |

|---|---|---|

| \(precision_1\) (1 gramo) | 8/11 | 9/11 |

| \(precision_2\) (2 g) | 4/10 | 5/10 |

| \(precision_3\) (3 g) | 2/9 | 2/9 |

| \(precision_4\) (4 g) | 0/8 | 1/8 |

| Brevity-Penalty | 0,83 | 0,83 |

| Puntuación BLEU | 0,0 | 0,27 |