評估模型

訓練模型後,AutoML Translation 會使用 TEST 集評估新模型的品質和準確率。AutoML Translation 會使用 BLEU (雙語評估研究) 分數表示模型品質,進而指出候選語句與參考語句的相似程度。BLEU 分數越接近 1,表示翻譯結果越接近參考文字。

請使用這項資料評估模型的準備程度。如要提升模型品質,建議您新增更多 (且更多樣化) 的訓練區隔組合。調整資料集後,請使用改善後的資料集訓練新模型。

請注意,我們不建議使用 BLEU 分數比較不同語料庫和語言。例如,英文到德文的 BLEU 分數 50,與日文到英文的 BLEU 分數 50 無法比較。許多翻譯專家已改用以模型為基礎的指標方法,這類方法與人工評分的相關性較高,且能更精細識別錯誤情境。

AutoML Translation 僅支援 BLEU 分數。如要使用以模型為基礎的指標評估翻譯模型,請參閱這篇文章。

取得模型評估結果

前往 AutoML Translation 控制台。

在導覽選單中按一下「Models」(模型),即可查看模型清單。

按一下要評估的模型。

按一下「Train」(訓練) 分頁標籤,即可查看模型的評估指標,例如 BLEU 分數。

測試模型預測

您可以使用 Google Cloud 控制台,比較自訂模型與預設 NMT 模型的翻譯結果。

前往 AutoML Translation 控制台。

在導覽選單中按一下「Models」(模型),即可查看模型清單。

按一下要測試的模型。

按一下「Predict」(預測) 分頁標籤。

在原文語言文字方塊中新增輸入文字。

按一下「Translate」(翻譯)。

AutoML Translation 會隨即顯示自訂模型和 NMT 模型的翻譯結果。

使用新測試集評估及比較模型

您可以在 Google Cloud 控制台,使用一組新的測試資料重新評估現有模型。在單一評估作業中,您最多可以納入 5 個不同模型並比較結果。

將測試資料以定位點分隔值 (TSV) 或Translation Memory eXchange (TMX) 檔案的形式上傳至 Cloud Storage。

AutoML Translation 會根據測試集評估模型,然後產生評估分數。您可以選擇將每個模型的結果儲存為 Cloud Storage bucket 中的 TSV 檔案,每列的格式如下:

Source segment tab Model candidate translation tab Reference translation

前往 AutoML Translation 控制台。

在導覽選單中按一下「Models」(模型),即可查看模型清單。

按一下要評估的模型。

按一下「Evaluate」(評估) 分頁標籤。

在「Evaluate」(評估) 分頁中,按一下「New Evaluation」(新增評估)。

選取要評估及比較的模型,然後點按「Netxt」(下一步)。

您必須選取目前的模型,系統預設會選取 Google NMT,但您可以取消選取。

指定測試集名稱,以便與其他評估作業區分,然後從 Cloud Storage 選取新的測試集。

點按「Next」(下一步)。

指定 Cloud Storage 目標資料夾,以便匯出預測結果。

按一下「Start evaluation」(開始評估)。

評估完成後,AutoML Translation 會在控制台以表格格式顯示評估分數。您一次只能執行一項評估作業。如果您指定了要儲存預測結果的資料夾,AutoML Translation 會將 TSV 檔案寫入該位置,並以相關聯的模型 ID 命名,後面加上測試集名稱。

瞭解 BLEU 分數

BLEU (雙語評估研究) 是評估機器翻譯結果品質的指標。BLEU 分數是介於零與一之間的數字,用來測量機器翻譯結果與一組高品質參考翻譯的相似度。值為 0 表示機器翻譯輸出內容與參考翻譯完全不重疊 (表示品質較低),值為 1 則表示與參考翻譯完全重疊 (表示品質較高)。

AutoML Translation 會將 BLEU 分數表示為百分比,而不是 0 與 1 之間的小數。

解釋

做為概略指南,下列 BLEU 分數 (以百分比表示,而不是小數) 的解釋仍具有一定的實用價值。

| BLEU 分數 | 解釋 |

|---|---|

| < 10 | 幾乎沒有用 |

| 10 - 19 | 難以掌握要點 |

| 20 - 29 | 要點明確,但存在大量文法錯誤 |

| 30 - 40 | 品質介於能夠理解與好的翻譯之間 |

| 40 - 50 | 高品質翻譯 |

| 50 - 60 | 品質非常高、適當且流暢的翻譯 |

| > 60 | 品質通常比人工翻譯高 |

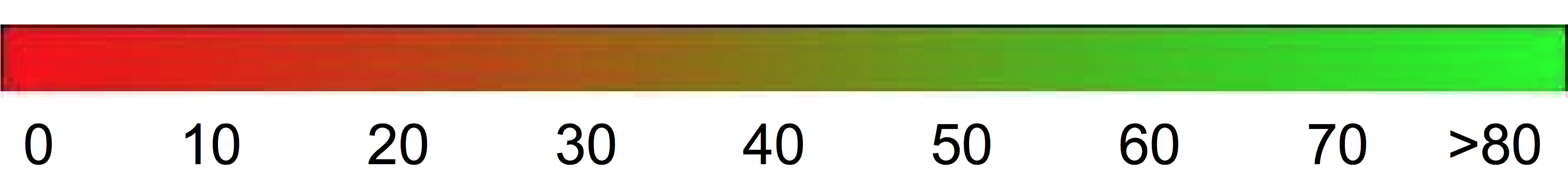

下列顏色漸層可做為一般量表 BLEU 分數解釋使用:

數學詳細資料

在數學上,BLEU 分數的定義為:

使用的公式為

\[ precision_i = \dfrac{\sum_{\text{snt}\in\text{Cand-Corpus}}\sum_{i\in\text{snt}}\min(m^i_{cand}, m^i_{ref})} {w_t^i = \sum_{\text{snt'}\in\text{Cand-Corpus}}\sum_{i'\in\text{snt'}} m^{i'}_{cand}} \]

其中

- \(m_{cand}^i\hphantom{xi}\) 是候選翻譯中與參考翻譯相符的 i 元語法數量

- \(m_{ref}^i\hphantom{xxx}\) 是參考翻譯中 i 元語法的數量

- \(w_t^i\hphantom{m_{max}}\) 是候選翻譯中的 i-gram 總數

公式包含兩部分:短句懲罰值與 n 元語法重疊。

短句懲罰值

如果產生的翻譯與最接近的參考長度相比太短,短句懲罰值會以指數衰減,對這些翻譯進行處罰。短句懲罰值彌補了 BLEU 分數缺少召回率機制的缺憾。N 元語法重疊

N 元語法重疊會計算與參考翻譯中對應 n 元語法相符的一元語法、二元語法、三元語法與四元語法 (i=1,...,4) 數。這個機制會做為精確度指標使用。一元語法說明翻譯的「適當性」,而更長的 n 元語法說明「流暢性」。為避免數量過多,系統會將 n 元語法數降至參考中出現的 n 元語法數上限 (\(m_{ref}^n\))。

範例

計算 \(precision_1\)

請考慮下列參考語句與候選翻譯:

參考語句:the cat is on the mat

候選語句:the the the cat mat

首先要計算參考語句與候選語句中,每個一元語法的出現次數。請注意,BLEU 指標區分大小寫。

| 一元語法 | \(m_{cand}^i\hphantom{xi}\) | \(m_{ref}^i\hphantom{xxx}\) | \(\min(m^i_{cand}, m^i_{ref})\) |

|---|---|---|---|

the |

3 | 2 | 2 |

cat |

1 | 1 | 1 |

is |

0 | 1 | 0 |

on |

0 | 1 | 0 |

mat |

1 | 1 | 1 |

候選語句中的一元語法總數 (\(w_t^1\)) 為 5,因此 \(precision_1\) = (2 + 1 + 1)/5 = 0.8。

計算 BLEU 分數

參考語句:

The NASA Opportunity rover is battling a massive dust storm on Mars .

候選語句 1:

The Opportunity rover is combating a big sandstorm on Mars .

候選語句 2:

A NASA rover is fighting a massive storm on Mars .

上述範例包含單一參考與兩個候選翻譯。 如上文所述,在計算 BLEU 分數之前,會對語句進行詞元化。比方說,會將最後的句號做為單獨的詞元計算。

如要計算每個翻譯的 BLEU 分數,我們會計算下列統計資料。

- N 元語法精確度

下表包含兩個候選語句的 n 元語法精確度。 - 短句懲罰值

候選語句 1 與候選語句 2 的短句懲罰值相同,因為兩個語句都包含 11 個詞元。 - BLEU 分數

請注意,至少要有一個相符的 4 元語法,才能取得 > 0 的 BLEU 分數。 由於候選翻譯 1 沒有相符的 4 元語法,因此 BLEU 分數為 0。

| 指標 | 候選 1 | 候選 2 |

|---|---|---|

| \(precision_1\) (1gram) | 8/11 | 9/11 |

| \(precision_2\) (2gram) | 4/10 | 5/10 |

| \(precision_3\) (3gram) | 2/9 | 2/9 |

| \(precision_4\) (4gram) | 0/8 | 1/8 |

| 簡潔處罰值 | 0.83 | 0.83 |

| BLEU 分數 | 0.0 | 0.27 |

屬性

BLEU 是以語料庫為基礎的指標

在用來評估個別語句時,BLEU 指標的效能不佳。比方說,即使兩個範例語句表達出了大概意思,也會得到非常低的 BLEU 分數。由於個別語句的 n 元語法統計資料沒有什麼意義,因此 BLEU 是以語料庫為基礎來設計的指標;也就是說,在計算分數時,會對整個語料庫中的統計資料進行累計。請注意,無法針對個別語句,對上文定義的 BLEU 指標進行因式分解。實詞與虛詞之間沒有差異

BLEU 指標不會區分實詞與虛詞,也就是說,捨棄諸如「a」的虛詞所致使的懲罰值,與將名稱「NASA」錯誤取代為「ESA」時致使的懲罰值相同。在掌握語句的含意與語法方面表現不佳

捨棄類似「not」的單一字詞,表達的語意就會相反。 另外,僅考慮 n≤4 的 n 元語法會忽略長範圍依賴性,因此,BLEU 通常只會對不合文法的語句施加較小的處罰。正規化與詞元化

在計算 BLEU 分數之前,會對參考與候選翻譯進行標準化與詞元化。標準化與詞元化步驟的選擇會對最終 BLEU 分數造成重大影響。