Questo documento descrive come attivare data lineage per i job Dataproc Spark a livello di progetto o cluster.

La derivazione dei dati è una funzionalità di Dataplex Universal Catalog che consente di monitorare il modo in cui i dati vengono trasferiti nei sistemi: da dove provengono, dove vengono inviati e a quali trasformazioni sono sottoposti.

La derivazione dei dati è disponibile per tutti i job Spark Dataproc, ad eccezione dei job SparkR e Spark streaming, e supporta le origini dati BigQuery e Cloud Storage. È incluso in Dataproc su Compute Engine 2.0.74+, 2.1.22+,

2.2.50+, 2.3.1+ e 3.0.

Una volta abilitata la funzionalità nel cluster Dataproc, i job Spark di Dataproc acquisiscono gli eventi di derivazione dei dati e li pubblicano nell'API Data Lineage di Dataplex Universal Catalog. Dataproc si integra con l'API Data Lineage tramite OpenLineage, utilizzando il plug-in OpenLineage Spark.

Puoi accedere alle informazioni sulla derivazione dei dati tramite Dataplex Universal Catalog utilizzando quanto segue:

Prima di iniziare

Nella console Google Cloud , nella pagina di selezione del progetto, seleziona il progetto che contiene il cluster Dataproc per cui vuoi monitorare la derivazione.

Abilita l'API Data Lineage.

Modifiche imminenti alla data lineage di Spark: consulta le note di rilascio di Dataproc per l'annuncio di una modifica che renderà automaticamente la data lineage di Spark disponibile per i tuoi progetti e cluster quando attivi l'API Data Lineage (vedi Controllare l'importazione della lineage per un servizio) senza richiedere impostazioni aggiuntive a livello di progetto o cluster.

Ruoli obbligatori

Se crei un cluster Dataproc utilizzando il

service account VM predefinito,

questo ha il ruolo Dataproc Worker, che consente la derivazione dei dati. Non sono necessarie ulteriori azioni.

Tuttavia, se crei un cluster Dataproc che utilizza un service account personalizzato, per attivare la derivazione dei dati sul cluster, devi concedere un ruolo richiesto al account di servizio personalizzato come spiegato nel paragrafo seguente.

Per ottenere le autorizzazioni necessarie per utilizzare la derivazione dei dati con Dataproc, chiedi all'amministratore di concederti i seguenti ruoli IAM sul service account personalizzato del cluster:

-

Concedi uno dei seguenti ruoli:

-

Dataproc Worker (

roles/dataproc.worker) -

Editor Data Lineage (

roles/datalineage.editor) -

Data Lineage Producer (

roles/datalineage.producer) -

Amministratore di Data Lineage (

roles/datalineage.admin)

-

Dataproc Worker (

Per saperne di più sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Potresti anche riuscire a ottenere le autorizzazioni richieste tramite i ruoli personalizzati o altri ruoli predefiniti.

Abilitare la derivazione dei dati Spark

Puoi abilitare la derivazione dei dati Spark a livello di progetto o cluster.

Abilita la derivazione dei dati Spark a livello di progetto

Dopo aver abilitato la derivazione dei dati Spark a livello di progetto, i successivi job Spark eseguiti sui cluster Dataproc nel progetto avranno la derivazione dei dati Spark abilitata.

Per abilitare la derivazione dei dati Spark a livello di progetto, imposta i seguenti metadati di progetto personalizzati:

| Chiave | Valore |

|---|---|

DATAPROC_LINEAGE_ENABLED |

true |

DATAPROC_CLUSTER_SCOPES |

https://www.googleapis.com/auth/cloud-platformL'impostazione di questo ambito di accesso VM è necessaria solo per i cluster con versione immagine 2.0. Viene impostato automaticamente sui cluster con versione immagine 2.1 e successive. |

Puoi disattivare la derivazione dei dati Spark a livello di progetto impostando i metadati

DATAPROC_LINEAGE_ENABLED su false.

Abilita la derivazione dei dati Spark a livello di cluster

Se abiliti la lineage dei dati Spark quando crei un cluster, i job Spark supportati eseguiti sui cluster Dataproc avranno la lineage dei dati Spark abilitata. Questa impostazione sostituisce qualsiasi impostazione della lineage dei dati Spark a livello di progetto: se la lineage dei dati Spark è disattivata a livello di progetto, ma attivata a livello di cluster, il livello di cluster ha la precedenza e la lineage dei dati sarà attivata per i job Spark supportati eseguiti sul cluster.

Per attivare la derivazione dei dati Spark su un cluster,

crea un cluster Dataproc

con la proprietà del cluster dataproc:dataproc.lineage.enabled impostata su true.

Esempio di gcloud CLI:

gcloud dataproc clusters create CLUSTER_NAME \

--project PROJECT_ID \

--region REGION \

--properties 'dataproc:dataproc.lineage.enabled=true'Puoi disattivare la derivazione dei dati Spark su un cluster

impostando la proprietà dataproc:dataproc.lineage.enabled su false

quando crei il cluster.

Disattivazione della derivazione dei dati su un cluster: per creare un cluster con la derivazione disattivata, imposta

dataproc:dataproc.lineage.enabled=false. Dopo la creazione del cluster, non puoi disattivare la derivazione dei dati Spark sul cluster. Per disattivare la derivazione dei dati Spark su un cluster esistente, puoi ricreare il cluster con la proprietàdataproc:dataproc.lineage.enabledimpostata sufalse.Imposta l'ambito sui cluster con versione immagine 2.0: l'ambito

cloud-platformdi accesso alle VM del cluster Dataproc è necessario per la derivazione dei dati Spark. I cluster con versione immagine di Dataproc creati con la versione immagine2.1e successive hannocloud-platformabilitato. Se specifichi la versione dell'immagine Dataproc2.0quando crei un cluster, imposta l'ambito sucloud-platform.

Disabilitare la derivazione dei dati Spark in un job

Se la lineage dei dati Spark è abilitata su un cluster, puoi disabilitarla

in un job passando la proprietà spark.extraListeners

con un valore vuoto ("") quando invii il job.

gcloud dataproc jobs submit spark \

--cluster=CLUSTER_NAME \

--project PROJECT_ID \

--region REGION \

--class CLASS \

--jars=gs://APPLICATION_BUCKET/spark-application.jar \

--properties=spark.extraListeners=''Invia un job Spark

Quando invii un job Spark supportato su un cluster Dataproc creato con la derivazione dei dati Spark abilitata, Dataproc acquisisce e segnala le informazioni sulla derivazione dei dati all'API Data Lineage.

gcloud dataproc jobs submit spark \

--cluster=CLUSTER_NAME \

--project PROJECT_ID \

--region REGION \

--class CLASS \

--jars=gs://APPLICATION_BUCKET/spark-application.jar \

--properties=spark.openlineage.namespace=CUSTOM_NAMESPACE,spark.openlineage.appName=CUSTOM_APPNAMENote:

- L'aggiunta delle proprietà

spark.openlineage.namespaceespark.openlineage.appName, che vengono utilizzate per identificare in modo univoco il job, è facoltativa. Se non aggiungi queste proprietà, Dataproc utilizza i seguenti valori predefiniti:- Valore predefinito per

spark.openlineage.namespace: PROJECT_ID - Valore predefinito per

spark.openlineage.appName:spark.app.name

- Valore predefinito per

Visualizza la derivazione nel Catalogo universale Dataplex

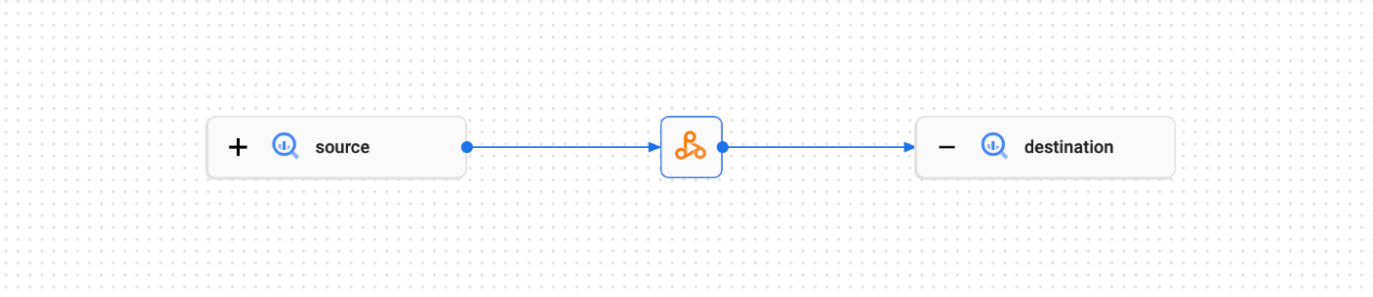

Un grafico di derivazione mostra le relazioni tra le risorse del progetto e i processi che le hanno create. Puoi visualizzare le informazioni sulla derivazione dei dati nella console Google Cloud o recuperarle dall'API Data Lineage sotto forma di dati JSON.

Codice di esempio PySpark:

Il seguente job PySpark legge i dati da una tabella BigQuery pubblica e poi scrive l'output in una nuova tabella in un set di dati BigQuery esistente. Utilizza un bucket Cloud Storage per l'archiviazione temporanea.

#!/usr/bin/env python

from pyspark.sql import SparkSession

import sys

spark = SparkSession \

.builder \

.appName('LINEAGE_BQ_TO_BQ') \

.getOrCreate()

bucket = 'gs://BUCKET`

spark.conf.set('temporaryCloudStorageBucket', bucket)

source = 'bigquery-public-data:samples.shakespeare'

words = spark.read.format('bigquery') \

.option('table', source) \

.load()

words.createOrReplaceTempView('words')

word_count = spark.sql('SELECT word, SUM(word_count) AS word_count FROM words GROUP BY word')

destination_table = 'PROJECT_ID:DATASET.TABLE'

word_count.write.format('bigquery') \

.option('table', destination_table) \

.save()

Effettua le seguenti sostituzioni:

BUCKET: Il nome di un bucket Cloud Storage esistente

PROJECT_ID, DATASET e TABLE: l'ID progetto, il nome di un set di dati BigQuery esistente e il nome di una nuova tabella da creare nel set di dati (la tabella non deve esistere)

Puoi visualizzare il grafico della derivazione nella UI di Dataplex Universal Catalog.

Passaggi successivi

- Scopri di più sulla derivazione dei dati.