Dataproc 叢集必須透過映像檔版本 1.5 或 2.0 建立,才能安裝選用的 HBase 元件。

雖然 Google Cloud 提供許多服務,可部署自行管理的 Apache HBase,但 Bigtable 提供與 HBase 相容的開放式 API,而且可以遷移工作負載,因此通常會是最佳選擇。您可以將 HBase 資料庫資料表遷移至 Bigtable,以便管理基礎資料,而先前與 HBase 互通的應用程式 (例如 Spark) 則可保留在 Dataproc 並安全地連至 Bigtable。本指南提供 Bigtable 入門的概略步驟和參考資料,說明如何將資料從 Dataproc HBase 部署項目遷移至 Bigtable。

開始使用 Bigtable

Cloud Bigtable 是 NoSQL 平台,擴充性極高且效能卓越,並具備 Apache HBase API 用戶端相容性,也能遷移 HBase 工作負載。這個用戶端與 HBase API 1.x 和 2.x 版相容,可納入現有應用程式,用於讀取及寫入 Bigtable。現有的 HBase 應用程式可以新增 Bigtable HBase 用戶端程式庫,來讀取及寫入儲存於 Bigtable 的資料。

如要進一步瞭解如何透過 Bigtable 設定 HBase 應用程式,請參閱「Bigtable 和 HBase API」。

建立 Bigtable 叢集

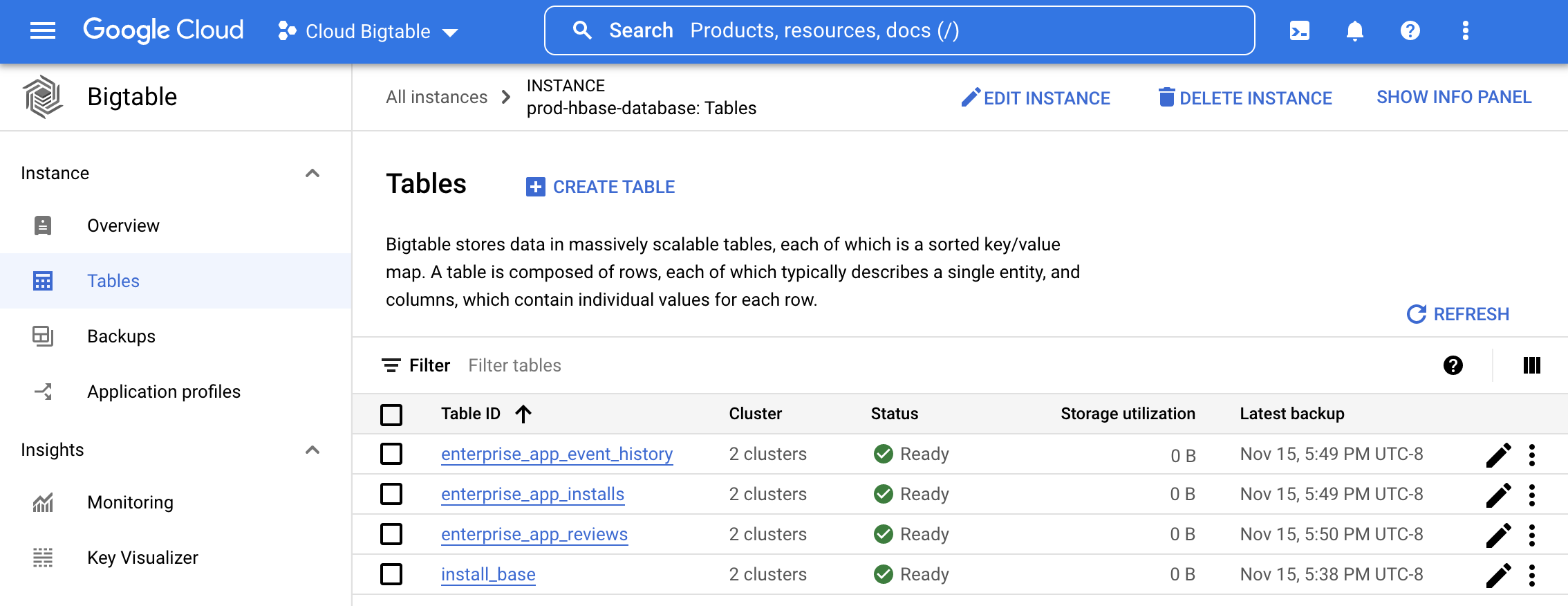

如要開始使用 Bigtable,您可以建立叢集和資料表,來存放先前儲存在 HBase 的資料。請按照 Bigtable 說明文件中的步驟,建立執行個體、叢集和資料表,並採用與 HBase 資料表相同的結構定義。如要透過 HBase 資料表 DDL 自動建立資料表,請參閱結構定義轉譯工具。

在 Google Cloud 控制台開啟 Bigtable 執行個體,即可查看資料表和伺服器端監控圖表 (包括每秒資料列數、延遲時間和處理量),以便管理新佈建的資料表。詳情請參閱「監控說明」。

將資料從 Dataproc 遷移至 Bigtable

在 Bigtable 建立資料表後,請參閱「將 Google Cloud 的 HBase 遷移至 Bigtable」,按照說明匯入及驗證資料。資料遷移完畢後就可以更新應用程式,將讀取和寫入作業傳送至 Bigtable。

後續步驟

- 參閱「Wordcount Spark 範例」,瞭解如何透過 Bigtable 執行 Spark。

- 參閱「從 HBase 即時複製至 Bigtable」,瞭解線上遷移選項。

- 觀看「Box 如何翻新 NoSQL 資料庫」影片,瞭解其他優點。