Este documento fornece informações sobre as métricas do Spark. Por predefinição, o Serverless para Apache Spark ativa a recolha de métricas do Spark disponíveis, a menos que use propriedades de recolha de métricas do Spark para desativar ou substituir a recolha de uma ou mais métricas do Spark.

Para ver propriedades adicionais que pode definir quando envia uma carga de trabalho em lote do Apache Spark do Serverless for Apache Spark, consulte o artigo Propriedades do Spark

Propriedades de recolha de métricas do Spark

Pode usar as propriedades indicadas nesta secção para desativar ou substituir a recolha de uma ou mais métricas do Spark disponíveis.

| Propriedade | Descrição |

|---|---|

spark.dataproc.driver.metrics |

Use para desativar ou substituir as métricas do controlador do Spark. |

spark.dataproc.executor.metrics |

Use para desativar ou substituir as métricas do executor do Spark. |

spark.dataproc.system.metrics |

Use para desativar as métricas do sistema do Spark. |

Exemplos da CLI gcloud:

Desative a recolha de métricas do controlador do Spark:

gcloud dataproc batches submit spark \ --properties spark.dataproc.driver.metrics="" \ --region=region \ other args ...

Substitua a recolha de métricas do controlador predefinido do Spark para recolher apenas as métricas

BlockManager:disk.diskSpaceUsed_MBeDAGScheduler:stage.failedStages:gcloud dataproc batches submit spark \ --properties=^~^spark.dataproc.driver.metrics="BlockManager:disk.diskSpaceUsed_MB,DAGScheduler:stage.failedStages" \ --region=region \ other args ...

Métricas do Spark disponíveis

O Serverless for Apache Spark recolhe as métricas do Spark indicadas nesta secção, a menos que use as propriedades de recolha de métricas do Spark para desativar ou substituir a respetiva recolha.

custom.googleapis.com/METRIC_EXPLORER_NAME.

Métricas do controlador do Spark

| Métrica | Nome do Metrics Explorer |

|---|---|

| BlockManager:disk.diskSpaceUsed_MB | spark/driver/BlockManager/disk/diskSpaceUsed_MB |

| BlockManager:memory.maxMem_MB | spark/driver/BlockManager/memory/maxMem_MB |

| BlockManager:memory.memUsed_MB | spark/driver/BlockManager/memory/memUsed_MB |

| DAGScheduler:job.activeJobs | spark/driver/DAGScheduler/job/activeJobs |

| DAGScheduler:job.allJobs | spark/driver/DAGScheduler/job/allJobs |

| DAGScheduler:messageProcessingTime | spark/driver/DAGScheduler/messageProcessingTime |

| DAGScheduler:stage.failedStages | spark/driver/DAGScheduler/stage/failedStages |

| DAGScheduler:stage.runningStages | spark/driver/DAGScheduler/stage/runningStages |

| DAGScheduler:stage.waitingStages | spark/driver/DAGScheduler/stage/waitingStages |

Métricas do executor do Spark

| Métrica | Nome do Metrics Explorer |

|---|---|

| ExecutorAllocationManager:executors.numberExecutorsDecommissionUnfinished | spark/driver/ExecutorAllocationManager/executors/numberExecutorsDecommissionUnfinished |

| ExecutorAllocationManager:executors.numberExecutorsExitedUnexpectedly | spark/driver/ExecutorAllocationManager/executors/numberExecutorsExitedUnexpectedly |

| ExecutorAllocationManager:executors.numberExecutorsGracefullyDecommissioned | spark/driver/ExecutorAllocationManager/executors/numberExecutorsGracefullyDecommissioned |

| ExecutorAllocationManager:executors.numberExecutorsKilledByDriver | spark/driver/ExecutorAllocationManager/executors/numberExecutorsKilledByDriver |

| LiveListenerBus:queue.executorManagement.listenerProcessingTime | spark/driver/LiveListenerBus/queue/executorManagement/listenerProcessingTime |

| executor:bytesRead | spark/executor/bytesRead |

| executor:bytesWritten | spark/executor/bytesWritten |

| executor:cpuTime | spark/executor/cpuTime |

| executor:diskBytesSpilled | spark/executor/diskBytesSpilled |

| executor:jvmGCTime | spark/executor/jvmGCTime |

| executor:memoryBytesSpilled | spark/executor/memoryBytesSpilled |

| executor:recordsRead | spark/executor/recordsRead |

| executor:recordsWritten | spark/executor/recordsWritten |

| executor:runTime | spark/executor/runTime |

| executor:shuffleFetchWaitTime | spark/executor/shuffleFetchWaitTime |

| executor:shuffleRecordsRead | spark/executor/shuffleRecordsRead |

| executor:shuffleRecordsWritten | spark/executor/shuffleRecordsWritten |

| executor:shuffleRemoteBytesReadToDisk | spark/executor/shuffleRemoteBytesReadToDisk |

| executor:shuffleWriteTime | spark/executor/shuffleWriteTime |

| executor:succeededTasks | spark/executor/succeededTasks |

| ExecutorMetrics:MajorGCTime | spark/executor/ExecutorMetrics/MajorGCTime |

| ExecutorMetrics:MinorGCTime | spark/executor/ExecutorMetrics/MinorGCTime |

Métricas do sistema

| Métrica | Nome do explorador de métricas |

|---|---|

| agent:uptime | agent/uptime |

| cpu:utilization | cpu/utilization |

| disk:bytes_used | disk/bytes_used |

| disk:percent_used | disk/percent_used |

| memory:bytes_used | memory/bytes_used |

| memory:percent_used | memory/percent_used |

| network:tcp_connections | network/tcp_connections |

Veja as métricas do Spark

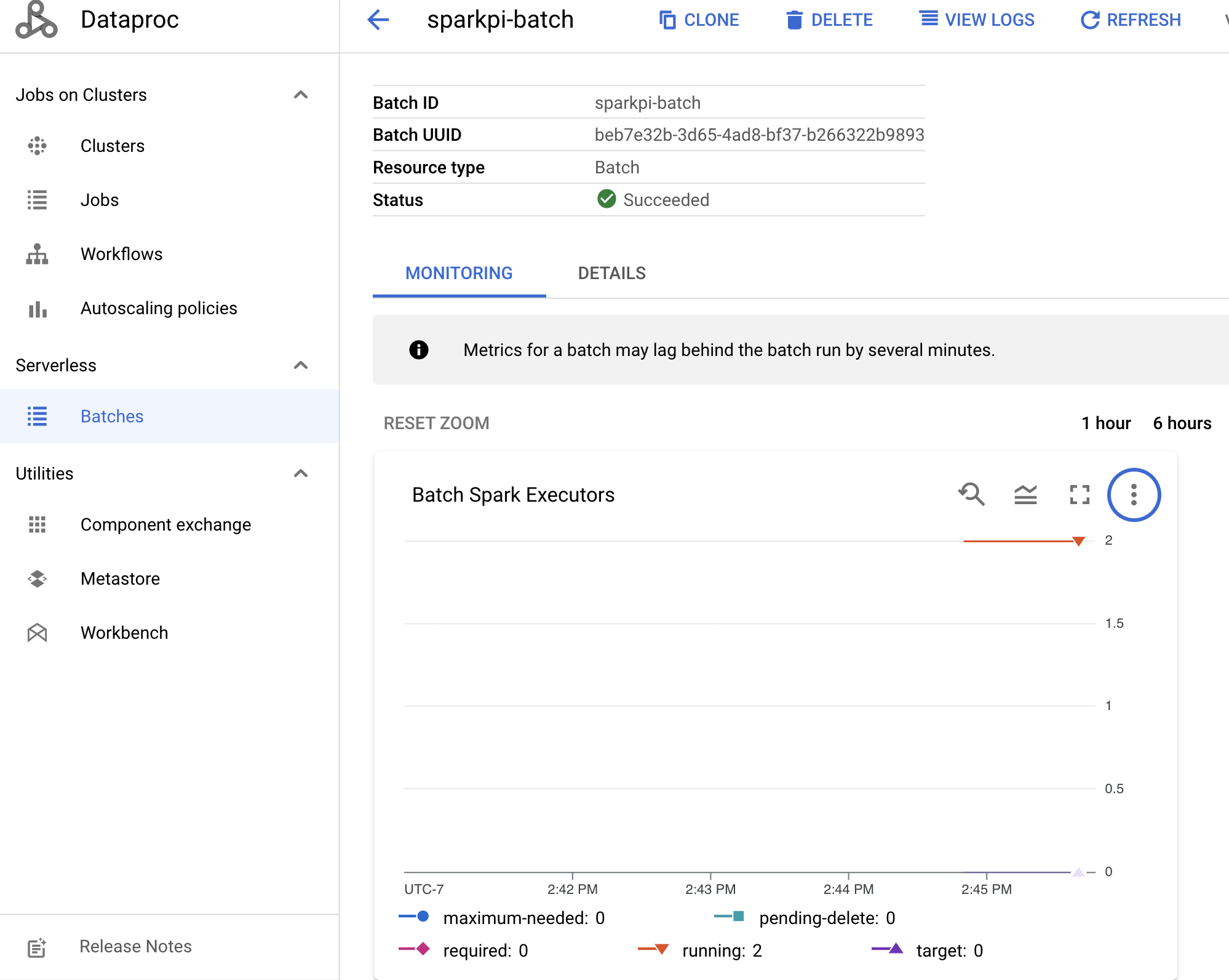

Para ver as métricas de lotes, clique num ID de lote na página Lotes do Dataproc na Google Cloud consola para abrir a página Detalhes do lote, que apresenta um gráfico de métricas para a carga de trabalho do lote no separador Monitorização.

Consulte o Cloud Monitoring do Dataproc para ver informações adicionais sobre como ver as métricas recolhidas.