AI ゾーンは、人工知能と機械学習(AI と ML)のトレーニングと推論のワークロードに使用される専用ゾーンです。ML アクセラレータ(GPU と TPU)の容量を大幅に提供します。

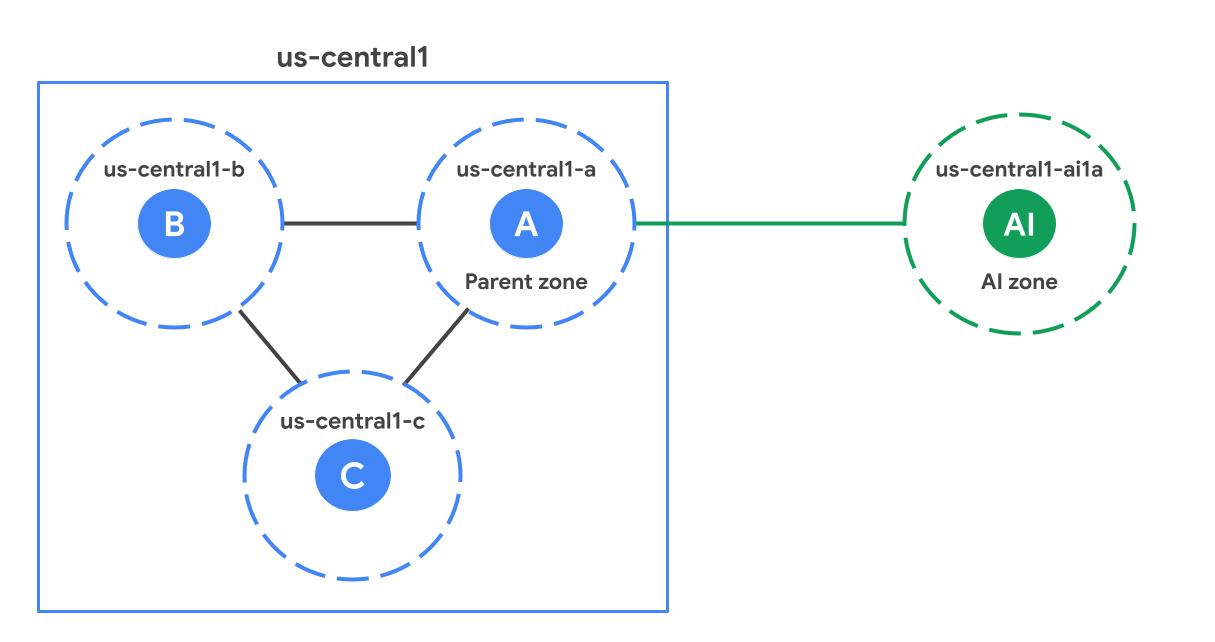

リージョン内では、AI ゾーンは標準(非 AI)ゾーンから地理的に離れた場所に配置されます。次の図は、us-central1 リージョンの標準ゾーンよりも離れた場所にある AI ゾーン(us-central1-ai1a)の例を示しています。

保護者ゾーン

各 AI ゾーンは、リージョンの標準ゾーン(親ゾーン)に関連付けられています。親ゾーンは、AI ゾーンと同じ接尾辞を持つ標準ゾーンです。たとえば、この図では、us-central1-a は us-central1-ai1a の親ゾーンです。ソフトウェア アップデートのスケジュールや、場合によってはインフラストラクチャを共有します。つまり、親ゾーンに影響するソフトウェアやインフラストラクチャの問題は、AI ゾーンにも影響する可能性があります。高可用性ソリューションを設計する際は、高可用性(HA)に関する考慮事項を確認して、親ゾーンへの依存関係を考慮してください。

AI ゾーンを使用する場合

AI ゾーンは AI / ML ワークロード向けに最適化されています。次のガイダンスを使用して、AI ゾーンに最適なワークロードと、標準ゾーンに適したワークロードを判断します。

推奨される用途:

大規模なトレーニング: 大量のアクセラレータを利用できるため、大規模言語モデル(LLM)や基盤モデルのトレーニングなど、大規模なトレーニング ワークロードに最適です。

小規模なトレーニング、ファインチューニング、一括推論、再トレーニング: AI ゾーンは、大量のアクセラレータ容量を必要とするワークロードに適しています。

リアルタイム ML 推論: AI ゾーンは、リアルタイム推論ワークロードをサポートします。パフォーマンスは、アプリケーション設計とモデル レイテンシ要件によって異なります。特に、ワークロードで親リージョンへのラウンド トリップ リクエストが必要な場合は、パフォーマンスに影響します。

推奨されない用途:

- ML 以外のワークロード: AI ゾーンではすべての Google Cloud サービスがローカルで提供されないため、ML 以外のワークロードは標準ゾーンで実行することをおすすめします。

AI ゾーンからサービスにアクセスする

Google Cloud リージョンのすべての Google Cloud プロダクトには、その AI ゾーンからアクセスできます。ただし、AI ゾーンはリージョンの標準ゾーンのロケーションから物理的に分離されているため、AI ゾーンから Google Cloud リージョンのサービスにアクセスすると、ネットワーク レイテンシが発生する可能性があります。

特定のプロダクトでは、AI ゾーンでゾーンリソースをローカルに作成またはアクセスできます。これらのサービスの詳細については、次の表をご覧ください。

| プロダクト | 説明 |

|---|---|

| Google Kubernetes Engine(GKE) | ComputeClass、ノード自動プロビジョニング、GKE Standard ノードプールを使用した構成など、GKE クラスタで AI ゾーンを使用するための設定。 GKE での AI ゾーンの使用 |

| Cloud Storage | AI ゾーンのワークロードのオブジェクト ストレージの構成。これには、アクティブなジョブのパフォーマンスを最大化するゾーン ストレージと、データセットとモデルのチェックポイント用の永続ストレージが含まれます。 Cloud Storage で AI ゾーンを使用する |

| Compute Engine | コンソール、Google Cloud CLI、REST API を使用して使用可能な AI ゾーンを特定する方法。命名規則、アクセラレータ タイプ、マシンでフィルタする方法も含む。 使用可能な AI ゾーンを見つける |

ロケーション

AI ゾーンは次のロケーションで利用できます。

| AI ゾーン | AI ゾーンの場所 | Google Cloud リージョン | Google Cloud リージョンのロケーション | 親ゾーン |

|---|---|---|---|---|

us-south1-ai1b |

テキサス州オースティン(北米) | us-south1 |

テキサス州ダラス(北米) | us-south1-b |

us-central1-ai1a |

ネブラスカ州リンカーン(北米) | us-central1 |

アイオワ州カウンシル ブラフス(北米) | us-central1-a |

AI ゾーンの使用

AI ゾーンには、 Google Cloud コンソール、Google Cloud CLI、または REST を使用してアクセスできます。ただし、Google Cloud コンソールを使用して VM を作成する場合は、AI ゾーンを手動で選択する必要があります。標準ゾーンのように自動的に選択されることはありません。次の機能で AI ゾーンを使用するには、これらのリソースの設定時に AI ゾーンを明示的に選択する必要があります。

特定の Compute Engine と GKE の機能: 特定の Compute Engine と GKE のリージョン機能(リージョン マネージド インスタンス グループ、リージョン GKE クラスタなど)では、AI ゾーンは自動的に選択されません。GKE の詳細については、GKE のドキュメントをご覧ください。

非アクセラレータ ワークロードの制限事項: AI ゾーンで CPU 専用 VM を実行する場合は、Compute Engine で適用される制限事項に注意してください。これには、GPU:CPU 比率と予約の要件が含まれる場合があります。

Vertex AI: GKE ベースの Vertex AI リージョン プロダクトでは、リージョン クラスタに AI ゾーンを含めるように GKE を構成する必要があります。Vertex AI を有効にする必要はありません。この構成は Vertex AI によって管理されます。

Google Cloud Service Metadata Locations API: locations.list API を使用する際は、

--extraLocationTypesフラグを有効にして、AI ゾーンが使用を予定しているユーザーにのみ表示されるようにする必要があります。

GKE での AI ゾーンの使用

デフォルトでは、GKE は AI ゾーンにワークロードをデプロイしません。AI ゾーンを使用するには、次のいずれかのオプションを構成します。

ComputeClass: AI ゾーンでオンデマンド TPU をリクエストする優先度を最高に設定します。ComputeClasses を使用すると、ワークロードのハードウェア構成の優先順位付きリストを定義できます。例については、ComputeClass についてをご覧ください。

ノードの自動プロビジョニング: Pod 仕様で

nodeSelectorまたはnodeAffinityを使用して、AI ゾーンにノードプールを作成するようにノードの自動プロビジョニングに指示します。ワークロードが AI ゾーンを明示的にターゲットにしていない場合、ノード自動プロビジョニングは新しいノードプールを作成するときに標準ゾーンのみを考慮します。この構成により、AI/ML モデルを実行しないワークロードは、明示的に別の構成を行わない限り、標準ゾーンに残ります。nodeSelectorを使用するマニフェストの例については、自動作成されたノードのデフォルト ゾーンを設定するをご覧ください。GKE Standard: ノードプールを直接管理する場合は、ノードプールの作成時に

--node-locationsフラグで AI ゾーンを使用します。例については、GKE Standard に TPU ワークロードをデプロイするをご覧ください。

制限事項

AI ゾーンでは次の機能は使用できません。

AI ゾーンに関する設計上の考慮事項

AI ゾーンを使用するアプリケーションを設計する際は、次の点を考慮してください。

高可用性(HA)に関する考慮事項

AI ゾーンは、ソフトウェアのロールアウトとインフラストラクチャを親ゾーンと共有します。ワークロードの高可用性を確保するには、ゾーンを自動または手動で選択する際に、次のデプロイ パターンを避けてください。

AI ゾーンとその親ゾーンに HA ワークロードをデプロイすることは避けてください。

同じ親ゾーンを共有する 2 つの AI ゾーンに HA ワークロードをデプロイしないでください。

ストレージのベスト プラクティス

費用、耐久性、パフォーマンスのバランスを取るには、階層型ストレージ アーキテクチャをおすすめします。

- コールド ストレージ レイヤ: 標準ゾーンのリージョン Cloud Storage バケットを使用して、トレーニング データセットとモデル チェックポイントの永続的で耐久性の高いストレージを実現します。

パフォーマンス レイヤ: 専用のゾーン ストレージ サービスを使用して、高速キャッシュまたは一時スクラッチ スペースとして機能します。このアプローチにより、ゾーン間のレイテンシが解消され、アクティブなジョブ中の goodput が最大化されます。

GPU と TPU を完全に飽和状態に保ち、グッドプットを最大化するには、コンピューティング リソースと同じ AI ゾーンにパフォーマンス レイヤをプロビジョニングします。

AI ゾーンで AI / ML システムのパフォーマンスを最適化するには、次のストレージ ソリューションをおすすめします。

| ストレージ サービス | 説明 | ユースケース |

|---|---|---|

| Cloud Storage の Anywhere Cache 機能 | バケットから AI ゾーンに頻繁に読み取られるデータを取り込む、SSD を利用したフルマネージドのゾーン読み取りキャッシュ。 | 推奨される用途:

|